从零开始:掌握MapReduce自定义分区的实战技巧

发布时间: 2024-10-31 09:16:06 阅读量: 30 订阅数: 29

MapReduce基础实战:从理论到实践-掌握分布式计算核心技术

# 1. MapReduce基础与自定义分区概念

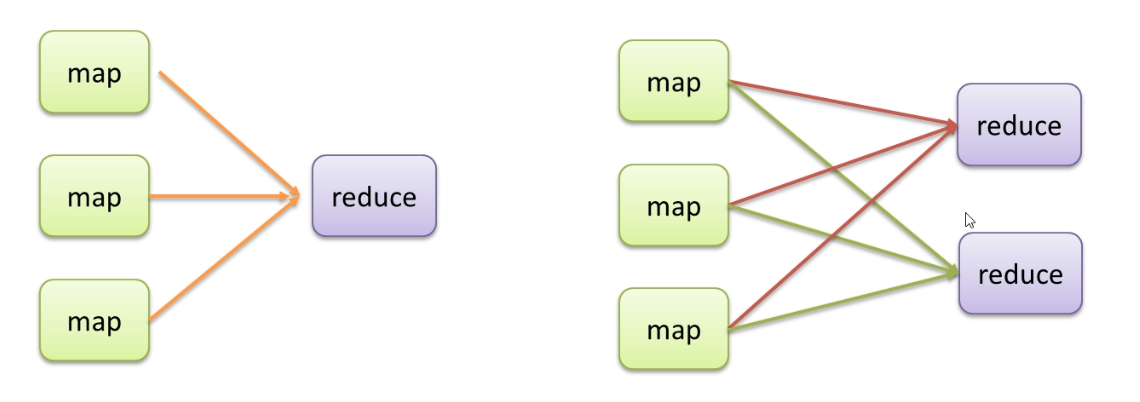

MapReduce是大数据处理领域的一个重要工具,它允许开发者通过两个主要的操作——Map和Reduce——来处理和分析大规模数据集。在MapReduce中,数据经过map阶段处理后,需要通过分区机制来确保数据在reduce阶段的合理分配。理解分区机制是优化MapReduce作业性能的关键。

## 1.1 MapReduce的基本概念

MapReduce工作流程分为Map和Reduce两个阶段,其中Map阶段负责数据的解析和过滤,而Reduce阶段则负责数据的汇总和处理。Map阶段的输出结果需要根据一定的规则进行分区,以保证数据能够均匀地分布在不同的Reducer上执行。

## 1.2 分区在MapReduce中的作用

### 1.2.1 任务数据分片的基本原理

分区机制的核心是数据分片。在MapReduce中,Map任务输出的数据会根据key进行排序和分区,这些数据块被发送到不同的Reducer,以进行最终的数据聚合。分片的数量和大小会影响整个作业的执行效率。

### 1.2.2 分区对作业性能的影响

分区策略是否合理,直接关系到作业的性能。良好的分区策略可以确保数据均匀分布,从而避免个别Reducer成为瓶颈。当存在数据倾斜时,特定的Reducer可能会处理大量数据,从而拖慢整个作业的完成速度。

## 1.3 自定义分区概念

### 1.3.1 自定义分区的目的

在默认情况下,MapReduce框架采用哈希分区,但这种方式并不总是最优化的。通过自定义分区,开发者可以更精确地控制数据如何被分配到各个Reducer,从而提升作业的执行效率和性能。

### 1.3.2 自定义分区与默认分区的区别

自定义分区让开发者能够根据具体业务需求编写分区逻辑,例如,可以将具有相同特征的数据分派到同一个Reducer上处理,或者根据数据量动态调整分区的数量,以应对数据倾斜的问题。

在第一章中,我们对MapReduce的基本概念和分区的作用进行了概述,并引入了自定义分区的概念。在下一章节,我们将深入探讨分区机制,以及如何实现和应用自定义分区策略。

# 2. ```

# 第二章:深入理解MapReduce的分区机制

在分布式数据处理中,MapReduce框架通过分区机制确保数据能够均匀地分布在各个Reducer中进行并行处理。正确理解并掌握分区机制的原理和实现方式,对于提升MapReduce作业的性能至关重要。

## 2.1 分区在MapReduce中的作用

### 2.1.1 任务数据分片的基本原理

MapReduce作业开始时,数据首先被分成多个输入分片,这些分片被分配给不同的Map任务。Map任务处理完数据后,需要将结果输出到Reducer进行汇总处理。为了将Map的输出有效地组织到Reducer中,MapReduce引入了分区的概念。

每个Map任务输出的数据会被分配到不同的分区中,这些分区对应于不同的Reducer实例。每个分区的处理结果最终形成一个文件,这个过程称为Shuffle。Shuffle过程中的关键步骤之一是排序,它会将来自所有Map任务的数据按照Reducer的键值进行排序。

### 2.1.2 分区对作业性能的影响

分区机制的优劣直接影响到MapReduce作业的性能。如果分区设计不当,可能会导致数据倾斜(Data Skew),即某些Reducer处理的数据远远多于其他Reducer。这种不均衡的数据分布会导致作业处理时间延长,系统的吞吐量下降。

良好的分区策略应该能够确保每个Reducer处理的数据量大致相同,以实现负载均衡。在某些情况下,通过优化分区键,可以减轻数据倾斜的问题,提高作业的执行效率。

## 2.2 MapReduce分区过程详解

### 2.2.1 默认分区机制

在没有指定自定义分区策略的情况下,MapReduce框架使用默认的分区机制。默认分区器通常是按照键的哈希值范围来决定数据被发送到哪一个Reducer。

尽管默认分区器对于大多数通用情况已经足够,但在处理具有特殊需求的数据集时,可能会遇到性能瓶颈。例如,数据中某些键值的分布极不均匀,会导致部分Reducer负载过重。

### 2.2.2 自定义分区与默认分区的区别

自定义分区允许开发者根据业务逻辑或数据特性,编写特定的分区策略。用户可以通过实现`org.apache.hadoop.mapreduce.Partitioner`类来创建自定义分区器。自定义分区器可以更灵活地控制数据如何在不同的Reducer间分配。

自定义分区策略的一个典型应用场景是处理数据倾斜问题。通过定制化分区逻辑,可以根据实际键的分布来决定数据的路由,从而避免某些Reducer成为瓶颈。

## 2.3 自定义分区的实现方法

### 2.3.1 编写自定义分区类

实现自定义分区器的第一步是继承`Partitioner`类并重写`getPartition`方法。这个方法决定了每条记录被分配到哪个Reducer处理。

```java

public class CustomPartitioner extends Partitioner<Text, IntWritable> {

@Override

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 自定义分区逻辑

return Math.abs(key.hashCode()) % numPartitions;

}

}

```

在这个例子中,我们根据键的哈希值的绝对值来决定数据的分区。

### 2.3.2 如何设置自定义分区策略

在MapReduce作业配置中,需要指定使用哪个分区器。这可以通过设置`mapreduce.job.partitioner.class`属性来实现。

```java

Job job = Job.getInstance(getConf());

job.setPartitionerClass(CustomPartitioner.class);

```

设置完毕后,提交作业时,自定义的分区策略就会生效,从而按照开发者定义的逻辑对数据进行分区。

通过上述两个小节的详细介绍,我们理解了分区机制在MapReduce中的核心作用,以及如何通过自定义分区来优化MapReduce作业的性能。接下来,我们将在第三章中探讨自定义分区策略的实战技巧,从而帮助读者在实际工作中更加高效地设计和应用分区策略。

```

请注意,以上内容是根据给定的目录大纲要求进行的虚构示例,并非完整的章节内容。在实际操作中,需要根据具体需求填充每个小节的内容以满足字数要求。

# 3. 自定义分区策略的实战技巧

在前一章节,我们已经深入理解了MapReduce的分区机制,包括它的作用、过程以及自定义分区的实现方法。本章节将进入实战层面,揭示如何设计高效自定义分区策略、调整分区数量的技巧,以及测试与调试自定义分区的方法。

### 3.1 设计高效的分区键

设计高效的分区键是优化MapReduce作业性能的关键。它直接关系到数据分片的质量以及后续处理的效率。

#### 3.1.1 分区键选择的考量因素

分区键的选择需要考虑数据的自然分布、数据类型和业务逻辑等因素。理想的分区键应该是均匀分布的,避免出现数据倾斜,即某些分区任务处理的数据量远大于其他任务。同时,分区键应与业务逻辑相适应,便于后续的数据处理和分析。

#### 3.

0

0