MapReduce自定义分区:深度剖析提升任务效率的秘诀

发布时间: 2024-10-31 09:28:51 阅读量: 25 订阅数: 22

# 1. MapReduce基础知识回顾

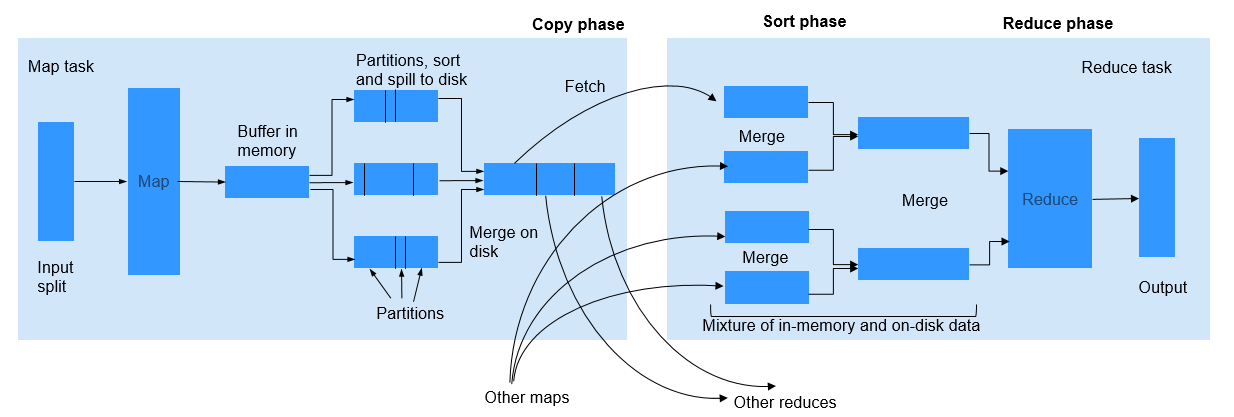

MapReduce 是一种编程模型,用于处理和生成大数据集的算法。其核心思想是将任务分解为两个阶段:Map(映射)阶段和Reduce(归约)阶段。在 Map 阶段,输入数据被分解成独立的块,并且每个块被处理以生成中间键值对。在 Reduce 阶段,所有具有相同键的中间值被合并以形成最终结果。

随着大数据的兴起,MapReduce 已经成为处理大规模数据集的有效工具。它简化了分布式计算的复杂性,使得开发者能够专注于编写处理逻辑而不是协调分布式计算的底层细节。接下来的章节将深入探讨 MapReduce 的分区机制,这是优化 MapReduce 作业性能的关键因素之一。

# 2. 深入理解MapReduce分区机制

### 2.1 分区的基本概念与作用

#### 2.1.1 分区的定义及其在MapReduce中的重要性

MapReduce作为大数据处理的重要模型,其性能在很大程度上取决于数据的划分和分布。分区(Partitioning)作为数据分片的一种机制,它决定了Map阶段的输出数据如何分配给Reduce任务。每个分区都是独立的数据集,不同的分区数据由不同的Reduce任务处理,因此,合理的分区策略对提高MapReduce作业的效率和性能至关重要。

在MapReduce中,分区是按照一定的规则,将key-value对集合分割成若干个子集的过程。这些子集在后续的排序和归并过程中,会分别被不同的Reduce任务处理,最终生成输出文件。如果分区划分不合理,可能会导致数据倾斜(Data Skew),即某些分区数据量过大,任务处理不均衡,从而影响整体计算性能。

#### 2.1.2 默认分区机制的工作原理

MapReduce框架提供了一个默认的分区函数,通常是哈希分区(Hash Partitioning),它的基本原理是基于key的哈希值来决定该key-value对应该发送到哪个Reduce任务。

具体来说,默认的分区函数会对key应用一个哈希算法,然后将哈希值和可用的Reduce任务数进行取模操作(key的哈希值 % Reduce任务数),得到的结果即为key-value对应该分配到的分区编号。这种机制简单高效,但在数据分布不均匀时可能导致性能问题。

### 2.2 分区与数据分布的关系

#### 2.2.1 理解数据倾斜对任务性能的影响

数据倾斜是指在分布式计算中,数据在不同节点上的分布不均匀,导致某些节点处理的数据量远远大于其他节点,进而影响了整体任务的执行效率。在MapReduce中,数据倾斜通常发生在Reduce阶段,因为Reduce任务需要处理来自多个Map任务的数据。

数据倾斜会导致部分Reducer节点任务量过大,而其他节点则可能处于空闲或轻负载状态。这不仅延长了处理时间,也使得集群资源没有得到充分利用。因此,合理设计分区策略是避免数据倾斜的关键。

#### 2.2.2 如何通过分区优化数据分布

为了避免数据倾斜,可以通过多种方式优化分区策略。最直接的方法是使用自定义分区函数,根据实际业务需求和数据特性来设计分区逻辑。

一种常见的优化策略是“二次哈希”,它对key进行两次哈希运算,第一次得到一个临时哈希值,第二次得到最终的分区编号,这种方法可以较为均匀地分配数据,但可能会增加计算成本。

另一种策略是“范围分区”,根据key的范围来决定其分配到的分区。例如,可以将员工信息按照部门划分,使得同一部门的员工信息聚集到同一分区,从而减少数据倾斜的风险。

### 2.3 自定义分区的动机与优势

#### 2.3.1 自定义分区的场景应用

在某些特定的业务场景中,使用默认分区算法并不能取得最佳的性能。例如,在处理具有明显分布特征的数据集时,如按地区、产品类别等维度划分的数据,使用默认的哈希分区就显得不够灵活。

自定义分区可以让开发者根据数据的特征和业务逻辑来指定分区规则。在文本数据处理中,可以根据数据的首字母、长度、出现频率等属性来划分分区。在图数据处理中,可以根据节点的度(与节点连接的边的数量)来优化分区。这些自定义的策略往往可以更好地适应具体问题,从而提高计算效率。

#### 2.3.2 自定义分区与默认分区的性能比较

自定义分区与默认分区之间的性能比较很大程度上取决于具体的应用场景。在没有数据倾斜和任务负载均衡的理想情况下,两者可能性能相近。但在数据倾斜的情况下,自定义分区往往能带来显著的性能提升。

自定义分区可以根据实际数据集的特点,设计出更为科学合理的分区策略,从而避免任务执行过程中出现的负载不均问题。例如,在处理大量倾斜数据时,通过自定义分区可以将数据均匀地分布在不同的Reduce任务上,从而减少单个任务的处理时间,提升整体作业效率。

然而,值得注意的是,实现自定义分区算法可能会增加开发者的编程工作量,且需要对业务场景和数据分布有较为深入的理解。因此,在实际应用中需要权衡开发成本与性能收益。在某些情况下,自定义分区可能只是权宜之计,长远来看,可能需要通过调整数据存储模型或计算模型来根本解决数据倾斜问题。

自定义分区的优势在于其灵活性和针对性,但与此同时,开发者需要具备一定的编程能力和对业务逻辑的深刻理解,才能设计出符合实际需求、高效合理的分区策略。

下一章节我们将深入探讨自定义分区的理论基础与实现方法,包括分区函数的数学模型、分区键值的选取原则、自定义分区函数的编写和配置,以及自定义分区的高级技巧。通过掌握这些内容,开发者将能够为特定的业务场景设计和实现高效的分区策略。

# 3. 自定义分区的理论基础与实现方法

## 3.1 自定义分区的理论基础

### 3.1.1 分区函数的数学模型

在MapReduce编程模型中,分区函数的目的是为了将映射输出的键值对(key-value pairs)均匀地分配到各个Reducer。分区函数是数学模型的一种实现,它根据特定的数学规则将key分配给Reducer。

分区函数的设计核心在于确保数据尽可能均匀地分布,避免某些Reducer处理的数据量过大,从而导致任务执行的瓶颈。一个典型的分区函数会取键值对的key,通过某种数学运算(如取模运算)来决定其应该被分配给哪一个Reducer。

例如,如果我们有一个总共有`R`个Reducer,那么一个简单的分区函数可能是:`partition(key) = key.hashCode() % R`。这个函数将key的哈希值与Reducer的数量进行取模运算,以此来确定数据应发送给哪一个Reducer。

### 3.1.2 分区键值的选取原则

选取合适的分区键值是实现有效数据分布的关键。理想的分区键值应该具有以下特性:

- **均匀分布**:分区键值应均匀地分布在所有Reducer上,避免出现数据倾斜。

- **相关性**:选择的键值应与处理的业务逻辑紧密相关,保证数据在Reducer中的逻辑正确性。

- **确定性**:相同键值在任何时候都应该产生相同的分区结果,以便于数据处理的稳定性。

分区键值的选取还应考虑到具体的数据处理需求。例如,在处理用户日志时,可以使用用户ID作为键值,这样同一用户的所有日志都会被发送到同一个Reducer进行处理。这不仅保证了数据的逻辑一致性,同时也利用了用户ID的哈希特性实现了数据的均匀分布。

## 3.2 自定义分区的实现步骤

### 3.2.1 编写自定义分区函数

在MapReduce中,自定义分区函数通常需要实现一个接口,例如Hadoop中的`Partitioner`接口。以下是一个简单的自定义分区函数的代码示例,它基于用户的地理位置信息来进行分区。

```java

public class GeoPartitioner extends Partitioner<T

```

0

0