【数据驱动的决策艺术】:20年数据分析师的实战心得

发布时间: 2025-01-02 16:57:16 阅读量: 7 订阅数: 12

数据驱动决策:在数据分析中实施A/B测试的全面指南

# 摘要

随着信息技术的飞速发展,数据驱动决策已成为企业和组织优化流程、提高效率的关键手段。本文从理论基础入手,深入探讨了数据收集、预处理、分析、挖掘以及数据可视化和报告撰写的关键技巧。通过对数据收集方法论、数据清洗的重要性、数据转换与特征工程、预测性分析与模型建立等多方面的阐述,本文提供了数据处理和分析的实战方法。特别是在数据可视化与报告撰写章节,本文不仅对比了可视化工具和技巧,还探讨了如何将数据转化为有价值的情报。最后,本文通过实际案例分析,总结了数据驱动决策的成功经验与挑战,并展望了人工智能和大数据融合的未来趋势,为数据驱动决策的进一步研究和技术进步指明了方向。

# 关键字

数据驱动决策;数据收集;数据预处理;特征工程;数据分析;数据可视化

参考资源链接:[GR-487-CORE: 电子设备机柜通用要求](https://wenku.csdn.net/doc/6467666e543f844488b73d43?spm=1055.2635.3001.10343)

# 1. 数据驱动决策的理论基础

在当今竞争激烈和信息驱动的商业环境中,数据驱动的决策制定已经成为了企业和组织在策略规划和日常运营中不可或缺的一部分。本章将探讨数据驱动决策的基本理论,为读者深入理解后续章节中涉及的数据收集、分析、可视化以及报告撰写等内容提供必要的理论基础。

## 1.1 数据决策的概念与重要性

数据决策是一种基于数据分析和解释来指导决策的方法。它依赖于数据的收集、处理和解释,以形成有根据的决策。数据驱动决策之所以重要,是因为它提供了更加客观、精确的视角,有助于减少偏见和直觉上的错误,提高了决策的质量和效率。

## 1.2 数据与信息的关系

数据是原始的事实和数字,而信息是数据经过加工后,能够提供洞察力和知识的格式。理解数据与信息之间的关系,可以帮助我们更好地识别和利用数据,确保收集的数据能够转化为有助于决策的信息。

## 1.3 数据驱动决策的流程

数据驱动决策的流程通常包括以下几个步骤:

1. 定义问题:明确需要决策的问题或目标。

2. 数据收集:收集与问题相关的数据。

3. 数据处理:包括数据清洗、转换和特征工程。

4. 数据分析:通过统计和分析工具从数据中提取信息。

5. 决策制定:基于分析结果制定决策。

6. 执行与反馈:执行决策并收集反馈以优化未来决策。

通过这些步骤,企业不仅能够提升决策的科学性,还能在动态变化的市场中快速响应,保持竞争优势。

# 2. 数据收集与预处理技巧

### 2.1 数据收集的方法论

数据收集是数据分析的起始点,对后续的分析和挖掘工作具有决定性的影响。有效和可靠的数据收集方法不仅能够保证数据的质量,还能为数据处理和分析奠定坚实的基础。

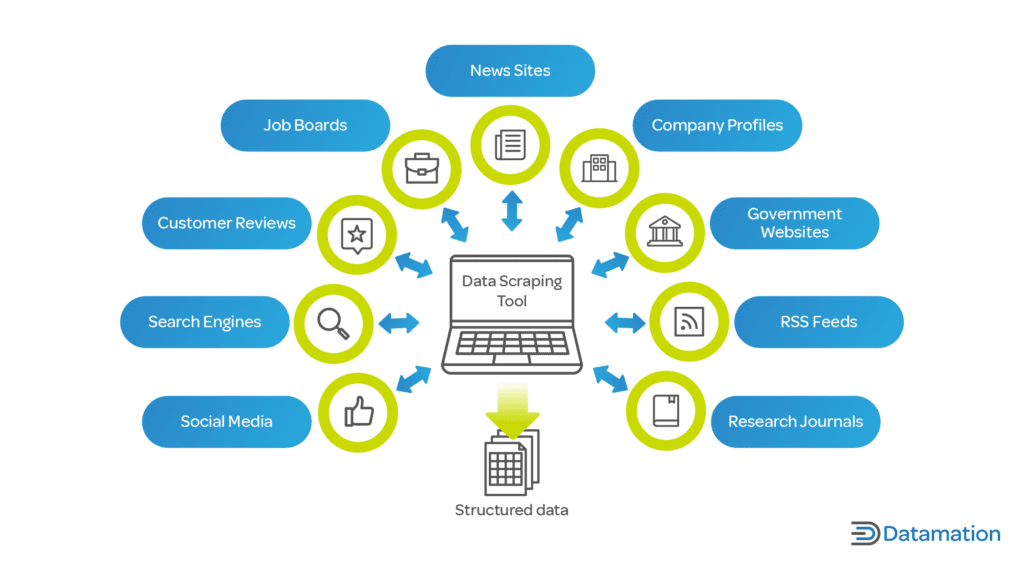

#### 2.1.1 数据收集工具和技术

数据收集的工具有多种形式,包括在线调查问卷、网络爬虫、公开数据集、日志文件、传感器数据等。技术方面,需要结合实际业务需求和数据类型选择合适的工具和方法。

1. **在线调查问卷**:使用如SurveyMonkey或Google Forms等工具进行数据收集,适用于市场调研和用户反馈收集。

2. **网络爬虫**:利用Python中的requests库和BeautifulSoup库,编写爬虫脚本,从网页中提取所需数据。

3. **公开数据集**:从政府公共数据平台、学术资源、或数据提供商那里获取数据。

4. **日志文件**:对于互联网公司,服务器日志文件是宝贵的用户行为数据源。

5. **传感器数据**:在物联网领域,各种传感器收集的数据用于监控和分析环境或设备状态。

下面是一个简单的Python网络爬虫代码示例:

```python

import requests

from bs4 import BeautifulSoup

# 目标网站URL

url = 'http://example.com'

# 发送HTTP请求

response = requests.get(url)

# 确认请求成功

if response.status_code == 200:

# 使用BeautifulSoup解析网页

soup = BeautifulSoup(response.text, 'html.parser')

# 提取特定元素,例如所有的段落

paragraphs = soup.find_all('p')

for p in paragraphs:

print(p.text)

else:

print('Failed to retrieve the webpage')

```

**参数说明**:`requests.get(url)` 发送一个GET请求到指定URL;`BeautifulSoup(response.text, 'html.parser')` 将返回的HTML内容解析成易于操作的BeautifulSoup对象;`soup.find_all('p')` 查找所有的段落元素。

#### 2.1.2 数据质量控制与评估

数据质量控制与评估是确保数据可用性的必要步骤。在收集数据后,需要进行初步检查,以识别和纠正错误或不一致的数据。

- **完整性检查**:确认数据中是否有缺失值,决定如何处理。

- **一致性检查**:检查数据在各个系统或数据源之间是否保持一致。

- **准确性检查**:验证数据的准确程度,通常需要与外部数据源进行对比。

进行数据质量评估时,可以使用描述性统计分析,例如计算均值、中位数、标准差等,这些可以帮助我们初步了解数据的分布和波动情况。

### 2.2 数据清洗的重要性与方法

#### 2.2.1 数据清洗流程概述

数据清洗流程通常包括以下步骤:

1. **数据集成**:整合来自不同来源的数据。

2. **数据清洗**:处理重复记录、纠正错误和不一致。

3. **数据转换**:将数据转换成适合分析的格式。

4. **数据规约**:减少数据集的大小,但保持数据的完整性。

在数据清洗中,一个重要的环节是处理缺失值和异常值。缺失值的处理可以采用删除、填充或预测的方式。异常值的识别通常通过统计检验或可视化方法完成。

```python

import pandas as pd

# 创建一个数据框示例

df = pd.DataFrame({'A': [1, 2, None, 4], 'B': [4, None, 6, 8]})

# 删除含有缺失值的行

df_cleaned = df.dropna()

# 填充缺失值为均值

df_filled = df.fillna(df.mean())

```

**参数说明**:`df.dropna()` 用于删除含有缺失值的行或列;`df.fillna(df.mean())` 用数据框的均值填充缺失值。

#### 2.2.2 数据缺失值和异常值处理

处理缺失值时,需考虑缺失值的模式和缺失的原因。如果数据丢失是随机发生的,那么删除缺失数据或填充均值通常是合理的。如果数据丢失是非随机的,可能需要更复杂的处理方法。

异常值可能是由录入错误或其他异常情况导致的,但也可能是自然出现的变异。确定异常值后,可以将其从数据集中删除或替换为更合适的值,如均值、中位数或根据分布推测的值。

#### 2.2.3 数据格式转换与统一

数据格式的不一致性会增加数据处理的复杂性。统一数据格式,包括日期、货币、文本大小写等,是数据预处理的一个重要环节。

以下示例展示了如何处理日期格式:

```python

from datetime import datetime

# 原始日期数据

dates = ['2023-04-01', '4/2/2023', '03/04/2023']

# 将所有日期转换为统一格式

parsed_dates = [datetime.strptime(date, '%Y-%m-%d') for date in dates]

```

**参数说明**:`datetime.strptime(date, '%Y-%m-%d')` 将字符串转换为日期对象,`'%Y-%m-%d'`指定了日期的格式。

### 2.3 数据转换与特征工程

#### 2.3.1 数据归一化与标准化

数据归一化与标准化是减少数据维度差异,让模型处理数据更为方便的重要步骤。归一化通常指的是将数据缩放到0和1之间,而标准化则是减去均值后除以标准差,使得数据具有单位方差。

```python

from sklearn.preprocessing import MinMaxScaler, StandardScaler

# 假设有一个数据数组

data = [10, 20, 30, 40, 50]

# 使用MinMaxScaler进行归一化

scaler = MinMaxScaler()

data_normalized = scaler.fit_transform(data.reshape(-1, 1))

# 使用StandardScaler进行标准化

scaler = StandardScaler()

data_standardized = scaler.fit_transform(data.reshape(-1, 1))

```

**参数说明**:`MinMaxScaler()` 和 `StandardScaler()` 是用于数据归一化和标准化的类;`fit_transform()` 方法先拟合数据然后转换数据。

#### 2.3.2 特征选择与提取方法

特征选择和提取的目的是减少数据的维度,同时保留有助于模型训练和预测的关键信息。特征选择方法包括过滤式、包裹式和嵌入式三种类型。

过滤式方法通常基于数据的统计特性,比如皮尔森相关系数、卡方检验等。包裹式方法如递归特征消除(RFE)。嵌入式方法

0

0