R语言nnet包的可视化工具:洞察模型内部工作机制的秘籍

发布时间: 2024-11-01 19:19:20 阅读量: 27 订阅数: 23

# 1. R语言nnet包简介

R语言是一种广泛用于统计分析和数据科学的语言,nnet包则是R语言中用于构建和训练神经网络模型的一个重要工具包。nnet包提供了一种简单而有效的方式来实现神经网络算法,使其在数据分析和机器学习领域中得到了广泛的应用。

nnet包的核心功能是构建和训练多层感知器(MLP)神经网络,它通过前向传播和反向传播算法进行训练。在学习和应用nnet包时,不仅可以掌握神经网络的构建和训练技巧,还可以深入理解其背后的理论基础。

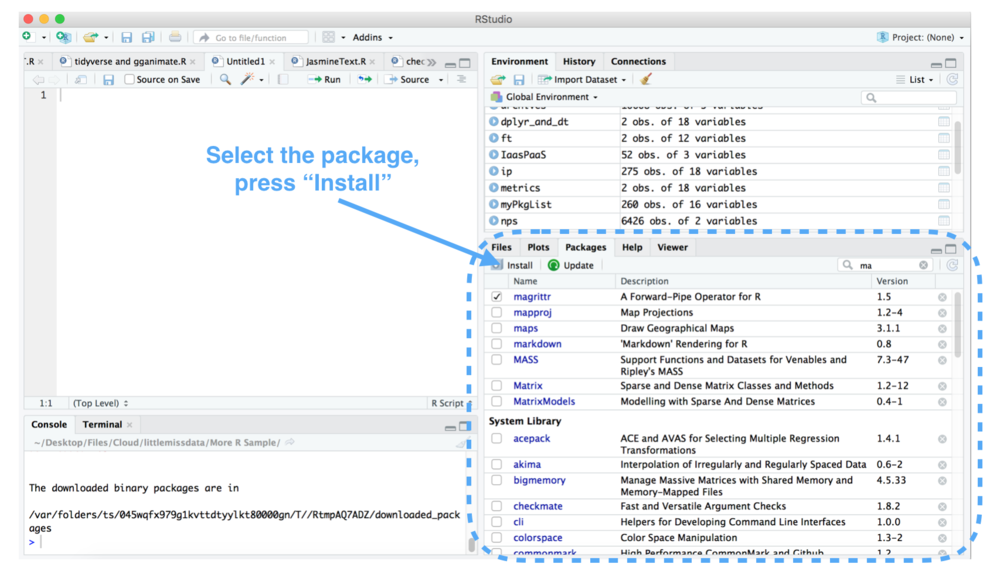

本章将首先介绍nnet包的基本使用方法,包括如何安装和加载nnet包,以及如何使用其核心函数nnet()构建一个基础的神经网络模型。通过本章的学习,读者将能够对nnet包有一个初步的了解,并为进一步深入学习和应用打下良好的基础。

# 2. nnet包的理论基础与模型构建

## 2.1 nnet包中的神经网络模型理论

### 2.1.1 神经网络的基本概念

在深入探讨`nnet`包之前,理解神经网络的基本概念是至关重要的。神经网络是一类模仿生物神经网络结构和功能的计算模型,由大量的节点(或称神经元)之间相互连接构成。每个连接可以传送一个信号,每个节点可以进行数学运算,比如加权求和,然后通过激活函数处理信号。这个网络能够学习大量的输入与输出之间的映射关系,无需对输入数据进行精确的数学描述。

神经网络的类型很多,包括前馈神经网络、卷积神经网络、循环神经网络等。`nnet`包主要提供了一种简单的前馈神经网络实现,对于更复杂的神经网络实现,可能需要调用如`keras`或`TensorFlow`等更先进的工具包。

### 2.1.2 前向传播和反向传播算法

神经网络的学习过程主要由前向传播和反向传播两个部分组成。在前向传播阶段,输入数据通过神经网络,从输入层经过隐藏层,最终到达输出层,每一层的神经元的输出都是基于其接收的输入通过激活函数计算得出。如果输出层的输出与期望输出不符,那么误差会被计算出来。

反向传播算法是训练神经网络的关键,它通过计算输出误差关于网络权重的梯度,然后根据梯度下降或其他优化算法,更新网络中的权重,以减少输出误差。`nnet`包中的函数正是基于这样的机制,使用梯度下降算法对神经网络的参数进行优化。

## 2.2 构建基本的神经网络模型

### 2.2.1 nnet函数的参数解析

`nnet`包中的核心函数是`nnet()`,它提供了构建和训练一个单隐藏层前馈神经网络的简便方法。该函数的参数众多,下面列举了一些关键参数:

- `formula`:指定模型的公式,类似于R中的`lm()`函数。

- `data`:包含变量的数据框或列表。

- `size`:整数或整数向量,指定隐藏层的神经元数量。

- `decay`:权重衰减参数,有助于防止过拟合。

- `maxit`:训练的最大迭代次数。

- `linout`:逻辑值,指示输出是否线性,对多类分类问题很有用。

### 2.2.2 使用nnet包构建模型的步骤

使用`nnet`包构建模型可以分为以下步骤:

1. **安装和加载nnet包:**

```R

install.packages("nnet")

library(nnet)

```

2. **准备数据:**

数据需要是适当格式的R数据框,通常需要进行预处理,比如编码类别变量、处理缺失值等。

3. **调用nnet函数:**

根据具体的数据集和问题,定义网络结构和参数,构建模型。

```R

model <- nnet(target ~ ., data = training_data, size = 10, decay = 0.0005, maxit = 200)

```

4. **评估模型性能:**

使用测试数据评估模型的预测性能,可能包括计算准确率、召回率等指标。

## 2.3 模型训练与验证

### 2.3.1 数据集的分割与预处理

在训练神经网络之前,通常需要将数据集分割为训练集和测试集。训练集用于训练模型,而测试集用于评估模型性能。此外,数据预处理是一个重要步骤,它包括标准化特征、编码分类变量、处理缺失值等。

### 2.3.2 交叉验证和模型性能评估

交叉验证是评估模型泛化能力的有效方法之一。在`nnet`包中可以结合其他函数实现交叉验证,比如`caret`包。性能评估通常涉及计算准确率、混淆矩阵、ROC曲线等指标,这些可以帮助我们了解模型在分类问题中的表现。

# 3. nnet包的可视化工具使用

## 3.1 模型权重与偏置的可视化

### 3.1.1 权重矩阵的绘制方法

在神经网络模型中,权重是连接不同神经元的参数,决定了模型学习到的数据表征的复杂性。权重矩阵的可视化有助于我们理解模型各层之间是如何相互作用的。在R语言的nnet包中,可以使用特定的函数来提取权重,并通过图形展示。

首先,使用`nnet`函数构建模型后,模型对象中包含了`wts`属性,即为权重矩阵。要可视化权重矩阵,我们可以使用`ggplot2`包来制作热图,这样的图形非常适合展示矩阵数据的分布。

```R

library(ggplot2)

# 假设model是已经训练好的nnet模型对象

# 提取权重矩阵并转置

weights_matrix <- t(model$wts)

# 转换为数据框,方便绘图

weights_df <- as.data.frame(weights_matrix)

# 绘制热图

ggplot(melt(weights_df), aes(Var1, Var2, fill=value)) +

geom_tile() +

scale_fill_gradient2(low="blue", high="red", mid="white", midpoint=0) +

theme_minimal() +

labs(title="权重矩阵热图", x="神经元", y="权重")

```

在上述代码中,`melt`函数用于将权重矩阵转换为长格式数据框,`geom_tile`函数用于绘制热图的瓦片,`scale_fill_gradient2`定义了颜色渐变的范围,其中颜色的深浅代表权重值的大小。

### 3.1.2 偏置项的可视化展示

偏置项(Bias)是神经网络中每个神经元固有的参数,它影响着模型输出的截距。可视化偏置项可以帮助我们了解模型中的线性偏移量。

nnet包直接提供了偏置项的值,可以通过类似权重矩阵的方式提取并展示。这里使用`barplot`函数直接绘制偏置项的条形图,使得每层的偏置值一目了然。

```R

# 假设model是已经训练好的nnet模型对象

# 提取偏置项

biases <- model$wts

# 为条形图添加标签

bias_labels <- paste0("层", seq_along(biases))

# 绘制偏置项条形图

barplot(biases, names.arg = bias_labels, col = "steelblue",

main="偏置项条形图", xlab="层", ylab="偏置项值",

las=1, cex.names=0.8)

```

在执行上述代码后,我们会得到一个条形图,其中横坐标表示不同的层,纵坐标显示了各层的偏置项值。

## 3.2 神经网络结构的图形表示

### 3.2.1 网络层次和连接的可视化

理解神经网络的层次结构和节点之间的连接关系对于调试模型和解释结果至关重要。虽然nnet包没有直接提供绘制整个网络结构的函数,但我们可以通过其他方式来展示这些信息。

一种方法是使用`neuralnet`包中的`plot`函数,尽管这需要将nnet模型对象转换为`neuralnet`模型对象。这不总是直接可行的,但假设我们能够这样做,下面是一个示例代码。

```R

library(neuralnet)

# 需要将nnet模型转换为neuralnet模型

nn_model <- neuralnet(formula, data, ...)

# 绘制网络结构

plot(nn_model)

```

该代码将生成一个图,直观显示网络的层次以及各层之间的连接情况,非常适合初学者理解神经网络的内部结构。

### 3.2.2 激活函数的选择与可视化

激活函数在神经网络中起着至关重要的作用,它决定了神经元的输出是否应该被激活以及如何激活。在R语言中,激活函数的可视化通常不依赖于nnet包,而是需要自己实现或者使用第三方库。

激活函数的可视化通常涉及到在函数值和输入值之间绘制关系图。例如,最常见的激活函数之一是ReLU(Rectified Linear Unit),其数学表达式为 `f(x) = max(0, x)`。下面是一个使用R语言中的基础函数绘制ReLU激活函数的示例:

```R

# 定义ReLU激活函数

relu <- function(x) pmax(0, x)

# 生成输入值

input_values <- seq(-2, 2, by=0.01)

# 应用激活函数

output_values <- relu(input_values)

# 绘制ReLU激活函数图形

plot(input_values, output_values, type="l", col="red",

main="ReLU激活函数图", xlab="输入值", ylab="输出值")

```

通过上述代码,我们可以看到ReLU函数在输入值为0的左侧是完全平的,而在输入值为0的右侧则随着输入值线性增加。

## 3.3 预测结果的可视化分析

### 3.3.1 实际值与预测值对比图

为了评估模型的预测能力,实际值与预测值对比图是一个直观的方式。通过这种图表,我们可以清楚地看到模型预测的准确性如何,以及是否存在系统性的偏差。

```R

# 假设actual是实际值向量,predicted是预测值向量

# 绘制散点图

plot(actual, predicted, pch=19, col=ifelse(actual == predic

```

0

0