R语言nnet包案例研究:7个实战步骤,手把手教你模型预测

发布时间: 2024-11-01 18:39:55 阅读量: 19 订阅数: 27

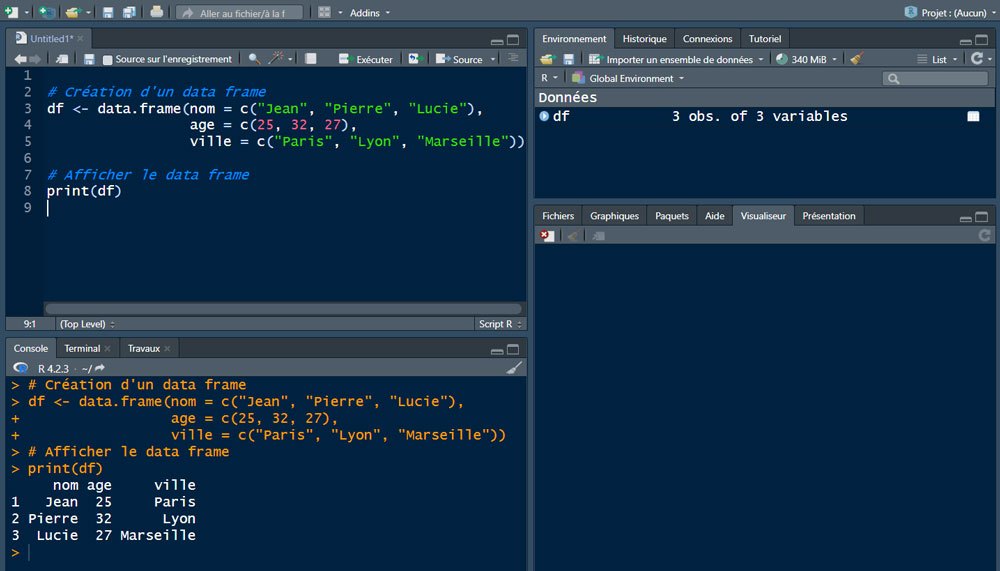

# 1. R语言nnet包基础介绍

## 简介

R语言是一个用于统计计算和图形的强大编程语言和软件环境。nnet包是R中一个流行的用于构建简单神经网络的工具包。在本章中,我们将探讨nnet包的基本功能,及其在机器学习任务中的应用。

## nnet包特性

nnet包支持前馈神经网络的训练,并可以处理分类或回归任务。它特别适用于数据集较小,结构相对简单的场景。该包提供了简便的函数接口,允许用户快速训练和预测。

## 快速开始

对于R语言用户而言,安装nnet包非常简单,只需在R控制台输入`install.packages("nnet")`即可。接下来,我们将通过例子来演示如何使用nnet包构建基础的神经网络模型,并解释其工作原理。

# 2. 构建nnet神经网络模型

### 2.1 神经网络基础知识

#### 2.1.1 神经网络的组成和工作原理

神经网络是一种模仿生物神经网络(人脑结构)进行信息处理的数学模型。它由大量的节点(或称“神经元”)以及节点间的连接线路组成。每个神经元可以看作是一个处理单元,它通过加权输入、激活函数的处理后输出结果。神经网络的工作原理可以简单描述为:输入数据经过加权求和和激活函数处理后,生成输出数据,输出数据再作为下一层的输入,直至最后一层输出最终结果。

神经网络的连接通常分为三种类型:

- 前馈网络:输入从输入层流向输出层,不形成循环。

- 反馈网络(递归网络):网络中存在反馈连接,允许信号在节点间循环传递。

- 自联想网络:专门设计用来重建输入的网络,常用于模式识别。

#### 2.1.2 神经网络的类型和选择

神经网络的类型繁多,包括但不限于以下几种:

- 前馈神经网络(FFNN):最基础的神经网络类型,适用于分类和回归任务。

- 卷积神经网络(CNN):常用于图像处理和分析,能够自动提取特征。

- 循环神经网络(RNN):擅长处理序列数据,例如自然语言处理。

- 深度信念网络(DBN):是一种包含多个隐藏层的生成模型,通常用于特征提取。

- 自编码器(Autoencoder):通过学习输入数据的有效表示,常用于降维和特征学习。

选择适合的神经网络类型主要取决于数据的特性和问题的性质。例如,若数据为时间序列,则选择循环神经网络更为合适;若为图像数据,则卷积神经网络可能是更好的选择。

### 2.2 nnet包安装与环境准备

#### 2.2.1 安装R语言和nnet包

安装R语言可通过官方网站下载对应操作系统的安装包进行安装。安装好R后,安装nnet包可以通过R的包管理命令进行:

```R

install.packages("nnet")

```

一旦安装完成,我们就可以在R环境中调用nnet包进行神经网络模型的构建。

#### 2.2.2 环境配置和依赖检查

为了确保nnet包正确安装并能正常运行,我们需要配置R的运行环境,并检查所有必需的依赖是否都已经满足。这可以通过R的内置函数和nnet包提供的功能进行检查:

```R

library(nnet) # 加载nnet包

sessionInfo() # 查看当前R环境信息

```

在确认了环境配置正确无误后,我们可以继续进行神经网络模型的构建。

### 2.3 构建简单的nnet模型

#### 2.3.1 模型参数的设定

在构建nnet模型之前,需要设定模型相关的参数。nnet函数的基本参数包括:

- `size`:指定隐藏层神经元的数量。

- `linout`:一个逻辑值,当因变量是连续值时,此参数应设置为 TRUE。

- `decay`:权重衰减参数,用于防止过拟合。

- `skip`:一个逻辑值,允许某些连接被跳过,用于增加模型的复杂性。

```R

nnet_model <- nnet(formula, data, size = 10, linout = FALSE, decay = 0.1, skip = FALSE)

```

#### 2.3.2 使用nnet函数训练模型

使用nnet函数训练模型之前,需要准备好数据,并将其格式化为公式(formula)和数据框(data frame)。下面的代码块展示了如何准备数据并训练一个简单的nnet模型:

```R

# 准备数据

formula <- y ~ x1 + x2 + x3 # 假设y是因变量,x1, x2, x3是自变量

data <- read.csv("data.csv") # 从数据文件读取数据

# 训练模型

nnet_model <- nnet(formula, data = data, size = 5)

# 查看模型结构

summary(nnet_model)

```

在上面的示例中,我们首先定义了模型的公式和数据来源。然后,我们使用nnet函数训练了一个具有5个隐藏单元的简单模型。最后,我们使用summary函数来查看模型的详细结构和相关信息,例如权重和各单元的激活。

通过上述步骤,我们就完成了一个基本的nnet神经网络模型的构建和训练过程。然而,在实践中,往往需要进行更复杂的预处理和参数调整来优化模型性能。

# 3. nnet模型数据预处理

## 3.1 数据集准备和探索

### 数据集的获取和导入

在机器学习项目中,准确且高质量的数据是成功建模的关键。R语言提供了多种方式获取和导入数据集,包括使用内置数据集、读取本地文件(如CSV、Excel等)、连接数据库或通过API获取在线数据集。

为了确保分析的准确性,需要对数据集来源进行严格的审查。首先,确定数据集是否适合所要解决的问题。接下来,导入数据到R环境中,可以使用`read.csv`或`readxl`包中的`read_excel`函数来读取常见的文件格式。

下面是一段示例代码,展示如何导入一个CSV格式的数据集:

```r

# 如果还没有安装readr包,请先运行 install.packages("readr")

library(readr)

# 从本地读取CSV文件

data <- read_csv("path/to/your/dataset.csv")

# 如果数据在URL上,可以使用read_csv函数直接读取

data <- read_csv("***")

```

一旦数据被导入,下一步是进行初步的数据探索。

### 数据探索性分析方法

在任何数据分析项目中,理解数据的基本特征是至关重要的。数据探索性分析方法包括数据类型检查、统计摘要、缺失值和异常值的识别、数据分布情况的可视化等。

R语言的`summary`函数可以提供数据集的概览,包括每列的中位数、均值、四分位数等统计信息。`str`函数则显示数据结构,帮助确定每列数据的类型。

```r

# 使用summary函数获取数据集的统计摘要

summary(data)

# 使用str函数查看数据结构

str(data)

```

数据可视化是探索性数据分析中的一个关键环节。可以使用`ggplot2`包来绘制数据的分布图、箱型图等图形,快速发现数据分布的特征和潜在问题。

```r

# 加载ggplot2包

library(ggplot2)

# 绘制数据的直方图

ggplot(data, aes(x = variable_name)) +

geom_histogram(bins = 30) +

theme_minimal()

```

## 3.2 数据预处理技术

### 缺失值处理

数据集中不可避免会有缺失值,处理缺失值的方法包括删除含有缺失值的行或列、使用均值、中位数或众数填充、或者利用更高级的方法如预测模型进行填充。选择哪种方法取决于缺失值的比例和数据集的性质。

```r

# 删除含有缺失值的所有行

data_clean <- na.omit(data)

# 使用列的均值填充缺失值

colMeans(data, na.rm = TRUE)

# 使用预测模型填充缺失值(例如,使用随机森林)

library(randomForest)

rf_model <- randomForest(y ~ ., data = data, na.action = na遗漏)

data$variable <- predict(rf_model, newdata = data)

```

### 特征选择和工程

在建模之前,特征选择是去除冗余和不相关特征的重要步骤。这有助于减少模型训练时间和避免过拟合。特征选择可以通过相关性分析、递归特征消除(RFE)、基于模型的特征重要性等方法实现。

```r

# 使用相关性分析

cor_matrix <- cor(data)

# 选择相关性较高的特征

# 使用递归特征消除(以随机森林为例)

library(caret)

control <- rfeControl(functions=rfFuncs, method="cv", number=10)

results <- rfe(data, target_var, rfeControl=control)

results$optVariables

```

特征工程是数据预处理中的另一个关键步骤,它包括创建新特征、组合现有特征、以及

0

0