Python爬虫数据可视化:用图表展示爬取结果,直观呈现数据价值

发布时间: 2024-06-18 17:47:23 阅读量: 172 订阅数: 56

1. Python爬虫数据可视化概述

数据可视化是将数据以图形方式呈现的过程,它可以帮助我们更直观地理解和分析数据。Python是一种流行的编程语言,提供了丰富的库和工具,用于从网络爬取数据并进行可视化。

通过使用Python爬虫,我们可以从各种网站和在线平台中提取数据。这些数据可以包含产品信息、用户行为、财务数据等。一旦数据被爬取,我们就可以使用Python数据可视化库将其转换为可视化表示形式,例如图表、图形和地图。

数据可视化在IT行业和相关行业中具有广泛的应用。它可以帮助我们识别趋势、发现模式、进行预测并做出明智的决策。通过使用Python爬虫和数据可视化技术,我们可以从海量数据中提取有价值的见解,并以更有效的方式传达信息。

2. Python数据可视化库介绍

2.1 Matplotlib:基础绘图和图表库

Matplotlib是Python中广泛使用的基础绘图和图表库。它提供了各种绘图功能,包括折线图、柱状图、散点图等,以及对图表进行自定义和美化的选项。

2.1.1 折线图、柱状图、散点图绘制

Matplotlib提供了绘制折线图、柱状图和散点图的简单方法。

代码逻辑分析:

plt.plot():绘制折线图,参数为x轴和y轴数据。plt.xlabel()和plt.ylabel():设置x轴和y轴标签。plt.title():设置图表标题。plt.show():显示图表。

2.1.2 图表自定义和美化

Matplotlib提供了丰富的选项来自定义和美化图表,包括设置颜色、线宽、标记样式等。

代码逻辑分析:

color:设置折线颜色。linewidth:设置折线宽度。marker:设置散点标记样式。grid():显示网格线。legend():添加图例。title()、xlabel()和ylabel():设置标题和标签。

3.1 数据爬取技术

3.1.1 网页解析和数据提取

网页解析是爬虫技术的基础,其目的是从网页中提取所需的数据。常用的网页解析技术包括:

- **HTML解析:**使用HTML解析器(如BeautifulSoup)解析网页的HTML结构,提取特定标签或属性中的数据。

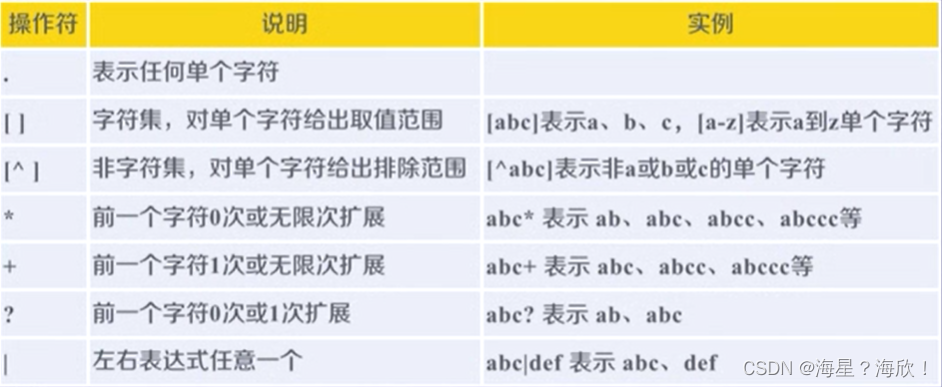

- **正则表达式:**使用正则表达式匹配和提取网页中的特定数据模式。

- **XPath:**使用XPath表达式在XML文档中查找和提取数据。

3.1.2 爬虫框架和工具介绍

为了简化爬虫开发,出现了各种爬虫框架和工具,它们提供了丰富的功能和易用性。一些流行的爬虫框架和工具包括:

- **Scrapy:**一个功能强大的爬虫框架,提供数据提取、持久化和并发处理等功能。

- **Beautiful Soup:**一个HTML解析库,支持多种解析方法和选择器语法。

- **Selenium:**一个浏览器自动化工具,可以模拟用户在浏览器中的操作,用于动态网页的爬取。

代码块:

- import requests

- from bs4 import BeautifulSoup

- # 获取网页内容

- url = 'https://www.example.com'

- response = requests.get(url)

- # 解析HTML

- soup = BeautifulSoup(response.text, 'html.parser')

- # 提取特定数据

- title = soup.find('title').text

逻辑分析:

该代码块演示了如何使用Requests库获取网页内容,然后使用BeautifulSoup库

0

0