Python爬虫实战:从0到1构建一个完整爬虫项目,掌握爬虫开发秘诀

发布时间: 2024-06-18 17:35:49 阅读量: 149 订阅数: 55

# 1. Python爬虫基础**

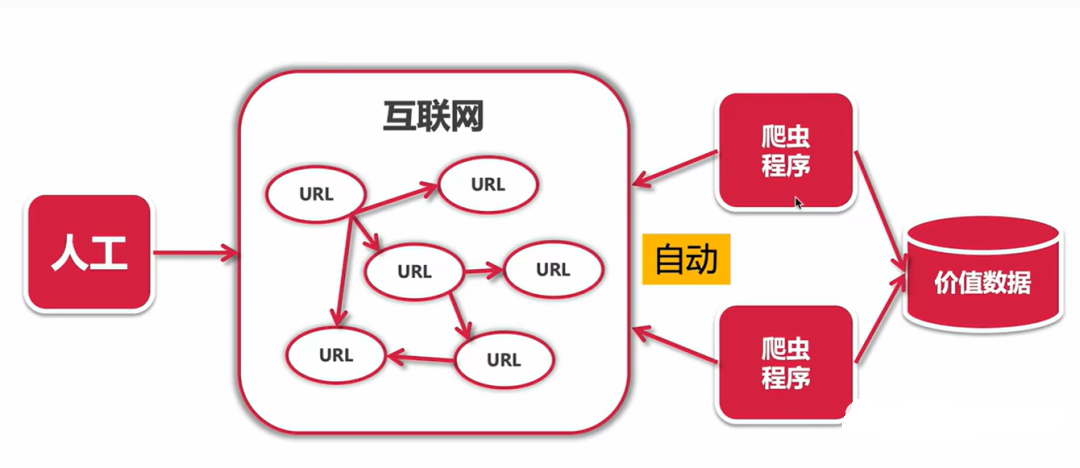

Python爬虫是一种使用Python语言编写的网络爬虫,用于从互联网上提取数据。它涉及以下基本概念:

* **HTTP请求和响应:**爬虫使用HTTP请求从网络服务器获取数据,服务器以HTTP响应的形式返回数据。

* **网页解析:**爬虫使用解析器从HTML或JSON响应中提取所需的数据。

* **数据存储:**爬虫将提取的数据存储在数据库、文件或其他存储介质中。

# 2. 爬虫开发实战**

**2.1 爬虫架构与设计**

**2.1.1 爬虫架构概述**

爬虫架构是爬虫系统的设计蓝图,它决定了爬虫的整体结构、功能和性能。常见的爬虫架构包括:

* **单线程架构:**一个线程负责所有爬取任务,简单易实现,但并发性差。

* **多线程架构:**多个线程并行爬取,提高并发性,但线程管理复杂。

* **分布式架构:**多个爬虫节点协同工作,扩展性好,但开发难度大。

**2.1.2 爬虫设计模式**

爬虫设计模式是针对爬虫开发的特定设计模式,旨在提高爬虫的效率、可维护性和可扩展性。常见的爬虫设计模式包括:

* **生产者-消费者模式:**生产者负责爬取网页,消费者负责解析和存储数据。

* **管道模式:**将爬虫过程分解为一系列独立的阶段,每个阶段执行特定任务。

* **代理模式:**使用代理服务器隐藏爬虫的真实身份,避免被网站封禁。

**2.2 爬虫实现与优化**

**2.2.1 爬虫请求与解析**

爬虫请求负责向目标网站发送请求,获取网页内容。爬虫解析负责从网页内容中提取所需数据。常用的爬虫请求库包括:

```python

import requests

# GET 请求

response = requests.get("https://www.example.com")

# POST 请求

data = {"username": "admin", "password": "password"}

response = requests.post("https://www.example.com/login", data=data)

```

常用的爬虫解析库包括:

```python

import bs4

# 创建 BeautifulSoup 对象

soup = bs4.BeautifulSoup(response.text, "html.parser")

# 提取标题

title = soup.find("title").text

```

**2.2.2 数据存储与管理**

爬虫爬取的数据需要存储和管理,以供后续使用。常用的数据存储方式包括:

* **关系型数据库:**如 MySQL、PostgreSQL,结构化存储,查询效率高。

* **非关系型数据库:**如 MongoDB、Redis,非结构化存储,扩展性好。

* **文件系统:**如 CSV、JSON,简单易用,但查询效率低。

**2.2.3 爬虫性能优化**

爬虫性能优化至关重要,以提高爬取效率和避免被网站封禁。常见的爬虫性能优化方法包括:

* **使用代理:**隐藏爬虫身份,避免被封禁。

* **限制请求频率:**避免对网站造成过大压力。

* **使用缓存:**避免重复爬取相同内容。

* **多线程并行:**提高并发性,加快爬取速度。

# 3.1 分布式爬虫

#### 3.1.1 分布式爬虫原理

分布式爬虫是一种将爬虫任务分布在多个节点上并行执行的爬虫架构。它通过将爬取任务分解成更小的子任务,然后将这些子任务分配给不同的节点来实现并行处理。这种架构可以显著提高爬虫的效率和吞吐量。

分布式爬虫通常由以下组件组成:

- **调度器:**负责分配爬取任务给不同的节点。

- **节点:**执行爬取任务并返回结果的服务器或计算机。

- **存储:**存储爬取到的数据的数据库或文件系统。

#### 3.1.2 分布式爬虫实现

实现分布式爬虫需要考虑以下几个关键因素:

- **任务分解:**将爬取任务分解成更小的子任务,以便在不同的节点上并行执行。

- **任务分配:**设计一种算法来将任务分配给不同的节点,以确保负载均衡和资源利用率最大化。

- **数据同步:**确保不同节点之间的数据同步,以避免数据丢失或不一致。

- **容错处理:**设计容错机制来处理节点故障或网络中断等异常情况。

#### 代码示例:

```python

# 分布式爬虫调度器

class Scheduler:

def __init__(self, nodes):

self.nodes = nodes

self.tasks = []

def add_task(self, task):

self.tasks.append(task)

def assign_tasks(self):

for node in self.nodes:

while len(node.tasks) < node.max_tasks:

if len(self.tasks) > 0:

task = self.tasks.pop(0)

node.add_task(task)

# 分布式爬虫节点

class Node:

def __init__(self, max_tasks=10):

self.tasks = []

self.max_tasks = max_tasks

def add_task(self, task):

self.tasks.append(task)

def run_tasks(self):

for task in self.tasks:

result = task.run()

# 将结果存储到数据库或文件系统

```

#### 逻辑分析:

上述代码实现了分布式爬虫调度器和节点。调度器负责将任务分配给节点,而节点负责执行任务并返回结果。通过这种方式,爬取任务可以并行执行,提高爬虫的效率。

# 4.1 电商数据爬取

### 4.1.1 电商数据分析

电商数据是反映电商平台运营状况和用户行为的重要指标,通过分析这些数据,可以为电商企业提供决策支持,优化运营策略,提升用户体验。电商数据主要包括以下几个方面:

- **商品数据:**包括商品名称、价格、销量、库存、评论等信息。

- **用户数据:**包括用户注册信息、购买记录、浏览记录、搜索记录等信息。

- **交易数据:**包括订单信息、支付信息、物流信息等信息。

- **市场数据:**包括行业竞争情况、市场份额、用户画像等信息。

### 4.1.2 电商数据爬取案例

**案例一:京东商品数据爬取**

**需求:**爬取京东平台指定类目的商品名称、价格、销量、评论等信息。

**实现:**

1. **确定爬虫目标:**确定要爬取的京东类目,如手机类目。

2. **分析页面结构:**通过浏览京东手机类目页面,分析商品列表页面的HTML结构,确定商品信息的定位规则。

3. **编写爬虫代码:**使用Python的Requests库发送HTTP请求,并使用BeautifulSoup库解析HTML页面,提取商品信息。

4. **数据存储:**将爬取到的商品信息存储到数据库或CSV文件中。

**代码块:**

```python

import requests

from bs4 import BeautifulSoup

# 发送HTTP请求

response = requests.get("https://www.jd.com/category/670-671-672.html")

# 解析HTML页面

soup = BeautifulSoup(response.text, "html.parser")

# 提取商品信息

product_list = soup.find_all("li", class_="gl-item")

for product in product_list:

product_name = product.find("div", class_="p-name").text.strip()

product_price = product.find("strong", class_="J-p-7d6").text.strip()

product_sales = product.find("span", class_="p-sale").text.strip()

product_comments = product.find("a", class_="J-p-review").text.strip()

print(f"商品名称:{product_name}")

print(f"商品价格:{product_price}")

print(f"商品销量:{product_sales}")

print(f"商品评论:{product_comments}")

print("-------------------------------------")

```

**逻辑分析:**

1. 使用Requests库发送HTTP请求,获取京东手机类目页面。

2. 使用BeautifulSoup库解析HTML页面,获取商品列表。

3. 遍历商品列表,提取商品名称、价格、销量、评论等信息。

4. 将提取到的商品信息打印输出。

**参数说明:**

- `requests.get()`:发送HTTP GET请求。

- `BeautifulSoup()`:解析HTML页面。

- `find_all()`:查找所有符合条件的HTML元素。

- `text.strip()`:获取HTML元素的文本内容并去除空格。

# 5.1 爬虫框架与工具

### 5.1.1 爬虫框架概述

爬虫框架是一个预先构建的软件库,它提供了开发和管理爬虫所需的基本组件。它封装了爬虫的通用功能,如请求处理、数据解析和存储,从而简化了爬虫开发过程。

爬虫框架的主要优点包括:

- **提高开发效率:**通过提供预先构建的组件,框架可以显著减少开发时间。

- **增强可维护性:**框架通常遵循良好的设计模式,这有助于提高代码的可读性和可维护性。

- **扩展性:**框架通常提供扩展点,允许开发人员轻松地添加自定义功能。

### 5.1.2 爬虫工具介绍

除了爬虫框架之外,还有许多专门的爬虫工具可用于简化爬虫开发过程。这些工具包括:

- **HTTP请求库:**用于发送HTTP请求和处理响应,如Requests和urllib3。

- **解析库:**用于从HTML或XML文档中提取数据的库,如BeautifulSoup和lxml。

- **数据存储库:**用于存储和管理爬取数据的库,如MongoDB和SQLAlchemy。

- **代理池:**用于管理代理服务器的库,以绕过反爬虫措施,如Scrapy-Splash和Scrapy-Tor。

- **爬虫管理工具:**用于管理和监控爬虫的工具,如Scrapyd和Airflow。

0

0