MapReduce高级技术:并行处理大文件的技巧与实践

发布时间: 2024-11-01 13:24:54 阅读量: 13 订阅数: 23

# 1. MapReduce并行处理基础

## MapReduce简介

MapReduce是一种分布式数据处理模型,它允许开发者通过简单的Map和Reduce两个操作,将复杂的并行处理任务抽象化。作为一种编程模型,MapReduce适用于大规模数据集的处理,广泛应用于搜索引擎、数据挖掘等大数据处理场景。

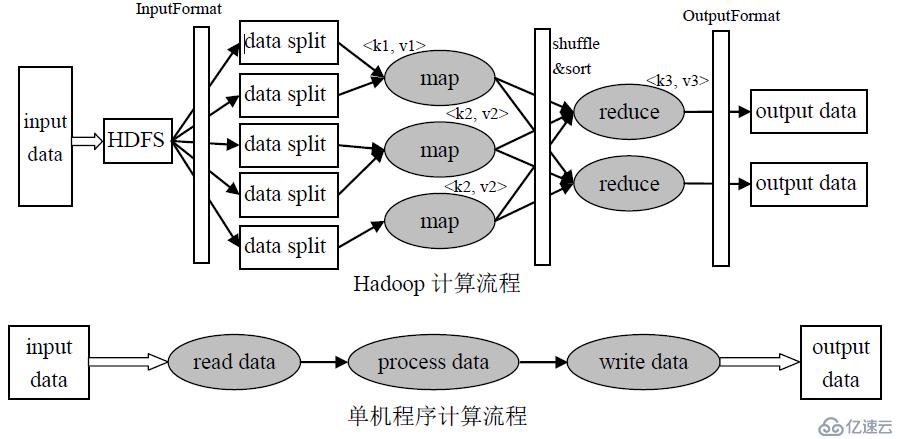

## MapReduce的工作原理

MapReduce的工作原理可简单概括为三个步骤:Map(映射)、Shuffle(洗牌)和Reduce(归约)。在Map阶段,输入数据被分片处理并转换成键值对(key/value pairs)。Shuffle阶段则负责将相同键的数据集中到一起。最后,Reduce阶段将这些键值对按键进行合并,输出最终结果。

## MapReduce应用场景

MapReduce能够处理TB级别的数据集,适用于对数据的统计、排序、过滤等操作。例如,它可以用于Web日志分析,将访问日志按照用户信息进行分组,并统计每个用户的访问次数。

```java

// 示例:MapReduce的伪代码

map(String key, String value):

// key: document name

// value: document contents

for each word w in value:

EmitIntermediate(w, "1");

reduce(String key, Iterator values):

// key: a word

// values: a list of counts

int result = 0;

for each v in values:

result += ParseInt(v);

Emit(AsString(result));

```

通过这个简单的例子,我们可以看到MapReduce模型如何将一个复杂的计算任务分解成两个阶段:Map阶段的分词和计数,以及Reduce阶段的汇总计数。这种模型的可扩展性使其能够处理大规模数据集,是大数据处理不可或缺的技术之一。

# 2. MapReduce高级编程技巧

## 2.1 数据分割与输入格式

### 2.1.1 数据分割策略

在MapReduce框架中,数据分割(Splitting)是将输入数据切分成独立的块(Splits),这样就可以在多个Mapper之间进行并行处理。一个良好的数据分割策略可以显著提高处理效率,避免数据倾斜现象,保证各个Map任务负载均衡。

分割策略的选择依赖于数据的特性和任务的需求。以下是常用的几种策略:

- 均匀分割(Uniform Splitting): 最简单的分割策略,每个Split的大小尽量保持一致。这种策略简单易行,但可能不会考虑到数据的实际分布,有时会导致数据倾斜问题。

- 哈希分割(Hash Splitting): 使用哈希函数对数据的键(Key)进行处理,以确保具有相似键的数据被划分到同一个Split中。这样可以有效避免数据倾斜问题,尤其适用于数据量非常大的情况。

- 自定义分割(Custom Splitting): 根据数据的实际内容和任务需求来定义分割逻辑。例如,如果数据按照时间戳排序,则可以根据时间间隔进行分割。

选择合适的分割策略是优化MapReduce作业性能的关键因素。在实践中,通常需要根据实际数据集和计算需求进行多次尝试和调整。

### 2.1.2 自定义输入格式

MapReduce框架提供了灵活的接口来定义自定义输入格式。通过继承`InputFormat`类并实现`createRecordReader`和`getSplits`方法,开发者可以对数据读取和分割过程进行精确控制。

自定义输入格式可以解决一些特定的数据处理场景,例如:

- 处理非结构化数据,如日志文件。

- 对特定数据格式进行解析,如CSV、JSON或XML。

- 优化数据读取过程,提高性能。

在自定义输入格式时,重点需要考虑以下两个方法的实现:

- `getSplits`: 定义如何将输入数据集分割成多个Split。需要考虑到数据本地化(Data Locality),即将数据和计算任务尽可能放在同一个节点上进行。

- `createRecordReader`: 定义如何从一个Split中读取数据。需要考虑如何高效地解析数据并将其转换为键值对(KVs)供Mapper使用。

下面是一个自定义输入格式的示例代码:

```java

public class CustomInputFormat extends FileInputFormat<LongWritable, Text> {

@Override

public RecordReader<LongWritable, Text> createRecordReader(InputSplit split, TaskAttemptContext context) {

return new CustomRecordReader();

}

@Override

public List<InputSplit> getSplits(JobContext job) throws IOException {

// 实现数据分割逻辑

// ...

}

}

class CustomRecordReader extends RecordReader<LongWritable, Text> {

// 实现读取逻辑

// ...

}

```

在自定义`createRecordReader`时,需要处理输入数据并将其转换为MapReduce框架所期望的键值对形式。自定义`getSplits`方法则需要基于数据集的特性来划分数据。

## 2.2 MapReduce性能优化

### 2.2.1 Map和Reduce任务调优

在MapReduce的作业执行过程中,Map任务和Reduce任务的调优是提升性能的关键环节。理解并正确设置相关参数对于优化作业执行至关重要。

以下是几个关键的性能调优策略:

- 控制Map任务数量:通过`mapreduce.job.maps`参数可以设置Map任务的数量。如果Map任务过多,会增加任务调度的开销,过少则会导致资源利用不充分。通常需要根据集群的实际负载和数据规模进行调整。

- 设置合理的Map内存大小:通过`mapreduce.map.java.opts`参数可以设置Map任务的内存大小。如果内存设置过小,Map任务可能会因为内存溢出而失败;设置过大,则可能造成资源浪费。

- 调整Reduce任务数量:通过`mapreduce.job.reduces`参数可以设置Reduce任务的数量。这个参数的调整需要考虑Reduce端的数据量和网络带宽。

- 设置合理的Reduce内存大小:通过`mapreduce.reduce.java.opts`参数可以设置Reduce任务的内存大小。这同样需要根据实际的数据量和网络状况来调整。

调优MapReduce作业的性能,往往需要根据具体的业务场景和集群的硬件资源进行多次测试和优化,找到最佳的性能平衡点。

### 2.2.2 缓存文件与Combiner的使用

缓存文件(DistributedCache)和Combiner是MapReduce提供的两个优化工具,它们可以帮助减少网络传输的数据量,提高计算效率。

- 缓存文件:通过DistributedCache可以在作业运行前将文件分发到所有TaskTracker节点。这样,在Mapper或Reducer运行时,可以直接使用这些文件。这一机制常用于提供辅助数据集或配置文件,例如字典文件、机器学习模型等。

- Combiner:Combiner是在Map任务结束后和Reduce任务开始前对Map输出进行局部合并的组件。它的使用减少了传输到Reduce端的数据量,并且能够减少Reduce任务的计算压力。Combiner的使用需要保证合并操作满足交换律和结合律。

合理利用缓存文件和Combiner可以显著提升MapReduce作业的效率。例如,当Map任务输出的中间数据需要进行大量相同操作时,可以使用Combiner来减少相同操作的重复次数,如计数、求和等。

### 2.2.3 JVM重用和Shuffle优化

JVM重用和Shuffle过

0

0