MapReduce大文件处理案例:7个优化策略与经验分享

发布时间: 2024-11-01 13:14:46 阅读量: 22 订阅数: 23

# 1. MapReduce大文件处理概述

MapReduce作为大数据处理领域的重要技术之一,常用于处理大规模数据集。它通过分而治之的策略,将复杂的数据处理任务分解为Map和Reduce两个阶段,有效提高了数据处理的并行性和扩展性。然而,在处理大文件时,MapReduce面临着性能瓶颈和资源分配的挑战,这要求我们对大文件的处理方式进行优化。从数据倾斜到内存管理,本章将深入探讨MapReduce在处理大文件时面临的问题,并为后续章节对优化策略的讨论打下基础。通过本章,读者将对MapReduce在大文件处理中的应用有一个全面而深入的理解,为后续章节中的优化策略和案例分析奠定基础。

# 2. 理论基础与核心概念

MapReduce作为一种编程模型,广泛应用于处理大规模数据集。在深入探讨优化策略之前,首先我们需要理解其核心概念和工作原理,以及在处理大文件时面临的一些挑战。

## 2.1 MapReduce工作原理

### 2.1.1 MapReduce编程模型

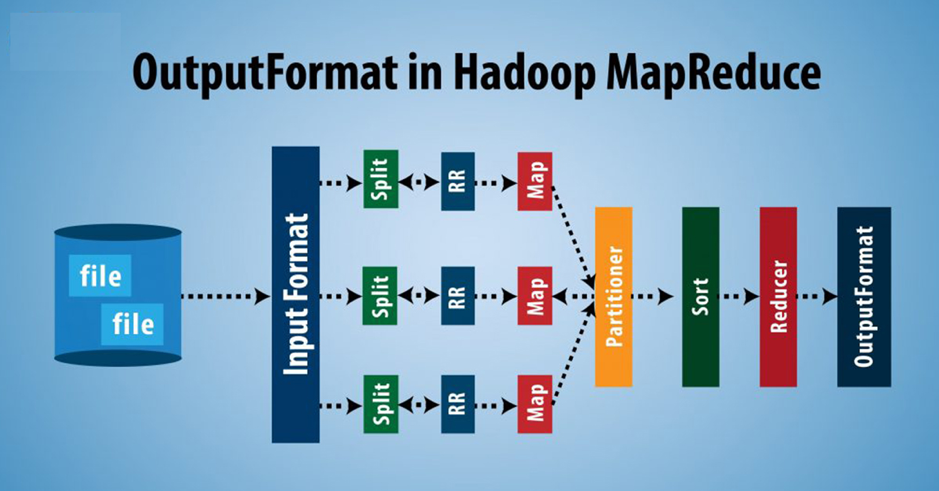

MapReduce编程模型的核心思想是“分而治之”,通过把对大规模数据集的处理分解成两个阶段:Map阶段和Reduce阶段。Map阶段处理输入数据,输出中间键值对(key-value pairs);Reduce阶段则对具有相同键的所有值进行归约操作。

#### Map阶段

在Map阶段,系统首先对输入数据集进行切片(splitting),然后每个切片被分配给一个Map任务。Map函数读取数据集中的每条记录(record),对每条记录执行用户定义的操作,然后输出中间键值对。这些中间键值对会被排序和合并,为Reduce阶段做准备。

#### Reduce阶段

Reduce阶段开始时,系统会自动对Map阶段输出的中间键值对进行分组,所有相同键的值会被聚集成一个列表,然后传递给Reduce函数。Reduce函数处理这些值列表,输出最终结果。最终结果一般被写入到输出文件中。

### 2.1.2 Map与Reduce函数的工作流程

#### Map函数

Map函数由用户根据具体需求实现,其核心工作流程是接收一个输入记录,对输入进行处理并输出一系列键值对。例如,在文本处理任务中,Map函数可能会读取文本文件的一行作为输入,然后输出每个单词及其出现的次数。

```java

map(String key, String value):

// key: document name

// value: document contents

for each word w in value:

EmitIntermediate(w, "1");

```

这段伪代码展示了Map函数的一个简单例子,它将每行文本拆分为单词,并为每个单词输出一个键值对,键是单词,值是数字"1"。

#### Reduce函数

Reduce函数接收一组具有相同键的中间值列表,然后将这些值合并为一个输出值。在文本处理的例子中,Reduce函数将相同单词的所有计数进行累加,输出最终的单词计数。

```java

reduce(String key, Iterator values):

// key: a word

// values: a list of counts

int result = 0;

for each val in values:

result += ParseInt(val);

Emit(key, IntToString(result));

```

这段伪代码展示了Reduce函数的工作流程,它对每个单词出现的次数进行累加,并输出最终的计数值。

## 2.2 大文件处理的挑战

### 2.2.1 数据倾斜问题

在处理大文件时,MapReduce可能会遇到数据倾斜的问题。数据倾斜指的是数据分布不均匀,导致某些Map或Reduce任务的处理时间远高于其他任务。这会导致整体处理时间被拖长,因为MapReduce需要等待所有任务完成后才能继续下一个阶段。

### 2.2.2 内存管理与溢写

在MapReduce过程中,中间键值对需要存储在内存中,如果内存不足以存储所有的键值对,就会发生溢写到磁盘。对于大文件处理来说,内存溢写是一个常见问题,它会影响处理性能,因为磁盘I/O速度远慢于内存访问速度。

## 2.3 性能优化理论

### 2.3.1 优化的目标和方法

优化的目标通常是减少处理时间,提高系统吞吐量和资源利用率。可以通过多种方法实现,例如数据预处理、合理设置MapReduce任务并行度、优化Map和Reduce函数等。

### 2.3.2 MapReduce性能评估指标

评估MapReduce性能的指标包括处理速度、资源利用率、以及吞吐量等。通过这些指标,我们可以衡量优化措施的效果,并进一步进行调整。

在后续章节中,我们将探讨具体的优化策略,包括输入数据预处理、Map和Reduce阶段的优化、任务调度与资源管理等。这些策略能够帮助我们应对大文件处理中的挑战,并提升MapReduce任务的性能。

# 3. 优化策略详解

在大数据处理中,优化策略是提升MapReduce作业效率的关键。本章节将深入探讨MapReduce在处理大文件时可以采用的优化策略,并提供实际的案例分析。

## 3.1 输入数据预处理

### 3.1.1 数据分割与均衡

MapReduce框架默认按照输入文件的块(block)来分配任务,如果数据分布不均匀,会导致某些Map任务处理的数据量远远大于其他任务,造成“数据倾斜”。为了避免这种情况,我们需要在Map任务之前对输入数据进行分割和均衡处理。

数据分割应根据实际业务需求来进行。例如,如果要处理的是日志文件,可以按照日期来分割数据;如果是交易数据,则可以按照交易类型或金额区间来分割。数据的分割可以通过MapReduce程序或者使用如Hive这样的数据仓库工具来完成。

代码示例:使用Hive进行数据分割

```sql

CREATE TABLE log_table (

log_id STRING,

event_time STRING,

user_id STRING,

...

) PARTITIONED BY (date STRING);

-- 将原始数据分割为不同日期的数据文件

INSERT OVERWRITE TABLE log_table PARTITION (date)

SELECT *, date_format(log_time, 'yyyy-MM-dd') AS date

FROM raw_log_table;

```

### 3.1.2 采样与过滤

在处理大规模数据之前,进行数据采样和过滤可以有效减少数据量,从而加快处理速度。数据过滤是根据一定的规则来筛选出需要处理的数据子集。

代码示例:使用Hadoop命令行工具进行数据过滤

```bash

hadoop fs -text /user/input/log_file.log | grep "ERROR" > /user/output

```

0

0