【Python库文件学习之Twitter与深度学习】:深度学习大显身手,文本分类的新境界

发布时间: 2024-10-14 14:04:47 阅读量: 32 订阅数: 22

# 1. Python库文件概述

在Python编程中,库文件扮演着至关重要的角色。它们是一组预先编写的代码模块,可以被重复使用来执行特定的任务。对于数据科学和机器学习项目来说,Python库尤为重要,因为它们提供了强大的工具来处理数据、训练模型以及评估结果。

## Python标准库

Python的标准库提供了广泛的模块,用于文件操作、系统调用、套接字通信等。这些模块对于任何Python开发者都是内置可用的,无需额外安装。

## 第三方库

除了标准库之外,Python社区还提供了大量的第三方库,它们可以通过包管理工具如pip进行安装。这些库通常专注于特定的功能,例如:

- 数据处理:NumPy、Pandas

- 数据可视化:Matplotlib、Seaborn

- 机器学习:scikit-learn、TensorFlow、Keras

## 如何使用库文件

使用Python库文件通常涉及以下几个步骤:

1. **安装库文件**:使用pip安装所需的库,例如 `pip install numpy`。

2. **导入模块**:在Python脚本中导入所需的模块,例如 `import numpy as np`。

3. **使用模块功能**:调用模块中定义的函数和类,例如 `data = np.array([1, 2, 3])`。

通过这些步骤,开发者可以快速地利用现成的代码来加速开发过程,同时提高代码的可读性和可维护性。在接下来的章节中,我们将深入探讨如何利用Python库来获取Twitter数据、进行文本预处理以及实现深度学习模型。

# 2. Twitter数据获取与处理

## 2.1 Twitter API的应用

### 2.1.1 API的配置与认证

在本章节中,我们将介绍如何使用Twitter API进行数据的获取与处理。首先,我们需要对Twitter API进行配置与认证,这是使用Twitter API的前提。

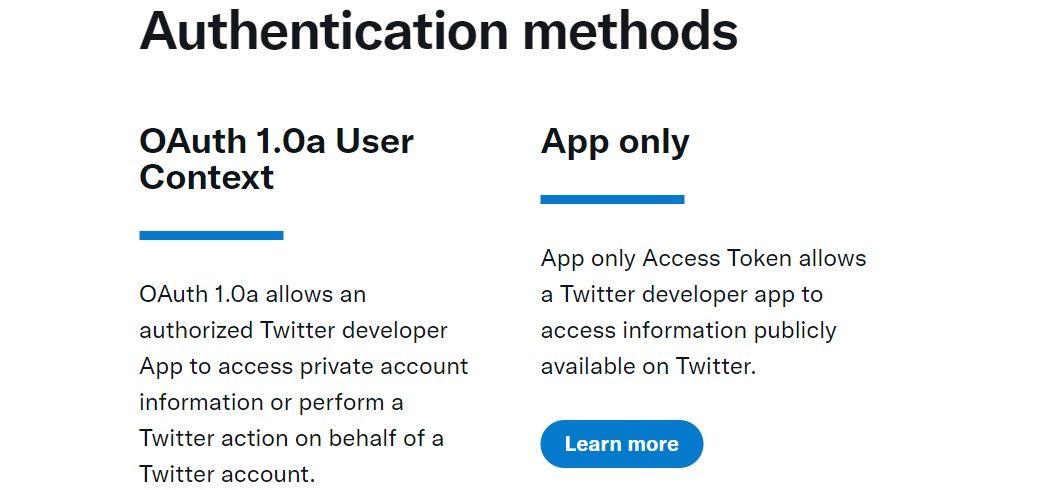

Twitter API的认证需要使用OAuth协议,这是一个行业标准的认证机制,允许用户授权第三方应用访问其信息而无需共享密码。OAuth认证通常需要四个组件:API密钥(API key)、API密钥密文(API secret)、访问令牌(Access token)和访问令牌密文(Access token secret)。

为了完成认证,你需要注册一个Twitter开发者账号并创建一个应用以获取相应的密钥和令牌。以下是使用Python库tweepy进行认证的代码示例:

```python

import tweepy

# 填入你的API密钥和密钥密文

consumer_key = 'YOUR_CONSUMER_KEY'

consumer_secret = 'YOUR_CONSUMER_SECRET'

# 填入你的访问令牌和令牌密文

access_token = 'YOUR_ACCESS_TOKEN'

access_token_secret = 'YOUR_ACCESS_TOKEN_SECRET'

# 进行认证

auth = tweepy.OAuthHandler(consumer_key, consumer_secret)

auth.set_access_token(access_token, access_token_secret)

api = tweepy.API(auth)

# 验证API是否认证成功

try:

api.verify_credentials()

print("Authentication OK")

except:

print("Error during authentication")

```

在这段代码中,我们首先导入tweepy库,然后创建一个OAuthHandler对象,并使用注册应用时获得的API密钥和密钥密文进行初始化。接着,我们使用访问令牌和令牌密文对API进行设置。最后,我们创建一个API对象并尝试验证认证是否成功。

### 2.1.2 数据抓取策略

在完成了API的配置与认证之后,我们可以开始数据的抓取工作。Twitter API提供了多种方式来抓取数据,包括全量数据抓取、用户时间线抓取、搜索API抓取等。

全量数据抓取通常用于抓取一个用户所有的推文,这需要使用到User Timeline API。用户时间线抓取则用于获取指定用户发布推文的时间线。搜索API抓取可以让我们根据关键词、位置、日期等条件来抓取推文。

以下是一个使用User Timeline API抓取指定用户推文的示例代码:

```python

# 获取指定用户的推文

user_timeline = api.user_timeline(screen_name='twitter', count=10)

# 打印推文内容

for tweet in user_timeline:

print(tweet.text)

```

在这个示例中,我们首先调用`user_timeline`方法并传入`screen_name`参数指定要获取推文的用户(在这里是twitter官方账号)。`count`参数用于指定获取的推文数量。然后,我们遍历返回的推文列表并打印出每条推文的文本内容。

通过本章节的介绍,我们了解了如何配置和使用Twitter API,以及如何根据不同的需求选择合适的数据抓取策略。在下一节中,我们将进一步探讨如何进行文本数据的预处理,包括数据清洗与规范化以及特征提取基础。

## 2.2 文本数据预处理

### 2.2.1 数据清洗与规范化

文本数据的清洗与规范化是文本分析中的重要步骤,它能够帮助我们提高分析的准确性和效率。数据清洗通常包括去除噪声、纠正错误、标准化文本等操作。而规范化则涉及到文本的标准化处理,如转换大小写、移除停用词等。

在Python中,我们可以使用正则表达式(Regular Expressions)来处理文本中的噪声和错误。例如,以下是一个简单的代码示例,展示了如何使用Python的`re`模块来移除文本中的特殊字符:

```python

import re

# 原始文本字符串

text = "Hello! This is an example #text# with $special% characters*."

# 使用正则表达式移除非字母和数字字符

clean_text = re.sub(r"[^a-zA-Z0-9\s]", "", text)

print(clean_text)

```

在这个代码示例中,我们首先导入了`re`模块。然后定义了一个包含特殊字符的原始文本字符串。使用`re.sub()`函数,我们定义了一个正则表达式`[^a-zA-Z0-9\s]`来匹配所有非字母、非数字和非空格的字符,并将这些字符替换为空字符串,从而得到一个清洗后的文本。

除了正则表达式,我们还可以使用自然语言处理库NLTK来帮助我们进行文本的规范化。例如,以下代码展示了如何使用NLTK库移除停用词:

```python

import nltk

from nltk.corpus import stopwords

# 下载停用词集

nltk.download('stopwords')

# 定义英文停用词

stop_words = set(stopwords.words('english'))

# 示例文本

text = "This is a sample sentence, removing stopwords from similar text can be done easily."

# 分词

words = text.split()

# 移除停用词

filtered_words = [word for word in words if word.lower() not in stop_words]

# 重新组合为字符串

cleaned_text = " ".join(filtered_words)

print(cleaned_text)

```

在这段代码中,我们首先导入了`nltk`库和`stopwords`模块。我们从`nltk.corpus`导入了英文停用词集,并将其转换为一个集合。然后,我们将示例文本分词,并移除其中的停用词。最后,我们将过滤后的单词重新组合成一个字符串并打印出来。

### 2.2.2 特征提取基础

在完成了文本的清洗与规范化之后,我们需要进行特征提取,将文本转换为模型能够处理的数值形式。常见的文本特征提取方法包括词袋模型(Bag of Words)、TF-IDF(Term Frequency-Inverse Document Frequency)以及词嵌入(Word Embeddings)。

词袋模型是最简单的一种特征提取方法,它忽略了文本中单词的顺序,只是将文本转换为单词出现频率的向量。以下是一个使用Python的`sklearn`库来实现词袋模型的示例代码:

```python

from sklearn.feature_extraction.text import CountVectorizer

# 示例文本

texts = [

"This is the first document.",

"This document is the second document.",

"And this is the third one.",

"Is this the first document?"

]

# 创建CountVectorizer对象

vectorizer = CountVectorizer()

# 将文本转换为词频向量

X = vectorizer.fit_transform(texts)

# 打印词频矩阵

print(X.toarray())

# 打印词汇表

print(vectorizer.get_feature_names_out())

```

在这个代码示例中,我们首先导入了`CountVectorizer`类,然后定义了一个示例文本列表。我们创建了一个`CountVectorizer`对象,并使用`fit_transform`方法将文本转换为词频矩阵。最后,我们打印出了词频矩阵和词汇表。

TF-IDF是另一种常用的特征提取方法,它不仅考虑了单词的频率,还考虑了单词在整个文档集合中的分布情况。以下是一个使用`sklearn`库来实现TF-IDF的示例代码:

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例文本

texts = [

"This is the first document.",

"This document is the second document.",

"And this is the third one.",

"Is this the first document?"

]

# 创建TfidfVectorizer对象

vectorizer = TfidfVectorizer()

# 将文本转换为TF-IDF矩阵

X = vectorizer.fit_transform(texts)

```

0

0