【Python库文件学习之Twitter高级】:构建高级Twitter爬虫,揭秘数据抓取与分析的策略

发布时间: 2024-10-14 13:25:30 阅读量: 2 订阅数: 3

# 1. Twitter高级API的理解和应用

## 1.1 Twitter API概述

Twitter提供了一系列的API,允许开发者访问和操作Twitter平台上的数据。高级API,如v2版本,提供了更丰富的接口和更高的数据抓取限额,为数据分析和数据挖掘提供了强有力的支持。

## 1.2 API的权限和认证

理解API的权限等级和认证机制是使用高级API的第一步。开发者需要通过OAuth 2.0协议进行身份验证,获取必要的访问令牌,以确保数据的合法抓取。

## 1.3 高级API的特点和优势

高级API支持更多的参数设置,能够获取更深层次的数据,如用户详情、推文元数据等。此外,高级API还提供了对数据速率的控制,有助于避免过快请求而导致的封禁风险。

```python

# 示例代码:使用Tweepy库进行OAuth认证

import tweepy

# 从环境变量读取API密钥和访问令牌

consumer_key = "YOUR_CONSUMER_KEY"

consumer_secret = "YOUR_CONSUMER_SECRET"

access_token = "YOUR_ACCESS_TOKEN"

access_token_secret = "YOUR_ACCESS_TOKEN_SECRET"

# OAuth认证流程

auth = tweepy.OAuthHandler(consumer_key, consumer_secret)

auth.set_access_token(access_token, access_token_secret)

# 创建API对象

api = tweepy.API(auth)

```

通过上述代码,我们可以创建一个Tweepy API对象,用于执行后续的Twitter数据抓取和分析任务。

# 2. 构建Twitter爬虫的基本流程

## 2.1 环境准备和基础设置

### 2.1.1 Python环境的搭建

在开始构建Twitter爬虫之前,首先需要确保你的Python环境已经搭建好。Python是一个广泛使用的高级编程语言,它拥有大量的库和框架,非常适合进行数据抓取和分析。

#### 选择合适的Python版本

Python有多个版本,包括Python 2.x和Python 3.x。目前Python 2.x已经停止维护,而Python 3.x是目前的主流版本。因此,你应该选择安装Python 3.x。如果你是初学者,建议安装Python 3.8或更高版本。

#### 安装Python

访问Python官网 [***](*** 下载适合你操作系统的Python安装包。安装过程中,请确保勾选了"Add Python to PATH"选项,这样可以让你在命令行中直接使用Python命令。

#### 验证Python环境

安装完成后,打开命令行工具,输入以下命令来验证Python是否安装成功:

```bash

python --version

```

如果安装成功,你将看到Python的版本号。

#### 安装Python虚拟环境

为了更好地管理项目的依赖,建议使用Python虚拟环境。可以使用`virtualenv`来创建一个独立的Python环境:

```bash

pip install virtualenv

```

创建一个新的虚拟环境:

```bash

virtualenv venv

```

激活虚拟环境:

```bash

# Windows

venv\Scripts\activate

# macOS/Linux

source venv/bin/activate

```

### 2.1.2 Tweepy库的基本使用

Tweepy是Python的一个第三方库,它为访问Twitter API提供了一个简单且强大接口。要使用Tweepy,首先需要安装它:

```bash

pip install tweepy

```

#### 注册Twitter开发者账号

在使用Tweepy之前,你需要有一个Twitter开发者账号,并创建一个应用,以获取必要的API密钥和令牌。访问Twitter开发者平台 [***](***,按照指引完成注册和应用的创建。

#### 获取API密钥

创建应用后,你会得到四个重要的密钥和令牌:API key、API secret key、Access token和Access token secret。将这些信息保存好,因为你将在编写代码时使用它们。

#### 使用Tweepy连接Twitter API

以下是一个简单的Tweepy使用示例,用于连接Twitter API并打印登录用户的名称:

```python

import tweepy

# 填入你的API密钥和令牌

consumer_key = 'your-api-key'

consumer_secret = 'your-api-secret-key'

access_token = 'your-access-token'

access_token_secret = 'your-access-token-secret'

# 认证授权

auth = tweepy.OAuthHandler(consumer_key, consumer_secret)

auth.set_access_token(access_token, access_token_secret)

# 创建API对象

api = tweepy.API(auth)

# 获取并打印登录用户的名称

user = api.me()

print(f'Logged in as @{user.screen_name}')

```

运行上述代码,如果一切顺利,你将看到打印出来的用户名。这表明你已经成功地使用Tweepy连接到了Twitter API。

在本章节中,我们介绍了如何搭建Python环境,并安装了Tweepy库以及如何使用它来连接Twitter API。这是构建Twitter爬虫的第一步。接下来,我们将进一步探讨如何使用API获取数据,并进行数据清洗和预处理。

# 3. Twitter数据的高级分析

#### 3.1 文本数据的处理和分析

在本章节中,我们将深入探讨如何对Twitter文本数据进行预处理和分析。文本数据的处理和分析是社交媒体分析中至关重要的一步,因为它直接影响到后续的数据挖掘和模式识别的质量和效果。

##### 3.1.1 文本数据的预处理

文本预处理是任何文本分析任务的第一步,它的目的是将原始文本转换为适合分析的格式。这通常包括以下几个步骤:

1. **分词(Tokenization)**:将文本分割成单词或短语,例如将句子"Twitter 数据分析真有趣"分割成["Twitter", "数据分析", "真有趣"]。

2. **去除停用词(Stop Words Removal)**:删除在文本中频繁出现但对分析帮助不大的词,如"的"、"是"、"在"等。

3. **词干提取(Stemming)/词形还原(Lemmatization)**:将单词转换为其基本形式,例如将"running"转换为"run"。

4. **词性标注(Part-of-Speech Tagging)**:识别每个单词的词性,如名词、动词等。

5. **实体识别(Named Entity Recognition)**:识别文本中的专有名词、地点、组织等实体。

```python

import nltk

from nltk.tokenize import word_tokenize

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

# 示例代码:文本分词和词干提取

nltk.download('punkt')

nltk.download('stopwords')

nltk.download('wordnet')

text = "Twitter 数据分析真有趣"

tokens = word_tokenize(text)

stop_words = set(stopwords.words('english'))

lemmatizer = WordNetLemmatizer()

# 分词

words = [word for word in tokens if word.isalpha()]

# 去除停用词

filtered_words = [word for word in words if word.lower() not in stop_words]

# 词干提取

stems = [lemmatizer.lemmatize(word) for word in filtered_words]

print(stems)

```

#### 3.1.2 文本分析的基本方法

文本分析的基本方法包括但不限于以下几种:

1. **词频统计(Term Frequency)**:计算每个单词在文本中的出现频率。

2. **TF-IDF(Term Frequency-Inverse Document Frequency)**:评估单词对于一个语料库中的其中一份文件的重要程度。

3. **情感分析(Sentiment Analysis)**:确定文本的情感倾向,如积极、消极或中立。

4. **主题建模(Topic Modeling)**:从大量文本中发现主题,例如使用LDA(Latent Dirichlet Allocation)算法。

```python

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import classification_report

# 示例代码:TF-IDF和情感分析

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(["Twitter 数据分析真有趣", "这是一句非常无聊的句子"])

y = [1, 0] # 假设第一句情感积极,第二句情感消极

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 使用逻辑回归进行情感分类

model = LogisticRegression()

model.fit(X_train, y_train)

predictions = model.predict(X_test)

print(classification_report(y_test, predictions))

```

#### 3.2 用户行为的数据分析

用户行为数据分析是了解社交媒体用户互动方式的重要手段。通过分析用户行为数据,我们可以获得用户活动的模式、偏好和趋势。

##### 3.2.1 用户行为的数据抓取

用户行为数据通常包括用户的点赞、转发、回复和关注等行为。这些数据可以通过Twitter API获取,并用于分析用户的互动模式。

```python

# 示例代码:使用Tweepy库抓取用户行为数据

import tweepy

# 假设已经设置好Twitter API的认证信息

auth = tweepy.OAuthHandler(CONSUMER_KEY, CONSUMER_SECRET)

auth.set_access_token(ACCESS_TOKEN, ACCESS_TOKEN_SECRET)

api = tweepy.API(auth)

# 获取用户最近的推文

user = api.get_user(screen_name="Twitter")

latest_tweets = user.statuses_count

print(f"{user.name} 最近发布了 {latest_tweets} 条推文。")

```

##### 3.2.2 用户行为的分析方法

用户行为数据的分析方法包括:

1. **网络分析(Network Analysis)**:分析用户之间的关注关系,构建社交网络图。

2. **行为聚类(Behavioral Clustering)**:将用户根据行为模式进行分组。

3. **影响力分析(Influence Analysis)**:识别影响者和他们的影响力范围。

```python

import networkx as nx

import matplotlib.pyplot as plt

# 示例代码:社交网络图的构建和绘制

G = nx.Graph()

users = api.get_followers(screen_name="Twitter")

for user in users:

G.add_node(user.screen_name)

for friend in user.following:

G.add_edge(user.screen_name, friend.screen_name)

nx.draw(G, with_labels=True)

plt.show()

```

#### 3.3 社交网络的分析

社交网络分析可以帮助我们了解社交媒体中的关系和交互模式,这对于揭示社交结构和影响力传播至关重要。

##### 3.3.1 社交网络的构建

社交网络可以通过节点和边的集合来表示,节点代表用户,边代表用户之间的关系。

##### 3.3.2 社交网络的分析方法

社交网络分析的方法包括:

1. **中心性分析(Centrality Analysis)**:识别网络中的关键节点,如中心度、中介中心性等。

2. **社区检测(Community Detection)**:将网络中的节点分组到不同的社区中。

3. **连通性分析(Connectivity Analysis)**:分析网络的连通性,如强连通分量、弱连通分量等。

```python

# 示例代码:社交网络中心性分析

centrality = nx.degree_centrality(G)

print(centrality)

```

通过本章节的介绍,我们了解了文本数据的预处理和分析方法,用户行为数据的抓取和分析方法,以及社交网络的构建和分析方法。这些高级分析技术对于深入挖掘Twitter数据具有重要意义,它们为我们提供了从数据中提取有价值信息的工具和途径。在接下来的章节中,我们将进一步探讨如何使用Python库在Twitter数据抓取和分析中实现高级应用和实践。

# 4. Python库在Twitter数据抓取和分析中的高级应用

## 4.1 Python库的高级功能和技巧

### 4.1.1 使用Pandas进行数据处理

在本章节中,我们将深入了解如何使用Pandas这一强大的数据处理库来处理Twitter数据。Pandas是一个开源的Python数据分析库,提供了高性能、易用的数据结构和数据分析工具。它非常适合处理结构化数据,特别是在数据分析、数据清洗、数据转换等方面有着广泛的应用。

#### 概述Pandas库

Pandas库主要提供了两种数据结构:`Series`和`DataFrame`。`Series`是一个一维标签化数组,可以存储任何数据类型(整数、字符串、浮点数、Python对象等),并提供了丰富的功能来操作这些数据。`DataFrame`是一个二维标签化数据结构,可以看作是一个表格或是一个Excel工作表的结构化表现形式。

#### 数据清洗示例

在处理Twitter数据时,我们经常会遇到一些不完整或不规范的数据。使用Pandas进行数据清洗的步骤通常包括:

1. **导入数据**:使用`pd.read_csv()`或`pd.read_json()`函数导入数据。

2. **缺失值处理**:使用`dropna()`或`fillna()`函数处理缺失值。

3. **数据类型转换**:使用`astype()`函数转换数据类型。

4. **重复值处理**:使用`drop_duplicates()`函数删除重复行。

5. **数据标准化**:使用`apply()`函数配合自定义函数进行数据标准化。

```python

import pandas as pd

# 示例代码:导入数据并进行初步清洗

df = pd.read_json('twitter_data.json') # 假设数据存储在名为'twitter_data.json'的文件中

# 处理缺失值

df = df.dropna(subset=['text', 'user']) # 删除text和user列中含有缺失值的行

# 数据类型转换

df['created_at'] = pd.to_datetime(df['created_at']) # 将created_at列转换为datetime类型

# 删除重复值

df = df.drop_duplicates()

# 数据标准化示例:转换文本为小写

df['text'] = df['text'].str.lower()

```

#### 逻辑分析和参数说明

在上述代码中,我们首先导入了必要的Pandas库,并从一个JSON文件中读取Twitter数据。接着,我们对数据进行了初步的清洗,包括删除含有缺失值的行、将时间戳转换为datetime类型以及删除重复的数据行。最后,我们将所有的文本数据转换为小写,以便于后续的文本分析。

### 4.1.2 使用Scikit-learn进行机器学习

Scikit-learn是Python中一个非常流行的机器学习库,它提供了许多简单而高效的工具进行数据挖掘和数据分析。Scikit-learn支持多种机器学习模型,包括分类、回归、聚类等,并且具有良好的文档和用户友好性。

#### 概述Scikit-learn库

Scikit-learn库主要提供了以下几种机器学习算法的实现:

- **分类**:包括支持向量机、随机森林、朴素贝叶斯等。

- **回归**:包括线性回归、岭回归、Lasso回归等。

- **聚类**:包括K均值聚类、层次聚类、DBSCAN等。

- **降维**:包括PCA、LDA、t-SNE等。

- **模型选择**:包括交叉验证、网格搜索等。

#### 机器学习示例

在处理Twitter数据时,我们可能会对用户的文本信息进行情感分析,以了解公众对某个话题的情绪倾向。使用Scikit-learn进行情感分析的基本步骤如下:

1. **导入库和数据**:使用Pandas导入数据,并将文本数据转化为数值特征。

2. **分词和向量化**:使用`CountVectorizer`或`TfidfVectorizer`进行文本的分词和向量化。

3. **模型训练**:选择一个分类模型(如朴素贝叶斯、随机森林等)并进行训练。

4. **模型评估**:使用交叉验证或测试集评估模型的性能。

```python

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 示例代码:进行简单的文本分类

# 假设我们有一组文本数据和对应的标签

texts = df['text'].values

labels = df['sentiment'].values # sentiment列包含情感标签

# 分词和向量化

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(texts)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, labels, test_size=0.2)

# 使用朴素贝叶斯分类器

clf = MultinomialNB()

clf.fit(X_train, y_train)

# 预测和评估

y_pred = clf.predict(X_test)

print('Accuracy:', accuracy_score(y_test, y_pred))

```

#### 逻辑分析和参数说明

在上述代码中,我们首先导入了必要的Scikit-learn库,并使用`CountVectorizer`对文本数据进行了分词和向量化处理。然后,我们划分了训练集和测试集,并使用朴素贝叶斯分类器进行模型训练和预测。最后,我们计算了模型的准确率来评估其性能。

### 4.1.3 项目背景和需求分析

在进行实际的项目分析之前,我们需要对项目背景进行充分的了解,并明确项目的需求。这一步骤对于确保项目的成功至关重要。在本节中,我们将探讨如何进行项目背景和需求分析。

#### 项目背景分析

项目背景分析主要包括以下几个方面:

1. **业务背景**:了解业务的背景和目标,以及为什么需要进行数据抓取和分析。

2. **数据来源**:确定数据来源,包括Twitter API等。

3. **数据类型**:了解将要处理的数据类型,如文本、用户信息、时间戳等。

#### 项目需求分析

项目需求分析主要包括以下几个方面:

1. **功能需求**:明确项目需要实现的功能,如数据抓取、数据分析、数据可视化等。

2. **性能需求**:确定项目的性能要求,包括处理速度、准确率、可扩展性等。

3. **用户需求**:了解用户的具体需求,包括用户界面、交互设计等。

### 4.1.4 项目实施和效果评估

在项目背景和需求分析之后,我们将进入到项目的实施阶段。在本节中,我们将探讨如何实施项目,并对项目的效果进行评估。

#### 项目实施步骤

1. **设计**:根据需求分析设计项目架构和实现方案。

2. **编码**:根据设计方案进行编码实现。

3. **测试**:对项目进行测试,确保其按照预期工作。

4. **部署**:将项目部署到生产环境。

#### 项目效果评估

项目效果评估通常包括以下几个方面:

1. **性能评估**:评估项目的性能指标,如处理速度、准确率等。

2. **用户反馈**:收集用户的反馈,了解项目的实际效果。

3. **持续优化**:根据评估结果进行项目的持续优化。

通过本章节的介绍,我们深入了解了如何使用Python的高级库——Pandas和Scikit-learn来处理和分析Twitter数据。我们首先介绍了Pandas库在数据清洗中的应用,然后探讨了如何使用Scikit-learn进行简单的文本分类。此外,我们还讨论了项目实施过程中的背景和需求分析,以及如何对项目效果进行评估。在下一节中,我们将通过具体的实践案例来进一步展示这些技术的实际应用。

# 5. Python库在Twitter数据抓取和分析中的高级实践

在本章节中,我们将深入探讨如何将Python库应用于Twitter数据抓取和分析的高级实践中。我们将从实践项目的设计和实施开始,然后讨论项目的优化和改进策略。

## 5.1 实践项目的设计和实施

### 5.1.1 项目的设计思路和方法

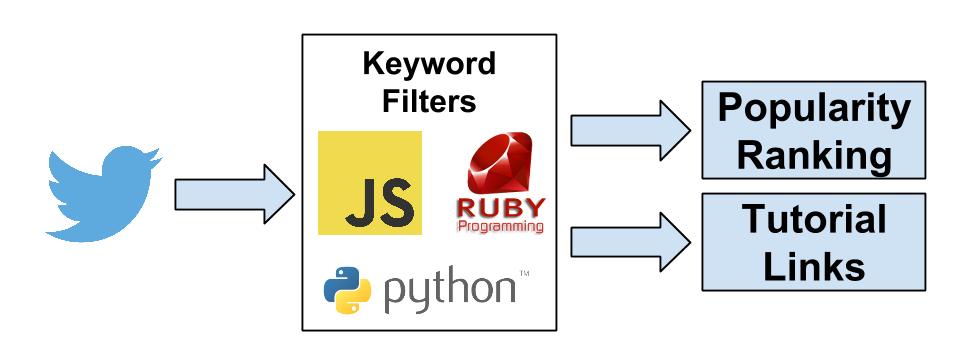

设计一个实践项目需要明确的目标和详细的规划。在设计Twitter数据抓取和分析项目时,首先要确定分析的目标,比如分析某个话题的流行趋势、评估品牌影响力或者研究用户行为模式。确定目标后,需要规划数据抓取策略,包括选择合适的API端点、设置抓取频率和时间等。此外,还需要规划数据分析的方法,如文本分析、情感分析、用户行为分析等。

### 5.1.2 项目的实施过程和问题解决

在实施过程中,需要编写脚本来与Twitter API交互,抓取数据,并对数据进行存储和处理。在本章节中,我们将通过一个具体的例子来展示如何使用Python库来实现这些步骤。

#### *.*.*.* Python库的选择和使用

为了实现Twitter数据的高级抓取和分析,我们通常会使用如下几个Python库:

- **Tweepy**: 用于与Twitter API交互。

- **Pandas**: 用于数据处理和分析。

- **Scikit-learn**: 用于机器学习和文本分析。

以下是使用这些库的基本代码示例:

```python

import tweepy

import pandas as pd

from sklearn.feature_extraction.text import CountVectorizer

from tweepy import OAuthHandler

# 设置Twitter API认证信息

auth = OAuthHandler("CONSUMER_KEY", "CONSUMER_SECRET")

auth.set_access_token("ACCESS_TOKEN", "ACCESS_TOKEN_SECRET")

# 创建API对象

api = tweepy.API(auth, wait_on_rate_limit=True)

# 抓取推文数据

tweets = [t.text for t in tweepy.Cursor(api.search_tweets, q="Python", lang="en").items(100)]

# 使用Pandas处理数据

df = pd.DataFrame(tweets, columns=['Tweet'])

# 文本分析准备

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(df['Tweet'])

# 这里只是简单的代码展示,实际项目中需要更复杂的逻辑。

```

#### *.*.*.* 数据抓取和存储

在抓取数据时,我们需要注意遵守Twitter API的限制,例如请求频率限制。数据抓取后,通常需要存储到CSV或数据库中以便于后续分析。

#### *.*.*.* 数据分析和处理

数据分析可以包括文本分析、情感分析等。以下是一个简单的文本分析示例:

```python

from sklearn.feature_extraction.text import TfidfTransformer

from sklearn.pipeline import make_pipeline

# 创建文本处理和TF-IDF模型的管道

text_clf = make_pipeline(CountVectorizer(), TfidfTransformer())

# 对数据集进行拟合和变换

X = text_clf.fit_transform(df['Tweet'])

# 这里只是简单的代码展示,实际项目中需要更复杂的逻辑。

```

### *.*.*.* 解决实际问题

在实际项目中,可能会遇到各种问题,如API限制、数据质量问题等。解决这些问题需要对Twitter API和Python库有深入的理解,并且具备一定的调试和优化能力。

## 5.2 实践项目的优化和改进

### 5.2.1 项目的性能优化

性能优化可以从多个方面进行,比如优化数据抓取策略、使用更高效的数据结构、并行化数据处理等。

### 5.2.2 项目的功能改进和扩展

功能改进可以包括增加用户交互界面、提供实时分析能力、集成更多的分析工具等。

#### *.*.*.* 性能优化示例

以下是一个简单的性能优化示例,通过使用Python多线程来加速数据抓取:

```python

import threading

def fetch_tweets(api, query, max_tweets):

tweets = []

for t in tweepy.Cursor(api.search_tweets, q=query, lang="en").items(max_tweets):

tweets.append(t.text)

if len(tweets) >= max_tweets:

break

return tweets

# 创建API对象

api = tweepy.API(auth, wait_on_rate_limit=True)

# 定义要抓取的推文数量

max_tweets = 100

# 创建线程

threads = []

for i in range(2):

t = threading.Thread(target=fetch_tweets, args=(api, "Python", max_tweets))

threads.append(t)

t.start()

# 等待所有线程完成

for t in threads:

t.join()

# 合并结果

tweets = sum([thread.result() for thread in threads], [])

# 这里只是简单的代码展示,实际项目中需要更复杂的逻辑。

```

#### *.*.*.* 功能改进示例

功能改进可以包括集成图形用户界面(GUI)来增强用户体验。以下是一个使用Tkinter创建简单GUI的示例:

```python

import tkinter as tk

from tkinter import scrolledtext

def fetch_tweets(api, query, max_tweets):

# ... 省略之前的fetch_tweets函数代码 ...

# 创建主窗口

root = tk.Tk()

root.title("Twitter Data Fetcher")

# 创建文本区域

text_area = scrolledtext.ScrolledText(root, height=20, width=60)

text_area.pack()

# 创建按钮

fetch_button = tk.Button(root, text="Fetch Tweets", command=lambda: fetch_tweets(api, "Python", 100))

fetch_button.pack()

# 运行主循环

root.mainloop()

# 这里只是简单的代码展示,实际项目中需要更复杂的逻辑。

```

### 5.2.3 项目总结

在本章节中,我们详细探讨了如何设计和实施一个Twitter数据抓取和分析的实践项目。我们介绍了项目的设计思路和方法、实施过程中的问题解决以及如何进行性能优化和功能改进。通过实际的代码示例,我们展示了如何使用Python库来实现这些功能。

### 5.2.4 项目展望

未来,随着机器学习和人工智能技术的发展,我们可以期待在Twitter数据抓取和分析中实现更多的自动化和智能化。例如,使用深度学习模型来进行情感分析、主题建模等。此外,随着大数据技术的进步,我们可以处理更大规模的数据集,并从中提取更深层次的洞察。

# 6. 未来的发展和挑战

## 6.1 Twitter数据抓取和分析的未来趋势

随着社交媒体数据量的爆炸性增长,Twitter数据抓取和分析的技术也在不断进步。未来的发展趋势可能会集中在以下几个方面:

### 6.1.1 大数据技术的融合

大数据处理技术如Apache Spark、Hadoop等将越来越多地应用于Twitter数据的抓取和分析中。这些技术能够处理海量数据,并提供实时分析能力,对于理解用户行为和社交网络动态至关重要。

### 6.1.2 机器学习和人工智能的应用

机器学习和人工智能技术将被广泛应用于文本分析、用户行为预测和社交网络分析。例如,通过自然语言处理(NLP)技术,我们可以更准确地分析用户的情感倾向,预测流行趋势。

### 6.1.3 云计算和边缘计算的结合

云计算提供了强大的数据存储和计算能力,而边缘计算则使得数据处理更加贴近数据源,减少了延迟,提高了实时性。结合两者,可以实现更高效、更灵活的数据抓取和分析流程。

### 6.1.4 数据隐私和合规性的挑战

随着全球对数据隐私和合规性的关注增加,未来的Twitter数据抓取和分析必须严格遵守相关法律法规,如欧盟的GDPR。这要求开发者在设计系统时就要考虑隐私保护和数据加密问题。

## 6.2 面临的挑战和应对策略

### 6.2.1 数据抓取的限制

Twitter对API的使用有一定的限制,例如请求频率限制、API使用频率限制等。开发者需要了解这些限制,并设计出能够适应这些限制的抓取策略。

### 6.2.2 数据质量和准确性

数据抓取过程中可能会遇到数据不完整、错误或偏差的问题。应对策略包括使用多个API端点交叉验证数据,以及实施数据清洗和预处理步骤来提高数据质量。

### 6.2.3 分析模型的复杂性

随着分析需求的增加,模型变得越来越复杂。这需要开发人员具备更深入的统计学和机器学习知识,同时也需要更强大的计算资源支持。

### 6.2.4 法律和伦理挑战

社交媒体数据的抓取和分析可能涉及到法律和伦理问题,例如未经用户同意抓取和使用数据。应对策略包括明确告知用户数据使用目的、获取用户同意,并确保数据的安全存储和使用。

### 6.2.5 持续学习和技术创新

技术不断进步,开发者需要持续学习最新的技术和工具,以适应快速变化的环境。同时,创新也是推动行业发展的关键,开发者应积极探索新的方法和技术,以提高数据抓取和分析的效率和准确性。

0

0