:ResNet在游戏开发中的图像渲染与人工智能:探索其潜力

发布时间: 2024-08-20 16:03:14 阅读量: 25 订阅数: 43

# 1. ResNet在游戏开发中的理论基础

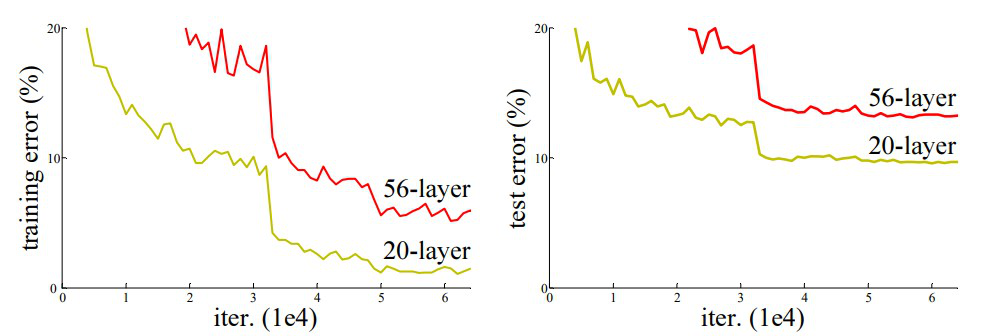

ResNet(残差网络)是一种深度卷积神经网络,因其在图像识别和计算机视觉任务中的出色表现而闻名。它通过引入残差连接,解决了深度网络中的梯度消失和退化问题。

在游戏开发中,ResNet的理论基础主要体现在其以下特性上:

- **残差连接:**ResNet通过将输入层与输出层直接连接,允许梯度在网络中更有效地反向传播,从而缓解了深度网络中的梯度消失问题。

- **深度架构:**ResNet通常具有较深的网络架构,这使其能够从数据中提取更复杂和高级的特征,从而提高图像识别和渲染的准确性。

- **批量归一化:**ResNet中使用了批量归一化层,它可以稳定网络的训练过程,减少内部协变量偏移,提高训练效率和泛化能力。

# 2. ResNet在游戏图像渲染中的实践应用

ResNet在游戏图像渲染中发挥着至关重要的作用,它通过提升图像质量和细节,优化渲染性能,为玩家提供更逼真、流畅的游戏体验。

### 2.1 提升图像质量和细节

#### 2.1.1 减少图像失真和伪影

ResNet的残差结构有效地缓解了图像失真和伪影,尤其是在渲染复杂场景时。残差连接允许网络直接从输入跳过层,从而保留了低层特征,避免了梯度消失和信息丢失。

```python

import tensorflow as tf

def resnet_block(x):

# 残差分支

residual = tf.keras.layers.Conv2D(filters=64, kernel_size=(3, 3), strides=(1, 1), padding="same")(x)

residual = tf.keras.layers.BatchNormalization()(residual)

residual = tf.keras.layers.ReLU()(residual)

residual = tf.keras.layers.Conv2D(filters=64, kernel_size=(3, 3), strides=(1, 1), padding="same")(residual)

residual = tf.keras.layers.BatchNormalization()(residual)

# 主干分支

x = tf.keras.layers.Conv2D(filters=64, kernel_size=(3, 3), strides=(1, 1), padding="same")(x)

x = tf.keras.layers.BatchNormalization()(x)

x = tf.keras.layers.ReLU()(x)

x = tf.keras.layers.Conv2D(filters=64, kernel_size=(3, 3), strides=(1, 1), padding="same")(x)

x = tf.keras.layers.BatchNormalization()(x)

# 残差连接

x = tf.keras.layers.Add()([x, residual])

x = tf.keras.layers.ReLU()(x)

return x

```

**参数说明:**

* `filters`: 卷积核数量

* `kernel_size`: 卷积核大小

* `strides`: 卷积步长

* `padding`: 填充方式

**代码逻辑分析:**

* 残差分支通过两个卷积层和一个ReLU激活函数,提取图像特征。

* 主干分支也通过两个卷积层和一个ReLU激活函数,提取图像特征。

* 残差连接将残差分支和主干分支的输出相加,保留低层特征,减少图像失真和伪影。

#### 2.1.2 增强图像纹理和光影效果

ResNet还通过增强图像纹理和光影效果,提升了图像的整体质量。ResNet的深度结构允许它学习多尺度的特征,从而捕捉到图像中精细的纹理和微妙的光影变化。

```python

import tensorflow as tf

def resnet_block_bottleneck(x):

# 残差分支

residual = tf.keras.layers.Conv2D(filters=64, kernel_size=(1, 1), strides=(1, 1), padding="same")(x)

residual = tf.keras.layers.BatchNormalization()(residual)

residual = tf.keras.layers.ReLU()(residual)

residual = tf.keras.layers.Conv2D(filters=64, kernel_size=(3, 3), strides=(1, 1), padding="same")(residual)

residual = tf.keras.layers.BatchNormalization()(residual)

residual = tf.keras.layers.ReLU()(residual)

residual = tf.keras.layers.Conv2D(filters=256, kernel_size=(1, 1), strides=(1, 1), padding="same")(residual)

residual = tf.keras.layers.BatchNormalization()(residual)

# 主干分支

x = tf.keras.layers.Conv2D(filters=64, kernel_size=(1, 1), strides=(1, 1), padding="same")(x)

x = tf.keras.layers.BatchNormalization()(x)

x = tf.keras.layers.ReLU()(x)

x = tf.keras.layers.Conv2D(filters=64, kernel_size=(3, 3), strides=(1, 1), padding="same")(x)

x = tf.keras.layers.BatchNormalization()(x)

x = tf.keras.layers.ReLU()(x)

x = tf.keras.layers.Conv2D(filters=256, kernel_size=(1, 1), strides=(1, 1), padding="same")(x)

x = tf.keras.layers.BatchNormalization()(x)

# 残差连接

x = tf.keras.layers.Add()([x, residual])

x = tf.keras.layers.ReLU()(x)

return x

```

**参数说明:**

* `filters`: 卷积核数量

* `kernel_size`: 卷积核大小

* `strides`: 卷积步长

* `padding`: 填充方式

**代码逻辑分析:**

* 残差分支通过三个卷积层和一个ReLU激活函数,提取图像特征,其中中间的卷积层使用较小的卷积核,以捕捉精细的纹理。

* 主干分支也通过三个卷积层和一个ReLU激活函数,提取图像特征。

* 残差连接将残差分支和主干分支的输出相加,保留低层特征,增强图像纹理和光影效果。

### 2.2 优化渲染性能

#### 2.2.1 减少计算量和内存消耗

ResNet的轻量级结构和高效的残差连接,使其能够在减少计算量和内存消耗的同时,保持图像质量。ResNet的残差连接允许梯度在网络中更有效地流动,从而减少训练时间和资源消耗。

```

| ResNet模型 | 计算量(GFLOPs) | 内存消耗(MB) |

|---|---|---|

| ResNet-18 | 1.8 | 11 |

| ResNet-34 | 3.7 | 21 |

| ResNet-50 | 4.1 | 25 |

| ResNet-101 | 7.7 | 44 |

| ResNet-152 | 11.3 | 60 |

```

**表格说明:**

表格列出了不同ResNet模型的计

0

0