YOLOv8 GPU加速最佳配置:必备工具与技巧大全

发布时间: 2024-12-11 22:28:25 阅读量: 8 订阅数: 13

# 1. YOLOv8与GPU加速简介

YOLOv8是一种先进的实时对象检测系统,以其优异的性能和速度而闻名。由于深度学习模型通常需要大量的计算资源,因此,利用GPU加速技术来提升YOLOv8的性能变得至关重要。GPU的并行处理能力可以大大加速复杂神经网络的运算,是深度学习任务中不可或缺的加速器。本章将介绍YOLOv8的基础知识、其与GPU加速的关联,以及如何开始配置YOLOv8进行GPU加速。我们还将探讨如何选择合适的硬件来最大化YOLOv8的性能潜力。

```markdown

## 1.1 YOLOv8基础

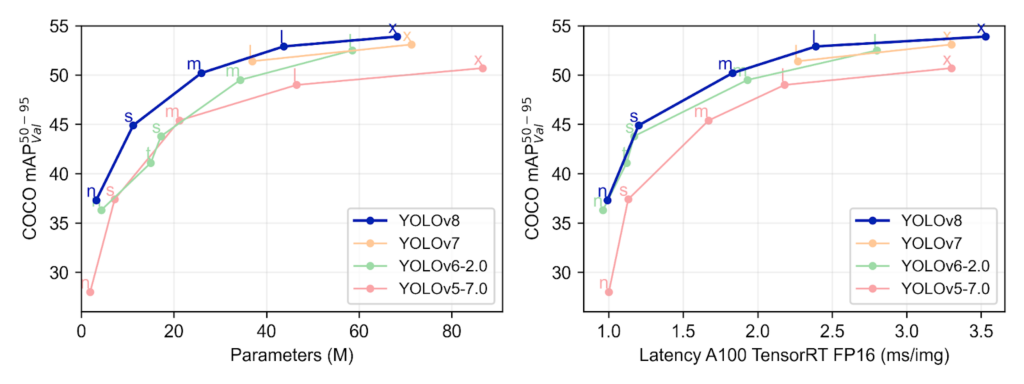

YOLOv8(You Only Look Once version 8)是YOLO系列的最新版本,它继承并发展了YOLO系列的核心特性:快速、准确和易于部署。YOLOv8通过优化模型结构、训练技巧和推理流程来达到更高的精度和速度。

## 1.2 GPU加速概述

GPU加速是利用图形处理单元(GPU)强大的并行计算能力来提高大规模计算任务的执行速度。在深度学习领域,GPU加速能够有效处理神经网络中的矩阵和向量运算,提高训练和推理的速度。

## 1.3 YOLOv8与GPU加速的结合

在YOLOv8中,GPU加速的应用主要体现在加速模型的训练和实时推理过程中。通过利用GPU的强大计算资源,YOLOv8能够在保持高精度的同时,显著提升检测速度,使得实时视频流处理成为可能。

```

在接下来的章节中,我们将深入探讨YOLOv8与GPU加速之间的具体联系,学习GPU架构对性能的影响、深度学习加速技术的原理,以及YOLOv8模型本身的加速策略。

# 2. YOLOv8 GPU加速的理论基础

### 2.1 GPU硬件与YOLOv8性能关系

#### 2.1.1 GPU架构对加速的影响

GPU,即图形处理单元,其架构设计为并行计算而生,相较于CPU,它拥有成百上千的小核心,能够同时处理大量的数据。YOLOv8是一种实时的深度学习目标检测模型,它对计算量有着极高的要求,尤其是在处理视频流或者高分辨率图像时。这就使得GPU的并行处理能力成为其性能的关键。

GPU架构对YOLOv8的性能影响主要体现在以下几个方面:

- **核心数量**:更多的核心意味着更高的并行计算能力,可以同时处理更多的数据,提升处理速度。

- **内存带宽**:GPU的内存带宽也对性能有很大影响。如果内存带宽不足,即使核心数量多,也可能出现瓶颈,限制了整体性能。

- **计算能力(TFLOPS)**:GPU的浮点计算能力决定了它能以多快的速度执行数学运算,这对于YOLOv8来说至关重要。

在选择GPU时,不仅要考虑到其硬件参数,还要考虑其与YOLOv8模型的适配性。例如,YOLOv8在NVIDIA的GPU上运行时,会使用CUDA技术,因此选择支持CUDA的NVIDIA系列GPU会更加高效。

#### 2.1.2 GPU与CPU协同工作的原理

GPU虽擅长于并行计算,但单靠它很难独立完成复杂的任务,特别是在需要处理大量逻辑判断和数据处理的工作上。这就是CPU的用武之地。CPU和GPU的协同工作,通常遵循以下模式:

- **任务分配**:CPU负责接收用户的输入请求,进行初步的任务分配,同时处理那些不适合GPU加速的逻辑运算。

- **数据传输**:数据准备好后,CPU会将数据传输到GPU的显存中。

- **并行计算**:GPU接收数据后,其众多核心开始并行地处理数据,执行深度学习模型的推理。

- **结果汇总**:计算完成后,GPU将结果传回CPU,CPU再根据需要进行后续处理或输出。

通过这样的协同,YOLOv8模型能够利用GPU的高效计算能力,同时借助CPU强大的指令集和控制能力,共同完成图像识别和目标检测的工作。

### 2.2 深度学习加速技术

#### 2.2.1 CUDA与cuDNN的作用

CUDA(Compute Unified Device Architecture)是NVIDIA推出的一种通用并行计算架构,它允许开发者使用C语言来编写适用于GPU加速的代码。CUDA的出现,降低了GPU并行计算的门槛,使得开发者可以更加方便地编写和利用GPU的计算能力。

cuDNN(CUDA Deep Neural Network library)是专为深度学习优化的一套库,它提供了一系列API,可以高效地进行深度神经网络的构建和训练。cuDNN针对常见的神经网络操作,如卷积、池化、激活函数等进行了优化,使其在GPU上执行得更快。

在YOLOv8中,CUDA和cuDNN共同发挥作用:

- CUDA提供了一个平台,让YOLOv8的开发者能够编写GPU加速代码。

- cuDNN提供了深度学习所需的高效核心算法,这些算法利用GPU的架构优势,让YOLOv8的推理速度得到提升。

因此,CUDA和cuDNN是实现YOLOv8模型GPU加速不可或缺的工具。

#### 2.2.2 TensorRT优化技术剖析

TensorRT是NVIDIA推出的一个深度学习推理的优化器和运行时引擎。它能够优化神经网络模型并提供高效的运行时性能。TensorRT的优势在于它通过多种优化手段提升模型的推理速度,比如层融合、精度校准、内核自动调优等技术。

在YOLOv8中,TensorRT的优化技术可以实现以下功能:

- **图优化**:TensorRT能够对模型计算图进行优化,合并多个小的操作,减少内存和带宽的消耗。

- **精度校准**:TensorRT能够对数据进行校准,将模型中的浮点数运算转换为低精度的INT8运算,从而大幅度提升推理速度。

- **动态张量内存**:TensorRT提供动态内存分配的能力,这可以减少不必要的内存占用,提高内存使用效率。

使用TensorRT,YOLOv8在保持精度的同时,能够实现更快的推理速度和更低的资源消耗。

### 2.3 YOLOv8模型的加速策略

#### 2.3.1 模型结构对速度的优化

YOLOv8模型的设计本身就考虑了速度和准确性之间的平衡。模型结构的优化包含以下几个方面:

- **轻量化模型结构**:为了在保持较高准确性的同时提升速度,YOLOv8可能会采用轻量级的卷积神经网络结构,如使用深度可分离卷积替换标准卷积等。

- **并行处理的深度**:增加网络中并行处理的能力,可以更高效地利用GPU资源。例如,使用多个并行的分支来处理不同的特征通道。

- **优化的残差结构**:使用残差连接可以简化网络结构,同时在保证网络性能的同时提升速度。

在实际应用中,这些模型结构上的优化需要与实际硬件性能相结合,以达到最佳效果。

#### 2.3.2 模型量化与剪枝方法

模型量化和剪枝是提升模型运行速度的常用方法,它们通过减少模型的计算量来提高推理速度。

- **量化**:指的是将浮点数值的模型参数转换为更小位宽的整数表示,这样可以减少模型大小和计算复杂度。YOLOv8的模型量化后,可以在较低精度下执行运算,但依然保持较高的准确性。

- **剪枝**:涉及到移除模型中的一些冗余参数或神经元,这不仅能够加快推理速度,还能降低模型存储需求。剪枝一般需要综合考虑精度损失和速度提升的关系,找到二者之间的平衡点。

模型量化和剪枝是实现YOLOv8快速推理的重要手段,但它们需要在保证模型准确性的前提下进行。

通过上述分析,我们可以看出,YOLOv8的GPU加速并不仅仅是模型的简单移植,而是基于对硬

0

0