TensorFlow深度应用:在复杂网络结构中实现反向传播算法

发布时间: 2024-09-05 15:30:33 阅读量: 59 订阅数: 31

# 1. 深度学习与反向传播算法概述

## 1.1 深度学习简介

深度学习是机器学习领域的一个分支,它通过构建多层的神经网络,使计算机能够模拟人脑对数据进行抽象和理解。深度学习模型,如卷积神经网络(CNN)和循环神经网络(RNN),已经成为图像识别、语音识别和自然语言处理等众多领域的核心技术。

## 1.2 反向传播算法的作用

反向传播算法是深度学习中训练神经网络的关键技术,它通过从输出层向输入层传播误差,并计算每个参数的梯度,实现了模型参数的调整和学习。这一过程使得神经网络能够通过大量数据的训练,不断优化自身结构,提升预测和分类的准确性。

# 2. TensorFlow基础与神经网络构建

在深度学习领域,TensorFlow已成为构建和训练神经网络的首选工具之一。作为一款开源的机器学习库,它提供了强大的计算图功能和灵活的API,支持从研究到生产环境的无缝迁移。本章将介绍TensorFlow的基本概念、操作和如何使用它来构建神经网络。

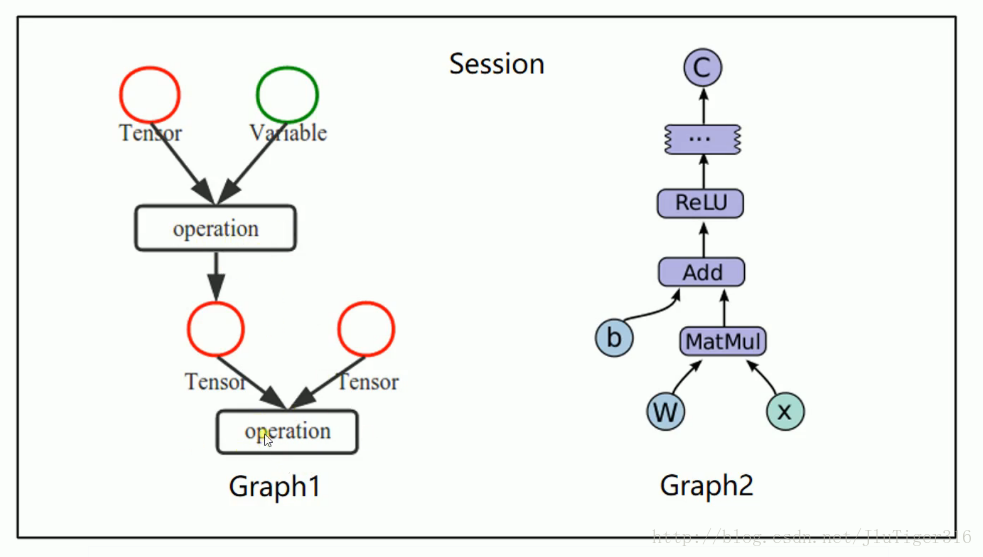

## 2.1 TensorFlow的基本概念与操作

TensorFlow的命名源于其核心概念——张量流(tensor flow)。张量是多维数组的一种形式,它们是TensorFlow中最基本的数据结构,用于表示所有的数据。TensorFlow程序由一张计算图构成,图中节点表示操作,边表示操作之间的多维数据数组(即张量)。

### 2.1.1 TensorFlow安装与环境配置

安装TensorFlow的方式有多种,包括使用`pip`安装,从源代码编译以及使用Docker容器。对于大多数用户来说,使用`pip`是最快捷的安装方法。以安装TensorFlow CPU版本为例,用户只需要在命令行中输入以下命令:

```bash

pip install tensorflow

```

为了进行GPU加速,用户需要确保计算机安装了CUDA和cuDNN,并安装对应版本的TensorFlow GPU支持包:

```bash

pip install tensorflow-gpu

```

环境配置还包括设置Python虚拟环境、确定依赖包的版本,以及配置开发IDE如PyCharm或VSCode等。适当的环境配置可以为接下来的神经网络构建提供一个稳定和高效的开发环境。

### 2.1.2 张量与操作的基本使用

在TensorFlow中,创建张量并执行基本操作非常直观。张量可以是常量也可以是变量,常量一旦创建无法改变其值,而变量则可以改变其值。以下是一个简单的例子,展示了如何在TensorFlow中创建张量和执行基本的数学操作:

```python

import tensorflow as tf

# 创建两个常量张量

a = tf.constant([1.0, 2.0], name='a')

b = tf.constant([3.0, 4.0], name='b')

# 执行张量的基本数学操作

c = tf.add(a, b) # 将a和b相加

# 通过会话运行计算图

with tf.Session() as sess:

print(sess.run(c))

```

执行上述代码段,会得到一个新的张量`c`,它是`a`和`b`的和。TensorFlow的计算图不仅仅在内存中存储了操作的结构,还优化了计算过程,只有在执行会话时(`sess.run()`)才会进行实际的计算。

## 2.2 神经网络的TensorFlow实现

### 2.2.1 简单神经网络模型的搭建

简单神经网络模型的搭建可以通过定义图层和连接来完成。在TensorFlow中,构建网络模型通常通过`tf.keras`模块来实现,这是TensorFlow为了兼容Keras API标准而开发的一个高层API。

```python

from tensorflow.keras import layers, models

# 创建一个序贯模型

model = models.Sequential()

# 添加一个全连接层,使用ReLU激活函数

model.add(layers.Dense(64, activation='relu', input_shape=(input_size,)))

# 添加另一个全连接层,可以输出类别数目大小的向量

model.add(layers.Dense(num_classes, activation='softmax'))

# 编译模型,指定损失函数、优化器以及评价指标

***pile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

```

上述代码首先创建了一个序贯模型`Sequential`,然后通过`add`方法向模型中添加了两个全连接层。第一个全连接层使用ReLU激活函数,输入层的大小为`input_size`。第二层输出类别数目的向量,并使用softmax激活函数来转换成概率分布。最后编译模型,指定了优化器为`adam`,损失函数为`sparse_categorical_crossentropy`,评价指标为准确率。

### 2.2.2 激活函数与损失函数的选择

在神经网络中,激活函数和损失函数的选择对于模型的性能至关重要。激活函数为网络引入非线性,常用的激活函数包括ReLU、Sigmoid、Tanh等。损失函数用于衡量模型预测值与真实值之间的差异,常见的损失函数有均方误差、交叉熵等。

选择合适的激活函数和损失函数需要考虑具体问题的性质,例如在二分类问题中常用的损失函数是二元交叉熵(binary_crossentropy),而在多分类问题中,常使用交叉熵损失函数(如`sparse_categorical_crossentropy`或`categorical_crossentropy`)。了解它们背后的工作原理和适用场景是构建有效神经网络模型的关键。

## 2.3 复杂网络结构的构建

### 2.3.1 卷积神经网络CNN的构建

卷积神经网络(CNN)是深度学习中最具代表性的模型之一,特别适用于图像识别等任务。构建CNN模型,需要使用卷积层(Conv2D)、池化层(MaxPooling2D)等特殊的层结构。

```python

from tensorflow.keras import models, layers

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = models.Sequential()

# 第一个卷积层,32个卷积核,核大小为3x3

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(height, width, channels)))

# 第一个池化层,池化窗口大小为2x2

model.add(MaxPooling2D((2, 2)))

# 第二个卷积层,64个卷积核

model.add(Conv2D(64, (3, 3), activation='relu'))

# 第二个池化层

model.add(MaxPooling2D((2, 2)))

# 展平层,将二维数据转换为一维数据

model.add(Flatten())

# 添加两个全连接层

model.add(Dense(64, activation='relu'))

model.add(Dense(num_classes, activation='softmax'))

# 编译和训练模型与之前相同

```

上述代码构建了一个简单的CNN模型,其中包含两个卷积层和两个池化层,最后是一个全连接层用于分类。构建CNN模型时,注意卷积层的配置,如卷积核的大小、数量、激活函数类型以及填充类型(same或valid)。

### 2.3.2 循环神经网络RNN的构建

循环神经网络(RNN)擅长处理序列数据,例如自然语言文本或时间序列数据。在TensorFlow中,可以使用`SimpleRNN`、`LSTM`或`GRU`层来构建RNN模型。LSTM(长短期记忆网络)由于其能够有效避免长期依赖问题,在复杂序列任务中非常受欢迎。

```python

from tensorflow.keras import layers, models

model = models.Sequential()

# 添加一个LSTM层

model.add(layers.LSTM(64, return_sequences=True, input_shape=(time_steps, input_features)))

# 添加一个全连接层

model.add(layers.Dense(num_classes, activation='softmax'))

# 编译和训练模型与之前相同

```

上述代码展示了如何构建一个包含LSTM层的RNN模型。`return_sequences=True`表示返回整个序列的输出,以便于下一层也是RNN层时能够使用整个输出序列。在自然语言处理任务中,还可以通过嵌入层(Embedding)将单词映射到向量空间中,再输入到RNN模型中。

通过本章节的介绍,我们了解了TensorFlow的基本概念和操作,如何使用TensorFlow构建简单与复杂的神经网络模型,并对激活函数与损失函数的选择进行了讨论。这为进一步深入学习深度学习和构建高效神经网络奠定了坚实的基础。

# 3. TensorFlow中的反向传播机制

## 3.1 反向传播算法的理论基础

### 3.1.1 梯度下降与优化算法

反向传播算法是深度学习中一种有效的学习算法,它的核心思想是通过计算损失函数关于模型参数的梯度,然后使用梯度下降(Gradient Descent)或其他优化算法来最小化损失函数。梯度下降是一种迭代优化算法,目标是找到使损失函数值最小的模型参数。

在TensorFlow中,我们通常使用梯度下降的变体,如随机梯度下降(SGD)、Adam或RMSprop等,这些优化算法比原始梯度下降更高效,尤其是在处理大型数据集时。

### 3.1.2 反向传播算法的数学原理

反向传播算法依赖于链式法则来计算梯度。链式法则是微积分中求导的一个重要法则,用于计算复合函数的导数。在神经网络中,我们将损失函数视为输出层的激活函数的复合函数,这个复合函数的输入是模型参数。通过链式法则,我们可以从输出层向输入层逐层计算梯度。

这种从输出到输入的梯度传递过程,称为反向传播。它使得我们可以高效地计算神经网络中每一层的参数梯度,这是学习过程的关键。

## 3.2 TensorFlow中的自动微分

### 3.2.1 TensorFlow的梯度计算机制

TensorFlow的核心是一个数值计算库,它使用自动微分(Automatic Differentiation)来计算梯度。自动微分允许开发者无需手动实现复杂的梯度计算,只需定义计算图并指定损失函数,TensorFlow就能自动计算所需梯度。

TensorFlow提供了`GradientTape` API,用于记录前向传播过程中的操作,并在需要计算梯度时通过自动微分来高效计算梯度。

### 3.2.2 反向传播中的梯度传播与应用

在执行梯度下降或其变体之前,需要进行反向传播以计算梯度。TensorFlow通过以下步骤来执行这一过程:

1. 使用`GradientTape

0

0