HDFS块管理:默认块大小调整与优化技巧

发布时间: 2024-10-29 00:53:13 阅读量: 78 订阅数: 31

YOLO算法-城市电杆数据集-496张图像带标签-电杆.zip

# 1. HDFS块管理基础

## 简介

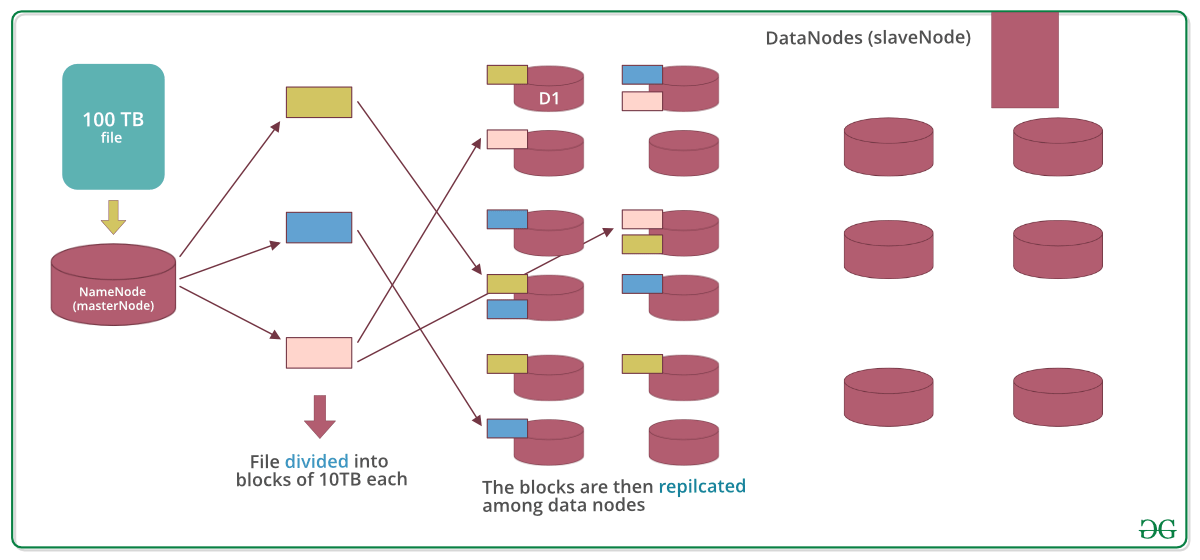

Hadoop分布式文件系统(HDFS)是Hadoop项目的核心组件之一,它被设计用来运行在廉价的硬件上,提供高吞吐量的数据访问。为了实现这一目标,HDFS采用了“分而治之”的策略,将大文件拆分成固定大小的数据块(block),进行分布式存储。理解HDFS的块管理是深入学习Hadoop和进行性能优化的基础。

## HDFS块的概念

在HDFS中,文件被切分成一系列的块,这些块默认大小为128MB(在早期版本中为64MB),用户也可以根据需要设置块的大小。块是HDFS文件系统存储和计算的基本单位,它们独立存储在多个DataNode上。这种设计允许Hadoop在数据处理时并行操作多个块,从而提高整体的处理速度和容错能力。

## HDFS块管理的重要性

块管理对于HDFS的性能至关重要。正确的块大小可以最大限度地利用存储资源,同时提高数据处理的效率。同时,块管理还涉及到数据的副本管理,确保数据的高可靠性与可用性。在本章中,我们将详细探讨块管理的基本原理和它在HDFS中的作用,为理解后续章节内容打下坚实基础。

# 2. HDFS默认块大小的影响

在数据存储系统中,块的大小是一个关键参数,它直接影响到存储的效率、性能,以及可靠性。在Hadoop分布式文件系统(HDFS)中,块大小是一个可配置的参数,它的选择会对系统的整体表现产生深远的影响。本章将探讨HDFS默认块大小对系统性能、数据可靠性和MapReduce作业的影响。

## 2.1 块大小对系统性能的影响

### 2.1.1 数据读写性能分析

在HDFS中,一个文件被切分成一系列块,并分布在不同的数据节点上。块的大小决定了单次读写操作能够处理的数据量,这对于系统的性能具有重要的影响。较小的块大小意味着需要更多的I/O操作来读写相同的文件,但可以提高并发度和容错能力。相反,较大的块大小减少了I/O操作,可能会提高吞吐量,但增加了单点失败的风险。

**代码示例**:

```java

// 伪代码示例,展示如何读取HDFS上的一个大文件

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path path = new Path("/user/hadoop/file.txt");

FSDataInputStream in = fs.open(path);

byte[] buffer = new byte[4096]; // 假定每次读取4KB大小的数据块

while(in.read(buffer) > 0){

// 处理数据

}

in.close();

```

在上述代码中,通过调整`buffer`的大小,可以模拟不同块大小对读操作的影响。较小的`buffer`大小意味着更多的读取次数,而较大的`buffer`则可以减少I/O操作次数。

### 2.1.2 块大小与网络传输效率

块大小还决定了HDFS中的数据在网络中的传输效率。较大的块可以减少网络传输的数据包数量,因为每个块只需要传输一次,但是同时也会增加网络拥堵的风险,尤其是当多个节点同时向NameNode报告大块数据的存储位置时。

**网络传输效率示意图**:

```mermaid

flowchart LR

A[客户端] -->|读取数据| B[DataNode1]

A -->|读取数据| C[DataNode2]

A -->|读取数据| D[DataNode3]

B -->|传输数据| A

C -->|传输数据| A

D -->|传输数据| A

```

上图显示了客户端从多个DataNode读取数据的场景,每个DataNode传输一个块的数据。小块可以使得客户端更快速地获取数据,因为数据传输速度快,但是更频繁的网络请求可能会降低整体效率。

## 2.2 块大小与数据可靠性

### 2.2.1 数据块复制机制

HDFS通过数据块的复制来提高数据的可靠性。块大小的选择影响了需要复制的数据量,进而影响了系统的可靠性和冗余量。较大的块大小意味着在发生硬件故障时需要复制更多的数据,从而增加了恢复时间和成本。而较小的块则可以减少在故障时需要复制的数据量,从而降低恢复时间和成本。

**数据块复制逻辑分析**:

```java

// 伪代码示例,展示如何创建文件并设置复制因子

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path path = new Path("/user/hadoop/file.txt");

FSDataOutputStream out = fs.create(path);

// 设置复制因子,这里为3

DFSOutputStream stream = (DFSOutputStream) out;

stream.setReplication(3);

byte[] buffer = new byte[4096];

// 写入数据到文件

while(写入操作) > 0){

// 实际代码应包含数据写入逻辑

}

out.close();

```

在上述代码中,`setReplication`方法用于设置文件的复制因子,该因子与块大小直接相关。如果块较大,则复制因子相同的条件下,需要复制的数据更多。

### 2.2.2 块大小与数据恢复时间

由于HDFS采用了冗余存储机制,因此在发生数据丢失或硬件故障时,系统能够自动从其他节点复制缺失的块。块大小的大小直接影响恢复时间,因为需要复制的数据量不同。小块的快速复制可以缩短系统不可用的时间,而大块则会延长恢复时间。

**数据恢复时间计算表**:

| 块大小 (MB) | 复制时间 (秒) | 可用性恢复时间 |

|-------------|----------------|----------------|

| 64 | 10 | 短 |

| 128 | 20 | 中等 |

| 256 | 40

0

0