揭秘HDFS块大小:10个实用技巧助你优化存储与性能

发布时间: 2024-10-29 00:27:08 阅读量: 50 订阅数: 32

外网无法访问HDFS org.apache.hadoop.hdfs.BlockMissingException: Could not obtain block

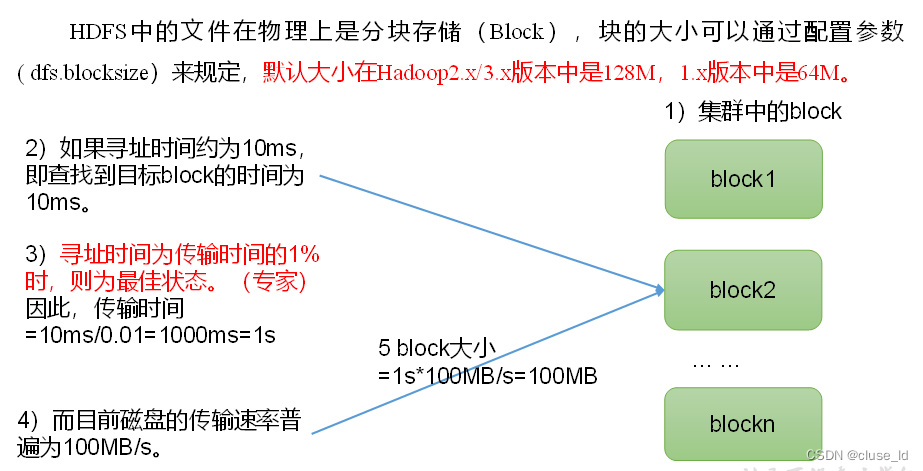

# 1. HDFS块大小的基本概念

在本章中,我们将开始探讨Hadoop分布式文件系统(HDFS)的核心概念之一:块大小。HDFS将大文件分解为固定大小的块(block),这些块是独立存储的,并由不同的数据节点(DataNode)进行管理。了解块大小的重要性是优化HDFS性能的关键,它直接关系到存储效率、读写性能、网络传输效率以及故障恢复能力。我们将从块大小的定义和基本原理着手,为您打下坚实的基础,以便更好地理解后续章节中关于块大小调优、实践案例分析以及未来趋势的深入讨论。

# 2. HDFS块大小的理论分析

在深入了解HDFS块大小的理论背景之前,理解块存储机制的起源和必要性至关重要。随后,我们将深入探讨块大小与存储效率之间的关系,以及如何通过调整块大小来优化Hadoop分布式文件系统(HDFS)的性能。

## 2.1 HDFS块大小的基本原理

### 2.1.1 块存储机制的起源和必要性

在分布式文件系统设计中,将文件分割成块(block)是处理大数据的基础。HDFS将文件分割成固定大小的块,这些块被独立存储在多个数据节点上。这种机制的起源主要源于以下几个方面:

- **容错性**: 在分布式环境下,数据块可以被复制多个副本存储在不同的数据节点上,从而提高了系统的容错能力。

- **扩展性**: 增加更多的数据节点可以线性扩展存储能力,同时也能提高数据的读写性能。

- **并行处理**: 独立的块可以让MapReduce等计算框架并行处理数据,提高计算效率。

块存储机制的必要性在于其提供了良好的可扩展性与灵活性,是实现大规模分布式存储系统的基石。

### 2.1.2 块大小与存储效率的关系

块大小的设置与存储效率紧密相关。理想的块大小设置能够在存储效率和性能之间取得平衡。以下几点阐述了块大小与存储效率的关系:

- **存储碎片**: 过大的块可能导致存储空间浪费,而过小的块可能导致大量存储碎片,同样影响存储效率。

- **读写操作**: 块大小直接影响到读写操作的次数,太小的块可能造成频繁的磁盘I/O操作,而太大的块可能导致单次操作时间过长。

- **数据局部性**: 合理的块大小可以保证数据的局部性,减少数据访问的延迟。

理解块大小与存储效率的关系,有助于我们在不同的应用场景下选择最合适的块大小。

## 2.2 HDFS块大小的性能影响

块大小不仅影响存储效率,还直接影响到HDFS的性能,具体表现如下:

### 2.2.1 块大小对读写性能的影响

读写性能是块大小设置时必须考虑的因素。以下是块大小对读写性能的具体影响:

- **读性能**: 较大的块大小减少了定位和打开文件的次数,从而可以提高读取效率。但是,如果块太大,单个读操作的时间会增加,可能对读性能产生负面影响。

- **写性能**: 同理,较大的块大小可以减少写操作的次数,但是也可能导致写入时延增加。

参数如`dfs.block.size`允许用户在Hadoop集群配置中指定块大小,通过实验找到最佳读写性能平衡点是实践中的一个常见任务。

### 2.2.2 块大小对网络传输的影响

块大小对于数据在网络中的传输效率也具有显著的影响:

- **数据传输量**: 块大小越大,单次传输的数据量就越大,网络带宽的需求也越高。这可能会导致在带宽有限的环境中成为瓶颈。

- **并行传输**: 较小的块大小可以让更多的数据块同时传输,有助于充分利用网络带宽。

因此,对于网络带宽有限的环境,需要适当调整块大小以优化网络传输效率。

### 2.2.3 块大小对故障恢复的影响

HDFS通过在不同的节点上保存多个副本来提高数据的可靠性。块大小对故障恢复的影响主要表现在:

- **恢复速度**: 较小的块大小意味着备份的数据块数量较多,这可能导致恢复过程更快。

- **资源消耗**: 在故障发生时,恢复较小的块需要更多的I/O和网络资源。

因此,在设计HDFS块大小时,需要权衡故障恢复的速度与资源消耗之间的关系。

通过深入分析HDFS块大小的基本原理及其对性能的影响,我们可以更好地理解如何在实际应用中进行优化。接下来,我们将探索HDFS块大小的调优技巧,以及如何在不同场景下应用这些技巧以提高存储系统的效率。

# 3. HDFS块大小的调优技巧

## 3.1 块大小的选择策略

在Hadoop分布式文件系统(HDFS)中,块大小是一个关键的配置参数,它直接影响存储效率、读写性能以及集群的资源使用。因此,选择合适的块大小对于提高整体系统的性能至关重要。

### 3.1.1 根据数据特征选择块大小

在选择块大小时,首先需要考虑数据的访问模式和大小。对于频繁读写的中等大小文件,使用较小的块大小可以提高数据的并发访问能力,因为更多的块意味着更多的Mapper可以并行处理数据。然而,对于大规模文件,较小的块大小可能导致NameNode内存消耗增加,因为需要维护更多的块信息。

以下是一个基本的指导原则来选择块大小:

- 小文件(< 64MB):可以考虑使用小块,例如128MB或更小,以提高并发性。

- 中等大小文件(64MB - 1GB):使用中等块大小,例如256MB,可以平衡读写性能和管理开销。

- 大文件(> 1GB):建议使用大块大小,例如128MB或更大,以减少NameNode的负载和优化存储空间使用。

### 3.1.2 根据集群规模调整块大小

集群的规模和可用的硬件资源也是调整块大小时需要考虑的因素。在拥有大量小核节点的小型集群中,使用较小的块大小可以提供更高的并行度。而在拥有少量大核节点的大型集群中,较大的块大小可以减少NameNode和DataNode之间的通信量,从而提高性能。

在调整块大小时,还需注意以下几点:

- 大块意味着更少的元数据,有助于减少NameNode内存压力。

- 小块意味着更高的冗余度,有助于提高容错能力。

- 大块可能意味着更少的并行度,但同时减少了对NameNode的负载。

- 小块可以提供更高的并行度和更快的处理速度,但会增加NameNode的内存压力。

## 3.2 块大小的动态调整方法

HDFS允许动态调整块大小,以应对数据增长和使用模式变化。以下是一些用于动态调整块大小的方法。

### 3.2.1 使用HDFS的balance-bandwidth参数

平衡带宽参数(`dfs.balance.bandwidthPerSec`)用于控制DataNode之间的数据迁移速率。如果想要提高块的大小,可以设置这个参数,使得DataNode之间的数据迁移更加频繁和快速。

### 3.2.2 利用HDFS的高级特性进行调整

HDFS提供了`hdfs dfsadmin -setBalancerBandwidth`命令来设置平衡带宽参数。通过这个命令,管理员可以控制DataNode之间数据迁移的速率,间接地影响块的大小调整过程。

```bash

hdfs dfsadmin -setBalancerBandwidth <bandwidth in bytes>

```

例如,将平衡带宽设置为1MB每秒的命令如下:

```bash

hdfs dfsadmin -setBalancerBandwidth 1048576

```

### 3.2.3 监控和调整策略的最佳实践

在进行块大小调整时,监控是不可或缺的步骤。通过`hdfs fsck`命令可以检查文件系统的健康状况,通过`hdfs dfsadmin -report`命令可以查看集群的使用情况。

监控工具如Nagios或Ganglia可以帮助持续跟踪集群的性能指标。对于块大小调整的决策,以下指标尤为重要:

- NameNode的内存使用情况。

- DataNode上的磁盘使用情况。

- 网络I/O的吞吐量和延迟。

- Map和Reduce任务的执行时间和负载均衡。

## 3.3 应用代码和配置

通过实际的配置和命令操作,下面是一个示例,说明如何在HDFS中调整块大小,并对集群进行监控和优化。

```bash

# 设置HDFS块大小为128MB

hadoop fs -setrep -w 2 /path/to/directory

```

该命令会将指定目录下所有的文件块大小调整为128MB,并且复制两份备份。参数 `-w` 表示确保每个文件都有指定数量的副本。

配置文件 `hdfs-site.xml` 可以用于设置默认的块大小:

```xml

<configuration>

<property>

<name>dfs.block.size</name>

<value>***</value> <!-- 128 MB -->

</property>

</configuration>

```

在调整块大小之后,需要对集群进行监控,确保新的块大小不会对集群性能造成负面影响。在监控过程中,可以使用以下指标:

- **NameNode内存使用情况**:监控NameNode的内存使用量,确保它不会超过物理内存限制。

- **DataNode磁盘使用情况**:监控DataNode上的磁盘空间使用情况,防止磁盘溢出。

- **网络I/O吞吐量**:确保数据传输不会导致网络拥塞。

- **任务执行时间**:监控Map和Reduce任务的执行时间,分析是否有性能瓶颈。

通过持续的监控和定期的调整,可以确保HDFS集群的块大小配置达到最佳状态。

至此,我们已经详细介绍了如何根据数据特征和集群规模来选择HDFS块大小,并讨论了动态调整块大小的方法以及最佳实践。下一章节,我们将深入探讨HDFS块大小的实际应用案例,从而更加深刻理解块大小调整在生产环境中的实际影响。

# 4. HDFS块大小的实践案例分析

## 4.1 小块大小的优势与挑战

### 4.1.1 小块大小的使用场景

在Hadoop生态系统中,小块大小通常用于那些读写操作频繁,但单个数据块较小的场景。例如,一些日志分析和小文件处理的场景中,小块大小可以提高数据的随机读写性能,因为较小的块意味着更多数量的块可以并行处理。这在处理大量小文件时特别有用,可以有效减少每个小文件的读取延迟。

小块大小的另一个场景是当集群中存储的数据量不是非常大,但对小文件的处理需求较高时。在这种情况下,使用小块大小可以提高存储空间的利用率。

### 4.1.2 小块大小带来的潜在问题

尽管小块大小在某些使用场景下有其优势,但它也带来了不少潜在问题。首先,小块大小会导致更多的NameNode内存占用,因为每个小块都需要在NameNode中有一个对应的元数据记录。对于拥有大量小文件的系统来说,这可能会成为瓶颈。

其次,小块大小可能会导致更多的网络通信开销。由于Hadoop是基于块的分布式文件系统,每个块的读写操作都需要通过网络进行,块的大小越小,单次操作涉及的网络传输次数越多,从而可能导致网络拥塞。

最后,小块大小还可能影响MapReduce等作业的性能。MapReduce任务通常需要读取大量数据块,小块大小意味着需要读取更多的块,这可能会导致任务调度和处理效率的下降。

## 4.2 大块大小的优势与挑战

### 4.2.1 大块大小的使用场景

大块大小在处理大文件时能发挥优势,它减少了数据块的数量,从而减少了管理元数据的开销和网络传输次数。对于那些一次性写入然后经常读取的大文件,大块大小可以提高整体的读写效率。

大数据分析和批量处理是大块大小的另一个典型使用场景。在这种场景中,数据处理通常是批量进行的,大块大小可以减少MapReduce任务的数量,因为每个任务处理的数据更多,从而提高了数据处理的效率。

### 4.2.2 大块大小带来的潜在问题

虽然大块大小在某些方面提供了性能优势,但它也带来了新的挑战。大块大小意味着更少的数据块可用于并行处理,这可能会限制MapReduce等作业的并行化程度,进而影响到整体的计算效率。

另一个问题是,大块大小可能会影响故障恢复的时间。由于每个块的大小较大,因此在发生故障时需要复制或重新计算的数据量也会增加,这可能会导致整个系统的恢复时间变长。

## 4.3 实际案例分析与总结

### 4.3.1 成功案例:块大小优化的实践经验

一个成功的案例来自于某大数据公司,该公司对HDFS块大小进行了细致的优化。在他们的环境中,数据主要由大规模的日志文件和一些分析型的大文件组成。通过仔细分析数据的读写模式,他们发现对于日志文件,使用128MB的块大小可以有效提高性能,因为这样可以减少NameNode的元数据压力并提升随机读写的效率。对于分析型的大文件,他们选择了256MB的块大小,这样可以减少MapReduce作业的数量,提高数据处理速度。

### 4.3.2 失败案例:块大小不当设置的教训

在另一家公司,由于缺乏对HDFS块大小影响的深刻理解,他们在没有充分测试的情况下将所有集群的块大小设置为默认的64MB。这导致了几个问题,首先是NameNode内存压力显著增加,由于大量小文件的存在,元数据的管理变得异常困难。其次是网络开销增大,因为更多的小块数据需要在网络中传输。最后,MapReduce作业的执行时间增长,因为更多的小块需要被处理。这个案例提醒我们,在调整HDFS块大小时,需要考虑具体的使用场景和数据特性。

### 4.3.3 优化建议:结合实际进行块大小调整

根据上述案例,我们可以总结出一些调整HDFS块大小的建议。首先,调整块大小前,应该详细了解数据的特征和读写模式。小文件和日志文件处理较多的场景适合使用较小的块大小,而大数据文件处理较多的场景则适合使用较大的块大小。

其次,在实施块大小调整时,应该采取逐步迭代的方式。可以在一部分节点上测试新的块大小设置,观察系统的性能变化和稳定性,然后再在全集群进行调整。

最后,还需要考虑整个集群的硬件配置,包括CPU、内存、存储和网络。块大小的调整应当与集群的硬件性能相匹配,以获得最优的性能表现。在对块大小进行优化时,始终要以实际的业务需求和系统性能指标为依据。

# 5. HDFS块大小的未来趋势与挑战

随着大数据技术的不断进步,Hadoop分布式文件系统(HDFS)的块大小设置也面临着不断变化的需求和技术挑战。在这一章节中,我们将探讨HDFS块大小的发展方向,面临的挑战,以及探索可能的替代方案。

## 5.1 HDFS块大小的发展方向

### 5.1.1 自动化块大小调整的前景

随着机器学习和人工智能技术的发展,自动化调整HDFS块大小的需求日益增加。自动化系统可以基于历史数据和当前的工作负载,动态地调整块大小,以实现最佳的存储效率和性能。例如,可以通过预测模型确定在特定时间段内最优的块大小配置,以应对数据访问模式的变化。

```java

// 伪代码示例:自动化调整块大小的算法概念

public class BlockSizeAutomation {

public static void adjustBlockSize(HDFSConfiguration config) {

// 获取当前系统负载和数据访问模式

WorkloadSummary currentWorkload = getCurrentWorkloadSummary();

DataAccessPattern accessPattern = get DataAccessPattern();

// 预测最佳块大小

int optimalBlockSize = predictOptimalBlockSize(currentWorkload, accessPattern);

// 调整HDFS块大小

config.setBlockSize(optimalBlockSize);

// 更新HDFS配置

updateHDFSConfiguration(config);

}

private static int predictOptimalBlockSize(WorkloadSummary currentWorkload, DataAccessPattern accessPattern) {

// 机器学习算法预测逻辑

// ...

return predictedBlockSize;

}

}

```

### 5.1.2 面向云存储的块大小调整策略

在云存储环境中,数据的规模、类型和访问模式可能会有很大的不同,这要求块大小策略也要相应调整。在云环境中,块大小的调整可能需要考虑到成本效益分析,例如,为存储成本较低但访问频繁的数据使用更大的块,以减少元数据操作成本。

## 5.2 HDFS块大小面临的挑战与应对

### 5.2.1 数据安全性和块大小的关系

数据安全性是任何存储系统必须考虑的重要因素。大块大小可能导致单个块损坏时数据丢失量更大。因此,需要采取措施,比如增加副本数量或采用纠删码技术来提高数据的容错能力。

### 5.2.2 新兴技术对块大小调整的影响

新兴技术如边缘计算、5G通信和物联网(IoT)等,对数据的处理和存储提出了新的要求。这些技术可能需要更细粒度的控制和更灵活的块大小策略,以便适应不同设备和应用程序的数据传输和处理需求。

## 5.3 探索HDFS的替代方案

### 5.3.1 其他分布式文件系统的块管理机制

除了HDFS之外,还有其他分布式文件系统,如Amazon的S3、Ceph等,这些系统提供了不同的块管理机制。对于某些特定场景,它们可能提供更好的块大小调整策略。例如,Ceph提供动态调整存储池中对象大小的能力,从而提供了更大的灵活性。

### 5.3.2 HDFS块大小优化的长期展望

未来,HDFS块大小的优化可能会走向更加智能化和模块化。系统可能允许应用层根据自己的需求来请求特定大小的块,而不是整个集群采用统一的设置。这样可以进一步优化特定应用的性能,同时保持系统的整体效率。

本章节展示了HDFS块大小在技术进步和业务需求变化下的一些可能的发展方向。自动化调整、云存储策略、数据安全考虑和新兴技术的影响等都为HDFS块大小的优化提供了新的视角和挑战。同时,对其他分布式文件系统的块管理机制的探索,为HDFS的进一步发展提供了可借鉴的路径。在不断变化的技术环境中,HDFS块大小的优化和调整仍将持续是一个活跃的研究与实践领域。

0

0