【R语言数据分析宝典】:精通从入门到精通的15个必备技巧

发布时间: 2024-11-10 01:14:01 阅读量: 50 订阅数: 25

《ArcGIS开发宝典—从入门到精通》示例代码及源数据

# 1. R语言数据分析基础

## 1.1 R语言概述

R语言是一个用于统计分析、图形表示和报告的自由软件编程语言和环境。由于其强大的社区支持和大量的统计包,R语言在全球范围内被广泛用于数据分析和机器学习领域。R语言的特点包括易于学习,强大的数据处理和分析能力,以及灵活的图形输出。

## 1.2 安装与配置R环境

开始使用R之前,我们需要下载并安装R软件。R语言可以通过CRAN(The Comprehensive R Archive Network)网站获取。安装后,可通过RStudio这样的集成开发环境(IDE)来提高编码效率。RStudio提供代码编辑、调试和数据可视化等功能。

## 1.3 R语言基础语法入门

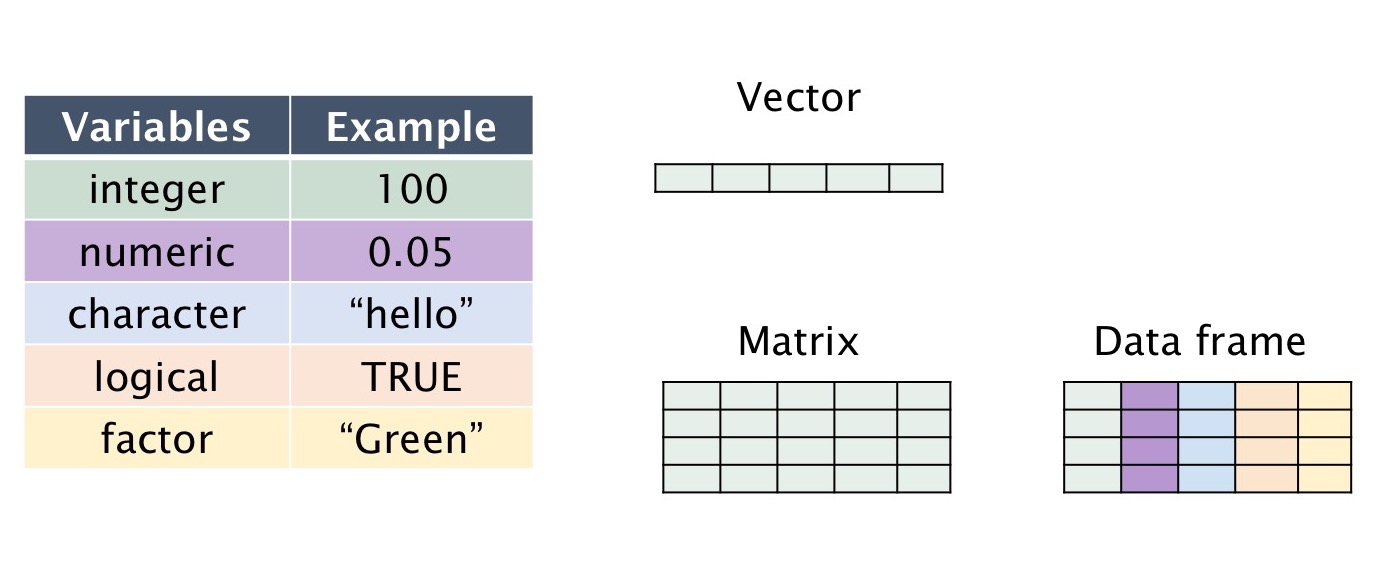

R语言的语法结构简洁明了。基本的命令包括变量赋值、数据结构操作(如向量、矩阵、列表、数据框等)和函数调用。例如,创建一个向量并进行简单的数学运算:

```R

# 创建向量

numbers <- c(1, 2, 3, 4, 5)

# 向量运算

squared_numbers <- numbers ^ 2

print(squared_numbers)

```

这个简单的例子展示了数据对象的创建和基础运算,为后续的数据处理和分析打下了基础。

# 2. R语言数据处理技巧

在本章节中,我们将深入探讨R语言在数据处理方面的高级技巧。本章的目标是让读者能够熟练地导入各种数据源、进行数据清洗与转换,以及掌握基础的数据可视化技能,从而为高级数据分析和建模打下坚实的基础。

## 2.1 数据导入与清洗

数据导入和清洗是数据分析中的第一步,也是至关重要的一步。处理数据前,需要将其从各种来源导入R环境中,并且确保数据的质量。

### 2.1.1 导入不同来源的数据

R提供了多种函数来导入不同来源的数据,包括CSV、Excel、数据库以及网络数据。以下是一些常用方法:

#### 从CSV文件导入

```R

data <- read.csv("path/to/your/data.csv", header = TRUE, sep = ",")

```

- `header` 参数指明数据的第一行是否包含列名。

- `sep` 参数定义了字段之间的分隔符,通常CSV文件使用逗号(`,`)。

#### 从Excel文件导入

使用 `readxl` 包的 `read_excel` 函数导入Excel文件:

```R

library(readxl)

data <- read_excel("path/to/your/data.xlsx")

```

- `read_excel` 函数可以直接读取 `.xlsx` 文件,并且自动处理单元格格式。

#### 从数据库导入

R语言通过 `DBI` 和特定数据库驱动包(如 `RMySQL`、`RSQLite` 等)与数据库进行交互:

```R

library(DBI)

conn <- dbConnect(RSQLite::SQLite(), dbname = "path/to/your/database.db")

data <- dbGetQuery(conn, "SELECT * FROM your_table")

dbDisconnect(conn)

```

- `dbConnect` 函数创建了一个数据库连接。

- `dbGetQuery` 函数执行SQL查询并将结果导入R环境。

#### 从网络导入

可以使用 `httr` 或 `readr` 包的函数从网上直接导入数据:

```R

library(readr)

url <- "***"

data <- read_csv(url)

```

- `read_csv` 函数可以直接从URL读取并解析CSV数据。

### 2.1.2 缺失数据处理

导入数据后,常常需要处理其中的缺失值。处理缺失数据的策略包括删除含有缺失值的观测,或者用其他值替代缺失值。

#### 删除含有缺失值的观测

```R

data_clean <- na.omit(data)

```

- `na.omit` 函数会移除所有包含缺失值的行。

#### 替代缺失值

有时,我们可以用列的均值、中位数或众数替代缺失值:

```R

# 使用均值替代数值型数据的缺失值

data$column[is.na(data$column)] <- mean(data$column, na.rm = TRUE)

# 使用众数替代因子型数据的缺失值

mode_value <- names(sort(-table(data$column)))[1]

data$column[is.na(data$column)] <- mode_value

```

- `na.rm` 参数在计算均值时用于忽略NA值。

- `table` 函数用于计算因子型数据的频数,然后根据频数确定众数。

## 2.2 数据转换与聚合

数据转换与聚合是数据分析的核心步骤之一,涉及数据的筛选、排序、创建新变量等,以及基于某些标准对数据进行分组并计算统计量。

### 2.2.1 使用dplyr包进行数据变换

`dplyr` 包提供了一组函数来处理数据框(data frame),每个函数只执行一个数据操作。

```R

library(dplyr)

data_transformed <- data %>%

filter(column1 > 0) %>% # 筛选出特定条件的行

mutate(new_column = column1 / 100) %>% # 添加新变量

arrange(desc(column2)) # 根据某列排序

```

- `filter` 函数用于选择数据框中的特定行。

- `mutate` 函数用于创建或修改变量。

- `arrange` 函数用于对数据框中的行进行排序。

### 2.2.2 数据分组与聚合方法

在分组聚合操作中,我们常常按某变量的不同类别,对数据集的其他变量进行汇总统计。

```R

grouped_data <- data %>%

group_by(grouping_column) %>%

summarise(mean_value = mean(column, na.rm = TRUE), # 计算均值

count = n()) # 计算组内观测数

```

- `group_by` 函数用于分组数据。

- `summarise` 函数用于对每个分组计算统计量。

## 2.3 数据可视化基础

数据可视化是数据分析中沟通发现结果的重要手段。R语言提供了多种图形系统,其中最流行的是基础图形系统和`ggplot2`包。

### 2.3.1 基本图形的绘制

使用R基础图形系统,我们可以绘制各种基本图形,如散点图、直方图和箱线图。

```R

# 散点图

plot(data$column1, data$column2)

# 直方图

hist(data$column, breaks = 10)

# 箱线图

boxplot(data$column ~ data$grouping_column)

```

- 在绘制散点图时,`plot` 函数根据两列数据生成点图。

- `hist` 函数用于绘制直方图,`breaks` 参数定义了分组的数量。

- `boxplot` 函数用于生成箱线图,可以按组别显示分布情况。

### 2.3.2 图形参数的调整与美化

R语言的基础图形系统提供了多种参数来调整图形的外观。

```R

# 调整图形标题和坐标轴标签

plot(data$column1, data$column2, main = "Title of Plot",

xlab = "X-axis Label", ylab = "Y-axis Label")

```

- 在图形函数中,可以通过添加参数来修改标题(`main`),X轴标签(`xlab`)和Y轴标签(`ylab`)。

本章节介绍了如何在R语言中导入、清洗、转换、聚合数据,并生成基础图形。掌握了这些基础技能后,就可以开始使用R进行更复杂的统计分析和数据可视化了。下一章节,我们将深入探讨R语言在高级数据分析方法中的应用。

# 3. R语言高级数据分析方法

## 3.1 统计模型应用

### 3.1.1 线性回归分析

线性回归是统计学中用来预测两个或多个变量之间关系的常用方法。在R语言中,使用`lm()`函数可以方便地实现线性回归分析。线性回归模型尝试建立一个因变量y和一个或多个自变量x之间的关系,表示为y = β0 + β1x1 + β2x2 + ... + ε。其中,β0是截距,β1, β2是x变量的系数,而ε是误差项。

在R语言中进行线性回归模型拟合的基本步骤包括:

1. 使用`lm()`函数拟合模型。

2. 查看模型摘要(`summary()`函数)了解模型的详细信息。

3. 对模型结果进行诊断,如检查残差、多重共线性等。

4. 如果需要,可以对模型进行改进或者重新拟合。

下面是一个简单的示例代码,展示如何在R中建立一个线性回归模型:

```r

# 示例数据集

data(mtcars)

# 建立线性模型,mpg为因变量,hp和wt为自变量

model <- lm(mpg ~ hp + wt, data=mtcars)

# 查看模型摘要

summary(model)

```

在上述代码中,`mtcars`是一个内置的R数据集,包含了汽车的各种参数,如`mpg`(每加仑英里数),`hp`(马力),`wt`(重量)。模型的输出会显示每个变量的估计系数和统计显著性,以及模型的R方值等重要统计量。

### 3.1.2 逻辑回归与分类问题

逻辑回归是处理二分类问题的常用统计方法,它通过一个逻辑函数将线性回归的结果映射到0和1之间,可以用来估计某个事件发生的概率。在R中,`glm()`函数可以用来进行逻辑回归分析。

逻辑回归模型通常用于医疗诊断、信用卡欺诈检测、市场预测等领域。其基本形式为:logit(p) = ln(p/(1-p)) = β0 + β1x1 + β2x2 + ... + ε。其中,p是响应变量为正值的概率。

在R中进行逻辑回归分析的步骤大致如下:

1. 使用`glm()`函数,指定家庭为`binomial`。

2. 使用`summary()`函数查看模型摘要。

3. 利用`predict()`函数进行概率预测。

4. 确定阈值,将概率转换为分类。

下面是一个使用R进行逻辑回归的简单例子:

```r

# 示例数据集

data("Titanic")

# 转换数据为数据框

titanic_data <- as.data.frame(Titanic)

# 简化数据集只选取部分列

titanic_data <- titanic_data[,c("Survived", "Age", "Sex")]

# 删除缺失值

titanic_data <- na.omit(titanic_data)

# 将因子变量转换为数值变量

titanic_data$Survived <- ifelse(titanic_data$Survived == "Yes", 1, 0)

titanic_data$Sex <- ifelse(titanic_data$Sex == "Female", 1, 0)

# 建立逻辑回归模型

logit_model <- glm(Survived ~ Age + Sex, data=titanic_data, family="binomial")

summary(logit_model)

# 使用模型进行预测

predicted_prob <- predict(logit_model, type="response")

# 将概率转换为二分类

predicted_class <- ifelse(predicted_prob > 0.5, "Survived", "Not Survived")

```

在这个例子中,我们从`Titanic`数据集中选取了乘客是否存活(`Survived`)、年龄(`Age`)和性别(`Sex`)三个变量,通过逻辑回归模型预测乘客的存活情况。

## 3.2 机器学习算法实践

### 3.2.1 常见机器学习模型的选择与应用

在R语言中,有许多包提供了机器学习算法,如`caret`, `e1071`, `randomForest`等。对于不同类型的问题,选择合适的模型至关重要。例如,对于分类问题,可能需要考虑`knn`, `决策树`, `随机森林`, `支持向量机(SVM)`等。回归问题可能需要`线性回归`, `岭回归`, `支持向量回归(SVR)`等。

在选择模型时,可以依据问题的复杂度、数据的大小和特点、模型的可解释性等因素。在实际应用中,可以先从一些基础模型开始,逐步尝试更复杂的模型,直至找到最适合当前问题的模型。

### 3.2.2 模型评估与优化

模型评估主要通过一系列统计量和可视化方法来判断模型的预测性能。常见的评估方法有:

- **准确率(Accuracy)**:正确分类的样本数除以总样本数。

- **混淆矩阵(Confusion Matrix)**:显示实际类别和预测类别的对照表。

- **精确率(Precision)**:预测为正例中真正正例的比例。

- **召回率(Recall)**:实际为正例中预测为正例的比例。

- **F1分数(F1 Score)**:精确率和召回率的调和平均数。

- **ROC曲线**和**AUC值**:反映模型在不同阈值下的分类性能。

模型优化则涉及到调整模型参数或选择更合适的特征来提高模型性能。常用的方法包括:

- **交叉验证(Cross Validation)**:通过分层抽样来验证模型的泛化能力。

- **网格搜索(Grid Search)**:尝试不同参数组合以找到最佳模型。

- **随机搜索(Random Search)**:在参数空间中随机选择参数组合进行搜索。

- **特征选择(Feature Selection)**:通过减少特征数量来简化模型并提高性能。

## 3.3 时间序列分析

### 3.3.1 时间序列数据的处理

时间序列分析是一种特殊的数据分析方法,它专注于分析按时间顺序排列的数据点。时间序列数据的处理在经济学、金融、环境科学等领域尤为重要。在R语言中,可以使用`ts()`函数创建时间序列对象,并进一步使用`forecast`包中的函数来进行时间序列的分解、平滑、预测等操作。

时间序列数据的处理包括以下几个步骤:

1. **识别趋势**:使用图表等可视化手段识别时间序列中的趋势。

2. **分解时间序列**:将时间序列分解为趋势、季节性和随机部分。

3. **差分**:通过差分序列以稳定时间序列的方差并使其变得平稳。

4. **季节性调整**:去除时间序列中的季节性因素以便于分析。

### 3.3.2 常见时间序列预测模型

在时间序列预测中,常见的模型包括:

- **ARIMA模型**:自回归积分滑动平均模型,适合处理非季节性的时间序列数据。

- **SARIMA模型**:季节性ARIMA模型,与ARIMA类似,但加入了季节性因素。

- **指数平滑模型**:如简单指数平滑、Holt-Winters方法等,适合处理具有趋势和季节性的时间序列数据。

下面是一个使用ARIMA模型对时间序列数据进行预测的例子:

```r

library(forecast)

# 假设data是一个时间序列数据集

data <- ts(dataset, frequency=12) # 设定频率为月度数据

# 拟合ARIMA模型

model <- auto.arima(data)

# 查看模型摘要

summary(model)

# 进行预测

forecast_result <- forecast(model, h=12) # 预测未来12个时间单位

# 绘制预测结果图

plot(forecast_result)

```

在这个示例中,`auto.arima()`函数自动选择最佳的ARIMA模型参数,`forecast()`函数则利用该模型进行预测。之后,使用`plot()`函数可以生成一个预测结果的图示,以直观地显示预测值和置信区间。

# 4. R语言在专业领域的应用

## 4.1 生物信息学数据分析

### 4.1.1 基因表达数据的处理与分析

在生物信息学领域,基因表达数据的处理与分析是理解细胞功能和疾病机制的关键步骤。R语言在这一领域应用广泛,得益于其强大的生物统计和可视化包。

#### 基因表达数据的导入和处理

首先,需要将基因表达数据从各种格式(如CSV、TXT、GTF等)导入R。使用`read.table`或`read.csv`函数读取数据,并使用`apply`或`lapply`等函数进行初步的数据清洗。对于大规模基因表达数据集,建议使用`data.table`包提高数据读取和处理速度。

```r

# 导入基因表达数据

expression_data <- read.csv("path/to/expression_data.csv", row.names = 1)

# 处理缺失值,这里以填充0为例

expression_data[is.na(expression_data)] <- 0

# 使用data.table提高效率

library(data.table)

setDT(expression_data)

```

#### 基因表达数据分析

接下来,进行差异表达分析。常用的包有`limma`、`edgeR`和`DESeq2`。通过这些包,可以对实验组与对照组的基因表达差异进行统计检验,识别显著差异表达的基因。

```r

# 使用limma包进行差异表达分析

library(limma)

design <- model.matrix(~ 0 + group, data=colData)

colnames(design) <- levels(colData$group)

fit <- lmFit(expression_data, design)

contrast.matrix <- makeContrasts(group1 - group2, levels=design)

fit2 <- contrasts.fit(fit, contrast.matrix)

fit2 <- eBayes(fit2)

topTable(fit2, adjust="BH", sort.by="B")

```

#### 基因表达数据可视化

最后,对分析结果进行可视化展示。可使用`ggplot2`或`pheatmap`包来绘制热图、箱线图等图形,直观展示基因表达模式。

```r

# 基因表达热图绘制

library(pheatmap)

# 假设top_genes是差异表达分析后的基因列表

pheatmap(expression_data[top_genes, ])

```

### 4.1.2 生物序列的比对与注释

在分析基因表达数据的同时,经常需要进行生物序列的比对与注释,R语言中可以使用`Biostrings`包进行这一工作。

#### 序列比对

序列比对是在研究基因功能、进化关系和疾病关联时的关键步骤。使用`Biostrings`包,可以实现序列的快速比对。

```r

# 序列比对

library(Biostrings)

# 假设seq1和seq2为两个需要比对的序列

alignments <- pairwiseAlignment(seq1, seq2, type="global")

```

#### 序列注释

在序列比对之后,进行序列注释以便理解其功能。可以利用`biomaRt`包链接到在线数据库(如Ensembl)进行序列功能注释。

```r

# 使用biomaRt包进行序列注释

library(biomaRt)

mart <- useEnsembl(biomart="ensembl", dataset="hsapiens_gene_ensembl")

# 假设seqs为比对后的序列

annotation <- getBM(attributes=c('ensembl_gene_id', 'external_gene_name'),

filters='ensembl_gene_id',

values=seqs,

mart=mart)

```

## 4.2 金融数据分析

### 4.2.1 金融市场的量化分析方法

金融市场量化分析方法是金融工程和投资决策的重要组成部分。R语言在这一领域的应用同样表现突出。

#### 时间序列分析

金融市场数据是典型的时间序列数据,分析这类数据时可以使用`xts`包进行数据的索引和操作,以及使用`forecast`包进行时间序列预测。

```r

# 使用xts包处理金融时间序列数据

library(xts)

# 假设stock_data为股票数据

stock_xts <- xts(stock_data, order.by=as.Date(stock_data$date))

# 时间序列预测

library(forecast)

fit <- auto.arima(stock_xts[, "closing_price"])

forecast_result <- forecast(fit, h=10)

```

#### 投资组合优化

投资组合优化通常涉及资产配置与风险管理。可以通过`portfolio`包计算最优资产组合,使用`PerformanceAnalytics`包来评估投资组合表现。

```r

# 投资组合优化

library(portfolio)

# 假设returns为资产收益率数据

portfolio <- portfolio.spec(assets=colnames(returns))

portfolio <- add.constraint(portfolio, type="full_investment")

portfolio <- add.objective(portfolio, type="risk")

# 计算最优权重

opt_weights <- optimize.portfolio(R=returns, portfolio=portfolio)

# 投资组合表现评估

library(PerformanceAnalytics)

***pare(opt_weights, returns)

```

## 4.3 网络数据分析

### 4.3.1 社交网络的可视化

社交网络分析是研究社交网络结构和属性的一种方法,R语言提供了多种工具用于网络数据的可视化。

#### 网络数据处理

在进行社交网络分析之前,需要处理网络数据,通常转化为邻接矩阵或边列表形式。R的`igraph`包提供了广泛的功能用于网络数据的处理。

```r

# 使用igraph包处理网络数据

library(igraph)

# 假设edgelist为边列表数据

g <- graph.data.frame(edgelist, directed=F)

```

#### 社交网络的可视化

网络可视化对于理解网络结构至关重要。`igraph`包的`plot`函数可以直接绘制网络图。

```r

# 社交网络可视化

plot(g, vertex.size=degree(g)*2, edge.arrow.size=.2,

main="Social Network Visualization")

```

### 4.3.2 网络结构的统计分析

网络结构的统计分析通常涉及中心性指标的计算、模块划分等。

#### 中心性分析

中心性分析有助于识别网络中的关键节点。`igraph`包提供了多种中心性指标,如度中心性、接近中心性等。

```r

# 计算度中心性

degree_centrality <- degree(g)

```

#### 模块划分

模块划分可以帮助理解网络的社区结构。`igraph`包中的`cluster_fast_greedy`函数可以用来进行模块划分。

```r

# 模块划分

modules <- cluster_fast_greedy(g)

membership(modules)

```

以上章节介绍了R语言在生物信息学、金融分析、网络数据三个专业领域的应用。通过分析R语言的各个专业领域应用,可以深刻理解R在处理复杂数据问题时的强大功能和灵活性。

# 5. R语言项目实战与代码优化

在数据分析与处理领域,R语言的强大功能及其灵活性使得它成为许多专业领域不可或缺的工具。然而,随着项目复杂度的增加,对代码的效率、可维护性以及复用性的要求也随之提高。本章将探讨R语言在实际项目中的应用,并着重讲解如何优化代码性能以及R语言包的开发和维护。

## 5.1 大数据处理

在处理大规模数据集时,R语言表现出了令人瞩目的潜力。特别是其与Hadoop等大数据框架的集成,为复杂数据的分析提供了极大的便利。

### 5.1.1 使用R进行大数据预处理

预处理是数据分析中一个关键步骤,它包括数据清洗、格式转换、数据类型转换等多个方面。

```r

# 示例:使用readr和dplyr包预处理数据

library(readr)

library(dplyr)

# 导入数据

data <- read_csv("path/to/large_data.csv")

# 数据清洗:去除空值、重复数据

clean_data <- data %>%

filter(!is.na(column1)) %>%

distinct()

# 数据转换:更改数据类型

transformed_data <- clean_data %>%

mutate(column1 = as.factor(column1))

# 基于某列分组,计算每组的均值

grouped_data <- transformed_data %>%

group_by(column2) %>%

summarise(mean_value = mean(column3))

```

上述代码块展示了如何利用R语言的包来处理大数据集,包括数据导入、清洗、转换和分组聚合等步骤。

### 5.1.2 R与Hadoop的集成应用

R与Hadoop的集成允许R直接访问存储在HDFS(Hadoop Distributed File System)上的数据,无需进行数据迁移,从而处理更大规模的数据集。

```r

# 示例:使用RHadoop包执行MapReduce任务

library(rhdfs)

hdfs.init()

# 创建HDFS目录

hdfs.mkdir("/user/hadoop/data")

# 将数据上传到HDFS

hdfs.put("path/to/large_data.csv", "/user/hadoop/data/large_data.csv")

# 使用RHadoop的mapreduce函数

map <- function(k, v) {

# 数据分割和映射逻辑

}

reduce <- function(k, v) {

# 数据聚合逻辑

}

mapreduce(input = "/user/hadoop/data/large_data.csv",

input.format = "text",

map = map,

reduce = reduce)

```

此代码段展示了使用RHadoop包在HDFS上执行MapReduce任务的基本流程,从数据上传到HDFS开始,到定义map和reduce函数,最后执行MapReduce任务。

## 5.2 代码性能优化

随着数据量的增长,优化代码性能变得至关重要。以下是一些常见的性能优化方法。

### 5.2.1 代码重构技巧

代码重构是为了改善代码内部结构而不影响其外部行为。良好的代码结构能够提高代码的可读性、可维护性和性能。

```r

# 示例:使用apply族函数代替循环

# 不推荐的循环方式

for(i in 1:nrow(data)) {

data[i, "new_column"] <- data[i, "column1"] + data[i, "column2"]

}

# 推荐的apply方式

data$new_column <- apply(data[, c("column1", "column2")], 1, function(x) sum(x))

# 使用data.table包进一步优化

library(data.table)

setDT(data)[, new_column := sum(column1 + column2)]

```

通过使用R语言的apply族函数或者data.table包,可以有效地提高数据处理的性能,尤其是在大数据集上进行复杂操作时。

### 5.2.2 并行计算与性能提升方法

并行计算通过在多核处理器上同时执行计算任务,缩短程序运行时间。

```r

# 示例:使用parallel包进行并行计算

library(parallel)

# 模拟计算密集型任务

calc_function <- function(x) {

Sys.sleep(1) # 模拟耗时计算

x^2

}

# 生成数据集

x <- 1:1000

# 串行计算

serial_result <- sapply(x, calc_function)

# 并行计算,设定4个核

cluster <- makeCluster(4)

clusterExport(cluster, "calc_function")

parallel_result <- parSapply(cluster, x, calc_function)

stopCluster(cluster)

```

通过创建集群和分配任务到多个核上执行,可以显著减少程序运行时间。并行计算是大数据处理和复杂模型训练中常用的技术。

## 5.3 R语言包开发与维护

开发R包不仅可以提高工作效率,还可以为社区做出贡献。

### 5.3.1 R包的创建与文档编写

创建一个R包需要遵循一系列规范,包括编写文档、单元测试以及确保代码质量和遵循CRAN的政策。

```r

# 示例:使用devtools创建R包

# 在R包根目录运行

use_r("function_name")

document()

build()

```

使用`devtools`包能够简化R包的创建和文档编写过程。`use_r()`函数用于创建函数的R文件,`document()`用于生成文档,`build()`用于构建包。

### 5.3.2 包的版本控制与社区贡献

对R包进行版本控制可以更好地管理代码变化,而参与社区贡献则能促进代码改进和错误修正。

```r

# 示例:使用git进行版本控制和GitHub进行协作

# 在R包根目录运行

git init

git add .

git commit -m "Initial commit"

# 在GitHub上创建新仓库并关联

# git remote add origin ***

```

通过在GitHub上托管代码并使用git进行版本控制,可以方便地进行代码协作和维护。社区成员可以通过pull request对R包进行贡献。

以上章节内容围绕R语言项目实战与代码优化提供了深入的探讨,从大数据处理到代码性能优化,再到R语言包的开发和维护,每一个环节都旨在提升工作效率和代码质量。通过本章的学习,读者将能够更加专业地运用R语言解决复杂的数据分析问题,并在专业领域内作出有效的贡献。

0

0