【PCA全面掌握】:从理论基础到实际案例的主成分分析详解

SVD_PCA_主成分分析_相关资料大全.zip

摘要

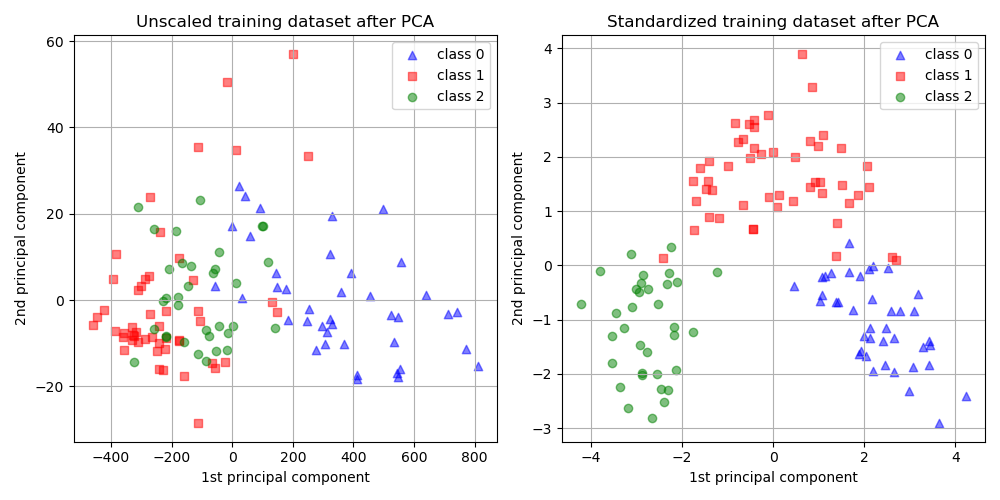

主成分分析(PCA)是一种广泛应用于数据降维和特征提取的统计技术。本文旨在详细阐述PCA的理论基础、数学原理及其在编程实现中的具体应用。首先介绍PCA的理论背景,然后深入探讨其数学原理,包括线性代数的相关应用、主成分提取过程以及降维逻辑。接下来,文章通过实际编程案例,展示如何利用Python和R语言实现PCA,并介绍了一些高级技巧,例如稀疏PCA、增量PCA和核PCA。最后,文章通过多个应用案例,例如生物信息学、金融市场分析和图像处理,展示了PCA的实际效用。同时,对PCA的局限性进行了分析,并提出了改进策略。本文旨在为读者提供一个全面的PCA学习和应用指南。

关键字

主成分分析;数据降维;特征提取;Python;R语言;生物信息学

参考资源链接:eviews中主成分分析和因子分析详解PPT学习教案.pptx

1. 主成分分析(PCA)的理论基础

在现代数据分析领域,主成分分析(PCA)是一种被广泛运用的统计技术,用以揭示数据中的内在结构。通过PCA,可以将原始数据集转换为一组线性不相关的变量,称为主成分。这些主成分按照方差大小排序,方差越大的主成分,其包含的信息量越多。PCA的理论基础在于,尽管原始数据可能具有多个变量,但这些变量间往往存在一定程度的相关性,PCA能够提取出这些隐含的模式,简化数据结构,同时尽量保留原始数据的重要信息。

PCA的这种降维特性使其在处理大数据集时变得非常有用,因为它可以减少计算量,简化模型复杂度,并有助于数据的可视化。然而,理解和正确应用PCA需要一定的数学和统计学基础,尤其是对协方差矩阵的理解。通过本章节的学习,读者将对PCA的理论基础有一个全面的认识,并为后续深入探讨PCA的数学原理和应用打下坚实的基础。

2. PCA的数学原理与计算方法

2.1 线性代数在PCA中的应用

2.1.1 特征值和特征向量的介绍

在PCA的计算过程中,理解特征值和特征向量是至关重要的。特征值和特征向量的概念源于线性代数,它们在PCA中用于确定数据集的方向和大小,这些方向和大小对应于数据的方差。

特征值表示的是一个线性变换后,某个向量的长度变化倍数。当我们对数据集进行协方差矩阵分析时,我们可以找到使得数据方差最大化的方向,这些方向就是特征向量,而相应的变化倍数就是特征值。

线性代数的定义可以表述为对于方阵A和非零向量x,如果存在标量λ,使得方程Ax = λx成立,那么标量λ称为矩阵A的一个特征值,非零向量x称为对应的特征向量。

2.1.2 协方差矩阵的计算与意义

PCA的一个核心步骤是计算数据集的协方差矩阵。协方差矩阵表示了数据集中各个变量之间的相关性,其元素是各个变量之间的协方差。如果两个变量正相关,则它们的协方差为正;如果是负相关,则为负;如果没有相关性,则协方差为零。

在数学上,如果有一个数据集X,其包含n个样本和m个特征,那么协方差矩阵C可以表示为:

[ C = \frac{1}{n-1} X^T X ]

其中,( X^T )是数据集X的转置。计算协方差矩阵可以理解为是将数据中心化后计算每两个特征之间的相关性。

协方差矩阵的意义在于它揭示了不同特征之间的相互影响。在PCA中,我们通过计算数据的协方差矩阵,然后寻找使得数据方差最大的方向,这个方向就是第一主成分。

2.2 主成分的提取过程

2.2.1 方差最大化的解释

PCA的目标是找到一组新的变量,这些变量是原始变量的线性组合,并且每个新变量都尽可能地包含原始数据的信息。为了衡量信息的多少,我们使用方差作为标准,因为方差越大,包含的信息越多。

方差最大化的解释在于,首先,PCA通过提取主成分的方式,尝试捕捉数据的最大方差,因为方差越大,说明在这个方向上数据的分布越散,包含了越多的信息。其次,数据的前几个主成分通常能够解释数据大部分的方差,这意味着使用较少的主成分就可以描述数据的大部分特征,从而达到降维的效果。

2.2.2 主成分的计算步骤详解

要计算主成分,我们首先需要对数据集进行中心化处理,即将数据集中的每个特征减去其均值。中心化处理后,计算协方差矩阵,接着求解协方差矩阵的特征值和特征向量。

具体计算步骤如下:

- 中心化数据:对每个特征减去其均值。

- 计算协方差矩阵C。

- 求解特征值和特征向量:解特征方程 ( |C - \lambda I| = 0 ) 求得特征值 ( \lambda ) 和对应的特征向量 ( v )。

- 选取最大的特征值对应的特征向量作为主成分,这些向量构成了数据的新坐标系。

2.3 PCA的降维逻辑

2.3.1 降维的必要性与优势

随着数据集维度的增加,问题也会随之增加,例如所谓的“维度的诅咒”。降维可以帮助我们减轻计算负担,简化模型结构,并可能提高模型的预测性能。

降维的必要性在于减少数据集中的冗余信息,降低存储和处理数据所需的资源。降维还可以帮助提高模型的泛化能力,减少过拟合的风险。

降维的优势包括:

- 信息简化:去除不重要的特征,保留最重要的信息。

- 可视化:将高维数据映射到二维或三维空间,便于观察和解释。

- 噪声减少:高维数据可能包含大量噪声,降维有助于剔除噪声。

- 计算效率提升:低维数据处理起来更快,消耗的计算资源更少。

2.3.2 如何选择主成分的数量

在PCA中选择主成分的数量是一个关键步骤。一个好的主成分数量既能捕捉到数据的主要特征,又能去除噪声和冗余信息。

选择主成分数量的常用方法包括:

- 累积方差贡献率:基于特征值计算每个主成分的方差贡献率,然后选取累积方差贡献率达到某个阈值(如95%)的主成分。

- 特征值门槛:选取特征值大于1的主成分,因为特征值表示的是方差,大于1意味着该主成分的信息量大于平均信息量。

- 拐点法:绘制一个特征值(或方差贡献率)按主成分排序的图,选取曲线的拐点作为主成分的数目。

选择主成分数量时还需要考虑实际应用场景,比如在数据可视化中,通常选择2到3个主成分;而在特征提取中,可能会根据具体模型的需求选择更多的主成分。

3. PCA的编程实现

3.1 使用Python实现PCA

3.1.1 利用NumPy和SciPy库进行PCA

Python语言由于其简洁易懂的特点,在数据分析和机器学习领域中被广泛采用。在实现PCA时,我们可以利用NumPy和SciPy这两个强大的数学库。NumPy是一个用于科学计算的基础库,而SciPy则提供了更多高级的科学计算功能。在进行PCA之前,我们首先需要安装这两个库(如果尚未安装)。

下面是一个使用NumPy和SciPy库进行PCA的基本步骤:

- 导入所需的库。

- 对数据进行预处理,包括中心化和标准化。

- 计算数据的协方差矩阵。

- 计算协方差矩阵的特征值和特征向量。

- 根据特征值的大小对特征向量进行排序,并选择主要的特征向量。

- 将特征向量转换成一个转换矩阵。

- 使用这个转换矩阵将原始数据投影到新的特征空间。

让我们用一段代码来展示这一过程:

- import numpy as np

- from numpy.linalg import eigh

- from scipy.linalg import svd

- def pca(X, num_components):

- # 数据预处理:中心化数据

- X_mean = np.mean(X, axis=0)

- X_norm = X - X_mean

- # 使用协方差矩阵

- cov_matrix = np.cov(X_norm, rowvar=False)

- # 计算特征值和特征向量

- eigenvalues, eigenvectors = eigh(cov_matrix)

- # 对特征值进行降序排序

- eigenvalues_sorted = np.argsort(eigenvalues)[::