【Fork_Join框架深度解析】:任务分解与合并的高级策略(多核处理器优化指南)

发布时间: 2024-09-24 22:21:05 阅读量: 79 订阅数: 28

探索Java并发:Future与ForkJoin框架深度解析

# 1. Fork_Join框架概述

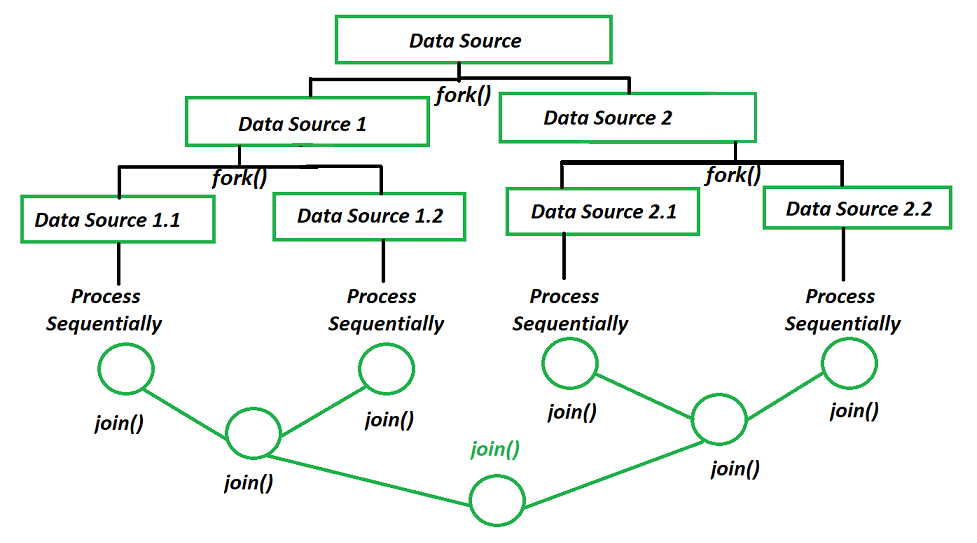

在现代的软件开发过程中,尤其是在处理大量计算任务时,有效地利用多核处理器的能力成为了一个关键点。**Fork_Join** 框架是在Java 7中引入的一个用于并行执行任务的框架,其核心思想是将一个大任务分解为多个小任务,递归地进行分解,直到这些小任务足够简单,可以直接执行,而后再将这些简单任务的结果合并起来得到最终结果。

Fork_Join框架通过工作窃取算法来提高处理器核心的利用率,即使某些核心的任务比其他核心多,也能保证所有核心都有活可干。这种机制特别适合于那些可以被递归拆分的任务,如树的遍历,图的搜索,或者任何可以自然分割为较小任务的工作。

在本章中,我们将探索Fork_Join框架的基本概念,介绍它的工作原理,并了解为什么它在多核处理器上比传统的串行算法更有效。我们还将讨论如何在多核环境中实现和优化Fork_Join框架,以及它如何帮助开发者利用现代处理器的强大计算能力来提升应用性能。

# 2. Fork_Join框架的理论基础

### 2.1 Fork_Join框架的工作原理

#### 2.1.1 工作窃取算法的原理

工作窃取算法是一种负载平衡技术,用于在多处理器环境中高效地分配任务。Fork_Join框架利用这一算法将任务分配给线程,并允许空闲线程从其他忙碌线程的任务队列中窃取任务来执行。这种策略的优势在于它能够在任务执行过程中动态地平衡负载,减少了线程闲置时间,提升了CPU的利用率。

工作窃取算法通常包含以下几个步骤:

1. **任务分配**:启动时,将待执行的任务平均分配给各个线程。

2. **任务执行**:每个线程处理自己队列中的任务。

3. **任务窃取**:当线程完成自己队列中的所有任务后,它会去其他线程的队列尾部窃取任务来执行,而不是等待新的任务分配。

4. **任务完成**:所有任务处理完毕后,线程可以进入空闲状态或者帮助其他线程。

```java

class WorkStealingQueue {

private final Deque<Runnable> queue = new ArrayDeque<>();

Runnable take() {

if (queue.isEmpty()) {

return null;

}

return queue.removeLast();

}

void push(Runnable task) {

queue.offer(task);

}

boolean isEmpty() {

return queue.isEmpty();

}

}

```

上面的Java代码示例展示了工作窃取队列的基本操作。队列使用双端队列(Deque),当队列为空时,尝试窃取的线程将得到null,表明没有任务可执行。

#### 2.1.2 任务分解策略

在Fork_Join框架中,任务分解是并行处理的基础。分解策略的合理性直接影响并行化的效果。通常有两种分解策略:

1. **递归分解**:这种策略适合于具有自然递归性质的任务,比如文件系统的遍历。任务在执行时,会将自身拆分为多个子任务,然后递归地执行这些子任务。

```java

if (task.isSmallEnough()) {

computeDirectly(task);

} else {

ForkJoinTask<SomeType> leftSubtask = task.splitOffLeft();

ForkJoinTask<SomeType> rightSubtask = task.splitOffRight();

invokeAll(leftSubtask, rightSubtask);

}

```

在这个例子中,如果任务足够小,它将直接被计算;否则,任务将被分解为两个子任务,然后并行处理。

2. **迭代分解**:这种方法通常用于那些不易直接递归分解的任务。在每次迭代中,任务将自己的一部分工作分解出去作为新的子任务。

#### 2.1.3 任务合并机制

任务合并是Fork_Join框架中尤为重要的一步,它保证了并行处理的正确性和效率。任务合并通常发生在所有子任务完成之后,父任务需要汇总子任务的结果来形成最终结果。

任务合并涉及到结果的收集和整合,这通常通过递归地调用子任务的`join`方法来完成。`join`方法会阻塞调用它的线程,直到相应的任务完成。下面的代码展示了如何合并子任务的结果:

```java

public class TaskResult {

// 任务结果的数据结构

}

public TaskResult compute() {

if (isLeaf()) {

return computeDirectly();

}

TaskResult result = new TaskResult();

List<ForkJoinTask<TaskResult>> forks = new ArrayList<>();

// 创建并启动子任务

for (SomeType subtask : createSubtasks()) {

ForkJoinTask<TaskResult> fork = new ForkJoinTask<>() {

public TaskResult compute() {

***pute();

}

};

forks.add(fork);

}

for (ForkJoinTask<TaskResult> fork : forks) {

// 等待子任务完成,并合并结果

result.merge(fork.join());

}

return result;

}

```

通过上述过程,父任务能够等待所有子任务的完成,并且通过`merge`方法将它们的结果统一起来。

### 2.2 多核处理器的任务调度优化

#### 2.2.1 处理器核心与任务分配策略

在多核处理器上,合理地分配任务到每个核心能够显著提升程序的执行效率。Fork_Join框架利用工作窃取算法来处理任务分配问题,这种策略对任务的分配不需要预先知道任务的数量和大小,从而提高了框架的通用性和灵活性。

任务分配时,如果处理器核心的数量固定,那么理想的状况是每个核心都能得到相等数量的任务。但在实际运行中,由于任务的执行时间不一致,某些核心可能会先完成任务,此时它就会去窃取其他核心的任务,以避免空闲。

```mermaid

graph TD;

A[开始分配任务] --> B[确定核心数N];

B --> C{核心完成情况};

C -->|未完成| D[继续执行任务];

C -->|已空闲| E[窃取其他核心任务];

D --> C;

E --> C;

```

上面的流程图展示了处理器核心与任务分配的基本过程。每个核心在完成自己的任务后,如果没有任务则选择窃取其他核心的任务。

#### 2.2.2 任务调度的理论模型

任务调度的理论模型对理解任务如何在处理器之间流动提供了理论依据。一个典型的模型是“调度器-处理器模型”,其中调度器负责任务的分配和管理,处理器则执行任务。

在Fork_Join框架中,任务调度模型的主要特点如下:

- **非抢占式调度**:任务一旦开始执行,直至完成,不会被中断。

- **动态调度**:任务在运行时动态分配和重新分配。

- **工作窃取机制**:任务调度的关键,决定着任务的动态分配策略。

调度器通常会将任务放入任务队列中,并由处理器从中取出任务执行。当处理器空闲时,它会尝试从其他处理器的队列中窃取任务。

#### 2.2.3 任务并行性与性能平衡

为了获得最佳的性能,需要在任务的并行性与处理器的利用率之间找到平衡点。如果并行度过高,可能会导致过多的任务创建和管理开销,而过低的并行度又不能充分利用处理器资源。

Fork_Join框架通过动态地调整任务的粒度和数量来实现这种平衡。当任务的粒度很小时,线程可以快速地完成任务,从而减少等待和窃取其他任务的时间。当任务的粒度较大时,可以减少任务创建和管理的开销。

Fork_Join框架通过以下机制来实现任务粒度的动态调整:

- **任务预分割**:在任务执行前,预估任务的执行时间和大小,从而决定是否需要进一步分割。

- **运行时监控**:在程序运行时监控任务的执行情况,根据任务的实际运行时间来调整后续任务的分割策略。

通过合理配置任务并行性和处理器的利用率,Fork_Join框架能够在保证性能的同时,提高多核处理器的总体效率。

# 3. Fork_Join框架的实践应用

Fork_Join框架是Java并发库中的重要成员,它通过工作窃取算法实现了高效的并行处理,特别适用于可以递归拆分的任务。在本章节中,我们将深入探讨Fork_Join框架在实际应用中的编程实践和性能优化。

## 3.1 Fork_Join框架的编程实践

### 3.1.1 Fork_Join框架的基本用法

Fork_Join框架的使用分为两个主要步骤:任务的拆分(Fork)和任务的合并(Join)。框架提供了一个抽象的 ForkJoinPool 类,用来执行任务并管理线程。下面是使用Fork_Join框架的基本步骤:

1. 创建一个 ForkJoinPool 实例。

2. 创建一个继承自 RecursiveTask 或 RecursiveAction 的任务类。

3. 将任务提交给 ForkJoinPool 执行。

以下是一个简单的示例代码,用于计算1到1000的所有整数之和:

```java

import java.util.concurrent.RecursiveTask;

import java.util.concurrent.ForkJoinPool;

class SumTask extends RecursiveTask<Integer> {

private int start, end;

SumTask(int start, int end) {

this.start = start;

this.end = end;

}

@Override

protected Integer compute() {

if (end - start < 10) { // 如果任务足够小,则直接计算结果

return sum(start, end);

} else {

int mid = (start + end) / 2;

SumTask task1 = new SumTask(start, mid);

SumTask task2 = new SumTask(mid + 1, end);

task1.fork(); // 将任务拆分并放入队列

int result2 = ***pute(); // 同步执行另一个任务

int result1 = task1.join(); // 等待第一个任务的结果

return result1 + result2; // 合并结果

}

}

private int sum(int start, int end) {

int sum = 0;

for (int i = start; i <= end; i++) {

sum += i;

}

return sum;

}

}

public class ForkJoinExample {

public static void main(String[] args) {

ForkJoinPool pool = new ForkJoinPool();

SumTask task = new SumTa

```

0

0