【线程安全集合解析】:理解并发集合的内部原理(多线程编程必备)

发布时间: 2024-09-24 21:39:48 阅读量: 55 订阅数: 27

# 1. 线程安全集合的概念与重要性

在多线程编程领域,线程安全是确保程序稳定性和正确性的一个核心概念。线程安全集合能够避免在多线程环境下的数据竞争和条件竞争,提供一种安全的方式来管理和存储共享数据。理解线程安全集合的概念对于构建健壮的并发程序至关重要,不仅能够提升程序的可靠性,还能提高开发效率和后期的维护能力。本章将深入探讨线程安全集合的基本定义,其背后的必要性,以及在现代软件开发中扮演的关键角色。通过理论与实践相结合的方式,帮助读者对线程安全集合形成全面而深刻的认识。

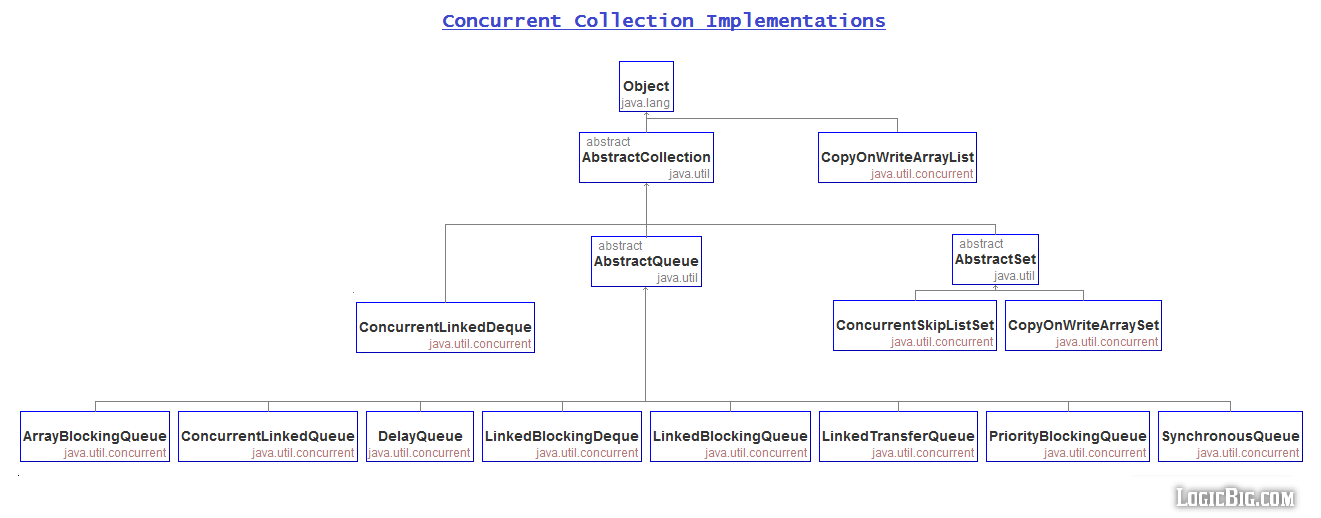

# 2. Java中的线程安全集合类

## 2.1 同步集合与并发集合的对比

### 2.1.1 同步集合的工作原理

在Java中,同步集合主要通过在集合的方法上加锁(synchronized keyword)来实现线程安全。这意味着当一个线程访问同步集合的任何方法时,其他线程都必须等待,直到第一个线程完成方法的执行。这种方式简单粗暴,但效率低下,因为它不允许任何并发执行,即使多个线程访问集合的不同部分。

下面是一个简单的示例,展示如何将ArrayList转换为同步List:

```java

List<E> syncList = Collections.synchronizedList(new ArrayList<>());

```

### 2.1.2 并发集合的优势与应用场景

并发集合,如ConcurrentHashMap和CopyOnWriteArrayList,采用了更高级的线程安全机制,允许在没有显式外部同步的情况下进行并发访问。其核心思想是减少锁的粒度,避免不必要的阻塞。例如,ConcurrentHashMap通过分段锁(Segmentation Locks)实现,而CopyOnWriteArrayList则在每次修改时复制整个数组。

并发集合特别适用于读多写少的场景,因为它们可以提供更高的并发度,同时保持相对较高的性能。在数据结构上的读写操作不互相阻塞,大大提高了程序的并发能力。

## 2.2 线程安全的Map实现

### 2.2.1 HashMap与ConcurrentHashMap的内部结构

HashMap是非线程安全的,它在Java中广泛用于需要快速访问键值对的场景。然而,在多线程环境下,需要使用线程安全的替代品,如ConcurrentHashMap。ConcurrentHashMap采用了一种分段锁策略,将数据分为多个段,每个段独立锁定,以支持并行访问。

ConcurrentHashMap的内部结构示意如下:

```mermaid

graph TD

A[ConcurrentHashMap] --> B[Segment 0]

A --> C[Segment 1]

A --> D[Segment n]

B --> E[Hash Bucket]

B --> F[Hash Bucket]

C --> G[Hash Bucket]

C --> H[Hash Bucket]

D --> I[Hash Bucket]

D --> J[Hash Bucket]

```

### 2.2.2 HashTable与ConcurrentSkipListMap的对比分析

HashTable是Java早期提供的线程安全的Map实现,但它使用单一的锁,因此在高并发下的性能较差。ConcurrentSkipListMap则是一种更先进的线程安全的Map实现,它在Java 6中引入,使用了一种称为跳跃表的结构。ConcurrentSkipListMap不仅可以保持键的排序,还支持高效的并发访问。

比较HashTable和ConcurrentSkipListMap的关键特性:

| 特性 | HashTable | ConcurrentSkipListMap |

|--------------|--------------------------|---------------------------|

| 线程安全性 | 线程安全 | 线程安全 |

| 内部结构 | 散列表 | 跳跃表 |

| 锁策略 | 单一锁 | 分段锁,跳跃表的锁粒度控制 |

| 并发度 | 低 | 高 |

| 排序保证 | 无 | 有(按自然顺序或自定义) |

| 性能 | 低(高并发时) | 高(高并发时) |

## 2.3 线程安全的List实现

### 2.3.1 ArrayList与CopyOnWriteArrayList的对比

ArrayList是非线程安全的,当多个线程同时对其进行修改时,可能会出现数据不一致的问题。CopyOnWriteArrayList是一种线程安全的List实现,它在每次修改操作时都会创建底层数组的一个新副本,这样就避免了锁的使用,提供了一种写时复制(Copy-On-Write)的并发策略。

CopyOnWriteArrayList的主要优势在于读操作可以无锁进行,因此在读多写少的场景中表现优异。

### 2.3.2 Vector与Collections.synchronizedList的使用与限制

Vector是Java中的另一个线程安全的List实现,使用synchronized关键字来保证线程安全。它和ArrayList类似,只是所有的公共方法都通过synchronized关键字同步。然而,这种方式使得Vector在高并发情况下性能不佳,因为它不允许对集合的不同部分进行并发访问。

Collections.synchronizedList则是一种包装器,它将普通的List包装成线程安全的List。这种做法同样需要外部同步,通常不推荐在并发访问时使用。

## 2.4 线程安全的Set实现

### 2.4.1 HashSet与CopyOnWriteArraySet的比较

HashSet是非线程安全的,它基于HashMap实现,用于存储唯一元素。当需要线程安全的HashSet时,可以使用CopyOnWriteArraySet,它基于CopyOnWriteArrayList,适用于读多写少的场景。CopyOnWriteArraySet在每次修改操作时复制整个底层数组,避免了锁的使用,但增加了内存开销。

### 2.4.2 LinkedHashSet与ConcurrentSkipListSet的特性

LinkedHashSet保持了元素的插入顺序,它基于LinkedHashMap实现。在需要线程安全的LinkedHashSet时,可以考虑使用CopyOnWriteArraySet,或者保持List和Set的组合使用,但这会牺牲一些性能。ConcurrentSkipListSet使用跳跃表的结构来保持元素的排序,并且是线程安全的,适用于需要排序和高并发访问的场景。

# 3. 线程安全集合的使用与实践

## 3.1 线程安全集合的性能考量

### 3.1.1 读写性能对比与基准测试

在Java中,线程安全集合的设计目标是提供在多线程环境中稳定运行的能力,同时保持高效率。性能考量是选择合适线程安全集合类时的关键因素。不同线程安全集合在读写性能上存在差异,这需要通过基准测试来量化。

#### 基准测试示例

```java

import org.openjdk.jmh.annotations.Benchmark;

import org.openjdk.jmh.annotations.BenchmarkMode;

import org.openjdk.jmh.annotations.Mode;

import org.openjdk.jmh.annotations.OutputTimeUnit;

import org.openjdk.jmh.annotations.Scope;

import org.openjdk.jmh.annotations.State;

import org.openjdk.jmh.infra.Blackhole;

import java.util.concurrent.ConcurrentHashMap;

import java.util.concurrent.ConcurrentSkipListMap;

import java.util.concurrent.CopyOnWriteArrayList;

import java.util.concurrent.TimeUnit;

@BenchmarkMode(Mode.AverageTime)

@OutputTimeUnit(TimeUnit.NANOSECONDS)

@State(Scope.Benchmark)

public class CollectionBenchmark {

private ConcurrentHashMap<String, String> concurrentHashMap;

private ConcurrentSkipListMap<String, String> concurrentSkipListMap;

private CopyOnWriteArrayList<String> copyOnWriteArrayList;

private ArrayList<String> arrayList;

@Setup(Level.Invocation)

public void setUp() {

concurrentHashMap = new ConcurrentHashMap<>();

concurrentSkipListMap = new ConcurrentSkipListMap<>();

copyOnWriteArrayList = new CopyOnWriteArrayList<>();

arrayList = new ArrayList<>();

}

@Benchmark

public void testConcurrentHashMap(Blackhole blackhole) {

// 测试写操作

concurrentHashMap.put("key", "value");

blackhole.consume(concurrentHashMap);

}

@Benchmark

public void testConcurrentSkipListMap(Blackhole blackhole) {

// 测试读操作

concurrentSkipListMap.get("key");

blackhole.consume(concurrentSkipListMap);

}

@Benchmark

public void testCopyOnWriteArrayList(Blackhole blackhole) {

// 测试读操作

copyOnWriteArrayList.get(0);

blackhole.consume(copyOnWriteArrayList);

}

@Benchmark

public void testArrayList(Blackhole blackhole) {

// 测试写操作

arrayList.add("value");

blackhole.consume(arrayList);

}

}

```

在上面的基准测试中,我们使用了JMH(Java Microbenchmark Harness)来测试 `ConcurrentHashMap` 和 `ConcurrentSkipListMap` 的读写性能,以及 `CopyOnWriteArrayList` 和 `ArrayList` 的读写性能。通过比较这些操作的执行时间,我们可以得出在不同场景下哪种集合类性能更优。

#### 读写性能分析

在高并发写入场景下,`ConcurrentHashMap` 的性能通常优于 `ConcurrentSkipListMap`,因为它采用了更细粒度的锁。然而,在读取密集型场景中,`ConcurrentSkipListMap` 提供了有序性保证,其读性能可能更优。

`CopyOnWriteArrayList` 在读操作性能上表现良好,因为它提供了不可变的视图。但是,每次修改操作都会导致整个列表的复制,所以在写操作频繁的情况下,其性能会显著下降。

### 3.1.2 并发集合在不同环境下的性能影响

线程安全集合的性能并非在所有环境下都保持一致。内存大小、CPU核心数量、垃圾回收策略和JVM版本等因素都会对并发集合的性能产生影响。

#### 性能影响因素分析

- **内存大小**:集合的大小可以显著影响性能。内存越大,集合操作时越不容易触发GC(垃圾回收),从而减少延迟。

- **CPU核心数**:CPU核心数的增加可以提高并行操作的性能。在多核心系统中,使用并发集合可以充分利用多核心的优势。

- **垃圾回收策略**:不同的GC算法和参数设置会对性能产生不同的影响。例如,G1垃圾回收器通常在大规模应用中表现更佳。

- **JVM版本**:随着JVM的不断优化,不同版本的JVM对并发集合的性能支持也有所不同。

#### 环境性能测试建议

在对线程安全集合进行性能评估时,应当模拟生产环境的配置和负载情况,从而得出更加准确的性能指标。同时,考虑到JVM的性能调优潜力,合理配置JVM参数也是优化性能的重要步骤。

## 3.2 高级并发集合特性解析

### 3.2.1 并发集合的原子操作与并发度控制

并发集合的原子操作确保了多线程环境下的线程安全,而并发度控制则涉及到集合内部线程争用资源的优化。

#### 原子操作与CAS

并发集合中的原子操作通常依赖于比较并交换(CAS)指令,CAS是一种硬件级别的原子操作,它可以在不使用锁的情况下进行变量的更新。

```java

public class AtomicReferenceExample {

private AtomicReference<String> atomicReference = new AtomicReference<>("Initial Value");

public void updateValue(String newValue) {

***pareAndSet("Initial Value", newValue);

}

public String getValue() {

return atomicReference.get();

}

}

```

#### 并发度控制

并发集合如 `ConcurrentHashMap` 允许用户控制并发级别,这是通过 `concurrencyLevel` 参数来实现的。并发级别决定了内部的Segment(分段锁结构)的数量,可以影响到并发操作的粒度和性能。

```java

ConcurrentHashMap<String, String> conMap = new ConcurrentHashMap<>(16, 0.75f, 16);

```

### 3.2.2 分段锁与锁粒度精细控制的原理与实现

分段锁技术是降低锁竞争的有效方法,它将集合分成多个段,每个段独立锁定,从而提高并发度。

#### 分段锁的原理

分段锁将数据划分为多个段,每个段独立维护自己的锁。这样,当多个线程访问不同段的数据时,就不会发生锁竞争,从而提高了并发性。

```java

public class SegmentLockExample {

private final HashMap<String, String>[] segments;

public SegmentLockExample(int concurrencyLevel) {

int segmentSize = (int) Math.ceil(1.0 / concurrencyLevel);

segments = new HashMap[segmentSize];

for (int i = 0; i < segmentSize; i++) {

segments[i] = new HashMap<>();

}

}

public void put(String key, String value) {

int index = key.hashCode() % segments.length;

synchronized (segments[index]) {

segments[index].put(key, value);

}

}

public String get(String key) {

int index = key.hashCode() % segments.length;

synchronized (segments[index]) {

return segments[index].get(key);

}

}

}

```

#### 锁粒度控制的实现

在 `ConcurrentHashMap` 中,锁粒度的控制是通过设置初始容量和并发级别来实现的。初始容量和并发级别决定了分段的数量。锁粒度的精细控制能够在保证线程安全的同时,尽可能地减少锁的争用,从而提升性能。

## 3.3 线程安全集合的故障排除

### 3.3.1 常见并发错误的诊断方法

在使用线程安全集合时,可能会遇到死锁、活锁、资源饥饿等问题。正确诊断这些问题对于优化性能和解决故障至关重要。

#### 死锁的诊断

死锁是指两个或多个线程在执行过程中,因争夺资源而造成的一种僵局。为了避免死锁,需要确保资源的有序获取和释放。

```java

public class DeadlockDetection {

private final Object lock1 = new Object();

private final Object lock2 = new Object();

public void potentiallyDeadlockingMethod() {

synchronized (lock1) {

try {

Thread.sleep(100);

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

synchronized (lock2) {

// Do work with both locks

}

}

}

}

```

为了避免死锁,应该始终遵循先获取所有需要的锁的固定顺序,或者使用锁的超时机制,使得线程在等待锁时不至于无限期阻塞。

#### 资源饥饿的诊断

资源饥饿通常是由于高优先级线程长时间占用资源而导致其他线程无法及时获取资源。解决资源饥饿问题,可以通过设置线程的优先级或者限制高优先级线程的资源占用时间。

### 3.3.2 解决并发集合引发的死锁和性能问题

解决并发集合引发的死锁和性能问题需要结合代码审查、性能监控和故障排查工具。

#### 解决死锁问题

利用JVM提供的工具如JConsole或VisualVM可以发现潜在的死锁。当检测到死锁时,需要审查相关的代码段,确保资源获取的顺序一致性和加锁的必要性。

```java

public class DeadlockFreeExample {

private final Object lockA = new Object();

private final Object lockB = new Object();

public void safeMethod() {

synchronized (lockA) {

synchronized (lockB) {

// Perform operations that need both locks

}

}

}

}

```

#### 解决性能问题

对于性能问题,除了通过基准测试来量化之外,还需要使用分析工具如JProfiler或YourKit来对运行中的应用程序进行性能分析。

当发现性能瓶颈时,针对瓶颈进行优化,例如优化锁的粒度、减少锁的范围,或者考虑使用无锁的数据结构和算法。

## 总结

本章节深入探讨了线程安全集合的使用和实践。我们从性能考量开始,了解了读写性能对比和基准测试的重要性。随后,我们分析了高级并发集合特性的内部机制,包括原子操作、分段锁技术以及如何通过调整并发度来提升性能。

故障排除部分介绍了如何诊断和解决并发集合中的死锁和性能问题,强调了进行代码审查、监控和使用分析工具的重要性。理解这些概念和技巧将帮助开发者有效地利用线程安全集合,构建健壮且高性能的应用程序。

# 4. 深入理解线程安全集合的内部原理

## 4.1 并发集合的数据结构解析

### 4.1.1 分段锁技术与数据分布策略

并发集合中的分段锁技术是解决多线程数据访问冲突的一种有效策略。通过将集合分割成若干个段(Segment),每个段独立地进行加锁操作,可以减少锁的粒度,从而提高系统的并发能力和效率。比如在`ConcurrentHashMap`中,整个哈希表被划分为16个段,每个段有自己的独立锁。

```java

ConcurrentHashMap<String, Integer> map = new ConcurrentHashMap<>();

map.put("key", 1);

```

在上述例子中,`ConcurrentHashMap`使用了分段锁技术。当执行`put`操作时,会根据key的哈希值将数据映射到特定的段上,并对该段加锁。这样,即使多个线程同时操作不同的段,也不会相互影响,因为它们持有了不同的锁对象。

分段锁背后的数据分布策略是关键。在`ConcurrentHashMap`中,这种策略依赖于一个哈希表结构,其中包含了多个元素和对应段的引用。在初始化时,这些段可以动态地创建和调整大小,以适应数据的增减和分布。

### 4.1.2 内存模型与线程安全保证机制

在Java内存模型(JMM)中,线程安全集合必须遵循一些规则来保证在多线程环境下的正确性和一致性。这包括使用volatile关键字保证变量的可见性,使用final关键字确保初始化安全,以及使用同步代码块或方法来保证操作的原子性。

以`ConcurrentHashMap`为例,它使用了volatile关键字来修饰其内部的一些关键字段。这确保了在多线程环境中,当一个线程修改了这些字段,其他线程能够立即看到这些修改。另外,它也使用了复杂的内存屏障(Memory Barriers)技术,以及底层的CAS(Compare-And-Swap)操作来保证更新操作的原子性。

```java

transient volatile Node<K,V>[] table;

```

在这个例子中,`table`数组是`ConcurrentHashMap`的主数组,它被声明为volatile类型。这意味着任何对`table`数组的修改都是对所有线程立即可见的,这对于并发集合来说是非常关键的。

## 4.2 非阻塞与乐观锁机制在集合中的应用

### 4.2.1 无锁数据结构的原理与优势

无锁数据结构是通过硬件指令保证操作的原子性,避免了锁带来的性能开销。其核心思想是利用CAS操作来实现读-改-写操作,而不需要阻塞等待。乐观锁(Optimistic Locking)是无锁技术的一种,它假设数据的更新冲突很少发生,在数据被多个线程共享时,每个线程在进行更新操作前检查数据是否被其他线程修改过。

```java

AtomicInteger atomicInt = new AtomicInteger(0);

int value = atomicInt.get();

do {

// optimistic assumption

} while (!***pareAndSet(value, value + 1));

```

在这个例子中,`AtomicInteger`使用了CAS操作来实现线程安全的增加操作。当多个线程尝试修改同一个值时,CAS操作会在更新前检查值是否已经被修改,如果被修改,操作会失败并重试,这种乐观的态度使得性能得到提升。

非阻塞数据结构的另一优势是避免了死锁和饥饿问题。由于没有锁的使用,线程不会因为锁的争用而停止执行,这使得系统更加健壮和可靠。

### 4.2.2 乐观锁与CAS操作在集合中的实践

在Java中,`ConcurrentHashMap`、`AtomicInteger`等都是使用乐观锁机制实现线程安全的集合和数据类型的例子。CAS操作保证了更新的原子性,而无需锁住整个数据结构。

```java

ConcurrentSkipListMap<Integer, String> map = new ConcurrentSkipListMap<>();

map.put(1, "one");

```

上述代码段演示了如何使用`ConcurrentSkipListMap`,它使用了一种支持并发的跳跃列表实现。这种数据结构在插入、删除和查找操作时,依赖于CAS操作来避免锁,并保证数据结构的完整性。

实现乐观锁的集合通常需要保证操作的原子性,所以它们经常依赖于底层硬件指令。在JVM层面,CAS操作通常通过`sun.misc.Unsafe`类中的方法实现,尽管这些方法是不推荐直接使用的,因为它们不是Java的标准API。

## 4.3 并发集合的扩展与自定义

### 4.3.1 扩展现有并发集合的策略与实现

Java中的并发集合是高度优化的,但它们并不总是完全满足特定场景的需求。扩展并发集合通常意味着在不改变其线程安全特性的前提下,增加新的功能或者优化其性能。这通常涉及到创建子类或者使用装饰者模式来包装现有的集合。

```java

public class CustomConcurrentHashMap<K, V> extends ConcurrentHashMap<K, V> {

// Additional methods and fields

}

```

通过扩展如`ConcurrentHashMap`这样的并发集合,我们可以添加额外的方法或者覆盖某些行为以满足特定需求。然而,任何扩展都应该保证不破坏原有集合的线程安全特性。

实现这样的扩展通常需要深入理解现有集合的内部工作方式,例如,理解`ConcurrentHashMap`是如何通过多个段(Segment)来保证并发访问的,或者理解`ConcurrentSkipListMap`是如何通过跳跃列表来实现有序访问的。

### 4.3.2 设计自定义线程安全集合的考量

设计自己的线程安全集合需要平衡多方面的因素,包括性能、内存使用、线程安全和可用性。在设计自定义集合时,首先需要确定集合的使用场景和性能要求,然后选择合适的数据结构和同步机制。

```java

public class MyThreadSafeList<E> extends ArrayList<E> {

// Synchronization mechanism to ensure thread safety

}

```

上面的代码仅是一个简单的自定义集合类的框架。在具体实现时,我们需要考虑使用哪种类型的锁,如何处理并发访问,以及是否需要使用无锁技术。设计线程安全集合的过程中,必须确保所有的公共方法都是线程安全的,同时保持操作的效率。

为了实现线程安全,集合中可以使用私有锁对象,或者利用Java的并发库(如`java.util.concurrent`包中的工具类)。如果需要实现更细粒度的控制,可以考虑使用`ReadWriteLock`来区分读写操作,以提高并发读的性能。

设计线程安全集合的最后一个考量是如何在不同环境下进行测试和验证。需要创建多线程测试用例来确保集合能够在高并发情况下稳定运行。同时,对集合进行压力测试和基准测试,了解其性能表现,并根据测试结果不断优化。

在设计和实现线程安全集合时,务必认真考虑所有可能的并发场景,并确保线程安全的同时优化性能。

# 5. 线程安全集合的未来趋势与挑战

## 5.1 Java并发集合的发展方向

随着多核处理器的普及和并发编程的广泛应用,Java并发集合未来的发展趋势是更加注重性能和易用性。开发者在设计并发集合时,越来越倾向于寻找新的数据结构和算法,以便更好地适应不同场景下的性能需求。

### 5.1.1 新型并发集合的探索与创新

在并发编程领域,探索新的数据结构和算法是持续不断的。例如,使用跳表(Skip List)的数据结构,不仅可以提供有序的访问,还能在并发环境下提供较好的性能。ConcurrentSkipListMap 就是基于跳表实现的一个线程安全的 Map 实现。

此外,无锁数据结构(Lock-Free Data Structures)的探索也是并发集合发展的重要方向之一。无锁数据结构通过使用原子操作来保证数据的一致性和线程安全,从而避免了锁的开销,提高了并发性能。

### 5.1.2 高性能并发集合设计的需求分析

高性能的并发集合设计需要综合考虑数据一致性、并发度、内存使用效率以及易用性等多方面因素。设计者需要对各种并发模式有深入的理解,同时对底层硬件架构有充分的认识。

例如,Java 8 引入的并发集合如 ConcurrentHashMap 在扩容时采用了更高效的策略,减少了同步成本。Java 9 及以后的版本中,引入了更多的并发集合改进,如使用了更多的无锁操作和细分的锁策略,以适应更复杂的应用场景。

## 5.2 多线程环境下的集合框架挑战

随着并发编程的深入,如何处理大规模并发环境下的集合框架问题成为一个挑战。集合框架需要在保证线程安全的同时,尽可能地减少资源竞争,提高吞吐量和响应速度。

### 5.2.1 大规模并发下的性能挑战与解决方案

在大规模并发环境下,传统的锁机制往往会成为性能瓶颈。一个解决方案是采用无锁或少锁的数据结构,另一个解决方案是使用分段锁(Segmented Locking)技术。分段锁将一个大的集合分成几个小的段(Segments),每个段都有自己的锁,这样可以使得并发访问更加精细。

例如,ConcurrentHashMap 就是通过分段锁技术,将数据分成了多个段,每个段单独进行加锁,大大减少了锁的粒度,提升了并发性能。

### 5.2.2 跨语言并发集合框架的现状与展望

随着技术的不断发展,跨语言的并发集合框架也逐渐受到关注。对于分布式系统和微服务架构来说,需要一套能够在不同语言间共享和同步的并发集合解决方案。

目前,这方面的研究还在初期阶段,但已经有了一些跨语言的并发数据处理库和框架。它们通常通过分布式锁、事务性内存和消息传递等机制来保证跨语言下的数据一致性和线程安全。

在实现上,这些框架可能会依赖于特定的中间件或服务,例如使用 Redis 或 Zookeeper 来实现跨进程或跨语言的同步。随着分布式系统架构的成熟,这些技术也将不断发展和优化,为多语言环境下的并发集合框架提供支持。

在以上讨论的领域内,可以预见的是,未来Java并发集合将继续朝着更高的性能、更精细的并发控制和更广泛的适用范围发展。随着硬件技术的进步和并发编程模式的创新,Java并发集合将会不断演化,以满足日益增长的计算需求。

0

0