卷积神经网络技术在自然语言处理中的应用

发布时间: 2024-05-02 08:16:57 阅读量: 68 订阅数: 33

# 1. 卷积神经网络(CNN)基础**

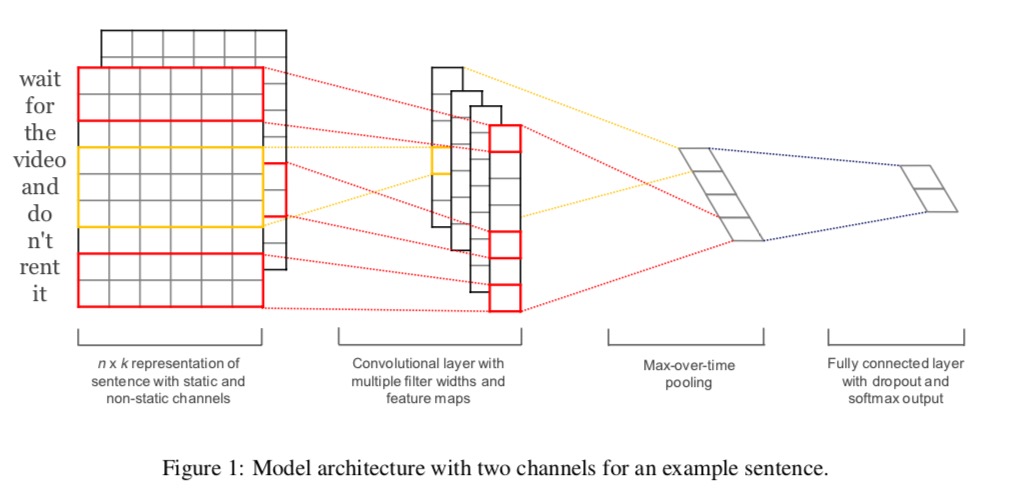

卷积神经网络(CNN)是一种深度学习模型,因其在图像处理和计算机视觉领域的出色表现而闻名。CNN 的核心思想是利用卷积运算来提取数据中的局部特征。卷积层通常由多个滤波器组成,每个滤波器在输入数据上滑动,计算每个位置的加权和,形成一个特征图。

CNN 的架构通常包括卷积层、池化层和全连接层。卷积层负责提取特征,池化层通过下采样减少特征图的维度,全连接层用于分类或回归任务。CNN 的层级结构允许它学习数据中的层次特征,从低级边缘和纹理到高级语义概念。

# 2. CNN在自然语言处理中的理论应用

### 2.1 CNN在NLP中的文本表示

#### 2.1.1 词嵌入与词向量

在自然语言处理中,文本通常被表示为单词序列。然而,直接将单词转换为数字向量会丢失单词之间的语义信息。词嵌入是一种将单词映射到低维稠密向量的技术,可以保留单词的语义和语法信息。

**Word2Vec**是常用的词嵌入模型之一。它通过预测单词上下文的单词来学习词嵌入。Word2Vec有两种模型:CBOW(连续词袋)和Skip-gram。CBOW从上下文单词中预测目标单词,而Skip-gram从目标单词中预测上下文单词。

**代码块:**

```python

import gensim

# 加载语料库

sentences = ["I love natural language processing.", "Natural language processing is a subfield of artificial intelligence."]

# 训练Word2Vec模型

model = gensim.models.Word2Vec(sentences, min_count=1)

# 获取单词"natural"的词向量

vector = model.wv['natural']

```

**逻辑分析:**

* `gensim.models.Word2Vec`类用于训练Word2Vec模型。

* `min_count`参数指定了单词在语料库中出现的最小次数,低于该次数的单词将被忽略。

* `model.wv`属性包含训练好的词向量。

* `model.wv['natural']`获取单词"natural"的词向量。

#### 2.1.2 文本序列的CNN表示

CNN可以对文本序列进行卷积操作,提取局部特征。对于文本序列,卷积核通常是二维的,形状为`[窗口大小,嵌入维度]`。

**代码块:**

```python

import torch

import torch.nn as nn

# 定义CNN模型

class TextCNN(nn.Module):

def __init__(self, vocab_size, embedding_dim, num_filters, kernel_sizes):

super(TextCNN, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.convs = nn.ModuleList([nn.Conv2d(1, num_filters, (kernel_size, embedding_dim)) for kernel_size in kernel_sizes])

def forward(self, x):

# 将单词序列转换为嵌入矩阵

x = self.embedding(x)

x = x.unsqueeze(1) # 增加一个通道维度

# 对嵌入矩阵进行卷积操作

conv_outputs = [F.relu(conv(x)).squeeze(3) for conv in

```

0

0