Hadoop SecondaryNameNode数据安全:备份与灾难恢复的最佳实践

发布时间: 2024-10-26 13:04:37 阅读量: 45 订阅数: 48

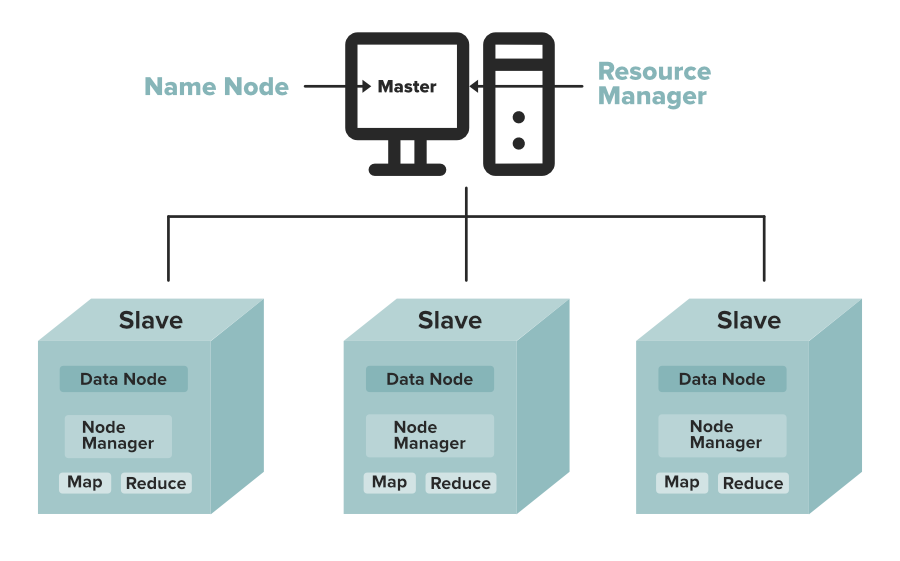

# 1. Hadoop SecondaryNameNode概述

## Hadoop SecondaryNameNode简介

Hadoop SecondaryNameNode 是 Hadoop 集群的重要组成部分,它辅助主 NameNode 管理文件系统的元数据。尽管名为 SecondaryNameNode,但它并不是 NameNode 的热备份或故障转移节点。相反,它的主要作用是合并文件系统的命名空间镜像和编辑日志,以减少主 NameNode 的内存消耗,并保持文件系统的状态可用。

## 工作原理

SecondaryNameNode 定期请求主 NameNode 生成文件系统的快照,并下载该快照。它会接收主 NameNode 的编辑日志并将其应用到快照上。完成这些操作后,SecondaryNameNode 将合并后的状态发送回主 NameNode,后者再加载到内存中。这个过程有助于将编辑日志保持在较小的规模,避免因日志过大导致 NameNode 内存溢出。

## 重要性与优势

SecondaryNameNode 在提高 Hadoop 集群的稳定性与可靠性方面扮演了关键角色。通过定期执行状态合并,它防止了 NameNode 重启时不得不从头读取所有编辑日志。这对于维护大型 Hadoop 集群和处理大量数据的环境来说至关重要。此外,SecondaryNameNode 的存在降低了 NameNode 重启的延迟,因为它不需要重新加载完整的编辑日志。

# 2. 数据备份策略与实践

## 2.1 备份理论基础

### 2.1.1 数据备份的重要性

在数字化时代,数据是企业最为重要的资产之一。数据丢失不仅意味着业务中断,还可能带来巨大的经济损失和品牌信誉的下降。因此,实施有效的数据备份策略是保障企业运营安全和稳定的重要环节。

数据备份能够确保在数据损坏、丢失或遭受恶意攻击的情况下,企业能够迅速恢复数据至可接受的最近状态,减少停机时间,保障服务的连续性。同时,对于某些需要满足合规性要求的行业来说,定期备份数据是法定要求。

### 2.1.2 常见的数据备份类型

在备份领域,根据不同的需求和场景,数据备份可分为全备份、增量备份和差异备份等多种类型:

- **全备份(Full Backup)**:备份所有的数据文件。全备份能够提供最全面的数据保护,但需要消耗大量的存储空间,并且备份时间较长。

- **增量备份(Incremental Backup)**:仅备份自上次备份以来发生变化的数据。增量备份效率较高,节省存储空间,但恢复时间较长,因为需要按顺序恢复最后一次全备份和所有的增量备份。

- **差异备份(Differential Backup)**:备份自上次全备份以来发生变化的数据。差异备份在备份时间和空间上是一种折衷方案,恢复时只需要最后的全备份加上最后一次差异备份即可。

## 2.2 实现数据备份

### 2.2.1 配置和使用Hadoop的快照功能

Hadoop的快照功能能够帮助用户创建数据文件系统的备份。通过快照功能,管理员可以定期创建整个HDFS文件系统的快照,并将其作为数据备份。

为了在Hadoop中启用快照功能,首先需要在HDFS的NameNode上启用支持快照的配置选项:

```shell

hdfs dfsadmin -allowSnapshot /data

```

上面的命令将会为`/data`目录启用快照功能。之后,可以通过如下命令创建快照:

```shell

hdfs dfs -createSnapshot /data snapshot_***

```

这将会创建一个名为`snapshot_***`的快照。

### 2.2.2 定期进行SecondaryNameNode的检查点备份

SecondaryNameNode是Hadoop架构中的一个辅助组件,它负责定期合并NameNode的编辑日志和文件系统的状态信息(FsImage)。这个过程被称为检查点操作。因此,定期备份SecondaryNameNode的检查点对于数据安全也是至关重要的。

检查点操作通常会在SecondaryNameNode配置文件中设置一个时间间隔,以便定期执行合并操作。一旦合并完成,FsImage文件将被复制到一个指定的备份目录。

## 2.3 备份数据的管理

### 2.3.1 备份数据的存储策略

备份数据的存储策略取决于数据的重要性和备份频率。通常,备份数据需要离线存储,以避免在线存储的单点故障和潜在的恶意攻击。

一种常见的存储策略是将备份数据存储在冷存储介质上,如磁带或离线的硬盘驱动器。这样不仅能够节约成本,还能够增加数据安全性。同时,还应考虑使用云存储服务,因为它们通常提供更加可靠的数据冗余和备份机制。

### 2.3.2 备份数据的验证和清理

备份操作完成后,确保备份数据的有效性和完整性是非常关键的。这通常涉及对备份数据进行定期的验证,如通过校验数据文件的完整性,或者模拟数据恢复过程来检查数据的可用性。

此外,随着时间的推移,备份数据会不断积累,需要定期清理过时或不再需要的备份,释放存储空间,以降低存储成本。清理策略应谨慎设计,以防误删除重要的数据备份。

```mermaid

flowchart LR

A[开始备份流程] --> B[配置Hadoop快照功能]

B --> C[创建快照]

C --> D[备份SecondaryNameNode检查点]

D --> E[存储备份数据]

E --> F[验证备份数据完整性]

F --> G[清理过时备份]

G --> H[结束备份流程]

```

在实际操作中,备份流程应根据数据的重要性和备份策略进行调整。建议定期对备份策略进行审查和优化,以适应数据增长和业务变化的需要。

# 3. 灾难恢复计划与流程

灾难恢复是保障企业数据安全和业务连续性的核心组成部分。它涉及到一系列预先计划和策略,以确保在发生重大故障或灾难性事件时,能够尽快恢复服务。本章节将深入探讨灾难恢复的理论基础,构建灾难恢复方案的策略选择,以及如何通过模拟演练来优化灾难恢复流程。

## 3.1 灾难恢复的理论基础

### 3.1.1 灾难恢复的定义与目标

灾难恢复(Disaster Recovery, DR)是指在遇到严重故障,例如自然灾害、硬件故障或人为错误时,能够快速恢复业务操作的一整套策略和流程。其核心目标是确保关键业务系统和数据可以在可接受的时间内恢复到灾难前的状态,从而最小化数据丢失和业务中断造成的损失。

### 3.1.2 灾难恢复计划的组成部分

一个有效的灾难恢复计划通常包括以下几个关键组成部分:

- **风险评估**:分析和识

0

0