【音频处理速成】:用Librosa实现音频信号处理的20个实用案例

发布时间: 2024-10-05 06:56:07 阅读量: 78 订阅数: 38

# 1. 音频信号处理基础与Librosa介绍

音频信号处理是信息技术的一个分支,它涉及到声音信号的捕捉、记录、存储、复制、处理和传播。为了有效执行这些操作,需要对音频信号的频率、相位、振幅等特性有深入的理解。在数字音频处理中,音频信号被转换为数字形式,以便通过计算机进行各种操作。

Python作为一种广泛使用的编程语言,已经成为音频信号处理的热门工具。其中,Librosa是Python中最流行的音频和音乐分析库之一。它提供了丰富的函数和类,可以方便地导入、分析、处理和可视化音频文件。此外,Librosa还支持各种信号处理技术,包括傅里叶变换、滤波器设计、MFCC(梅尔频率倒谱系数)等。

在本章中,我们将先介绍音频信号处理的基本概念,然后将重点放在Librosa库的基础知识上,通过实际案例展示如何使用Librosa库来实现音频文件的读取、显示、分析及元数据处理等基础操作。这将为接下来的章节打下坚实的基础,使读者能够更加深入地理解和应用音频信号处理技术。

# 2. Librosa基础操作

## 2.1 音频信号的导入与导出

音频信号的处理第一步便是导入音频文件,这涉及到不同的格式和采样率。Librosa支持多种音频格式,包括但不限于WAV, MP3, FLAC等。在这一节中,我们将探讨如何使用Librosa来导入和导出音频文件,以及理解音频数据的基本格式和属性。

### 2.1.1 读取音频文件

要读取一个音频文件,我们可以使用`librosa.load()`函数。这个函数不仅可以加载音频文件,还能自动处理采样率的转换。以下是一个简单的例子:

```python

import librosa

# 加载音频文件,y为音频数据,sr为采样率

y, sr = librosa.load('audio_file.wav')

```

在上面的代码中,`audio_file.wav`是待加载的音频文件名。该函数默认返回采样率为22050Hz的音频数据和采样率。若需要其他采样率,可以在`load()`函数中指定`sr`参数。

### 2.1.2 音频数据的基本格式和属性

音频数据`y`通常是一个一维或二维的numpy数组。一维数组代表单声道音频,而二维数组代表双声道或多声道音频。采样率`sr`表示每秒钟的采样点数。

我们可以使用以下命令来查看音频的基本属性:

```python

print('音频采样率:', sr)

print('音频时长:', librosa.get_duration(y=y, sr=sr))

print('音频的通道数:', librosa.stft(y).shape[1])

```

音频的基本属性包括时长、通道数和采样率。`librosa.get_duration()`函数用于计算音频时长,`librosa.stft()`函数则返回了一个表示音频短时傅里叶变换的复数数组,它的列数表示通道数。

### 2.1.3 代码逻辑的逐行解读

上述代码块中的每行逻辑如下:

- `import librosa`: 导入Librosa库。

- `y, sr = librosa.load('audio_file.wav')`: 加载名为`audio_file.wav`的音频文件。

- `print('音频采样率:', sr)`: 打印音频文件的采样率。

- `print('音频时长:', librosa.get_duration(y=y, sr=sr))`: 使用Librosa的`get_duration`函数计算音频时长并打印。

- `print('音频的通道数:', librosa.stft(y).shape[1])`: 使用Librosa的`stft`函数来获取音频的短时傅里叶变换,并打印其通道数。

这些基本操作为音频信号处理提供了入门级的了解,是开始深入探索音频分析和处理技术的基石。

## 2.2 音频信号的显示与分析

### 2.2.1 波形图的绘制

波形图是音频信号可视化的一种简单方式,它展示了音频信号的振幅随时间的变化。使用Librosa绘制波形图,我们可以对音频信号有更直观的认识。

```python

import matplotlib.pyplot as plt

# 绘制波形图

plt.figure(figsize=(14, 5))

librosa.display.waveplot(y, sr=sr)

plt.title('Waveform')

plt.show()

```

这段代码导入了`matplotlib.pyplot`,这是Python中绘制图形的标准库。然后使用`librosa.display.waveplot()`函数来绘制波形图,并通过`plt.show()`显示出来。

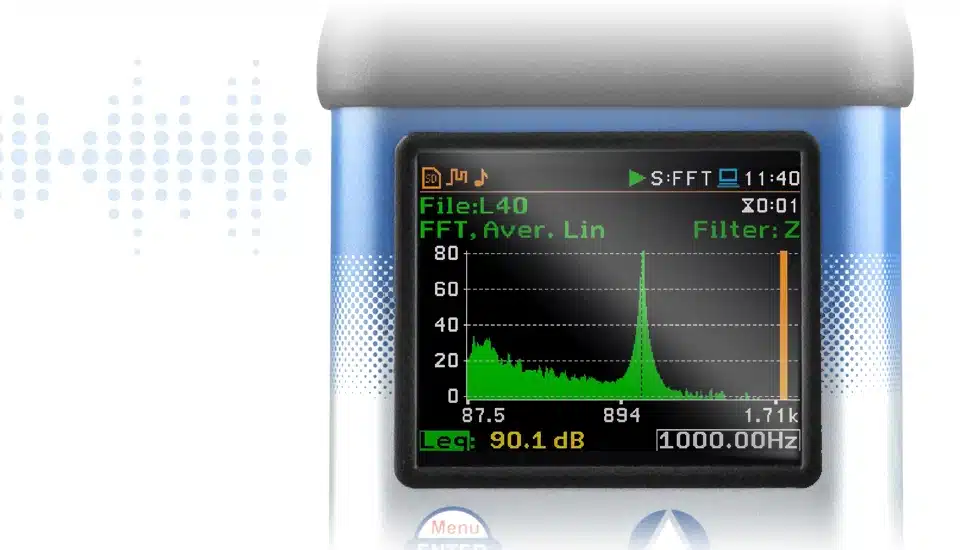

### 2.2.2 频谱分析方法

频谱分析是研究信号频率成分的一种方法。在音频信号处理中,快速傅里叶变换(FFT)是常用的频谱分析工具。

```python

# 计算并绘制频谱图

D = librosa.stft(y)

magnitude = np.abs(D)

plt.figure(figsize=(14, 5))

librosa.display.specshow(magnitude, sr=sr, x_axis='time', y_axis='hz')

plt.colorbar(format='%+2.0f dB')

plt.title('Spectrogram')

plt.show()

```

在这段代码中,我们首先计算音频信号的短时傅里叶变换,接着计算其幅度谱,并使用`librosa.display.specshow()`函数绘制频谱图。频谱图的x轴代表时间,y轴代表频率。`colorbar`为频谱图添加了色彩条,用分贝(db)表示幅度。

### 2.2.3 代码逻辑的逐行解读

上述代码块中的每行逻辑如下:

- `import matplotlib.pyplot as plt`: 导入Matplotlib绘图库。

- `plt.figure(figsize=(14, 5))`: 创建一个宽度为14英寸、高度为5英寸的图形。

- `librosa.display.waveplot(y, sr=sr)`: 使用Librosa的`waveplot`函数绘制音频的波形图。

- `plt.title('Waveform')`: 给当前图形设置标题。

- `plt.show()`: 显示图形。

接下来的代码:

- `D = librosa.stft(y)`: 计算音频信号的短时傅里叶变换。

- `magnitude = np.abs(D)`: 计算复数FFT结果的幅度谱。

- `plt.figure(figsize=(14, 5))`: 创建另一个图形,用于绘制频谱图。

- `librosa.display.specshow(magnitude, sr=sr, x_axis='time', y_axis='hz')`: 使用Librosa的`specshow`函数绘制频谱图,并设置x轴为时间轴,y轴为频率轴。

- `plt.colorbar(format='%+2.0f dB')`: 添加色彩条,并设置格式为分贝。

- `plt.title('Spectrogram')`: 为频谱图设置标题。

- `plt.show()`: 显示图形。

波形图和频谱图都是音频信号分析的重要工具。通过它们,我们可以直观地观察音频信号的时域和频域特性,为进一步的信号处理打下基础。

# 3. 音频信号的处理技巧

音频信号处理是数字信号处理的一个分支,它在现代通信、语音识别、音乐制作等多个领域中扮演着至关重要的角色。本章节将深入探讨音频信号处理中的一些高级技巧和方法,以及如何利用Python库Librosa实现这些处理技巧。我们将覆盖音频信号的滤波与去噪、分割与合并、特征提取等操作。

## 3.1 音频信号的滤波和去噪

在音频信号处理中,滤波是一个基本且关键的操作。滤波器可以用来增强或抑制特定频率范围内的信号成分,而音频去噪技术则旨在清除不需要的噪声,以提高音频质量。

### 3.1.1 使用Librosa进行滤波处理

Librosa提供了多种滤波器设计方法,例如带通滤波器和低通滤波器等。使用Librosa的`librosa.filters.get_filter`函数可以设计所需的滤波器。

```python

import librosa

import numpy as np

# 设计一个低通滤波器

def low_pass_filter(frequency, sample_rate, transition-bandwidth):

nyquist_rate = sample_rate / 2.0

filter_order = librosa.filters.order(frequency, nyquist_rate, transition-bandwidth)

taps = librosa.filters.firwin(filter_order, frequency, nyq=nyquist_rate, window='hann')

return taps

# 滤波器参数

frequency = 4000 # 截止频率为 4000 Hz

sample_rate = 44100 # 采样率为 44100 Hz

transition_bandwidth = 1000 # 过渡带宽度

# 创建滤波器

lp_filter = low_pass_filter(frequency, sample_rate, transition_bandwidth)

```

上述代码中的`low_pass_filter`函数设计了一个低通滤波器,`frequency`参数设置了滤波器的截止频率,`sample_rate`是音频文件的采样率,`transition_bandwidth`定义了截止频率附近的过渡带宽度。滤波器的设计依赖于`librosa.filters.firwin`函数,该函数基于窗函数法设计FIR滤波器。设计完滤波器后,我们可以通过卷积操作将其应用于音频信号。

### 3.1.2 音频去噪技术的实现

音频去噪是一个去除音频信号中不需要的背景噪声的过程。Librosa提供了简单而有效的方法来去噪,例如使用短时傅里叶变换(STFT)和逆短时傅里叶变换(ISTFT)。

```python

import librosa

# 读取音频信号

y, sr = librosa.load('path_to_audio_file.wav')

# 使用librosa的stft和istft进行去噪

D = librosa.stft(y) # 计算短时傅里叶变换

S = np.abs(D) # 取模得到频谱

mask = S > 0.1 * np.max(S) # 设定阈值以区分噪声和信号

S_no_noise = S * mask # 应用阈值掩码

y_no_noise = librosa.istft(S_no_noise) # 逆短时傅里叶变换恢复信号

```

这里首先使用`librosa.stft`函数将音频信号`y`转换为频谱`D`,然后取其幅度得到`S`。通过设定一个阈值来区分噪声和信号,从而创建一个掩码`mask`。接着,我们将掩码应用于频谱以去除噪声部分。最后,使用`librosa.istft`函数将去噪后的频谱`S_no_noise`转换回时域信号`y_no_noise`。

去噪是一个复杂的过程,可能需要根据信号的特性调整算法参数。例如,阈值的选择可能会影响去噪效果和音频的音质。在实际应用中,可能还需要结合其他信号处理技术,如谱减法、Wiener滤波等,以达到最佳去噪效果。

## 3.2 音频信号的分割与合并

音频信号的分割和合并是数字音频编辑中常见的操作,它们允许用户将长音频文件拆分成多个片段,或者将多个片段组合成一个新的音频文件。

### 3.2.1 音频的静音检测和分割

在处理音频文件时,静音检测和分割可以将音频中的无声部分去除,并且只保留有意义的音频片段。Librosa中可以使用能量检测方法来确定静音段。

```python

import librosa

# 加载音频文件

y, sr = librosa.load('path_to_audio_file.wav')

# 静音检测和分割

energy = librosa.feature.rms(y=y)

silence_threshold = np.mean(energy) - 2.0 * np.std(energy) # 定义静音阈值

# 创建分割点列表

split_points = []

for i in range(len(energy) - 1):

if energy[i] < silence_threshold and energy[i + 1] > silence_threshold:

split_points.append(i)

# 分割音频

audio_segments = []

start_index = 0

for sp in split_points:

end_index = sp

segment = y[start_index:end_index]

audio_segments.append(segment)

start_index = end_index

# audio_segments现在包含了分割后的音频片段

```

这段代码首先计算了音频信号的能量,并定义了静音段的阈值。接着,遍历能量值找到所有分割点,将音频信号分割成多个片段。每个片段都是在静音点之间的音频段。需要注意的是,分割点的选择可能会影响到音频的连贯性,因此在实际应用中需要仔细调整静音阈值以获取最佳分割效果。

### 3.2.2 音频片段的合并和混合

音频片段的合并和混合是一种将多个音频片段或音轨合成一个单一音频文件的过程。使用Librosa可以轻松实现这一功能。

```python

import librosa

import numpy as np

# 加载两个音频文件

y1, sr1 = librosa.load('path_to_audio_segment1.wav')

y2, sr2 = librosa.load('path_to_audio_segment2.wav')

# 确保两个音频的采样率一致

y1 = librosa.resample(y1, sr1, sr2)

# 合并两个音频片段

combined_audio = np.concatenate((y1, y2))

# 保存合并后的音频文件

librosa.output.write_wav('path_to_combined_audio.wav', combined_audio, sr2)

```

在上述代码中,两个音频片段首先被加载并确保采样率一致,然后使用`numpy`的`concatenate`函数将它们合并。最后,合并后的音频使用`librosa.output.write_wav`函数保存为一个WAV文件。音频片段的合并过程中可能会涉及到音频信号的长度调整、增益控制等步骤,以保证最终的音质和听感的连贯性。

## 3.3 音频信号的特征提取

音频信号的特征提取是指从音频信号中提取出对特定任务有帮助的信息,这些信息可以是时域特征、频域特征,也可以是更高级的特征如梅尔频率倒谱系数(MFCC)。在音频处理和识别任务中,特征提取至关重要。

### 3.3.1 音频的时域、频域特征提取

时域和频域特征是音频信号分析中最基础、最直接的特征形式。时域特征直接描述了音频信号随时间变化的特性,而频域特征则描述了音频信号在频谱上的分布。

```python

import librosa

import numpy as np

# 加载音频文件

y, sr = librosa.load('path_to_audio_file.wav')

# 时域特征 - 零交叉率和能量

zero_crossing_rate = librosa.feature.zero_crossing_rate(y)

energy = librosa.feature.rms(y=y)

# 频域特征 - 能量谱和频谱

energy_spectrum = np.abs(librosa.stft(y))**2

spectrum = librosa.feature.melspectrogram(y=y, sr=sr)

# 输出提取的特征

print("Zero Crossing Rate:\n", zero_crossing_rate)

print("Energy:\n", energy)

print("Energy Spectrum:\n", energy_spectrum)

print("Spectrum:\n", spectrum)

```

以上代码展示了如何使用Librosa提取音频信号的零交叉率和能量特征,以及能量谱和频谱。`librosa.feature.zero_crossing_rate`计算了音频信号的零交叉率,它反映音频波形在零点附近穿越的频率。`librosa.feature.rms`计算了音频信号的能量。频谱分析则通过`librosa.stft`函数计算短时傅里叶变换,再进行平方得到能量谱。`librosa.feature.melspectrogram`则用于计算音频信号的梅尔频谱。

### 3.3.2 音频的MFCC特征提取

梅尔频率倒谱系数(MFCC)是一种广泛使用的音频特征,特别是在语音识别和音乐信息检索中。MFCC模拟了人耳听觉特性,通过将频谱转换到梅尔刻度上,并计算其对数能量,然后通过离散余弦变换(DCT)得到。

```python

import librosa

# 加载音频文件

y, sr = librosa.load('path_to_audio_file.wav')

# 计算MFCC特征

mfcc = librosa.feature.mfcc(y=y, sr=sr)

# 输出MFCC特征

print("MFCC:\n", mfcc)

```

在上述代码中,`librosa.feature.mfcc`函数计算了音频文件的MFCC特征,`y`是音频信号,`sr`是采样率。MFCC参数可以通过函数的可选参数进行调整,以适应不同的应用需求。MFCC特征的提取涉及到了信号处理中的多个步骤,包括预加重、分帧、加窗、傅里叶变换、梅尔滤波器组、对数运算和离散余弦变换。

MFCC特征的提取是音频信号处理中的一个重要步骤,它为后续的音频分类、检索和识别任务提供了关键的信息。通过调整MFCC的参数,如帧长、帧移、滤波器组数量和DCT的阶数,可以获得适应不同应用场景的特征集。

在本章节中,我们探讨了音频信号处理中的高级技巧,包括滤波去噪、音频的分割与合并、特征提取等。这些技巧在音频分析和处理的应用中占据着核心地位,是音频处理技术深入发展的基础。通过这些方法,我们可以从原始音频中提取出有用的信息,进一步进行音频的高级分析和处理。在下一章节中,我们将介绍音频信号处理的实践应用,包括音乐信息检索、语音识别与处理、音频效果器制作等,这些应用将深化我们对音频信号处理技术的理解,并展示这些技术在现实世界中的实际应用。

# 4. 音频信号处理实践应用

在这一章节中,我们将深入探讨音频信号处理的实际应用,将理论知识转化为具体的案例分析。我们将从音乐信息检索(MIR)、语音识别与处理,以及音频效果器制作三个方面,展示如何利用Librosa和其他音频处理工具,实现音乐分析、语音分析和音频效果创造的高级功能。

## 4.1 音乐信息检索(MIR)

音乐信息检索(Music Information Retrieval,MIR)是指利用计算机技术对音乐内容进行检索和管理的领域。在这一小节中,我们将重点介绍基于内容的音频检索方法和音乐风格及情绪识别案例。

### 4.1.1 基于内容的音频检索方法

基于内容的音频检索方法主要是通过分析音频文件的内容特征,如旋律、节奏、和声等,来检索相似的音乐或音频片段。Librosa库为这些音频特征的提取提供了强大的工具。

```python

import librosa

import numpy as np

# 载入音频文件

y, sr = librosa.load('path/to/audiofile.wav')

# 提取音频特征,例如MFCC

mfccs = librosa.feature.mfcc(y=y, sr=sr)

# 计算音频文件的相似性

def compute_similarity(audio_feature_1, audio_feature_2):

return np.corrcoef(audio_feature_1, audio_feature_2)

# 假设我们有另一个音频文件的MFCC特征

mfccs_2 = librosa.feature.mfcc(y=y_2, sr=sr_2)

# 计算两段音频的相似度

similarity = compute_similarity(mfccs, mfccs_2)

```

在这个示例中,我们首先使用Librosa加载音频文件,并提取了MFCC特征。然后定义了一个计算相似度的函数,使用相关系数来量化两个音频特征之间的相似性。这个方法可以广泛应用于音乐推荐系统和音乐版权识别等领域。

### 4.1.2 音乐风格和情绪识别案例

音乐风格和情绪识别是MIR中一个令人兴奋的研究方向。通过分析音频信号,我们可以识别出音乐的风格(如古典、爵士、摇滚)和情绪(如快乐、悲伤、愤怒)。

```python

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集并提取特征

# 假设有一个包含音频特征和标签的数据集

X, y = load_dataset()

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# 使用随机森林进行分类

clf = RandomForestClassifier()

clf.fit(X_train, y_train)

# 进行预测

y_pred = clf.predict(X_test)

# 计算准确率

accuracy = accuracy_score(y_test, y_pred)

```

在这个例子中,我们使用了随机森林分类器来对音乐的风格和情绪进行预测。首先加载包含音频特征和标签的数据集,然后使用`train_test_split`函数划分数据集为训练集和测试集。最后,我们训练了模型并对测试集进行预测,最终计算了准确率。这个方法可以帮助音乐创作者了解音乐作品的风格和情绪,也有助于音乐平台为用户提供个性化的推荐服务。

## 4.2 语音识别与处理

语音识别与处理是指使用计算机技术将语音信号转换为文本,或进行其他形式的处理。在本小节中,我们将介绍语音信号的预处理方法和语音识别技术的Librosa实现。

### 4.2.1 语音信号的预处理方法

语音信号的预处理是语音识别前的重要步骤。预处理通常包括降噪、回声消除、声学增强等步骤。

```python

# 降噪处理

y_noise_free, sr = librosa.effects.preemphasis(y)

# 使用Librosa进行降噪

def denoise(y, sr, frame_length=2048, hop_length=512):

# 使用高通滤波器去除低频噪声

high_pass = 50.0

y_denoised = librosa.effects.preemphasis(y, coef=high_pass)

return y_denoised

# 应用降噪函数

y_denoised = denoise(y, sr)

```

在这个示例中,我们首先使用`preemphasis`方法进行预强调,它可以帮助去除由于麦克风引起的低频噪声。然后我们定义了一个`denoise`函数,该函数使用高通滤波器去除低频噪声。预处理后的语音信号更适合进行特征提取和模式识别。

### 4.2.2 语音识别技术的Librosa实现

Librosa库虽然不直接提供完整的语音识别功能,但可以辅助进行语音信号的处理,使得后续使用其他专门的语音识别库变得更容易。

```python

# 提取音频特征

MFCCs = librosa.feature.mfcc(y=y_denoised, sr=sr)

# 使用其他库进行语音识别

import speech_recognition as sr识别

# 初始化识别器

recognizer = sr.Recognizer()

# 使用麦克风作为音频源

with sr.Microphone() as source:

print("请说些什么:")

audio = recognizer.listen(source)

# 使用Google的语音识别API进行识别

try:

text = recognizer.recognize_google(audio)

print("你说的是:" + text)

except sr.UnknownValueError:

print("无法理解音频")

except sr.RequestError as e:

print("无法从Google语音识别服务请求结果; {0}".format(e))

```

在这里,我们首先利用Librosa提取了经过预处理的语音信号的MFCC特征。然后我们使用`speech_recognition`库来实现实际的语音识别功能。我们初始化了一个识别器,通过麦克风捕获音频,并使用Google的API进行语音识别。这种组合方式可以在一定程度上提高语音识别的准确性和鲁棒性。

## 4.3 音频效果器制作

音频效果器是指对音频信号进行特定处理以达到某种预期效果的设备或软件。本小节将介绍如何制作音频回声效果器和混响效果器。

### 4.3.1 音频回声效果器的制作

音频回声效果器能够模拟声音在空间中的反射和衰减,产生一种自然的回声声效。

```python

import numpy as np

import soundfile as sf

def echo_effect(y, sr, delay=0.5, gain=0.5):

''' 创建回声效果 '''

# 延迟时间以秒为单位转换为样本数

n = int(delay * sr)

# 创建零数组填充回声信号

echo = np.zeros_like(y)

# 在回声信号数组的对应位置叠加回声

echo[n::n] = gain * y[:-n]

# 将原始音频与回声信号叠加

return y + echo

# 载入音频文件

y, sr = sf.read('path/to/audiofile.wav')

# 应用回声效果

y_echo = echo_effect(y, sr, delay=0.3, gain=0.3)

# 输出处理后的音频

sf.write('path/to/output_with_echo.wav', y_echo, sr)

```

我们定义了一个`echo_effect`函数,通过延迟音频样本数来模拟回声,并将其与原始音频叠加。通过调整`delay`(延迟时间)和`gain`(增益)参数,可以控制回声的强度和间隔,以达到不同的回声效果。

### 4.3.2 音频混响效果器的制作

音频混响效果器模拟声音在封闭空间中的反射,可以增强音乐的丰满度和深度。

```python

import scipy.signal as signal

def reverb_effect(y, sr, decay_time=2):

''' 创建混响效果 '''

# 定义混响滤波器的冲击响应函数

h = signal.exponentialdecay(decay_time, sr)

# 应用卷积操作

y_reverb = signal.convolve(y, h, mode='same')

return y_reverb

# 载入音频文件

y, sr = sf.read('path/to/audiofile.wav')

# 应用混响效果

y_reverb = reverb_effect(y, sr, decay_time=1)

# 输出处理后的音频

sf.write('path/to/output_with_reverb.wav', y_reverb, sr)

```

我们使用了`scipy`库中的`exponentialdecay`函数创建了一个指数衰减的混响滤波器冲击响应,然后通过卷积操作来实现混响效果。混响效果器的参数`decay_time`(衰减时间)决定了混响的持续时间,可以根据需要进行调整。

## 4.3 音频效果器制作 - 音频效果器的实现

### 4.3.1 音频回声效果器的实现

音频回声效果器通过模拟声音传播过程中的延迟和衰减特性,为音频添加回声效果。以下是一个简单的回声效果器实现,它通过在原始音频信号中添加延迟和衰减的版本来模拟回声。

```python

import numpy as np

import soundfile as sf

def add_echo(y, sr, delay=0.5, gain=0.5):

"""

在音频信号中添加回声效果。

:param y: 原始音频信号

:param sr: 采样率

:param delay: 延迟时间,单位秒

:param gain: 回声增益

:return: 添加了回声效果的音频信号

"""

# 将延迟时间转换为样本数

delay_samples = int(delay * sr)

# 初始化回声信号数组

echo_signal = np.zeros_like(y)

# 逐步构建回声信号

for i in range(delay_samples, len(y)):

echo_signal[i] = gain * y[i - delay_samples]

# 将回声信号叠加到原始音频信号中

return y + echo_signal

# 载入音频文件

y, sr = sf.read('path/to/input_audio.wav')

# 应用回声效果

y_with_echo = add_echo(y, sr, delay=0.4, gain=0.3)

# 保存添加回声效果的音频文件

sf.write('path/to/output_with_echo.wav', y_with_echo, sr)

```

在这个代码中,我们首先定义了一个`add_echo`函数,它接受原始音频信号`y`和采样率`sr`,以及用户自定义的延迟时间和增益。函数计算了延迟时间对应的样本数,并创建了一个和原始信号长度相同的零数组作为回声信号。接着,通过循环将延迟后的音频信号按一定比例叠加到当前音频样本上,生成回声效果。最后,我们将带有回声的音频信号写入到一个新的文件中。

### 4.3.2 音频混响效果器的实现

混响效果器通过模拟声音在封闭空间的反射,为音频添加一种深度和丰满感。我们使用FIR滤波器来实现混响效果器。

```python

import numpy as np

from scipy.signal import firwin

def reverb_filter(sr, filter_length=1024):

"""

设计一个简单的混响滤波器。

:param sr: 采样率

:param filter_length: 滤波器长度

:return: 混响滤波器系数

"""

# 设计一个低通FIR滤波器

reverb_filter = firwin(filter_length, cutoff=0.1, fs=sr)

return reverb_filter

# 载入音频文件

y, sr = sf.read('path/to/input_audio.wav')

# 设计混响滤波器

reverb_filter_coeff = reverb_filter(sr)

# 应用混响滤波器

y_reverb = np.convolve(y, reverb_filter_coeff, mode='same')

# 保存带有混响效果的音频文件

sf.write('path/to/output_with_reverb.wav', y_reverb, sr)

```

在这里,我们首先定义了一个`reverb_filter`函数,使用`scipy.signal.firwin`方法来设计一个低通FIR滤波器,以模拟混响中的高频衰减特性。然后我们通过卷积操作将混响滤波器应用于原始音频信号,生成带有混响效果的音频。最后,将处理后的音频数据保存到文件中。

以上例子中,音频回声和混响效果器的实现展示了如何利用Librosa以及其他科学计算库来创建实用的音频处理工具。这些工具可以用于音乐制作、后期编辑和声音设计等众多领域。通过精确的音频处理技术,我们可以创造出丰富多变的听觉体验,使音频内容更加生动和吸引人。

# 5. 音频信号处理进阶应用

## 5.1 自动节拍检测与分析

音乐节拍是音乐节奏感的核心所在,它不仅影响着音乐的节奏,还与听众的听感体验密切相关。自动节拍检测技术能够帮助我们从计算机的角度理解和分析音乐的节奏模式。

### 5.1.1 节拍跟踪算法概述

节拍跟踪算法通过对音频信号进行分析,确定音频中的节奏点,这些节奏点帮助我们理解音乐中的时间结构。一个典型的节拍跟踪算法通常包含以下几个步骤:

1. 预处理:输入音频信号通常需要经过预处理,比如进行归一化处理,消除不必要的静音段落。

2. 特征提取:提取音频信号的特征,如能量、频谱特征等。

3. 节拍点检测:通过特征信号的峰值检测来确定可能的节拍点。

4. 节拍跟踪:利用统计模型或机器学习方法,如隐马尔可夫模型(HMM)、深度学习等,对可能的节拍点进行筛选和优化,以识别稳定且准确的节拍位置。

节拍检测是音频内容分析的一个研究热点,对于音乐信息检索、自动伴奏等应用有着重要的意义。

### 5.1.2 实现音频的节拍检测案例

以下使用Python和Librosa库实现一个简单的节拍检测案例:

```python

import librosa

import numpy as np

import matplotlib.pyplot as plt

def detect_beats(y, sr):

tempo, beat_frames = librosa.beat.beat_track(y=y, sr=sr, hop_length=512, units='frames')

beats = librosa.frames_to_time(beat_frames, sr=sr)

return beats

# 读取音频文件

y, sr = librosa.load('path/to/your/audio/file.wav')

# 检测节拍

beats = detect_beats(y, sr)

# 绘制波形图和节拍点

plt.figure(figsize=(14, 5))

librosa.display.waveshow(y, sr=sr)

plt.plot(beats, np.zeros_like(beats), 'o', markersize=10)

plt.title('Beat Detection')

plt.show()

```

在这个代码块中,`librosa.beat.beat_track` 函数用于计算音频文件的节拍和节拍位置。使用`librosa.display.waveshow`函数绘制音频的波形图,并在相应的节拍位置上用'x'标记出来。

## 5.2 音高检测与分析

### 5.2.1 音高检测算法介绍

音高检测是音频信号处理中的另一个重要领域,音高的检测可以应用于旋律线提取、声音的音准分析等方面。音高(Pitch)通常是指声音的频率高低,它是区分不同音符的重要物理量。音高检测算法的核心是识别音频信号中的主要频率分量。

目前流行的音高检测方法主要包括:

- 基于频率的方法:直接从音频信号中提取基频,如YIN、CREPE算法。

- 基于模型的方法:如使用隐马尔可夫模型(HMM)和高斯混合模型(GMM)等。

- 基于深度学习的方法:利用神经网络来学习音高特征。

### 5.2.2 音频的音高跟踪与分析案例

Librosa库同样提供了音高跟踪的功能,以下是一个音高跟踪的简单示例:

```python

import librosa

import matplotlib.pyplot as plt

def track_pitch(y, sr):

# 使用CREPE算法提取音高

pitches, magnitudes = librosa.piptrack(y=y, sr=sr, fmin=librosa.note_to_hz('C2'), fmax=librosa.note_to_hz('C7'))

return pitches

# 读取音频文件

y, sr = librosa.load('path/to/your/audio/file.wav')

# 跟踪音高

pitches = track_pitch(y, sr)

# 绘制音高跟踪结果

fig, ax = plt.subplots()

times = librosa.times_like(pitches)

librosa.display.specshow(pitches, sr=sr, x_axis='time', y_axis='log', ax=ax)

ax.set_title('Pitch Tracking')

plt.colorbar(format='%+2.0f Hz')

plt.show()

```

在代码中,`librosa.piptrack`函数用于提取音频信号中的音高信息。函数返回的`pitches`数组包含了每个时间帧的音高估计值。通过`librosa.display.specshow`函数,我们可以将这些音高信息以可视化的形式展示出来。

## 5.3 音频合成技术

### 5.3.1 数字音频合成基础

数字音频合成是指利用数字技术创造出新的音频波形的技术。它包括了几种不同的方法,如:

- 波表合成(Wavetable Synthesis):通过从真实乐器声音中采样得到的波形来合成音乐。

- 谐波合成(Harmonic Synthesis):使用谐波的叠加来模拟乐器声。

- 物理模型合成(Physical Modelling Synthesis):通过建立乐器物理属性的模型来生成声音。

- 脉冲编码调制(PCM):直接对声音的样本进行存储和播放。

### 5.3.2 使用Librosa合成音频案例

我们可以使用Librosa库来合成一些基本的音频波形。以下是一个创建正弦波音频合成的简单例子:

```python

import librosa

import librosa.display

import numpy as np

def create_sine_wave(freq, duration, sr):

# 生成纯正弦波

t = np.linspace(0, duration, int(sr * duration))

sine_wave = np.sin(2 * np.pi * freq * t)

return sine_wave

# 设置参数

sr = 22050 # 采样率

freq = 440 # 频率,A4音符

duration = 2 # 持续时间,秒

# 创建正弦波

sine_wave = create_sine_wave(freq, duration, sr)

# 保存音频文件

librosa.output.write_wav('sine_wave_440Hz.wav', sine_wave, sr)

# 绘制波形图

plt.figure(figsize=(14, 5))

librosa.display.waveshow(sine_wave, sr=sr)

plt.title('Sine Wave Synthesis')

plt.show()

```

在这段代码中,我们通过定义一个正弦波函数`create_sine_wave`生成了一个频率为440Hz(A4音符)的纯正弦波。然后,使用`librosa.output.write_wav`函数将生成的音频数据保存为WAV格式的文件。我们还可以使用`librosa.display.waveshow`函数来展示这个正弦波的波形图。

音频合成技术在音乐制作、游戏开发和虚拟现实等领域有着广泛的应用。通过掌握Librosa库,我们能够更加便捷地进行音频信号处理和合成。

在接下来的章节中,我们将探讨音频处理项目的优化和部署,以及音频处理技术的未来趋势和挑战。

# 6. 音频处理项目的优化与部署

## 6.1 音频处理算法的性能优化

在音频处理领域,算法的性能优化是一个不断追求的目标。为了获得更好的用户体验,处理速度和资源使用效率是两个关键因素。

### 6.1.1 算法效率分析与优化技巧

性能优化的第一步是对现有算法进行效率分析。我们可以使用Python的`cProfile`模块来获取程序的执行时间细节。这样可以识别出程序中哪些部分是性能瓶颈。

以下是一个使用`cProfile`来分析代码效率的示例代码:

```python

import cProfile

import re

def slow_function(text):

"""一个示例的低效函数"""

return re.findall(r'\w+', text.lower())

cProfile.run('slow_function("Some example text")')

```

通过分析上述代码的输出,我们可以观察到哪些函数调用消耗了最多的时间。找到效率低下的函数后,我们可以考虑使用更加高效的算法或者数据结构,例如使用numpy数组代替Python列表进行数值计算。

### 6.1.2 利用缓存和多线程提升处理速度

为了进一步优化性能,我们可以利用缓存来存储已经计算过的结果,避免重复计算。此外,对于CPU密集型任务,我们可以使用Python的`multiprocessing`模块来实现并行计算。

以下是一个使用`functools.lru_cache`来缓存结果的示例代码:

```python

from functools import lru_cache

@lru_cache(maxsize=100)

def expensive_computation(x):

"""一个示例的计算密集型函数"""

# 模拟一个复杂的计算过程

return x ** 2

# 在多次调用时,重复计算不会发生

for i in range(10):

print(expensive_computation(i))

```

对于多线程的实现,可以参考以下示例:

```python

from multiprocessing import Pool

def process_audio_file(file_path):

"""处理单个音频文件的函数"""

# 你的音频处理代码

pass

def process_all_files(file_paths):

with Pool(processes=4) as pool:

pool.map(process_audio_file, file_paths)

file_paths = ['path/to/file1.wav', 'path/to/file2.wav']

process_all_files(file_paths)

```

## 6.2 音频处理项目的打包与部署

当音频处理项目开发完成并经过测试后,我们需要将项目打包,以便在目标环境中部署和使用。

### 6.2.1 创建音频处理应用的步骤

创建音频处理应用程序通常涉及以下几个步骤:

1. 确定应用需求和功能。

2. 设计用户界面和交互流程。

3. 编写音频处理核心代码。

4. 集成和测试第三方库(如Librosa)。

5. 打包应用为可执行文件。

Python项目通常可以使用PyInstaller或者cx_Freeze等工具进行打包。以下是使用PyInstaller打包Python脚本为Windows可执行文件的示例:

```shell

pyinstaller --onefile your_script.py

```

### 6.2.2 应用部署的实践案例

部署音频处理应用时,我们可以选择多种方案:

- **桌面应用部署**:打包后分发安装程序。

- **Web应用部署**:使用Flask或Django等框架将应用部署到Web服务器。

- **云服务部署**:将应用部署到云平台,如AWS Lambda或Google Cloud Functions。

下面是一个简单的Flask Web应用部署示例:

```python

from flask import Flask, request, jsonify

import librosa

app = Flask(__name__)

@app.route('/upload', methods=['POST'])

def upload_file():

# 你的音频处理逻辑

audio_file = request.files['file']

processed_audio = process_audio(audio_file)

return jsonify({'status': 'success', 'file': processed_audio})

def process_audio(audio_file):

# 使用Librosa处理音频文件

return 'Processed Audio Data'

if __name__ == '__main__':

app.run(host='*.*.*.*', port=5000)

```

## 6.3 音频处理的未来趋势与挑战

随着人工智能和机器学习技术的快速发展,音频处理领域正在经历一场变革。

### 6.3.1 人工智能在音频处理中的应用

人工智能在音频处理中的应用包括但不限于:

- **自动音乐生成**:利用深度学习模型,如GANs(生成对抗网络),生成音乐作品。

- **语音助手与对话系统**:通过自然语言处理技术提高语音识别的准确度和交互性。

### 6.3.2 面临的伦理和技术挑战

尽管人工智能技术带来了巨大潜力,但同时也带来了一系列挑战:

- **隐私保护**:音频数据往往涉及用户隐私,如何确保数据安全和用户隐私是重要问题。

- **版权问题**:生成的音频内容可能涉及版权归属问题。

- **算法偏见**:机器学习模型可能存在偏见,需要不断优化以避免不公正。

在音频处理领域,以上内容只是冰山一角。为了深入理解如何应用这些理论到实际项目中,可以参加相关的在线课程或研讨会,与行业专家进行交流,进一步扩展知识边界。随着技术的发展和应用案例的丰富,我们可以预见一个充满创新和可能性的未来。

0

0