深度学习模型可解释性:揭开黑盒模型的神秘面纱

发布时间: 2024-08-17 03:21:43 阅读量: 63 订阅数: 41

(179979052)基于MATLAB车牌识别系统【带界面GUI】.zip

# 1. 深度学习模型可解释性的概述

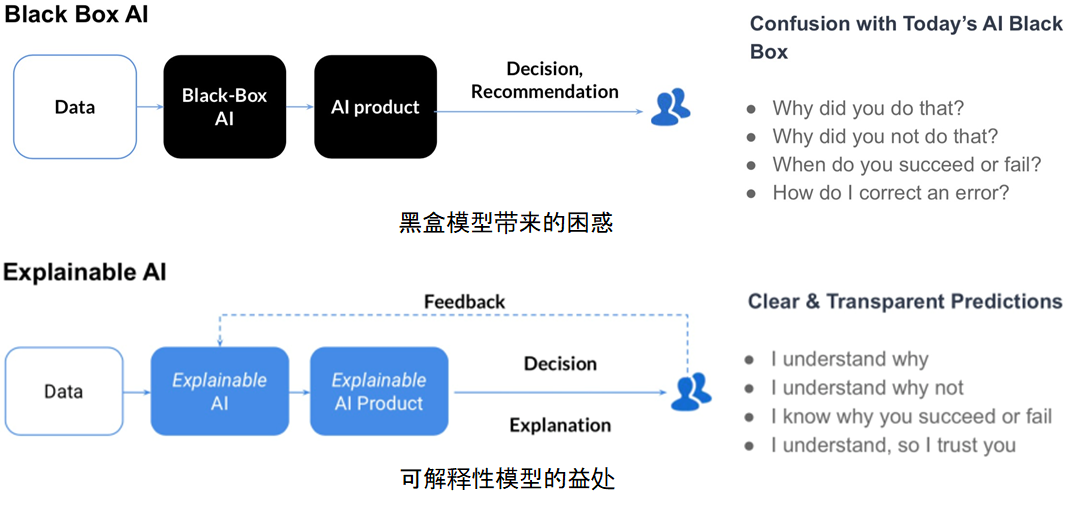

深度学习模型因其强大的学习能力而广泛应用于各种领域。然而,这些模型通常被视为"黑盒",其内部运作机制难以理解。深度学习模型可解释性旨在揭开这些模型的神秘面纱,帮助我们理解模型的决策过程,提高模型的可信度和可信赖性。

可解释性对于各种利益相关者至关重要。对于模型开发人员来说,可解释性可以帮助他们识别模型的偏差、错误和弱点。对于业务决策者来说,可解释性可以提供对模型预测的信心和依据。对于最终用户来说,可解释性可以帮助他们了解模型如何影响他们的决策,并提高对模型的信任。

# 2. 模型可解释性方法

模型可解释性方法旨在揭示深度学习模型的内部运作机制,使其能够被人类理解和解释。这些方法可以分为三大类:基于梯度的、基于决策树的和基于聚类的。

### 2.1 基于梯度的可解释性方法

基于梯度的可解释性方法利用梯度信息来衡量输入特征对模型输出的影响。

#### 2.1.1 梯度敏感度分析

梯度敏感度分析 (GSA) 计算每个输入特征的梯度绝对值之和,以衡量其对模型输出的影响。特征具有较高的梯度敏感性,表明它们对模型预测有较大的影响。

**代码块:**

```python

import numpy as np

def gradient_sensitivity_analysis(model, X):

"""

计算每个输入特征的梯度敏感性。

参数:

model: 深度学习模型

X: 输入特征矩阵

返回:

梯度敏感性向量

"""

# 计算梯度

gradients = np.gradient(model.predict(X), X)

# 计算梯度绝对值之和

sensitivity = np.sum(np.abs(gradients), axis=0)

return sensitivity

```

**逻辑分析:**

该代码块计算输入特征矩阵 `X` 中每个特征的梯度绝对值之和。梯度绝对值之和表示该特征对模型输出的影响程度。

#### 2.1.2 梯度积分梯度

梯度积分梯度 (IG) 沿输入特征的梯度方向积分梯度,以衡量特征对模型输出的贡献。特征具有较高的 IG 值,表明它们对模型预测的贡献较大。

**代码块:**

```python

import numpy as np

def integrated_gradients(model, X, baseline):

"""

计算每个输入特征的梯度积分梯度。

参数:

model: 深度学习模型

X: 输入特征矩阵

baseline: 基线输入特征矩阵

返回:

梯度积分梯度向量

"""

# 计算梯度

gradients = np.gradient(model.predict(X), X)

# 积分梯度

ig = np.sum((X - baseline) * gradients, axis=0)

return ig

```

**逻辑分析:**

该代码块计算输入特征矩阵 `X` 中每个特征的梯度积分梯度。梯度积分梯度表示特征从基线输入特征矩阵 `baseline` 到 `X` 的贡献。

# 3.1 医疗诊断中的可解释性

**3.1.1 疾病预测模型的可解释性**

在医疗诊断中,深度学习模型被广泛用于预测疾病的风险和进展。然而,这些模型通常是黑盒模型,难以解释其预测背后的原因。可解释性方法可以帮助医生理解模型的预测,从而提高对患者诊断和治疗决策的信心。

例如,梯度敏感度分析 (GS) 是一种基于梯度的可解释性方法,它可以识别输入特征对模型预测的影响。通过计算输入特征相对于输出预测的梯度,GS 可以确定哪些特征对预测贡献最大。这有助于医生了解哪些患者特征与疾病风险增加或降低相关。

**3.1.2 治疗方案推荐模型的可解释性**

除了疾病预测,深度学习模型还被用于推荐治疗方案。这些模型可以根据患者的特征和病史,预测最佳的治疗方案。然而,同样地,这些模型通常是黑盒模型,难以解释其推荐背后的原因。

SHAP (Shapley Additive Explanations) 是一种基于决策树的可解释性方法,它可以解释模型的预测,并量化每个输入特征对预测的贡献。通过使用 SHAP,医生可以了解哪些患者特征对治疗方案的推荐有重要影响,从而做出更明智的决策。

### 3.2 金融风险评估中的可解释性

**3.2.1 信用评

0

0