深度学习模型安全防护:应对对抗样本和隐私泄露威胁

发布时间: 2024-08-17 03:35:59 阅读量: 19 订阅数: 32

# 1. 深度学习模型安全概述

深度学习模型在各种领域取得了显著成功,但它们也面临着独特的安全挑战。本概述将介绍深度学习模型安全的基本概念,包括:

- **模型攻击类型:**对抗样本、隐私泄露和后门等。

- **安全风险:**模型性能下降、敏感信息泄露和模型操纵。

- **安全目标:**模型完整性、机密性和可用性。

# 2. 对抗样本攻击与防御

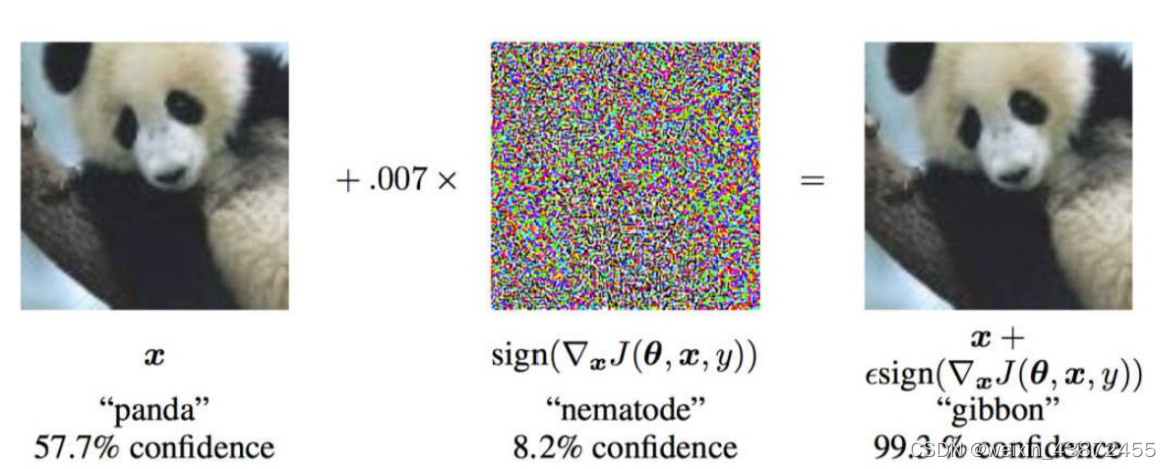

### 2.1 对抗样本的原理和生成方法

**2.1.1 梯度下降法**

梯度下降法是生成对抗样本的常用方法。其原理是通过不断迭代更新输入样本,使模型预测结果与目标标签之间的损失函数最小化。具体步骤如下:

```python

import numpy as np

def generate_adversarial_sample(model, x, y, epsilon):

"""

生成对抗样本

参数:

model: 目标模型

x: 原始输入样本

y: 目标标签

epsilon: 扰动范围

返回:

对抗样本

"""

# 初始化对抗样本

x_adv = x.copy()

# 计算梯度

gradient = model.gradient(x_adv, y)

# 更新对抗样本

x_adv += epsilon * np.sign(gradient)

# 限制对抗样本范围

x_adv = np.clip(x_adv, 0, 1)

return x_adv

```

**逻辑分析:**

* `model.gradient(x_adv, y)` 计算模型对输入样本 `x_adv` 和目标标签 `y` 的梯度。

* `np.sign(gradient)` 取梯度的符号,用于确定更新方向。

* `epsilon` 控制扰动范围,确保对抗样本与原始样本相近。

* `np.clip(x_adv, 0, 1)` 将对抗样本限制在图像像素值的合法范围内。

**2.1.2 遗传算法**

遗传算法是一种受进化论启发的优化算法,也可用于生成对抗样本。其原理是通过模拟生物进化过程,不断选择和繁殖具有较高适应度的个体,最终获得满足目标的对抗样本。

```python

import numpy as np

import random

def generate_adversarial_sample(model, x, y, population_size, num_generations):

"""

生成对抗样本

参数:

model: 目标模型

x: 原始输入样本

y: 目标标签

population_size: 种群大小

num_generations: 进化代数

返回:

对抗样本

"""

# 初始化种群

population = [x.copy() for _ in range(population_size)]

# 进化

for generation in range(num_generations):

# 计算适应度

fitness = [model.loss(sample, y) for sample in population]

# 选择

parents = [random.choice(population, p=fitness) for _ in range(population_size)]

# 交叉

children = [np.mean([parent1, parent2], axis=0) for parent1, parent2 in zip(parents, parents)]

# 突变

for child in children:

child += np.random.normal(0, 0.1, child.shape

```

0

0