【医疗健康实践探索】:逻辑回归在医疗健康领域的实践探索

发布时间: 2024-04-19 18:44:54 阅读量: 131 订阅数: 106

机器学习:逻辑回归实现癌症预测 .zip

# 1. 逻辑回归在医疗健康领域的介绍

逻辑回归是一种常用的分类算法,在医疗健康领域也发挥着重要作用。通过对医疗数据进行建模和分析,逻辑回归可以用于预测患者患病的风险、辅助临床诊断以及优化医疗资源的分配。在医疗领域,逻辑回归通常应用于疾病预测、患者分类等场景。逻辑回归能够根据已有数据,给出患病的概率或分类信息,帮助医疗工作者做出更科学的决策。在不断发展的医疗健康领域,逻辑回归的应用前景也越来越受到关注,具有广阔的发展空间。

接下来,我们将深入了解逻辑回归的基础知识,包括其原理、与线性回归的区别,以及在医疗健康领域的具体应用场景。让我们开始探讨逻辑回归背后的原理和概念。

# 2. 逻辑回归基础知识

### 2.1 逻辑回归原理简介

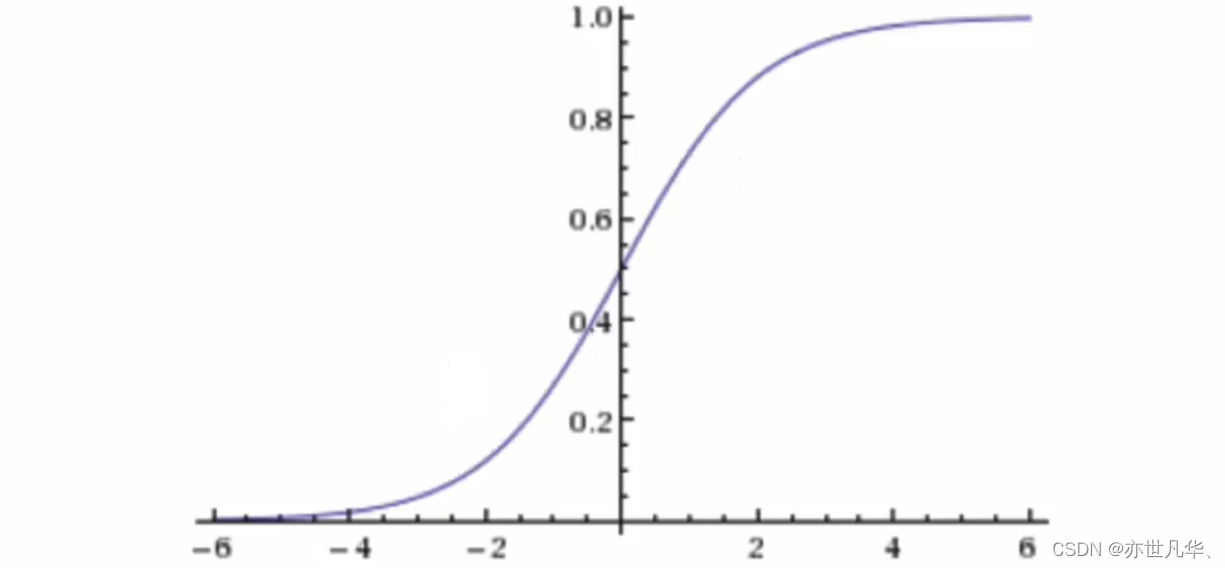

逻辑回归是一种广泛应用于分类问题的机器学习算法。它使用Logistic函数将输入特征映射到一个介于0和1之间的输出,表示某个类别的概率。

#### 2.1.1 逻辑回归的概念

逻辑回归是一种监督学习算法,用于解决二分类或多分类问题。它通过拟合特征与目标变量之间的关系,从而进行分类预测。

#### 2.1.2 逻辑回归的假设

逻辑回归建立在线性回归的基础上,假设特征之间是线性相关的,并且服从高斯分布。此外,假设因变量服从伯努利分布。

#### 2.1.3 逻辑回归的模型

逻辑回归模型基于Logistic函数,其数学表达式为:$$ P(y=1|x) = \frac{1}{1 + e^{-\theta^T X}} $$ 这里,$P(y=1|x)$表示在给定输入$x$条件下$y=1$的概率,$\theta$为模型参数,$X$为输入特征。

### 2.2 逻辑回归与线性回归的区别

#### 2.2.1 输入变量的类型

逻辑回归处理的输入变量可以是离散特征或连续特征,而线性回归通常处理连续型特征。

#### 2.2.2 输出变量的类型

逻辑回归的输出是已知一条数据属于某一类的概率,输出为概率值;而线性回归的输出是连续的数值。

#### 2.2.3 损失函数的选择

逻辑回归使用对数损失函数(Log Loss),而线性回归通常使用均方误差(MSE)作为损失函数。

在实际应用中,选择逻辑回归还是线性回归取决于数据本身的特性以及问题的实际需求。

### 示例代码:

```python

import numpy as np

from sklearn.linear_model import LogisticRegression

# 创建逻辑回归模型对象

model = LogisticRegression()

# 训练模型

model.fit(X_train, y_train)

# 预测结果

predictions = model.predict(X_test)

```

逻辑回归在分类问题中表现出色,可以适用于各种领域,如医疗健康、金融、电商等。

# 3. 逻辑回归模型优化

逻辑回归虽然是一种简单而有效的分类算法,但在实际应用中,我们需要对模型进行一定的优化,以提高其性能和泛化能力。本章将重点讨论逻辑回归模型的优化方法,包括特征工程、模型评估与选择、正则化与过拟合等方面。

### 3.1 特征工程

在逻辑回归中,特征工程是非常重要的一环,合理的特征工程可以有效提高模型的表现。下面我们将逐步介绍特征工程的一些优化方法。

#### 3.1.1 特征选择

特征选择是指从原始特征中选取出对目标变量有重要影响的特征,去除无效或冗余的特征,以简化模型并提高预测性能。常见的特征选择方法包括Filter方法、Wrapper方法和Embedded方法。

```python

# 使用SelectKBest进行特征选择

from sklearn.feature_selection import SelectKBest

from sklearn.feature_selection import chi2

selector = SelectKBest(chi2, k=5)

X_new = selector.fit_transform(X, y)

```

#### 3.1.2 特征缩放

在逻辑回归中,特征缩放对模型性能也有很大影响。通常情况下,可以使用标准化或归一化方法将特征缩放到相同的尺度范围,以确保模型训练的稳定性。

```python

# 使用MinMaxScaler进行特征缩放

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

X_scaled = scaler.fit_transform(X)

```

#### 3.1.3 特征构建

特征构建是指根据领域知识或特征之间的关系构造新的特征,以增强模型的拟合能力。常见的特征构建方法包括多项式特征生成和交互特征生成。

```python

# 使用PolynomialFeatures进行特征构建

from sklearn.preprocessing import PolynomialFeatures

poly = PolynomialFeatures(degree=2)

X_poly = poly.fit_transform(X)

```

### 3.2 模型评估与选择

模型评估是判断模型性能优劣的关键环节,只有通过准确的评估方法才能选择出最优的模型。接下来我们将介绍逻辑回归模型常用的评估指标和选择方法。

#### 3.2.1 混淆矩阵

混淆矩阵是评估分类模型预测性能的重要工具,能够显示模型在不同类别上的预测准确性。混淆矩阵包括真正例、假正例、真反例、假反例等四个重要指标。

| | 预测正例 | 预测反例 |

| ---- | -------- | -------- |

| 正例 | TP | FN |

| 反例 | FP | TN |

#### 3.2.2 准确率、召回率、F1值

除了混淆矩阵外,准确率、召回率和F1值是评估二分类模型性能的常用指标。准确率指模型预测正确的样本数量占总样本数量的比例,召回率指实际正例中被模型预测为正例的比例,F1值综合考虑了准确率和召回率。

```python

# 计算准确率、召回率和F1值

from sklearn.metrics import accuracy_score, recall_score, f1_score

accuracy = accuracy_score(y_true, y_pred)

recall = recall_score(y_true, y_pred)

f1 = f1_score(y_true, y_pred)

```

#### 3.2.3 ROC曲线与AUC值

ROC曲线是衡量分类模型对不同类别的分类性能的曲线,横轴为假正例率,纵轴为真正例率。AUC值则是ROC曲线下的面积,用于综合评价模型的性能,AUC值越接近1,模型性能越好。

```python

# 绘制ROC曲线并计算AUC值

from sklearn.metrics import roc_curve, roc_auc_score

import matplotlib.pyplot as plt

fpr, tpr, thresholds = roc_curve(y_true, y_pred)

auc = roc_auc_score(y_true, y_pred)

plt.pl

```

0

0