【强化学习在电力系统中的应用】:智能电网调控的创新思路与实践

发布时间: 2024-09-02 15:01:32 阅读量: 290 订阅数: 55

# 1. 强化学习与电力系统基础

## 1.1 强化学习概述

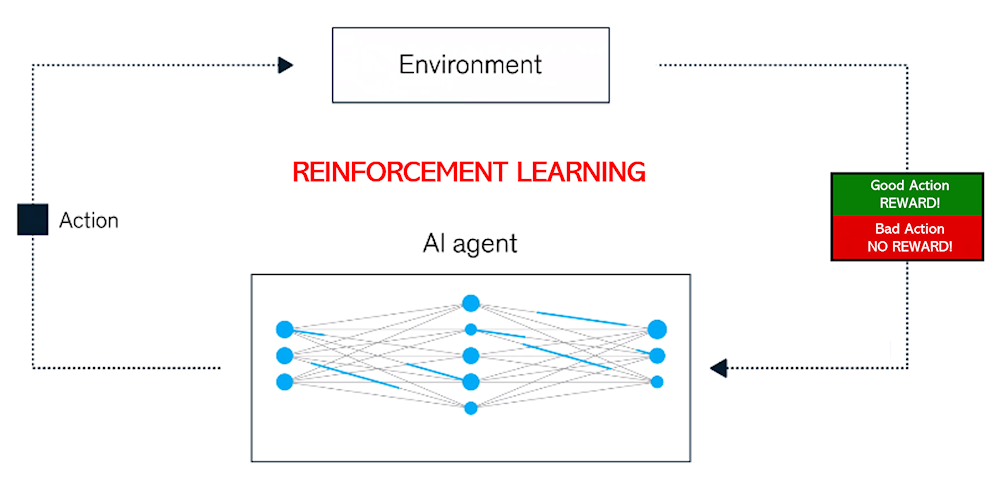

强化学习(Reinforcement Learning, RL)是人工智能领域中的一种学习方法,它通过让智能体在环境中进行尝试和探索,根据获得的反馈(奖励或惩罚)来优化决策过程。在电力系统中,强化学习被用于处理各种决策问题,如资源分配、负载平衡和故障响应。RL的独特之处在于其能够处理复杂的、长期的决策过程,这对于现代电力系统的稳定和高效运行至关重要。

## 1.2 电力系统基本概念

电力系统由发电、输电、变电、配电和用电等多个环节构成,是一个高度复杂且动态变化的网络。为确保系统稳定运行,电力工程师需不断优化电力资源的分配和调度。然而,传统方法往往无法高效解决电力系统中的非线性、多变量和随机特性问题,而强化学习提供了一种新的解决方案框架。

## 1.3 强化学习与电力系统的融合前景

将强化学习应用于电力系统,可以极大提高智能电网的自适应能力和决策的优化水平。通过学习环境反馈,强化学习模型能够预测系统行为并自动调整操作策略,从而提高系统效率、降低成本,并增强系统的稳定性和可靠性。随着研究的深入和技术的发展,强化学习有望在电力系统中发挥更大的作用。

```mermaid

graph LR

A[电力系统] -->|决策优化| B(强化学习)

B -->|自动化控制| C[提高效率与稳定性]

C -->|持续学习| A

```

该流程图展示了强化学习如何与电力系统相结合,实现持续的决策优化和系统性能提升。随着这一领域研究的推进,我们可以期待电力系统将变得更加智能化和高效。

# 2. 强化学习在电力系统中的理论应用

## 2.1 强化学习的概念与算法

### 2.1.1 马尔可夫决策过程(MDP)的基础

在强化学习(Reinforcement Learning, RL)的理论框架中,马尔可夫决策过程(Markov Decision Processes, MDPs)是核心概念之一。MDP是一个用于模拟决策者(即智能体)在环境中做出决策,并获得反馈(奖励或惩罚)的过程模型。MDP由五个部分组成:状态空间(S)、动作空间(A)、状态转移概率(P)、奖励函数(R)和折扣因子(γ)。

- **状态空间(S)**:表示环境可能处于的所有状态的集合。

- **动作空间(A)**:表示在每个状态下智能体可以采取的所有可能动作的集合。

- **状态转移概率(P)**:描述了在给定当前状态和动作的情况下,环境状态转移到下一个状态的概率。

- **奖励函数(R)**:指定在特定状态下采取特定动作时智能体获得的即时奖励值。

- **折扣因子(γ)**:是一个介于0和1之间的值,表示未来奖励相对于即时奖励的折现程度。

MDP模型的目标是找到一个策略,该策略能最大化智能体在长时间范围内的累积奖励。

### 2.1.2 强化学习算法概述:Q-learning与深度Q网络(DQN)

强化学习算法可以分为值函数估计方法(Value-based methods)和策略梯度方法(Policy gradient methods)。其中,Q-learning是一种值函数估计的经典算法,而深度Q网络(Deep Q Networks, DQN)则是将Q-learning与深度学习相结合的创新算法。

**Q-learning**算法是一种无模型的离线学习算法,它直接学习状态-动作对(state-action pairs)的值函数,即Q值。Q值表示在特定状态下采取特定动作的期望回报。Q-learning的目标是通过不断尝试和错误,找到最优的Q值函数,即Q*。智能体利用最优Q值函数来进行决策,从而最大化其累积奖励。

**深度Q网络(DQN)**是将Q-learning与深度神经网络结合,用于处理大规模状态空间的问题。DQN使用神经网络来估计Q值函数,并通过经验回放和目标网络来提高学习过程的稳定性和收敛速度。DQN在很多复杂游戏环境中取得了巨大的成功,为解决复杂现实问题提供了可行的范例。

## 2.2 电力系统的智能调控问题

### 2.2.1 智能电网调控的挑战与需求

随着可再生能源的广泛接入和电力消费结构的日益复杂,智能电网调控面临新的挑战。首先是需求侧管理,传统的电网调控无法适应消费模式的快速变化,而智能化的需求响应可以通过用户行为的调控,提高电网的经济性和稳定性。其次,分布式能源资源的接入,如太阳能和风能,这些间歇性能源的波动性要求电网调控系统具备更高的灵活性和自适应能力。此外,为了应对电网故障和极端天气条件,电力系统需要具备快速恢复供电的能力。

智能电网调控系统需要满足以下需求:

- **高效性**:在大规模分布式能源接入下,保持电网运行效率。

- **可靠性**:在各种条件下保证电力供应的可靠性。

- **经济性**:优化电网运行成本,实现经济调度。

- **安全性**:保护电网免受各种威胁和攻击,确保数据和物理安全。

- **可持续性**:促进可再生能源的高效利用,支持可持续发展。

### 2.2.2 强化学习解决调控问题的优势分析

强化学习在智能电网调控中的应用展现了其独特的优势。首先,它可以处理具有高维度状态空间和连续动作空间的复杂控制问题。其次,强化学习不需要详尽的系统模型,能够通过与环境的互动学习出最优策略。此外,它可以很好地处理不确定性和动态变化,这对于电力系统的实时调控非常重要。

具体来说,强化学习在电力系统调控中的优势主要体现在:

- **自适应性**:强化学习算法能自动调整控制策略以适应电网的动态变化。

- **在线学习能力**:可以在不中断服务的情况下,实时更新控制策略。

- **多目标优化**:通过奖励设计,强化学习可以同时考虑效率、成本、可靠性和可持续性等多个目标。

- **模型灵活性**:可以使用深度学习模型模拟电网的非线性特性。

## 2.3 强化学习模型在电力系统的建模与仿真

### 2.3.1 建模电力系统的环境与状态

在强化学习模型中,电力系统环境的建模是指定义电力系统的状态、动作以及状态转移过程。电力系统可以被建模为一个具有多个状态和动作的动态系统,其中包括:

- **状态表示**:包括电网运行中的实时负荷、发电量、电压、频率等参数。

- **动作空间**:指调控系统可执行的操作,如开关操作、有功和无功功率调整等。

- **环境动态**:描述了状态如何随时间变化,通常由电力系统的物理规则和操作约束决定。

状态空间需要设计得既能够反映电网的运行特性,又足够简单以便于模型处理。

### 2.3.2 模拟电力系统的动态过程与奖励机制

在强化学习模型中,模拟电力系统的动态过程是通过状态转移概率来实现的,这需要对电力系统的动态行为有充分的认识。奖励机制的设计至关重要,它直接决定了学习到的控制策略是否能够满足调控目标。奖励函数通常设计为:

- **成本奖励**:减少运行成本、提升能效。

- **可靠性奖励**:提高供电可靠性,减少停电。

- **安全奖励**:确保系统稳定运行,避免故障。

- **可调度性奖励**:提升系统的灵活性和响应速度。

模拟过程中的

0

0