深度解析HDFS架构:datanode工作机制全解析及性能调优指南

发布时间: 2024-10-29 05:12:40 阅读量: 46 订阅数: 21

深入 Hadoop 的心脏:HDFS 架构解析与工作机制

# 1. HDFS架构概述

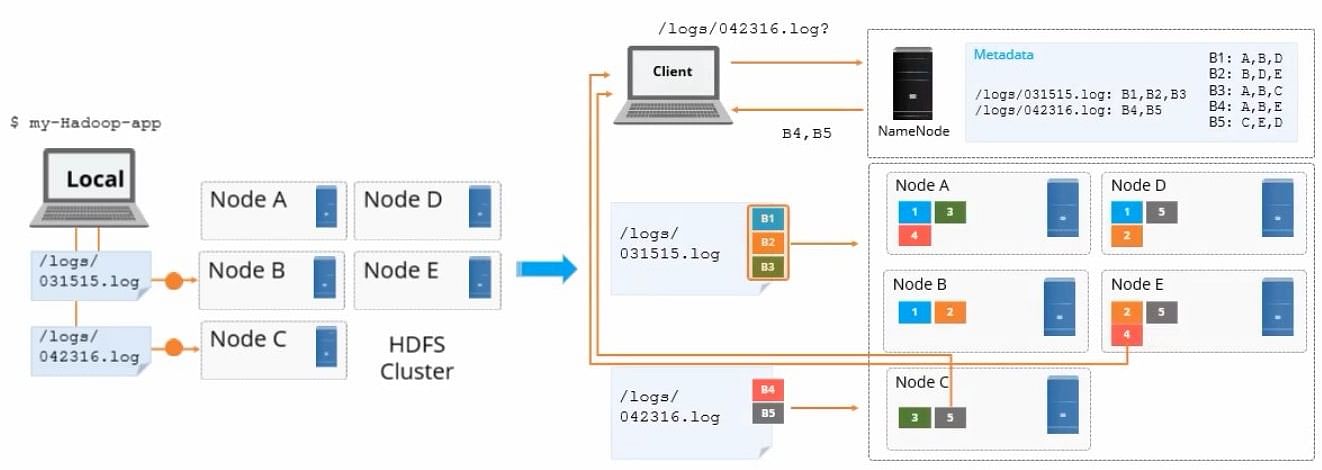

Hadoop分布式文件系统(HDFS)作为大数据生态系统的核心组件,提供了一个高吞吐量、可靠的存储平台,能够处理海量数据集。HDFS由一个NameNode(主服务器)和多个DataNodes(数据服务器)构成。NameNode负责管理文件系统的元数据,如文件命名空间和客户端访问权限等。而DataNodes则负责实际存储数据,为数据块的存储和检索提供服务。本章将探讨HDFS的基本架构,理解各个组件的作用以及如何协同工作,为数据的读写提供高性能、高可靠性的存储解决方案。

# 2. Datanode工作机制

### 2.1 Datanode的角色与职责

Datanode在Hadoop分布式文件系统(HDFS)中扮演着至关重要的角色,它负责存储实际的数据块,并提供数据的读写服务。在这一部分中,我们将深入了解Datanode的职责,特别是它如何处理数据存储和恢复,以及块管理和报告。

#### 2.1.1 数据存储和恢复

Datanode负责数据块的存储和在失败后恢复数据块,以保证数据的持久性和可靠性。

**数据存储机制**

数据块在写入时,会由Datanode进行切分和存储。每个Datanode负责管理一部分磁盘空间,并将这些空间划分为块。HDFS的数据块默认大小为128MB(Hadoop 2.x版本之前为64MB),较大块大小意味着较少的文件元数据,从而提高性能。

**数据恢复流程**

当Datanode发生故障时,NameNode会检测到Datanode心跳的缺失,并将此Datanode标记为死亡状态。此时,Datanode上存储的数据块副本数量减少,NameNode会启动复制过程以恢复数据块的副本数,保证数据的副本数满足HDFS的冗余策略。

```java

// 假设的代码段,展示Datanode上的数据存储和恢复机制的一部分

public class DataNode {

public void storeBlock(Block block, DataInputStream dataInputStream) {

// 存储数据块的逻辑

}

public void recoverBlock(Block block) {

// 数据块恢复的逻辑

}

}

```

**参数和配置**

- `dfs.replication`: 设置HDFS中数据块的默认副本数。

- `dfs.namenode.heartbeat.recheck-interval`: 心跳检查间隔,用于确定Datanode是否失效。

#### 2.1.2 块管理与报告

Datanode管理着本地存储上的数据块,并定期向NameNode发送数据块报告。

**块管理**

Datanode负责维护本地数据块的元数据,包括每个数据块的校验和。在数据写入或读取时,Datanode会使用校验和来验证数据块的完整性。

**数据块报告**

Datanode定期向NameNode发送数据块报告,报告中包含它所管理的数据块的列表。这些报告有助于NameNode维护整个文件系统的元数据信息。

```java

// 假设的代码段,展示Datanode发送数据块报告给NameNode的一部分

public class DataNode {

public BlockReport generateBlockReport() {

// 生成数据块报告的逻辑

return new BlockReport();

}

}

```

**表格展示**

为了更清晰地展示Datanode的工作细节,这里提供一个示例表格:

| Datanode职责 | 功能描述 | 相关配置参数 |

| ------------------ | ---------------------------------- | --------------------- |

| 数据存储 | 管理本地磁盘上的数据块 | dfs.block.size |

| 数据恢复 | 故障后自动恢复数据块 | dfs.namenode.heartbeat |

| 块管理 | 维护本地数据块的元数据 | fs.checkpoint.dir |

| 数据块报告 | 定期向NameNode报告数据块信息 | dfs.namenode.handler |

在实际操作中,Datanode通过内部机制实现这些职责,如定期与NameNode通信,以及在数据变更时同步元数据。

### 2.2 Datanode与NameNode的通信

Datanode与NameNode之间的通信是HDFS保持正常运行的关键,本节中我们将分析Datanode的心跳机制和数据复制过程。

#### 2.2.1 心跳机制详解

心跳机制是Datanode向NameNode报告健康状况的机制。

**心跳信号**

Datanode通过心跳信号定期向NameNode发送自己的存活状态。心跳信号通常包括数据块报告和Datanode统计信息。如果在指定时间内没有心跳信号,NameNode会认为该Datanode失效。

**代码块与逻辑分析**

```java

public class DataNode {

public HeartbeatResponse heartbeat(HeartbeatRequest heartbeatRequest) {

// 处理心跳请求的逻辑,心跳请求包括块报告和统计信息

// 如果超过设定时间未收到心跳,则标记为失效

return new HeartbeatResponse();

}

}

```

**心跳间隔**

心跳间隔是一个重要的配置参数,它决定了Datanode与NameNode通信的频率。这个参数需要平衡性能和可靠性。

#### 2.2.2 数据复制与负载均衡

数据复制和负载均衡是确保数据高可用性和整体性能的关键。

**数据复制**

当新的数据块写入时,NameNode会指定多个Datanode作为副本的目的地。Datanode收到数据后会将数据复制到其他Datanode,确保副本数满足冗余策略。

**负载均衡**

负载均衡的目的是优化集群性能,防止数据分布不均。通过动态调整副本位置,可以在Datanode之间均匀地分配数据块。

```java

public class NameNode {

public void replicateBlocks(Block block, List<DataNode> destinationDataNodes) {

// 数据复制逻辑,将数据块发送到目标Datanode

}

public void balanceDataNodes() {

// 负载均衡逻辑,平衡各个Datanode之间的数据块分布

}

}

```

### 2.3 Datanode故障处理与恢复

当Datanode发生故障时,HDFS需要采取措施来保障数据的完整性和集群的稳定性。在本节中,我们将探索故障检测机制以及数据块的重新复制策略。

#### 2.3.1 故障检测机制

故障检测是通过心跳机制来实现的,当NameNode在预设的心跳超时时间内没有收到Datanode的心跳信号时,会认为该Datanode发生故障。

**故障检测的流程**

1. Datanode定时发送心跳信号给NameNode。

2. 如果NameNode在一个周期内未收到心跳信号,则会重新尝试联系Datanode。

3. 经过一定次数的尝试后,若依然没有响应,则将Datanode标记为故障状态。

**故障检测的代码逻辑**

```java

// 假设代码段,展示NameNode处理故障Datanode的逻辑

public class NameNode {

public void detectFailedDataNodes() {

// 逻辑:遍历所有Datanode,检查它们的心跳信号

// 如果超过超时设定,则标记为故障

}

}

```

#### 2.3.2 数据块的重新复制策略

为了确保数据的冗余性,当Datanode发生故障时,NameNode会启动数据块的重新复制过程。

**重新复制的步骤**

1. NameNode识别出失效Datanode的数据块。

2. 选择新的Datanode作为数据块的存储位置。

3. 将失效Datanode上的数据块复制到新的Datanode上,直到达到配置的副本数。

**重新复制的代码示例**

```java

// 假设代码段,展示如何启动数据块重新复制过程

public class NameNode {

public void replicateBlocksForFailedDataNode(DataNode failedDataNode) {

// 逻辑:获取失效Datanode上存储的数据块信息

// 选择新的Datanode并启动数据块复制

}

}

```

在故障处理和数据块恢复的过程中,HDFS的可靠性得以体现。通过这样的机制,确保了数据不会因为单点故障而丢失,同时也保证了整个集群的稳定性。

# 3. Datanode性能监控与分析

### 3.1 Datanode性能监控工具

#### 3.1.1 JMX和Metrics

JMX(Java Management Extensions)提供了一种标准的管理Java应用程序的方法。Hadoop的Datanode暴露了多种JMX MBean,通过这些MBean可以获取到Datanode的实时性能数据,包括但不限于内存使用率、线程数、垃圾回收统计信息等。为了简化监控过程,社区提供了Metrics库,它可以用来收集和报告系统运行时的各种指标数据。通过这些工具,系统管理员可以实时监控Datanode的性能,并通过可视化工具(例如Grafana)展示这些数据,及时发现潜在问题。

```java

// 通过代码示例展示如何获取Datanode的JMX连接

import javax.management.MBeanServerConnection;

import javax.management.remote.JMXConnector;

import javax.management.remote.JMXConnectorFactory;

import javax.management.remote.JMXServiceURL;

public class JMXExample {

public static void main(String[] args) throws Exception {

String jmxUrl = "service:jmx:rmi:///jndi/rmi://<datanode-ip>:<port>/jmxrmi";

JMXServiceURL url = new JMXServiceURL(jmxUrl);

JMXConnector connector = JMXConnectorFactory.connect(url);

MBeanServerConnection mbsc = connector.getMBeanServerConnection();

// 代码逻辑继续,执行获取具体的性能数据

}

}

```

#### 3.1.2 Ganglia和Nagios

Ganglia是一个基于集群的分布式监控系统,它可以用于监控大规模高性能集群和网格环境。它特别适合于Datanode这样需要实时性能数据监控的场景。Ganglia利用RRDTool的数据存储和绘图特性,能够高效地收集和展示Datanode的性能数据。

Nagios是一个开源的监控系统,可以用于监控系统和网络。Nagios通过安装特定的插件来监控Datanode的健康状况和性能指标。当检测到问题时,Nagios会发送告警,以便运维人员及时处理问题。

### 3.2 性能瓶颈诊断

#### 3.2.1 网络I/O监控

网络I/O是分布式存储系统中重要的性能指标之一。对Datanode的网络I/O进行监控可以使用`iftop`或`nethogs`等工具来检测网络流量和带宽使用情况。此外,Hadoop本身提供了基于Web的界面,其中包含集群的I/O吞吐量数据,这些数据可以帮助管理员确定是否是网络I/O导致的性能瓶颈。

```bash

# 使用iftop监测特定接口的网络流量

iftop -i <interface-name>

```

#### 3.2.2 磁盘I/O瓶颈分析

磁盘I/O性能同样对HDFS至关重要。使用`iostat`工具可以获取磁盘I/O的实时性能数据,这包括每秒读写次数、吞吐量等。Hadoop管理员应该关注磁盘的读写速率,尤其是在高并发环境下。如果发现有磁盘I/O瓶颈,可能需要增加更多的磁盘或调整数据块的分布策略。

```bash

# 使用iostat监测磁盘I/O

iostat -dx <interval> <count>

```

### 3.3 性能数据的解读与应用

#### 3.3.1 日志分析与解读

Hadoop日志中包含了丰富的运行时信息,分析日志是诊断问题和监控性能的常规手段。对于Datanode的性能监控,需要特别关注日志中的错误和警告信息。通常,Hadoop的日志文件位于`$HADOOP_HOME/logs/`目录下。管理员可以使用如`logstash`或`fluentd`等日志管理工具,将日志统一收集和分析。

#### 3.3.2 性能报告的生成和审查

性能报告是对Datanode性能监控结果的总结。它通常包括资源使用率、请求处理时间、错误和异常统计等关键性能指标。Hadoop自带的`jhat`工具可以用来分析内存转储文件,而`hadoop fsck`命令可以用来检查文件系统健康状况。通过这些工具可以生成性能报告,方便定期审查和优化。

```bash

# 使用hadoop fsck检查文件系统健康状况

hadoop fsck / -files -blocks -locations

```

在下一章节中,我们将深入探讨如何对Datanode进行性能调优。我们会涉及到硬件优化、配置参数调整以及软件层面的优化措施,这些措施能帮助提升Datanode的整体性能,优化其在大规模数据处理场景下的表现。

# 4. Datanode性能调优实践

## 4.1 硬件层面的优化

### 4.1.1 存储介质的选择

在Hadoop集群中,Datanode负责存储实际的数据块,因此选择合适的存储介质是提升性能的关键一步。由于HDFS的数据流主要由顺序读写操作组成,因此可以使用SATA接口的硬盘(HDD)来作为存储介质,尤其是当数据需要频繁读写时。为了提升性能和可靠性,可以考虑使用固态硬盘(SSD),这能够减少读写延迟并提高吞吐量。

另一个选择是使用RAID技术,尽管Hadoop本身已经对数据进行了冗余备份,但是RAID可以进一步提升数据的安全性和性能。例如,使用RAID 10不仅可以获得较好的读写性能,还能在硬盘故障时保持数据的完整性。

### 4.1.2 网络配置与优化

除了存储介质,网络配置也是影响Datanode性能的重要因素。数据在各个节点间传输时,网络带宽和延迟直接影响整个集群的运行效率。在硬件层面,可以通过以下方式优化网络配置:

1. **提升带宽**: 使用高速以太网卡(如10GbE)以减少数据传输的瓶颈。

2. **降低延迟**: 优化网络拓扑结构和路由策略,减少数据传输距离和节点间跳数。

3. **网络隔离**: 将NameNode的管理流量和Datanode之间的数据流量进行隔离,确保关键管理命令的快速响应。

4. **网络协议优化**: 使用适合大规模分布式系统的网络协议,比如RoCE(RDMA over Converged Ethernet)或InfiniBand,以减少数据传输的延迟。

为了更细致地掌握网络使用情况,可以使用网络监控工具(如Wireshark或Nagios)来监控和分析网络流量,确保网络配置符合Hadoop集群的性能需求。

## 4.2 HDFS配置参数的调整

### 4.2.1 缓存池和数据块大小设置

在HDFS配置中,可以调整多个参数来优化Datanode的性能。首先是数据块(block)的大小,它影响了磁盘I/O和内存的使用效率。默认的数据块大小是128MB,但在某些情况下,根据数据访问模式和硬件特性,可以调整这个值。

例如,对于处理大型文件的工作负载,使用较大的数据块大小会减少NameNode的元数据压力,同时减少需要读写的次数。而处理许多小文件时,则可能需要减小数据块大小以避免过多的空闲空间。

另一个可调优的参数是缓存池(cache pool),它可以将热数据(即经常被访问的数据)从磁盘移动到内存中,从而提高读取性能。通过配置`dfs.namenode.host.cache.size`和`dfs.hosts.cache renovate interval`等参数,可以有效地利用内存资源提升数据访问速度。

### 4.2.2 宕机恢复与数据复制策略调整

HDFS通过数据副本保证了数据的高可用性。默认情况下,每个数据块会有三个副本,分别存储在不同的Datanode上。这样的机制可以保证当一个节点发生故障时,数据仍然可用。

在某些特定场景下,可以调整复制策略以优化性能和资源使用。例如,在高可用性要求不高的情况下,可以减少副本数量以减少存储压力和带宽消耗。相反,如果数据重要性极高,可以适当增加副本数量。

调整数据块的放置策略也是一个优化方向。例如,通过设置`dfs.replication.scatter`和`dfs.replication pierce`参数,可以控制数据块在集群中的分散程度,避免单点故障的风险。

## 4.3 软件层面的优化

### 4.3.1 JVM参数优化

Java虚拟机(JVM)的优化对于Datanode的性能也有显著影响。可以通过调整JVM的堆大小和垃圾收集器(GC)来减少延迟和提升吞吐量。

例如,对于具有大量内存的Datanode,可以增加堆大小(-Xmx参数)来缓存更多的数据块,减少磁盘I/O操作。同时,选择适合的垃圾收集器也非常重要。G1 GC适合大规模堆内存管理,它可以减少停顿时间,是Datanode的不错选择。

在使用JVM进行性能优化时,应该注意内存泄漏和性能瓶颈的问题,定期使用分析工具(如MAT或VisualVM)进行堆转储分析,确保JVM运行效率。

### 4.3.2 GC调优对性能的影响

垃圾收集(GC)是JVM内存管理的重要组成部分,GC调优可以帮助Datanode更好地管理内存。根据应用的工作负载和内存使用模式,选择合适的垃圾收集策略可以显著改善性能。

如果Datanode承担了大量的读写操作,长时间运行时可能会因为GC导致的停顿影响性能。在这样的场景下,可以考虑使用并发垃圾收集器如CMS或G1 GC,它们能够在应用程序运行时进行部分垃圾收集工作,从而减少停顿时间。

在调整GC参数时,需要注意以下几点:

- 调整新生代(Young Generation)和老年代(Old Generation)的堆内存比例,以适应不同的内存使用模式。

- 观察GC日志,了解GC活动的频率和持续时间,以便做出调整。

- 根据Datanode的性能指标来测试不同的GC设置,找到最佳配置。

## 总结

在本章中,我们深入探讨了Datanode性能调优的多个方面,从硬件选择到软件配置,再到参数的精细调整。我们强调了硬件层面的存储和网络优化的重要性,并详细介绍了HDFS配置参数的调整方法,包括数据块大小、缓存池、数据复制策略等。最后,我们还探讨了软件层面的JVM参数优化,以及GC调优对性能的影响。

通过这些调优策略,可以有效提升Datanode的工作效率,从而提高整个HDFS集群的性能。在实际应用中,每个集群的具体情况可能不同,调优应根据实际负载、硬件资源和业务需求进行有针对性的调整。通过不断测试和优化,可以找到最适合自己集群的性能调优方案。

# 5. HDFS架构扩展与未来展望

Hadoop分布式文件系统(HDFS)作为大数据存储的核心组件,随着数据量的剧增和技术的发展,不断地面临新的挑战和机遇。本章节将深入分析HDFS的可扩展性问题,探讨HDFS与新兴技术的融合,以及HDFS未来可能的发展方向。

## 5.1 HDFS架构的扩展性分析

### 5.1.1 水平扩展的限制与方案

HDFS设计之初就考虑到了水平扩展的能力,即通过增加更多的Datanodes来提高存储容量和计算能力。但是,在实践中我们发现,水平扩展并不是无限制的,它会受到多种因素的制约。

- **网络带宽和延迟**:随着集群规模的扩大,数据在各个节点间的传输延迟成为显著的瓶颈。

- **NameNode的扩展性问题**:作为整个HDFS的核心,NameNode的性能和稳定性对集群扩展性有着决定性影响。单点的NameNode在处理大规模集群状态时可能成为瓶颈。

为了克服这些限制,社区提出了多个方案,比如:

- **联邦HDFS**:引入多个NameNode进行管理不同的命名空间,以此来分散管理压力。

- **HDFS高可用性架构**:通过增加多个Standby NameNode,实现故障切换,提高系统的可用性和扩展性。

### 5.1.2 多数据中心的管理与挑战

多数据中心的管理是另一个扩展性的挑战。企业为了数据安全和业务连续性,往往需要在不同地理位置建立数据中心。然而,HDFS在设计时并未充分考虑到跨数据中心的数据管理和同步问题。

- **数据一致性**:在多个数据中心之间同步数据,保持数据一致性是一个重大挑战。

- **网络延迟**:跨地域的数据传输会有更高的网络延迟,对数据操作的响应时间产生负面影响。

- **数据备份和灾难恢复**:多个数据中心还需要考虑数据备份和灾难恢复策略。

为解决这些问题,可以采取以下措施:

- **使用HDFS联邦**:通过联邦架构,可以跨越不同的数据中心进行有效的数据管理。

- **跨数据中心复制**:实施数据的跨数据中心复制策略,以支持灾难恢复和数据备份。

## 5.2 新兴技术与HDFS的融合

### 5.2.1 云原生与容器化

随着云原生技术和容器化应用的兴起,HDFS也需要适应这些变化,以便更好地在现代云计算环境中部署和运行。

- **容器化部署**:容器化可以简化HDFS的部署过程,并提高其在云环境中的可移植性。

- **资源管理优化**:容器化允许HDFS更高效地利用资源,因为容器可以动态分配和回收资源,而无需重启服务。

### 5.2.2 HDFS与大数据生态系统的整合

HDFS作为大数据生态系统的核心组件之一,它与其他组件(如Spark、Hive、HBase等)的整合程度直接影响到整个生态系统的效率。

- **数据共享与访问**:HDFS需要提供高效的机制来支持与其他大数据组件的数据共享和访问。

- **生态系统的协同优化**:通过整合生态系统中的组件,可以实现端到端的优化,比如在Spark中直接读写HDFS数据,减少了数据移动的开销。

## 5.3 HDFS的未来发展方向

### 5.3.1 社区路线图与长期愿景

HDFS社区致力于持续改进和更新HDFS,以适应不断变化的技术趋势和用户需求。

- **社区活跃度**:社区的活跃程度是HDFS发展的关键因素之一,它关系到新功能的引入和旧问题的解决。

- **技术演进**:社区将不断引入新技术,如机器学习和人工智能,以提升HDFS的智能化程度。

### 5.3.2 面向未来数据存储的挑战与机遇

面对未来数据存储的挑战与机遇,HDFS有潜力:

- **提升数据访问效率**:在数据量日益增加的情况下,如何快速有效地访问和处理数据是HDFS需要解决的问题。

- **数据安全与隐私保护**:随着数据隐私法规的日益严格,HDFS在保证数据安全和用户隐私方面也需要不断进步。

HDFS的未来发展方向将围绕这些挑战展开,旨在提供一个更加健壮、高效和安全的分布式存储解决方案,以满足大数据时代的需求。

0

0