【数据去重专家】:datanode上的数据重复识别与处理技巧

发布时间: 2024-10-29 05:39:06 阅读量: 34 订阅数: 21

基于Hadoop的大数据处理平台设计与实现.docx

# 1. 数据去重的基本概念和重要性

在当今信息爆炸的时代,数据去重作为数据处理的一项基础工作,显得尤为关键。通过对原始数据进行去重处理,可以有效提升数据质量,保障数据的准确性和一致性,减少存储空间,提升查询效率。本章将深入探讨数据去重的基本概念,阐述其在数据分析和管理中的重要性。

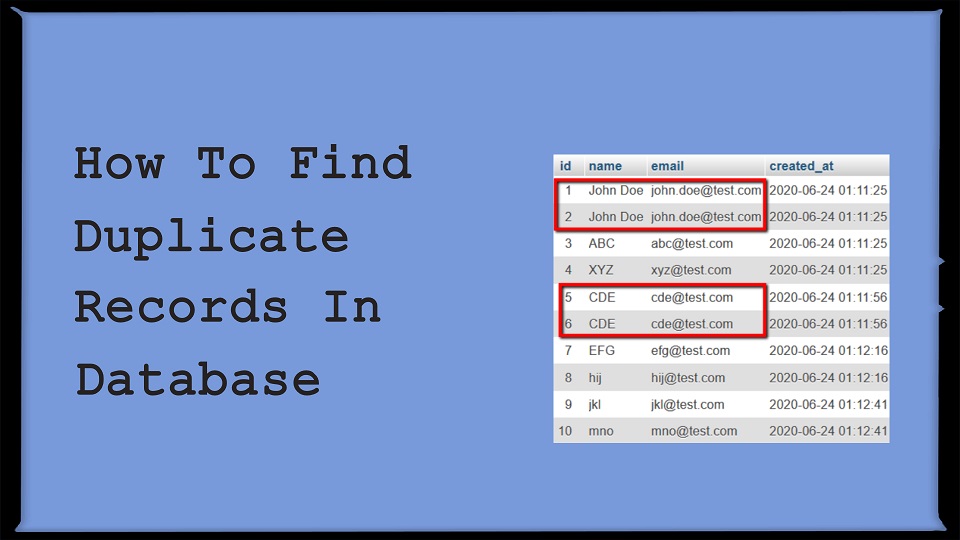

## 1.1 数据去重的定义

数据去重指的是从数据集中移除重复记录的过程,确保每个数据项在数据集中只出现一次。这一概念在关系型数据库、数据仓库以及大数据处理中都十分重要。

## 1.2 数据去重的重要性

数据去重不仅影响到数据质量的提升,也直接关联到数据处理的效率和准确性。例如,在数据分析中,去重可以确保分析结果不受重复数据的干扰;在数据集成中,去重是保证数据一致性的重要步骤。

## 1.3 数据去重的现实应用场景

从企业的客户信息管理,到政府的公民信息整理,数据去重的应用场景广泛,贯穿了数据处理的每一个环节,是数据科学和信息技术不可忽视的基本功。

# 2. 数据去重的理论基础

## 2.1 数据去重的定义和原理

### 2.1.1 数据去重的定义

数据去重,顾名思义,是指从数据集合中移除重复数据项的过程。在数据存储、管理和分析的过程中,重复的数据不仅浪费存储空间,还可能影响数据查询、分析的准确性。通过去重,我们能够得到唯一且准确的数据视图,这是数据去重的基本定义。

### 2.1.2 数据去重的原理

数据去重的基本原理是识别并区分数据集中重复的记录,然后选择性地保留或移除这些记录。在技术层面上,去重操作依赖于数据记录的唯一性标识,如主键、唯一索引等。为了保证去重的准确性,需要对数据进行充分的分析,明确哪些字段组合能够唯一标识一条记录。

## 2.2 数据去重的算法和方法

### 2.2.1 常见的去重算法

常见的去重算法包括哈希表法、排序法和分治法等。哈希表法通过构建哈希表快速定位重复数据;排序法则通过排序并逐个比较相邻记录来识别重复项;分治法则将数据分块处理,分别去重后再合并结果。每种算法都有其适用场景和优缺点,选择合适的方法至关重要。

### 2.2.2 去重方法的选择和应用

选择合适的去重方法需要考虑数据的大小、分布和可用资源等因素。例如,在内存充足的情况下,使用哈希表法可以迅速完成去重;而在处理海量数据时,可能需要采用分布式去重策略。应用时,通常还会结合实际数据特性进行算法优化,以达到最佳的去重效果。

## 2.3 数据去重的性能优化

### 2.3.1 去重性能的影响因素

去重性能受多种因素影响,包括但不限于数据的大小、格式、索引和硬件性能等。大数据量和复杂的数据结构可能拖慢去重速度。此外,数据索引的建立和维护也会消耗额外的计算资源。

### 2.3.2 去重性能的优化方法

针对去重性能的优化方法有多种。例如,在数据去重前进行数据预处理,如数据清洗和压缩,可以减少去重时的工作量。使用更加高效的算法,比如自适应的哈希表大小调整或改进的排序算法等,也能显著提高去重效率。此外,分布式去重策略可以充分利用多核处理能力,进一步提升性能。

```mermaid

graph TD;

A[数据去重性能优化] -->|预处理| B(数据清洗);

A -->|预处理| C(数据压缩);

A -->|算法优化| D(自适应哈希表);

A -->|算法优化| E(改进排序算法);

A -->|分布式计算| F(多核并行处理);

B --> G[提升数据处理速度];

C --> H[减少去重操作的数据量];

D --> I[降低哈希冲突概率];

E --> J[减少排序时间];

F --> K[利用更多计算资源];

```

为了优化性能,通常采取的措施不仅限于单一的优化方法,而是多种方法的结合使用。这要求我们深入理解去重过程中每一步对性能的影响,才能做出更合理的优化决策。

# 3. ```

# 第三章:数据去重的实践操作

在数据处理领域,理论知识是基础,实践操作是关键。没有实践操作,理论知识无法转化为解决实际问题的工具。本章将介绍数据去重的实践操作流程,包括工具的选择、环境搭建、数据预处理、去重操作和结果验证等步骤。为了更好地说明,本章将结合案例进行分析。

## 3.1 数据去重的工具和环境搭建

### 3.1.1 去重工具的选择

在开始数据去重之前,首先需要选择合适的去重工具。市场上存在多种去重工具,包括但不限于开源软件、商业软件、编程语言内置功能等。

- **开源软件**:如Python中的Pandas库,能够通过简单的函数调用来完成数据的去重。另外,命令行工具如`awk`, `sed`等也可以用于文本数据的去重。

- **商业软件**:例如Excel,具有直观的界面和强大的数据处理功能,适用于小规模的数据去重操作。对于大规模数据处理,可以使用专门的ETL工具如Talend或Informatica。

- **编程语言内置功能**:如SQL中的`DISTINCT`语句,Java的Set集合等,都可以完成简单的数据去重。

在选择去重工具时需要考虑到数据的规模、格式、处理需求等因素。对于大规模数据集,建议选择能够高效处理大数据的工具,如支持分布式计算的Hadoop生态中的工具(例如Hive)。

### 3.1.2 环境搭建和配置

为了进行数据去重,可能需要搭建特定的环境。这包括安装操作系统、数据库、数据处理软件等。以使用Python和Pandas库进行数据去重为例,下面展示了环境搭建的步骤:

1. 安装Python

```

0

0