【数据恢复秘籍】:datanode故障后数据重建与日志分析技巧

发布时间: 2024-10-29 05:24:16 阅读量: 23 订阅数: 21

Hadoop守护者:NameNode与DataNode故障恢复全攻略

# 1. 数据恢复的基础知识

数据恢复是指从受损、格式化、丢失或无法访问的存储介质中提取数据的过程。随着信息技术的快速发展,数据已成为企业的重要资产,确保数据的完整性和可恢复性变得至关重要。

## 数据丢失的原因

数据丢失可能由多种原因引起,包括硬件故障(如硬盘损坏)、软件故障(如意外删除或格式化)、用户错误操作、病毒攻击等。理解数据丢失的原因是预防和恢复数据的第一步。

## 数据恢复的基本流程

数据恢复流程通常包括以下几个步骤:

1. **备份验证** - 确认现有备份的有效性。

2. **故障诊断** - 识别数据丢失的原因和范围。

3. **数据恢复方案设计** - 根据故障类型和数据重要性制定恢复计划。

4. **恢复执行** - 使用专业工具或手工方法执行数据恢复。

5. **数据验证** - 确认恢复的数据完整性和准确性。

6. **数据备份** - 对恢复的数据进行备份,以防止未来的数据丢失风险。

在执行数据恢复之前,还需要考虑数据安全和隐私保护的问题,特别是对于敏感数据。接下来的章节将深入探讨数据恢复在大数据环境中的应用,故障诊断,以及高级数据恢复技术和最佳实践。

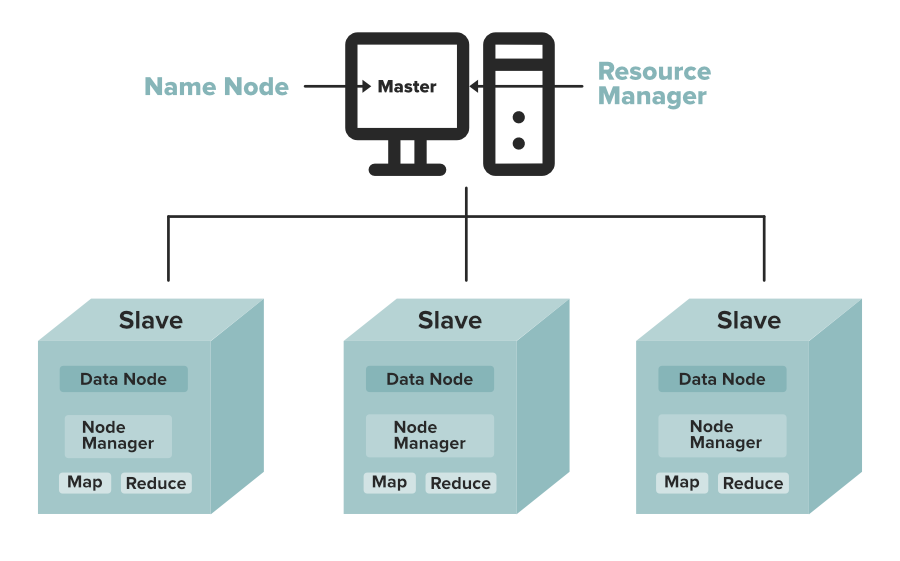

# 2. Hadoop架构与datanode故障解析

在当今的大数据时代,Hadoop已经成为处理大规模数据集的重要工具。其中,Hadoop分布式文件系统(HDFS)特别以其高容错性和高效的数据处理能力著称。datanode是HDFS的核心组件之一,负责存储实际的数据块,但其故障可能会对整个数据存储系统造成严重影响。本章将深入探讨Hadoop的架构,以及datanode可能出现的故障,及其诊断和解析方法。

## 2.1 Hadoop生态系统简介

### 2.1.1 Hadoop核心组件

Hadoop是一个开源框架,由Apache软件基金会支持,它允许使用简单编程模型在商品服务器集群上分布式处理大数据。Hadoop的核心组件包括:

- Hadoop Common:包含可以使用在Hadoop系统中的库以及Hadoop的各个模块运行所需要的Java库。

- Hadoop Distributed File System(HDFS):一个分布式文件系统,用于存储大量数据并提供高吞吐量的数据访问。

- Yet Another Resource Negotiator(YARN):用于作业调度和集群资源管理。

- Hadoop MapReduce:一个YARN为基础的系统用于并行处理大数据。

### 2.1.2 datanode的作用与特点

datanode是HDFS中负责存储数据块的节点,是Hadoop分布式文件系统的核心组件之一。datanode的特点和作用包括:

- **数据存储**:它直接存储用户数据的各个块。

- **数据复制**:数据块会被复制到多个datanode上,以提供容错性。

- **负载均衡**:通过在不同的datanode间动态移动数据块,它有助于保持集群的负载均衡。

- **简单设计**:datanode的结构设计很简单,可以很容易地扩展。

## 2.2 datanode故障的常见原因

datanode故障可能是由多种原因引起的,下面将探讨一些常见的故障原因。

### 2.2.1 硬件故障

硬件故障是导致datanode故障的主要原因之一,包括:

- **硬盘故障**:数据存储介质损坏会导致数据不可访问。

- **内存故障**:内存不足或损坏可能会导致datanode无法正确读写数据。

- **网络硬件问题**:网络连接不稳定或硬件故障会导致datanode与其它节点通信失败。

### 2.2.2 软件配置错误

软件配置错误同样可能导致datanode故障,可能包括:

- **配置文件错误**:错误的配置文件参数可能使得datanode启动失败。

- **权限问题**:文件系统权限设置不当可能导致进程无法读写数据。

- **版本不兼容**:不同版本的Hadoop组件间可能存在兼容性问题。

### 2.2.3 网络问题

网络问题也可能造成datanode的故障,例如:

- **网络分区**:导致集群内的节点无法相互通信。

- **网络延迟**:高延迟会阻塞数据传输,影响数据读写效率。

- **防火墙或安全策略**:不正确的网络策略可能会限制datanode间的正常通讯。

## 2.3 故障诊断与日志分析

为了快速定位和解决datanode故障,诊断和分析日志是十分关键的。

### 2.3.1 Hadoop日志的重要性

Hadoop日志文件记录了运行期间的各种信息,包括:

- **运行状态**:Hadoop系统运行的实时状态和历史记录。

- **错误信息**:发生错误时,日志文件中会包含错误详情和堆栈跟踪。

- **性能指标**:关键性能指标可以帮助系统管理员监控Hadoop集群的性能。

### 2.3.2 常用的日志分析工具和方法

在Hadoop生态中,有几个常用的工具用于日志分析:

- **日志滚动**:Hadoop提供滚动机制,可以定期切换日志文件,便于管理。

- **日志级别**:设置不同的日志级别(如INFO, WARN, ERROR),可以帮助管理员过滤重要信息。

- **日志聚合**:利用工具如Apache Flume或Apache NiFi可以将分散的日志聚合到一个中心位置。

- **日志可视化工具**:如Grafana、Elasticsearch配合Kibana等,可以提供图形化的日志分析。

接下来,让我们进一步深入了解日志结构与内容,以及如何运用高级日志分析技巧,为datanode的故障诊断提供更有价值的信息。

# 3. 数据重建的理论与实践

## 3.1 数据备份与恢复策略

### 3.1.1 备份策略概述

数据备份是数据恢复的前提,只有确保数据已经安全备份,才能在数据丢失或损坏时进行有效的数据恢复。备份策略的设计需要考虑数据的重要性、备份成本、恢复时间目标(RTO)、恢复点目标(RPO)等关键因素。常见的备份策略包括全备份、增量备份和差异备份。

- 全备份:复制所有选定的数据,是最全面的备份形式。缺点是备份时间长,消耗存储空间多。

- 增量备份:仅备份自上次备份以来发生变化的数据。相比全备份,增量备份节省了时间和存储空间。

- 差异备份:备份自上次全备份以来发生变化的数据。与增量备份相比,差异备份在恢复时需要结合最后一次全备份和最后一次差异备份,但恢复速度相对较快。

为了实现更灵活、高效的备份策略,可以采用备份集的组合,比如每周全备份一次,每天进行一次差异备份,而在工作日的其他时间进行增量备份。

### 3.1.2 恢复策略实施步骤

数据恢复不仅仅是一个技术过程,更是一个系统工程,涉及流程规划、技术实施和风险控制等多个环节。以下是数据恢复策略实施的基本步骤:

1. **评估情况**:首先需要评估灾难发生的情况,包括数据损坏的范围、数据丢失的量、系统受影响的程度等。

2. **选择恢复策略**:根据备份策略和灾难评估的结果,选择合适的恢复策略。可能的选项包括直接从备份中恢复、使用镜像进行恢复,或者从最近的全备份和增量备份中进行逐步恢复。

3. **恢复备份数据**:按照选定的策略,将备份数据恢复到原始位置或指定的新位置。

4. **数据完整性验证**:恢复完毕后,需要验证数据的完整性,确保没有数据损坏或丢失。

5. **系统恢复与测试**:恢复操作系统和应用程序,并进行测试以确保数据恢复成功,系统运行正常。

6. **审核与反

0

0