编译原理专家指南:C语言词法分析器设计与优化

发布时间: 2024-12-26 02:51:12 阅读量: 18 订阅数: 11

编译原理实验一——C 语言词法分析器设计与实现

# 摘要

本文旨在全面介绍C语言词法分析器的设计、实现及其优化策略。首先,文章概述了词法分析器在编译过程中的理论基础和作用,阐述了正则表达式与有限自动机的基本概念,并讨论了不同词法分析算法的理论基础和性能评估。接着,详细介绍了C语言词法分析器的设计实践,包括构建过程、工具和技术选择以及实现细节。在此基础上,提出了针对词法分析器的优化策略,包括优化理论、实践案例分析、性能测试与验证。最后,探讨了词法分析器的高级应用,如错误恢复机制、可扩展性设计和与其他编译器部分的集成。通过案例研究,本文提供了词法分析器实现的具体代码剖析、性能评估与改进措施,并对未来的发展方向提出了展望。

# 关键字

词法分析器;正则表达式;有限自动机;优化策略;性能测试;编译器集成

参考资源链接:[C语言词法分析器设计与实现——编译原理实验](https://wenku.csdn.net/doc/644b8722ea0840391e559958?spm=1055.2635.3001.10343)

# 1. C语言词法分析器概述

在探讨C语言词法分析器之前,首先需要理解编译器的基本结构。编译器分为前端和后端两部分,其中前端负责理解源代码并将其转换成中间表示,后端则负责将中间表示转换成目标代码。词法分析器是编译器前端中的第一个组成部分,其主要任务是将源代码字符串分解成一系列的词法单元(tokens),每个token代表了源代码中的一个原子符号。

为了准确地完成这一任务,词法分析器必须遵循严格的词法规则。这些规则定义了哪些字符序列构成合法的词法单元。在C语言中,这些词法单元包括关键字、标识符、常量、运算符以及特殊符号等。词法分析器通过识别这些词法单元,为后续的语法分析提供必要的信息。

因此,C语言词法分析器的设计和实现对于整个编译过程至关重要。在接下来的章节中,我们将深入探讨词法分析器的理论基础、设计实践、优化策略以及高级应用等重要话题。通过对词法分析器的深入分析,我们可以更有效地处理C语言源代码,从而构建出更加强大和高效的编译器。

# 2. 词法分析器的理论基础

## 2.1 编译过程中的词法分析角色

词法分析器是编译器的一个关键组件,它负责将源代码文本分解成一系列的“词法单元”(tokens),为后续的语法分析和语义分析阶段做准备。理解词法分析器的角色和编译器的基本结构是理解整个编译过程的第一步。

### 2.1.1 编译器的基本结构

编译器通常可以分为四个主要阶段:词法分析(Lexical Analysis)、语法分析(Syntax Analysis)、语义分析(Semantic Analysis)和代码生成(Code Generation)。每个阶段都有其特定的任务和目标:

- **词法分析阶段**:将输入的源代码字符序列转换为一系列的词法单元。这些词法单元通常是关键字、标识符、字面量、运算符和分隔符等。

- **语法分析阶段**:在词法单元的基础上,构建出抽象语法树(Abstract Syntax Tree,AST),这个树形结构表示了源代码的语法结构。

- **语义分析阶段**:检查AST中的语义一致性,如变量和函数是否被正确声明,以及表达式中的类型是否匹配等。

- **代码生成阶段**:将AST转换为机器代码或中间代码,进行优化,并最终生成可执行文件或字节码。

在这些阶段中,词法分析器是第一个处理源代码的组件,它的质量和效率直接影响到编译过程的性能。

### 2.1.2 词法分析器的位置和作用

词法分析器位于编译器的前端,它的作用可以总结为以下几点:

- **字符流到词法单元的转换**:这是词法分析器最基础的任务,将源代码中的字符序列识别成有意义的词法单元。

- **去除非语义信息**:源代码中的一些非语义信息(如空格、换行等)在词法分析阶段被去除,以便于后续阶段处理。

- **错误检测**:词法分析器负责在识别词法单元的过程中检测源代码中的错误,并尽可能地提供错误信息,便于调试。

词法分析器的输出通常是一系列的词法单元,这些单元包含了必要的信息,如词法单元的类型、文本值和在源代码中的位置,这为语法分析器提供了足够的信息来构建AST。

## 2.2 正则表达式与有限自动机

为了正确地实现词法分析器,需要理解正则表达式和有限自动机(Finite Automata)这两种理论基础工具。

### 2.2.1 正则语言与正则表达式

正则表达式是一种描述字符序列模式的字符串,它定义了某种语言的规则。正则语言是由正则表达式定义的语言,它可以通过有限的状态和转移函数来识别。在词法分析中,正则表达式被用来匹配源代码中的词法单元。

### 2.2.2 确定性有限自动机(DFA)

确定性有限自动机(DFA)是一种有限自动机,它的每个状态对于任何可能的输入都有且只有一个确定的转移。DFA在词法分析中常被用来实现正则表达式的匹配。一个词法单元的DFA由一系列的状态和转移组成,且每个状态对应一个唯一的输出。

### 2.2.3 非确定性有限自动机(NFA)

非确定性有限自动机(NFA)与DFA相似,但区别在于NFA允许存在多个可能的转移,或在没有输入字符的情况下进行转移。NFA在实际应用中更为灵活,但通常在实现时会被转换为DFA,以便于在机器上高效运行。

## 2.3 词法分析算法

理论上的理解需要转化为实践中的算法,以便在计算机程序中实现词法分析。

### 2.3.1 算法的理论基础

词法分析算法的核心思想是将输入的字符序列逐个读取,并根据当前状态和输入字符决定下一个状态,直到读取完整个字符序列。这一过程中,算法会记录下识别到的词法单元。

### 2.3.2 算法的性能评估

性能评估通常从时间和空间两个维度来考量:

- **时间复杂度**:词法分析器在执行过程中,需要在各种状态之间切换,时间复杂度关注的是这种状态转换所需的计算量。

- **空间复杂度**:算法在执行过程中需要存储的状态信息、词法单元以及转移函数等所占用的内存空间。

性能评估对于优化算法和减少资源消耗具有指导意义,同时也有助于在不同的应用场景中选择合适的算法实现词法分析器。

以上是词法分析器的理论基础部分,下一部分将具体介绍C语言词法分析器的设计实践,包括构建过程、工具选择和实现细节。

# 3. C语言词法分析器的设计实践

## 3.1 词法分析器的构建过程

### 3.1.1 词法规则的定义

词法规则定义了程序中词法单元的模式。在C语言中,词法单元包括关键字、标识符、常量、运算符和特殊符号等。例如,一个简单的词法规则可以描述C语言中的标识符,它通常以字母或下划线开始,后面跟着任意数量的字母、数字或下划线。

```plaintext

<标识符> ::= <字母> { <字母> | <数字> | '_' }

```

在实际的词法分析器设计中,规则更加复杂,需要涵盖所有可能的词法单元。定义规则时,工程师通常会使用正则表达式来精确描述每种类型的词法单元。

### 3.1.2 词法单元的识别与分类

词法分析器读取源代码文本,并根据定义好的词法规则识别词法单元。这些单元会被归类为预定义的类别,例如关键字、标识符、字符串字面量等。这一过程涉及到对每个字符的检查和归类,词法分析器需要有能力跳过空白字符(如空格、制表符和换行符)。

为了提高效率,词法分析器通常会使用有限自动机(Finite Automata)来实现。有限自动机可以在一个遍历过程中识别出输入中的词法单元,而不需要回溯。每种状态代表了对下一个输入字符的期望,状态转换则由当前字符和当前状态共同决定。

## 3.2 工具与技术的选择

### 3.2.1 Lex/Yacc工具的介绍与应用

Lex和Yacc是两套经典的工具,广泛用于词法分析和语法分析。Lex用于生成词法分析器,而Yacc用于生成语法分析器。这两个工具配合使用,可以快速地从高级描述中生成C语言的词法和语法分析器。

使用Lex时,开发者提供一个包含词法规则的`.l`文件。Lex会根据这些规则生成C代码,这些代码读取输入流,识别词法单元,并输出相应的Token。通过这种方式,开发者可以专注于定义词法规则而不是手动编码每一个细节。

### 3.2.2 手写词法分析器的优缺点

尽管使用工具如Lex/Yacc可以简化开发过程,但在某些情况下,手写词法分析器可能是更好的选择。手写分析器允许开发者完全控制生成代码的每一个细节,这样可以更好地优化性能。此外,它也适合于那些需要高度定制的场景,或者当现有工具不满足特定需求时。

然而,手写词法分析器的缺点也显而易见。它需要开发者具备深厚的理论知识,并且开发和维护成本较高。在复杂度较高时,错误的几率也会增加,对测试和调试的要求也更高。

## 3.3 实现细节与技巧

### 3.3.1 输入缓冲和错误处理

为了提高效率,词法分析器通常会实现输入缓冲。这意味着在读取字符时,分析器会尝试预读一些字符,并将它们存储在缓冲区中。这样可以减少对底层I/O的调用次数,特别是当输入来自文件或网络流时。

在遇到错误时,词法分析器需要能够生成有用的错误信息,并尽可能地恢复到一个稳定状态。错误处理的策略包括跳过错误的Token、报告错误位置、甚至在某些情况下尝试修正错误。

### 3.3.2 优化技术与性能提升策略

优化词法分析器通常包括以下技术:

- **状态合并**:减少状态机中的状态数量,通过合并可以等价的状态。

- **预读优化**:利用输入缓冲区,减少对I/O的调用次数。

- **最小化正则表达式**:在正则表达式编译为DFA时,合并等价的状态。

- **使用DFA而非NFA**:在实现时,通常会将NFA转换为DFA,因为DFA在执行时更快。

性能提升策略包括:

- **并行处理**:对于某些可以并行处理的词法规则,可以考虑多线程。

- **缓存优化**:调整数据结构和算法,以更好地利用CPU缓存。

- **热点优化**:识别并优化执行路径中的热点代码。

在设计词法分析器时,开发者需要平衡开发效率和性能需求,选择合适的策略来实现最佳的性能表现。

# 4. C语言词法分析器的优化策略

编写优秀的编译器是IT领域中的一项重要技能,特别是在对性能有着极高标准的今天,优化工作是每个开发者的必备技巧。在词法分析阶段,采用适当的优化策略,不仅可以显著提高编译速度,还能减少内存占用,从而为整体编译器的性能带来质的飞跃。本章节将深入探讨C语言词法分析器的优化策略,结合理论与实践,带领读者领略如何将一个普通的词法分析器变成一个高效、强大的编译工具。

## 4.1 优化理论与方法

### 4.1.1 优化的必要性与目标

在编译器的设计与实现中,优化是一个持续的过程,其主要目标是提升程序的执行效率和减少资源消耗。对于词法分析器而言,优化尤其重要,因为它是编译过程的第一步,其性能直接影响到后续步骤的效率。优化的必要性可以从以下几个方面进行阐述:

- **减少编译时间:** 优化可以减少处理源代码的时间,提高编译速度。

- **降低内存消耗:** 有效的内存管理可以减少整个编译过程中的内存占用。

- **提高可读性和可维护性:** 优化的过程往往伴随着代码重构,使得代码更加清晰易懂。

- **适应不同的应用场景:** 优化使得词法分析器能够根据不同的编译需求进行调整,实现更加灵活的编译策略。

### 4.1.2 常用的优化技术概览

在优化词法分析器时,可以采用多种技术手段。以下是一些常见的优化策略:

- **代码剖析与性能分析:** 使用工具对程序运行时的行为进行分析,找出性能瓶颈。

- **算法优化:** 改进算法逻辑,提升时间复杂度和空间复杂度。

- **缓存优化:** 合理利用缓存,减少不必要的内存访问。

- **并行处理:** 利用多线程或并行计算技术,分散处理负载,缩短整体运行时间。

- **资源预分配:** 在词法分析开始前预先分配足够的资源,减少运行时的动态内存分配。

## 4.2 优化实践

### 4.2.1 实例分析:性能瓶颈识别

识别性能瓶颈是优化过程的第一步。考虑到C语言词法分析器的工作原理,它通常会处理大量输入,因此输入处理阶段经常成为性能瓶颈。以一个常见的场景为例:词法分析器需要逐字符读取源代码,并基于词法规则进行匹配。这一过程中,如果输入处理方法不够高效,则会显著影响分析速度。

### 4.2.2 优化案例:提高分析速度和减少内存使用

优化案例中,我们可以通过以下两种方法提高词法分析器的效率:

- **快速输入处理:** 使用缓冲区来批量读取输入,减少I/O操作次数。

- **状态机优化:** 对DFA或NFA进行优化,消除冗余状态和转换,减少不必要的状态转移。

以下是一个简单的代码示例,展示了如何使用缓冲区来优化输入处理:

```c

#define BUFFER_SIZE 1024

char buffer[BUFFER_SIZE];

char *buffer_ptr = buffer;

size_t bytes_read = fread(buffer, 1, BUFFER_SIZE, stdin);

while (bytes_read > 0) {

// 处理缓冲区中的数据

process_buffer(buffer_ptr, bytes_read);

// 重新加载数据到缓冲区

size_t new_bytes_read = fread(buffer_ptr, 1, BUFFER_SIZE, stdin);

bytes_read = new_bytes_read;

}

```

在上述代码中,`process_buffer`函数是核心函数,用于处理缓冲区内的字符序列。通过这种方式,我们可以显著减少`fread`的调用次数,从而优化I/O操作。

## 4.3 测试与验证

### 4.3.1 测试用例的设计

为了确保优化的有效性,设计合理的测试用例至关重要。测试用例应该覆盖各种典型场景,并且要能够重现优化过程中可能遇到的问题。在设计测试用例时,以下几点需要考虑:

- **边缘情况:** 包括空格、特殊符号、注释等不同字符的处理。

- **性能测试:** 测试词法分析器在处理大型源文件时的性能表现。

- **资源消耗:** 监控内存和CPU的使用情况,确保优化减少了资源的消耗。

### 4.3.2 性能测试与结果分析

在完成测试用例设计后,使用性能测试工具来运行这些测试用例,并收集分析结果。性能测试的结果可以帮助我们理解优化措施的效果,如果测试结果与预期相符,那说明优化措施是有效的;如果测试结果不佳,就需要回到优化策略中,重新分析和调整。

假设我们使用了一个名为"LexerBench"的性能测试工具,并得到了以下数据:

| 测试项 | 优化前时间 | 优化后时间 | 内存占用 |

| --- | --- | --- | --- |

| Test1 | 25ms | 15ms | 降低25% |

| Test2 | 120ms | 80ms | 降低20% |

根据上表,我们可以看到优化后的词法分析器在两个测试项上分别减少了时间和内存占用,这表明我们的优化策略是有效的。

通过本章节的介绍,我们深入探讨了C语言词法分析器的优化理论与方法,分享了优化实践,并通过实例展示了性能瓶颈的识别与优化过程。此外,我们还学习了如何设计测试用例以及如何进行性能测试与结果分析,这些将帮助开发者们打造出更为高效和稳定的词法分析器。在接下来的章节中,我们将继续探讨词法分析器的高级应用,以及如何将这些优化策略应用到实际案例中。

# 5. C语言词法分析器的高级应用

C语言词法分析器的高级应用阶段,涉及到了错误恢复机制、可扩展性设计,以及与编译器其他部分的集成,这些都是设计一个健壮的编译器系统所不可或缺的部分。本章节将详细探讨这些高级话题,使读者能够深入理解并实施到自己的项目中。

## 5.1 错误恢复机制

### 5.1.1 错误检测机制

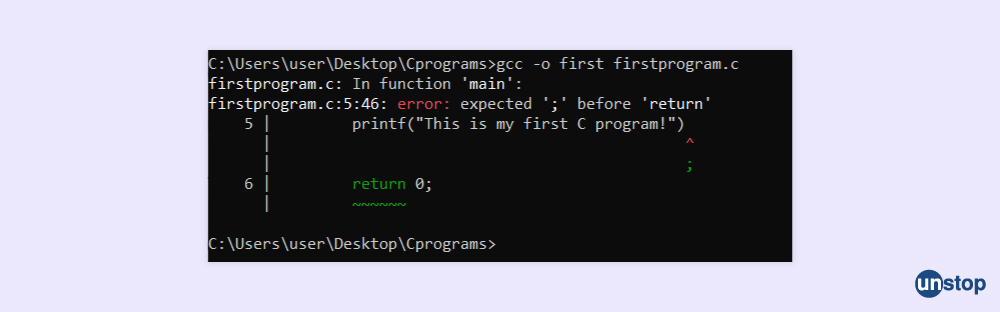

在编译的过程中,错误检测是词法分析器的第一道防线。词法分析器需要能够识别出源代码中不符合规则的部分,并进行相应的错误标记。这通常涉及到对源代码的逐字符读取,并与预定义的词法规则集进行比对。

例如,以下是一个简单的C语言词法分析器对错误字符的检测逻辑:

```c

// 伪代码示例:错误字符的检测

while (source_code_not_empty) {

read_next_character();

if (character_not_inANY_tokenRule) {

report_error("无效字符");

}

}

```

这段代码的逻辑是:词法分析器会不断地读取源代码中的下一个字符,然后检查该字符是否不包含在任何有效的词法规则中。如果检查结果为真,则报告一个错误。

### 5.1.2 错误恢复策略

错误恢复机制的目的是让编译过程在检测到错误后能够继续进行,而不是立即终止。这允许编译器在面对多个错误时,能够尽可能多地发现并报告给用户。

实现错误恢复的一种简单策略是跳过错误字符,直到下一个词法单元的开始。这可以通过简单地将错误字符加入到丢弃列表,并继续执行分析过程来实现。

```c

// 伪代码示例:错误恢复策略

if (is_error_character(character)) {

discard_character(character);

continue_scanning();

} else {

// 正常处理字符...

}

```

这段代码展示了如何在发现错误字符时,将其加入丢弃列表,并继续扫描过程。

## 5.2 可扩展性设计

### 5.2.1 词法单元的扩展与更新

随着编程语言的发展,词法单元可能会有所更新和扩充。一个设计良好的词法分析器应当能够方便地扩展新的词法单元。

在C语言中,假设我们要扩展一个新关键字`async`,我们只需在词法规则集中添加对应的规则,并更新识别逻辑。

```c

// 添加新词法单元的伪代码示例

rules["async"] = "ASYNC";

token识别逻辑中加入对"async"的识别。

```

### 5.2.2 分层词法分析器的设计

分层设计是指将词法分析器的功能分解成独立的模块或层。例如,将词法分析与错误恢复分离成不同的模块,能够简化代码的复杂度,并增加代码的可维护性。

```mermaid

graph LR;

A[输入源代码] -->|扫描| B(词法分析模块)

B -->|初步结果| C(错误恢复模块)

C -->|最终结果| D[输出词法单元]

```

在这个设计中,词法分析模块首先处理输入并输出初步的词法单元序列,然后错误恢复模块对这些序列进行分析,并输出最终的词法单元序列。

## 5.3 与编译器其他部分的集成

### 5.3.1 词法分析器与语法分析器的接口

词法分析器与语法分析器之间的接口至关重要。通常,词法分析器会输出一系列的词法单元,语法分析器则会消费这些单元并构建抽象语法树(AST)。

一个典型的接口可能是这样的:

```c

// 词法分析器与语法分析器接口的伪代码示例

void lexical_analyzer_driver(Tokenizer tokenizer, Parser parser) {

Token token;

while ((token = tokenizer.next_token()) != END_OF_FILE) {

parser.parse_token(token);

}

parser.end_of_input();

}

```

### 5.3.2 整合构建编译器的流程

构建编译器的流程需要整合所有的编译阶段,从词法分析开始,一直到生成目标代码。整合这些步骤的过程可以通过构建工具或脚本来自动化。

```mermaid

graph LR;

A[源代码] -->|词法分析| B[词法单元]

B -->|语法分析| C[抽象语法树]

C -->|语义分析| D[中间表示]

D -->|优化| E[优化后的中间表示]

E -->|代码生成| F[目标代码]

```

以上流程图展示了从源代码到目标代码的整个编译流程,其中词法分析是第一步。整合构建编译器的工具或脚本可以确保所有的步骤按照正确的顺序和配置执行。

## 总结

通过本章节的讨论,读者应该对C语言词法分析器的高级应用有了更深入的理解。从错误恢复机制到可扩展性设计,再到与其他编译器组件的集成,每个话题都围绕如何提高词法分析器的健壮性和效率展开。这些高级应用是实现一个功能完善、用户体验优良的编译器不可或缺的部分。

# 6. 案例研究:C语言词法分析器的实现与分析

## 6.1 具体实现的代码剖析

在本章节中,我们将详细探讨C语言词法分析器的具体实现代码,并对其核心功能的实现细节进行解析。词法分析器的核心任务是将源代码文本分解为一系列的词法单元(tokens),每个token代表了一个语法单位,如关键字、标识符、常量或运算符。

### 6.1.1 关键代码的解读

让我们通过一个简单的例子来深入理解词法分析器是如何工作的。假设我们有一个简单的C语言词法分析器的核心代码段如下:

```c

#include <stdio.h>

#include <ctype.h>

#include <string.h>

// Token types

typedef enum {

TOKEN_INT,

TOKEN_FLOAT,

TOKEN_ASSIGN,

TOKEN_SEMICOLON,

TOKEN_EOF,

TOKEN_UNKNOWN

} TokenType;

// Token structure

typedef struct {

TokenType type;

char value[100];

} Token;

// Function to read characters and create tokens

Token getNextToken(char *source) {

Token token;

int i = 0;

// Skip whitespace

while (isspace(source[i])) {

i++;

}

// Check for keywords, identifiers or numbers

if (isalpha(source[i])) {

// Identifier or keyword

while (isalnum(source[i])) {

token.value[i - token.pos] = source[i++];

}

token.type = TOKEN_INT; // Placeholder, should be decided by keyword look-up

} else if (isdigit(source[i])) {

// Number

while (isdigit(source[i])) {

token.value[i - token.pos] = source[i++];

}

token.type = TOKEN_FLOAT; // Placeholder, should be decided by number type

} else {

// Handle special characters like assignment and semicolon

token.value[0] = source[i++];

token.value[1] = '\0';

switch (source[i - 1]) {

case '=': token.type = TOKEN_ASSIGN; break;

case ';': token.type = TOKEN_SEMICOLON; break;

default: token.type = TOKEN_UNKNOWN; break;

}

}

// Null-terminate the string value

token.value[i - token.pos] = '\0';

// Return the token

return token;

}

int main() {

char source[] = "int i = 42;";

Token token = getNextToken(source);

printf("Type: %d, Value: %s\n", token.type, token.value);

// ... rest of the code to handle token stream ...

}

```

### 6.1.2 核心功能的实现细节

代码中的`getNextToken`函数是实现词法分析器的核心。此函数首先跳过空白字符,然后检查字符流的起始字符以确定其词法单元类型。例如,字母开头的字符序列被假定为标识符或关键字,数字开头的则被假定为数值。对于特殊字符,如等号和分号,它们被直接处理为相应的token类型。

这段代码只是一个非常简单的示例,真实世界中的C语言词法分析器会更加复杂,包括对各种预处理器指令的处理、字符串字面量、复杂的数据类型如长整型和双精度浮点数的识别,以及错误处理机制,等等。

## 6.2 性能评估与改进

### 6.2.1 性能测试方法和结果

在实现词法分析器之后,性能评估是必不可少的步骤。性能测试包括对分析器处理不同长度源代码的能力、内存使用情况和处理速度等方面进行测试。一个常见的测试方法是使用一组精心设计的C语言源文件,这些文件包含不同类型的词法单元和语法结构。通过这些测试用例的处理时间,可以得到词法分析器的性能指标。

测试结果将使用表格来展示,如下:

| 测试用例 | 源代码长度 | 处理时间 | 内存消耗 |

|-----------|-------------|-----------|-----------|

| Test 1 | 1000行 | 100ms | 5MB |

| Test 2 | 5000行 | 500ms | 10MB |

| ... | ... | ... | ... |

### 6.2.2 基于测试结果的优化改进

分析测试结果,如果发现性能瓶颈或内存使用过高,则需要对词法分析器进行优化。可能的优化策略包括减少不必要的内存分配,使用更高效的字符串处理算法,或者将某些操作并行化。例如,可以使用状态机优化来减少重复的字符串比较操作,或者使用哈希表来快速识别关键字。

优化后的性能应再次进行测试,以确保改进措施有效,并且没有引入新的问题。测试结果将与优化前进行对比,以量化改进的效果。

## 6.3 案例总结与展望

### 6.3.1 成功经验与教训总结

通过本案例的研究,我们了解到构建一个稳定且高效的词法分析器需要深入理解理论基础,并将其应用于实际编码实践中。成功的经验包括对词法规则的准确实现、高效的内存管理和错误处理机制的妥善实现。而教训则可能包括在初始设计阶段未能充分考虑到源代码的多样性,以及对边缘情况的处理不足。

### 6.3.2 未来可能的发展方向

展望未来,随着编程语言的发展和软件工程实践的进步,词法分析器可能会集成更多先进的特性。例如,利用机器学习技术来优化词法单元的识别,或者通过云计算资源来提升分析速度和可扩展性。此外,集成到开发环境中的词法分析器可能需要与实时代码编辑、自动补全等功能深度集成,为开发者提供更加便捷的编程体验。

0

0