HDFS权限问题诊断与解决:写入数据时的关键步骤

发布时间: 2024-10-30 04:34:25 阅读量: 4 订阅数: 9

# 1. HDFS权限问题概述

Hadoop Distributed File System (HDFS) 是大数据环境中的核心组件,它负责存储和处理海量数据。随着数据量的增长,集群的使用者越来越多,HDFS权限管理问题日益凸显,成为保障数据安全和访问控制的关键。本章将概览HDFS权限问题,为读者提供一个初步的认识,并为后续章节更深入地探讨权限模型、诊断方法和解决方案打下基础。理解权限问题不仅是系统管理员的职责,也是每个数据科学家和工程师的必备技能,确保数据不被非法访问,同时又不妨碍业务的正常运行。接下来的章节将详细介绍HDFS的权限模型,权限问题的诊断和解决策略,以及如何通过最佳实践预防权限问题的发生。

# 2. HDFS权限模型理论

## 2.1 HDFS权限模型基础

### 2.1.1 用户、组与超级用户

在Hadoop分布式文件系统(HDFS)中,权限模型基础围绕着用户、组和超级用户的概念。每个使用HDFS的用户都属于一个特定的用户ID(UID),他们可以访问和操作文件与目录。同样,为了方便权限的管理和分配,用户可以被组织成组,组内成员共享相同的权限。

超级用户,通常指的是系统管理员,在HDFS中拥有全部的权限。超级用户可以执行任何操作,包括访问所有文件、修改权限、以及执行系统级别的任务。超级用户的权限是必须被谨慎管理的,因为不当的操作可能会导致系统的安全风险或数据损坏。

在处理权限问题时,通常需要明确区分超级用户和普通用户,尤其是在安全模式下,系统对超级用户的某些操作会有所限制,以防止潜在的风险。

### 2.1.2 权限和权限位的概念

HDFS权限模型基于Unix风格的读(r)、写(w)和执行(x)权限位。每个文件或目录都有与之关联的权限位集合,分别对应所有者(owner)、所属组(group)和其他用户(others)。

- 所有者(owner)权限位控制文件或目录所有者的访问权限。

- 所属组(group)权限位控制文件或目录所在组内其他用户的访问权限。

- 其他用户(others)权限位控制非文件或目录所有者及所属组的用户访问权限。

每个权限位可以单独设置或组合设置,如读权限(r)表示能够查看文件内容或目录中的文件名,写权限(w)表示可以修改文件或在目录中创建和删除文件,执行权限(x)通常用于目录,表示可以进入目录并访问子目录或子文件。

为了方便管理和查询权限,HDFS权限模型使用数字形式来表示这些权限位。例如,权限rwx对应数值7,其中读、写、执行权限分别对应数值4、2、1。组合权限则为对应的数值之和。因此,所有者具有读、写和执行权限的文件表示为777,而只有读权限则表示为444。

```bash

# 示例:设置文件权限为rwxrwxrwx(777)

hdfs dfs -chmod 777 /path/to/file

```

在上述命令中,`chmod`是改变模式的命令,数字777代表对所有用户类别赋予读、写和执行权限。这种权限设置允许所有用户对文件进行任何操作,但出于安全考虑,在实际应用中应避免这种过于宽松的权限设置。

## 2.2 HDFS权限检查机制

### 2.2.1 文件和目录的权限检查流程

HDFS在进行文件或目录操作时,会执行一个详细的权限检查流程。这个流程确保了只有具有适当权限的用户或组才能进行操作。当用户尝试执行对文件或目录的某种操作时,HDFS首先确认操作者的身份,然后检查操作对应的权限位是否允许该操作。

例如,如果用户想要读取一个文件,HDFS会检查该文件的所有者权限位是否包含读权限,然后检查组权限位,最后检查其他用户权限位。如果任何一级的权限检查失败,HDFS将阻止操作并返回权限拒绝的错误。

```bash

# 示例:查看文件权限和所属组

hdfs dfs -ls -h /path/to/directory

```

在上述命令中,`ls`命令用于列出目录内容,`-h`参数用于将文件大小以易读的格式显示。输出结果中会包括文件权限和所属组等信息。

### 2.2.2 超级用户与安全模式下的权限特殊处理

在HDFS的安全模式下,超级用户的权限会受到一定的限制,以防止数据恢复过程中的误操作。例如,在安全模式下,超级用户可能无法删除某些关键文件或目录,即使它们通常拥有完全的权限。

```bash

# 示例:查看HDFS安全模式状态

hdfs dfsadmin -safemode get

```

在上述命令中,`dfsadmin`用于管理HDFS文件系统的状态,`-safemode`参数用于获取安全模式的状态。输出结果将显示HDFS是否处于安全模式以及该模式下允许的操作。

超级用户在安全模式下可能需要使用特定的命令来覆盖默认的权限限制。在执行这些命令时,超级用户需要特别注意,因为错误的操作可能导致不可逆的后果。HDFS提供了`-force`参数来执行在安全模式下通常不允许的操作。

## 2.3 权限问题诊断前的准备工作

### 2.3.1 系统配置和版本检查

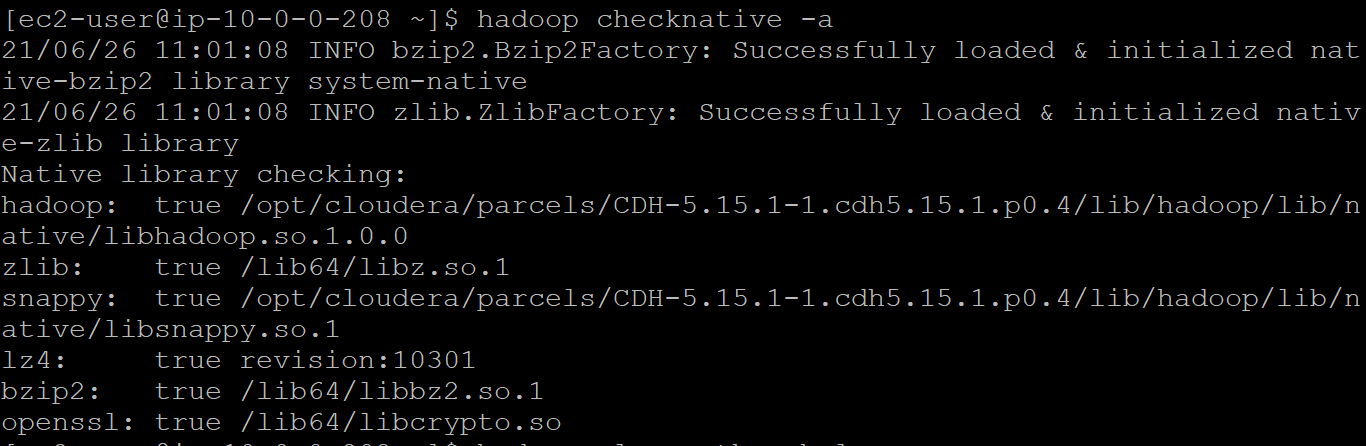

在诊断HDFS权限问题之前,首先需要确认Hadoop集群的系统配置和版本。不兼容的配置或过时的版本可能导致权限模型不符合预期,进而引发权限问题。

```bash

# 示例:检查Hadoop版本

hadoop version

```

上述命令会输出当前运行的Hadoop版本信息,这有助于判断系统是否运行着已知的、可能含有已修复权限问题的版本。

### 2.3.2 权限审计工具和日志分析基础

为了更有效地诊断权限问题,应熟悉和利用HDFS提供的权限审计工具。HDFS日志记录了所有文件操作的详细信息,包括权限检查的过程和结果,是诊断权限问题的关键资源。

```bash

# 示例:查看HDFS操作日志

hdfs dfs -getmerge /path/to/hadoop/logs /local/path/logs.txt

```

该命令将Hadoop集群的日志文件合并并复制到本地系统,便于进一步分析。查看日志文件时,通常需要关注权限相关的错误信息,如权限不足、访问被拒绝等。

```mermaid

graph LR

A[开始检查] --> B[确认Hadoop版本]

B --> C[确认系统配置]

C --> D[使用审计工具检查日志]

D --> E[分析错误信息]

E --> F[进行问题诊断]

```

在上述流程图中,从开始检查到使用审计工具检查日志,再到分析错误信息和进行问题诊断,形成了一套有效的诊断前准备工作流程。每一步都至关重要,为后续深入诊断和问题解决奠定了基础。

# 3. HDFS权限问题诊断方法

HDFS权限问题的诊断通常需要对Hadoop系统的权限模型和操作有深入的理解。这一章节将详细介绍诊断HDFS权限问题的一般流程,并说明如何利用HDFS命令行工具和日志监控工具来深入分析和解决权限问题。

## 3.1 权限问题的一般诊断流程

在对HDFS权限问题进行诊断前,需要确保已经对问题进行了准确的识别和重现。问题重现是诊断的起点,有助于理解问题发生的上下文环境。

### 3.1.1 识别和重现权限问题

首先,理解权限问题出现的上下文至关重要。通常需要回答以下问题来帮助定位问题:

- 问题是否在特定操作或用户行为后出现?

- 是否有新的配置更改或代码部署前后的日志?

- 权限问题是否总是与同一资源(文件或目录)相关联?

在收集到足够的信息后,尝试在测试环境中重现问题。这一步骤可以是手动操作,也可以通过脚本自动化地复现故障场景。

### 3.1.2 分析命令行输出和错误信息

一旦权限问题被重现,下一步是分析相关的命令行输出和错误信息。例如,查看尝试访问HDFS资源时产生的错误代码或信息。这些信息通常提供了权限问题的直接线索。

```bash

hdfs dfs -ls /path/to/directory

```

如果上述命令失败,可以查看返回的错误信息。例如,返回的错误可能是 `Permission denied`,说明当前用户没有足够的权限来列出该目录。

## 3.2 使用HDFS命令行工具进行诊断

HDFS提供了丰富的命令行工具来帮助用户诊断权限问题

0

0