HDFS常见问题诊断与解决方案:故障排除的10大指南

发布时间: 2024-10-28 14:20:11 阅读量: 72 订阅数: 48

--信息化工业化融合大数据平台建设方案.docx

# 1. HDFS故障排除概述

在大数据生态系统中,Hadoop分布式文件系统(HDFS)作为核心组件,承担着存储大量数据和保证数据高可用性的任务。然而,随着数据量的不断增长和计算需求的提升,HDFS在实际部署与应用中难免会遇到各种故障。本章节将为读者提供一个HDFS故障排除的概览,包括故障排查的重要性和基本流程。

故障排除不仅需要对HDFS的架构和工作原理有深刻理解,还要求能够准确识别不同类型的故障,并通过合理的方法进行诊断和修复。随着数据量的增长,有效的故障排除策略对于保障业务连续性和数据完整性至关重要。

本章将带领读者了解故障排除的必要性,并对HDFS中的常见故障进行分类。在此基础上,将会介绍一些关键的故障诊断工具和日志分析方法,这些都是排除HDFS故障不可或缺的技能。通过本章的学习,读者将具备HDFS故障排查的初步认识,并为接下来深入探讨HDFS的工作原理和故障解决策略奠定坚实的基础。

# 2. ```

# 第二章:HDFS的基本工作原理

Hadoop分布式文件系统(HDFS)是Hadoop的核心组件之一,被设计成能够在廉价硬件上存储大量数据的可靠存储方式。了解HDFS的基本工作原理是进行故障排除和优化的基础。

## 2.1 HDFS架构和组件

HDFS采用了主从(Master/Slave)架构,主要组件包括NameNode和DataNode,它们各自承担不同的职责。

### 2.1.1 NameNode和DataNode的作用

NameNode是HDFS的主节点,负责管理文件系统的命名空间,维护文件系统树及整个文件系统元数据,而DataNode则负责存储实际数据。DataNode会定期向NameNode发送心跳信号,报告自己的状态和已存储的数据块信息。

**代码块示例**:

```java

// 伪代码展示NameNode启动时注册DataNode的过程

public void start() {

while (!shutdown) {

for (DataNode node : dataNodes) {

registerDataNode(node);

}

monitorHeartbeat();

}

}

private void registerDataNode(DataNode node) {

// 注册数据节点的逻辑

}

private void monitorHeartbeat() {

// 监听数据节点心跳信号

}

```

在上述代码块中,展示了NameNode在启动时如何注册DataNode,并且监控其心跳信号。这种通信机制是HDFS保证数据一致性和节点健康状态的关键。

### 2.1.2 块存储和复制机制

HDFS通过将大文件切分成一系列的块(block),然后将这些块复制到多个DataNode上以实现数据冗余和高可用。复制的数量通常由HDFS的副本因子(replication factor)决定,这个因子可以根据需要进行配置。

**表格展示**:

| 属性 | 描述 |

| --- | --- |

| Block Size | HDFS中数据存储的基本单位,默认大小为128MB |

| Replication Factor | 定义文件复制的数量,以确保数据的高可用性和容错性 |

| NameNode | 管理文件系统的命名空间以及客户端对文件的访问 |

| DataNode | 存储实际的数据块,并且执行数据的读写操作 |

HDFS的这种设计使得其特别适合处理大量数据的存储和处理需求,尤其是在处理大批量的流式数据时表现出较高的效率。

## 2.2 HDFS的文件操作原理

HDFS提供了对文件进行读写操作的接口,这些操作隐藏了底层的复杂性,对外提供一致的文件系统视图。

### 2.2.1 文件读写流程

当客户端进行文件读写操作时,NameNode会提供与文件相关的块列表和存储它们的DataNode列表,然后客户端直接与DataNode通信,以读取或写入数据。

**mermaid流程图展示**:

```mermaid

graph LR

A[客户端请求文件] --> B[NameNode提供块信息]

B --> C[客户端与DataNode通信]

C --> D[数据读写操作]

```

### 2.2.2 文件系统命名空间和权限模型

HDFS的命名空间结构和Unix文件系统类似,支持目录和文件的创建、删除和重命名等操作。同时,HDFS也支持基于角色的访问控制列表(ACLs)和权限设置,以确保数据的安全性。

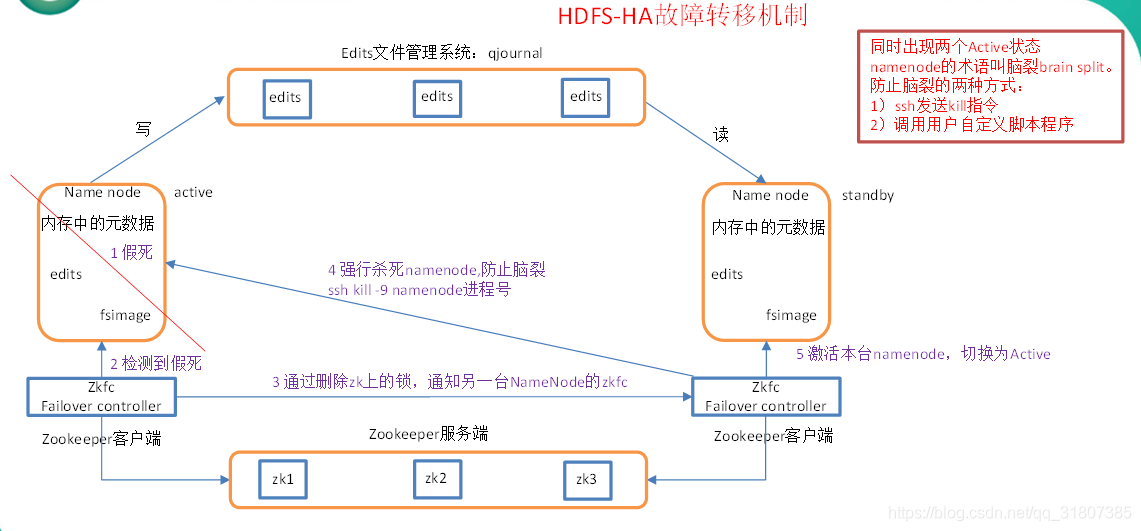

## 2.3 HDFS的容错机制

HDFS的设计目标之一是能够在一个大型集群中运行,即使部分组件失效也不会影响整体的可用性。

### 2.3.1 自动故障检测与恢复

HDFS能够自动检测DataNode的失败,并将存储在故障节点上的数据块复制到其他DataNode上。NameNode定期从DataNode接收心跳信号和块报告,任何心跳失败或块报告丢失都会触发故障恢复机制。

### 2.3.2 心跳机制和数据复制过程

心跳机制是HDFS容错的关键组成部分。DataNode通过心跳消息向NameNode表明它们的存活状态,同时报告它们所持有的数据块信息。如果NameNode未能接收到某个DataNode的心跳信息,则会将其视为离线,并启动数据复制过程。

通过理解HDFS的基础工作原理,运维人员可以更有效地监控和诊断潜在的故障点,从而确保Hadoop集群的稳定性和高效运行。

```

# 3. HDFS故障诊断基础

## 3.1 日志分析与监控工具

### 3.1.1 查看NameNode和DataNode日志

在Hadoop分布式文件系统中,NameNode和DataNode是核心组件,它们的稳定运行对于整个系统的正常工作至关重要。当出现故障时,日志文件是诊断问题的关键。每个NameNode和DataNode进程都会生成详细的日志文件,记录它们的操作和发生的错误。

查看NameNode日志的步骤如下:

1. 定位NameNode日志文件。通常位于Hadoop安装目录下的logs文件夹中,文件名可能类似于`***.log`。

```bash

cd /path/to/hadoop/***

***.log

```

2. 使用tail命令实时跟踪日志文件的变化,以便于观察最新的日志输出。

```bash

# 实时跟踪日志输出

***.log | grep ERROR

```

上述代码中,通过管道命令`grep ERROR`可以过滤出包含"ERROR"关键字的错误日志行。

查看DataNode日志的步骤与NameNode类似,定位到相应的DataNode日志文件并使用tail命令查看。

### 3.1.2 使用Web界面监控HDFS状态

除了通过日志文件,Hadoop还提供了一个Web界面用于监控和管理集群状态。通过访问NameNode的Web界面,可以查看文件系统的健康状况,以及各个DataNode的状态。

1. 打开浏览器并访问NameNode的Web界面地址,通常是`***`。

2. 在Web界面上查看NameNode和DataNode的状态。界面中会有各个DataNode的列表以及它们的状

0

0