HDFS与其他大数据存储方案:10项比较分析助你选择

发布时间: 2024-10-28 14:13:06 阅读量: 66 订阅数: 48

大数据技术原理与应用:概念、存储、处理、分析与应用 完整高清PDF

# 1. HDFS基础架构与工作原理

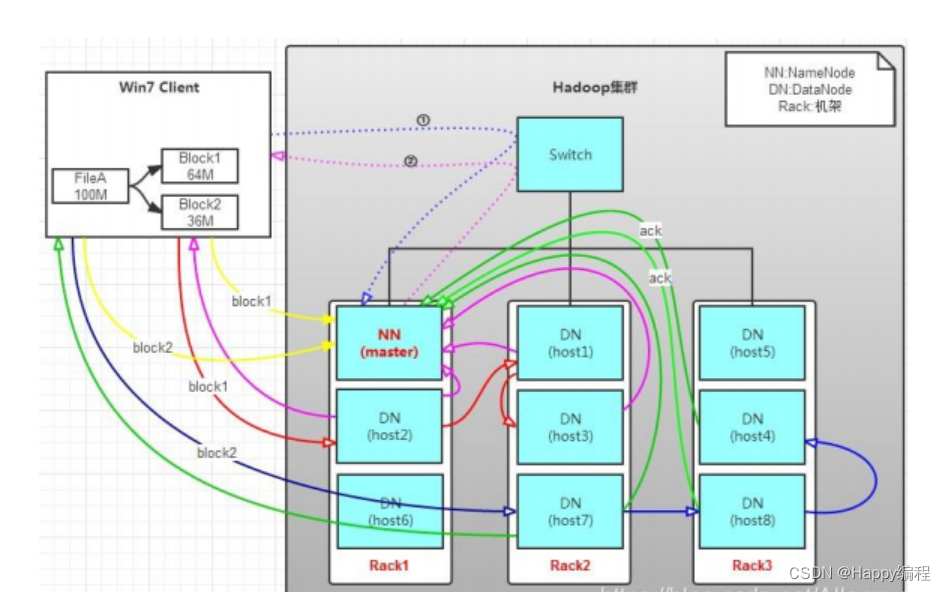

Hadoop分布式文件系统(HDFS)是构建在廉价硬件上的可扩展的分布式存储系统,其设计目标是提供高吞吐量的数据访问、容错能力以及存储大数据集的能力。本章将探讨HDFS的基础架构和工作原理,从其核心组件NameNode和DataNode说起,解析它们是如何协同工作以实现数据的存储和管理。

## 1.1 核心组件和功能

HDFS由一个NameNode和多个DataNode构成,NameNode负责管理文件系统命名空间和客户端对文件的访问,而DataNode则负责实际的数据存储。HDFS支持数据块的复制,以提高系统的容错性。

## 1.2 数据块复制机制

HDFS将大数据文件切分成固定大小的数据块,默认情况下,每个数据块有三个副本,分布在不同的DataNode上,从而实现数据的高可用性和容错性。

## 1.3 命名空间操作

命名空间是HDFS中对所有文件和目录的抽象表示。用户可以执行创建、删除和重命名等操作,NameNode维护这些元数据信息,并向客户端提供文件系统的视图。

通过这个架构的介绍,我们可以看到HDFS为存储和管理大数据而设计的高效性和可靠性,下一章将深入了解HDFS与其它大数据存储方案的理论对比。

# 2. HDFS与其他大数据存储方案的理论对比

在当今的数据密集型时代,选择合适的大数据存储解决方案对于构建一个高效、可靠且可扩展的数据系统至关重要。本章将深入探讨Hadoop分布式文件系统(HDFS)在众多大数据存储方案中的理论基础,以及如何与其他流行存储系统进行对比。

## 2.1 分布式文件系统的基本概念

### 2.1.1 分布式文件系统的定义和特性

分布式文件系统(DFS)是一类特殊的文件系统,它运行在多个服务器上,并共享一个统一的命名空间。这类文件系统允许应用程序存储和检索文件,而无需关心文件数据实际存储在哪些物理设备上。

分布式文件系统的主要特性包括:

- **高可用性**:即使部分服务器宕机,系统依旧可以提供服务。

- **扩展性**:可以通过增加服务器来提升系统的存储容量和计算能力。

- **容错性**:数据副本的存储机制确保了数据在损坏或丢失的情况下能够恢复。

- **异构性**:可以整合不同类型的硬件和网络设备。

### 2.1.2 一致性模型和容错机制

一致性和容错性是分布式文件系统的核心问题。一致性模型定义了文件系统保持数据一致性的级别和方法。常见的模型包括:

- **强一致性**:所有操作都会被立即应用到所有节点。

- **最终一致性**:系统保证没有新的更新,最终所有的副本将变得一致。

容错机制是确保系统在发生硬件故障时不会丢失数据的关键。通常通过以下方式实现:

- **冗余存储**:创建数据副本。

- **心跳检查**:定期检查节点是否存活。

- **恢复机制**:当检测到节点故障时,系统会自动启动恢复过程。

## 2.2 HDFS与其他分布式存储系统的架构差异

### 2.2.1 HDFS架构特点

HDFS是一个高度优化的分布式文件系统,专门用于存储大型数据集。它的架构特点包括:

- **主从架构**:由一个NameNode和多个DataNode组成。

- **写一次,读多次**:优化了数据写入的性能,多次读取的数据可以快速被处理。

- **数据流模型**:适用于大数据的批处理模式,而不是随机访问。

### 2.2.2 对比Cassandra和HBase的架构设计

Cassandra和HBase都是分布式NoSQL数据库,它们在架构上有别于HDFS:

- **Cassandra**:一个去中心化的、无单点故障的分布式数据库。它提供了最终一致性,支持动态扩展性,适合大规模数据的存储。

- **HBase**:构建在HDFS之上,提供了类似BigTable的列存储能力。它的架构与HDFS非常相似,但通过RegionServer来管理数据的存储和检索。

### 2.2.3 对比GlusterFS和NFSv4的存储策略

GlusterFS和NFSv4是两种非Hadoop生态系统的分布式文件存储方案,它们在存储策略上有所不同:

- **GlusterFS**:一个开源的分布式文件系统,它通过存储池和条带化技术提供了高度的可扩展性和弹性。

- **NFSv4**:网络文件系统版本4,它支持访问控制列表(ACLs)、锁定和更高效的协议。

## 2.3 存储模型与数据一致性

### 2.3.1 数据复制机制

数据复制是保证分布式文件系统高可用性和容错性的关键机制。HDFS使用以下策略实现数据复制:

- **默认副本数量**:通常为3个副本,但可以根据需要进行调整。

- **副本放置策略**:一个副本放在本地节点,另一个在相同机架的另一个节点,第三个在不同机架的节点。

### 2.3.2 数据一致性协议

HDFS提供了数据一致性保证,主要依赖于以下协议:

- **写操作一致性**:文件一旦成功关闭,就不会再有任何写入操作。

- **读操作一致性**:一旦文件被成功打开,读取操作就会返回文件的最后成功写入状态。

```mermaid

graph TD

A[开始] --> B[写入数据]

B --> C{数据是否成功保存}

C -->|是| D[更新NameNode元数据]

C -->|否| B

D --> E[复制数据至DataNode]

E --> F[关闭文件]

F --> G[确保所有副本一致]

```

以上流程图展示了HDFS中数据写入和一致性确认的过程。

通过本章节的介绍,我们了解了分布式文件系统的核心概念,以及HDFS如何在架构上与Cassandra、HBase等分布式存储系统区分开来。同时,我们也

0

0