HDFS DataNode的挑战与优化:磁盘管理与数据块健康度监控的4大策略

发布时间: 2024-10-28 14:38:39 阅读量: 41 订阅数: 50

大数据平台构建:HDFS运行原理.pptx

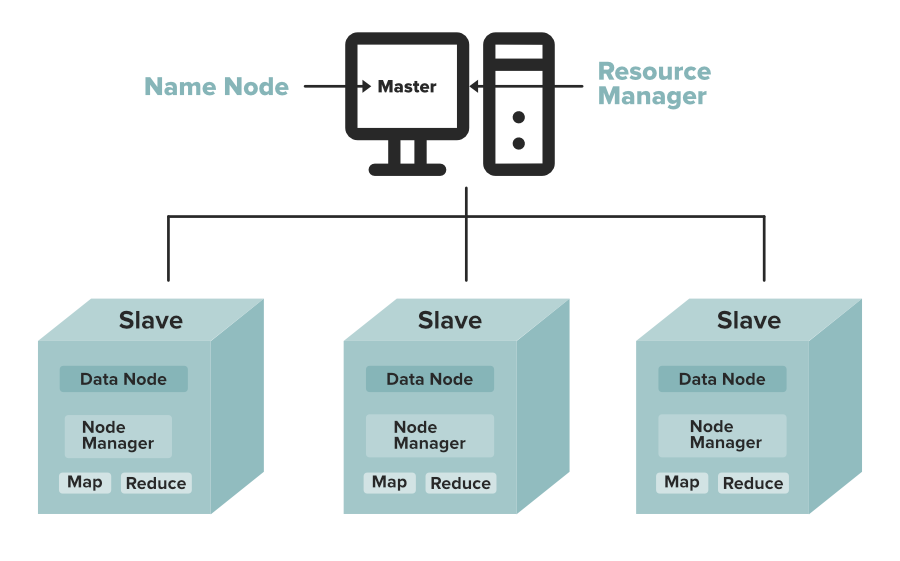

# 1. HDFS DataNode概述

## HDFS DataNode角色和功能

Hadoop分布式文件系统(HDFS)是大数据存储解决方案的核心,其中DataNode承担着关键的职责。DataNode是HDFS架构中的工作节点,负责实际数据的存储和检索。每个DataNode管理存储在本地文件系统上的数据块,并执行来自NameNode的读写请求。除了存储职责,DataNode还执行数据的复制、删除和维护数据块的校验和等操作。

## DataNode架构与组件

DataNode的架构由多个组件构成,其中包括块管理器(BlockManager),它负责维护数据块的映射信息、调度数据读写操作以及执行块的创建、删除和复制任务。数据节点还有心跳机制与NameNode保持通信,向NameNode报告其状态和健康度。心跳不仅是一种健康检查,也使NameNode能够监控数据节点上的数据块可用性。

## DataNode的性能考量

DataNode的性能直接关系到整个HDFS集群的稳定性和效率。它需要具备强大的I/O吞吐能力和足够的磁盘空间,以保证大数据块能够高效地存储和读取。此外,DataNode需要优化其内存使用,因为过多的内存占用会降低节点的处理能力,并影响到整个集群的扩展性。

在接下来的章节中,我们将深入探讨DataNode在磁盘管理、数据块健康度监控以及优化实践方面的细节。

# 2. 磁盘管理策略

## 2.1 磁盘空间监控与管理

### 2.1.1 磁盘容量阈值设置

为了确保数据节点(DataNode)的稳定运行,设置合理的磁盘容量阈值是至关重要的。当磁盘空间低于某个设定的阈值时,系统应能自动触发数据再平衡或其他相关操作。通常,HDFS支持设置两个阈值:

- `dfs.balance.bandwidthPerSec`:这个参数控制DataNode用于数据再平衡的最大带宽,防止磁盘空间不足时对集群性能造成过大影响。

- `dfs.namenode.fspace.limit`:此参数定义了DataNode可以使用的最大空间比例,超过此比例将不再接受新的数据写入。

在设置阈值时,需要考虑到集群的负载能力、网络带宽、以及节点的I/O性能。例如,如果一台DataNode的容量即将耗尽,它将启动数据的移动,以将部分数据移动到其他DataNode。以下是一个设置`dfs.balance.bandwidthPerSec`的示例代码块及其参数解释:

```xml

<property>

<name>dfs.balance.bandwidthPerSec</name>

<value>***</value> <!-- 该值设置为10MB/s -->

<description>指定DataNode用于数据再平衡的最大带宽</description>

</property>

```

### 2.1.2 动态数据平衡技术

动态数据平衡是HDFS维护集群健康状态的一个重要功能。当集群中的数据分布不均时,会触发重新平衡的机制。该机制通过数据的重新分布,保持DataNode之间的负载均衡。

数据平衡过程由NameNode管理,它根据数据块的分布、DataNode容量和负载等多个因素决定哪些数据块需要移动以及移动到哪里。数据移动是通过DataNode之间的直接数据传输完成的,减少了对NameNode的压力。

HDFS提供了一系列命令,如`hdfs diskbalancer`,来主动触发数据平衡。在执行平衡操作之前,需要设置好平衡策略和监控频率。以下是一个简单的`hdfs diskbalancer`使用示例:

```shell

# 检查DataNode上的数据平衡状态

hdfs diskbalancer -report <DataNodeHostname>

# 对指定DataNode执行平衡操作

hdfs diskbalancer -run -plan <DataNodeHostname>

```

## 2.2 磁盘故障预测与预防

### 2.2.1 磁盘健康度检查机制

为了预防磁盘故障导致的数据丢失,HDFS提供了多种磁盘健康度检查机制。首先,DataNode会定期运行自检程序,检查磁盘的健康状况。其次,可以使用第三方监控工具集成到HDFS,提供更为全面的监控。

磁盘健康度检查机制的关键在于及时发现并隔离潜在的故障磁盘。在Hadoop中,DataNode会定期向NameNode报告磁盘健康状态。如果NameNode检测到某DataNode的磁盘故障报告,它会将该节点标记为不可靠,并启动数据复制到其他健康的DataNode上。

### 2.2.2 预测模型与故障缓解措施

除了实时的健康检查之外,预测模型在磁盘故障预防中也扮演着重要角色。通过历史数据的学习和分析,预测模型可以估计某个磁盘的故障概率,并采取相应的预防措施。

预测模型通常基于机器学习算法,结合磁盘的读写次数、温度、响应时间等指标进行故障预测。这些模型需要定期的训练和调优,以提高预测的准确性。一旦预测到潜在故障,系统可以采取如下缓解措施:

- 增加对应磁盘上的数据副本数量。

- 将数据迁移到其他健康的磁盘。

- 隔离即将发生故障的磁盘,避免数据损坏。

## 2.3 数据块的存储优化

### 2.3.1 RAID技术在DataNode中的应用

冗余阵列独立磁盘(RAID)是一种将多个磁盘驱动器组合成一个或多个磁盘驱动器的技术,用于提高数据冗余和可靠性。在DataNode中应用RAID技术是提高数据耐久性的一种常见做法。

RAID级别有多种,如RAID 0, RAID 1, RAID 5, RAID 6等,每个级别具有不同的特点和性能。RAID 1提供磁盘镜像,为数据提供了最高级别的保护,但会消耗更多的磁盘空间。而RAID 5提供了一种平衡空间和冗余的方式,通过条带化数据和添加奇偶校验信息,实现单磁盘故障的容错能力。

### 2.3.2 数据复制策略的优化

数据复制是HDFS保证数据可靠性的核心机制。默认情况下,HDFS会为每个数据块维护3个副本(一个主副本和两个备份副本)。然而,在实际应用中,根据数据的重要性、访问频率等不同因素,可以对数据复制策略进行优化。

例如,对于不经常访问但需要高可靠性的数据,可以增加副本数以降低数据丢失的风险;对于读写频繁的数据,则可以考虑适度减少副本数以节省存储空间和提高写入性能。

优化复制策略时,还需考虑副本放置策略。一个好的放置策略可以最大程度地降低副本丢失的风险,并提升数据读写的效率。以下是一些常见的优化措施:

- **数据局部性优化**:优先在本地或同一机架上的DataNode中放置副本,以减少网络传输成本。

- **负载均衡**:避免某个DataNode由于放置过多副本而成为瓶颈。

- **故障恢复策略**:确保在DataNode发生故障时,能够快速恢复副本。

优化数据复制策略不仅需要对HDFS内部工作机制有深入的理解,还需要对业务数据特性有充分的考量。通过对数据特性的深入分析和实际监控数据的收集,可以制定出更符合实际需求的复制策略。

# 3. 数据块健康度监控

## 3.1 数据块复制机制的挑战

### 3.1.1 副本数不足的问题分析

在Hadoop分布式文件系统(HDFS)中,数据块的复制机制是保证数据可靠性和高可用性的核心机制。副本数不足是一种常见的问题,它可能由多种原因引起,如DataNode故障、网络问题或者运维配置失误等。副本数不足会影响HDFS的整体稳定性和数据的安全性,特别是在分布式计算环境中,丢失的副本会直接影响作业的执行和数据的完整性。

在处理副本数不足的问题时,HDFS本身提供了几种机制来确保副本数达到用户设置的水平。最直接的手段是使用`-setReplication`命令手动设置数据块的副本数。在自动管理层面,HDFS NameNode会周期性地检查数据块的副本数,并启动数据复制过程以满足最小副本数的要求。一旦检测到副本数不足,DataNode会开始从其他DataNode下载数据块副本,直到达到配置的副本数。

###

0

0