【HDFS全解析】:掌握分布式存储的20个核心秘密

发布时间: 2024-10-28 13:30:11 阅读量: 20 订阅数: 48

深入理解HDFS:Hadoop分布式文件系统

# 1. HDFS概述

## 1.1 Hadoop分布式文件系统简介

Hadoop分布式文件系统(HDFS)是Apache Hadoop项目的核心组件,它是一个高度容错的系统,适用于大规模数据集的存储。HDFS的设计理念是为了实现存储在廉价硬件上的大量数据,以及在不可靠环境中提供可靠的存储服务。通过将数据分块并分布在集群的不同机器上,HDFS实现了数据的并行处理和高吞吐量访问。

## 1.2 HDFS的主要特性

HDFS具有以下几个显著特点:

- **高容错性**:通过数据副本的机制,HDFS可以在单个节点失败时保证数据的完整性。

- **可扩展性**:HDFS可以轻松扩展到成百上千的节点。

- **流数据访问**:HDFS支持大文件的连续读写操作,适用于批量处理。

- **简单的一致性模型**:HDFS允许用户在数据集上执行一次写入多次读取的操作模式。

## 1.3 HDFS的应用场景

HDFS广泛应用于各种大数据处理场景,如日志分析、数据仓库、机器学习等。它的设计使得数据存储成本显著降低,同时保持了数据处理的高效率。作为一个基础存储架构,HDFS为大数据处理提供了坚实的基础。随着数据量的增加,HDFS显示出其在大规模分布式数据存储中的不可或缺性。

在下一章节中,我们将深入探讨分布式存储的基本概念以及HDFS的设计原理。

# 2. HDFS的理论基础

### 2.1 分布式存储的基本概念

分布式存储系统是大数据时代的核心技术之一,它允许在多个物理服务器上存储数据,并在逻辑上呈现为一个统一的存储系统。随着数据量的增加,传统的单点存储解决方案遇到了性能瓶颈和可扩展性的限制。

#### 2.1.1 分布式存储的定义

分布式存储涉及将数据分散存储在多台计算机上的多个存储设备中,这些计算机通过网络连接起来,并协同工作以提供数据存储和管理服务。数据分布在不同的节点上,可以提高数据的可用性和容错能力。

分布式存储系统主要解决以下几个问题:

- **数据容量扩展**:通过增加更多的存储节点,系统可以轻松扩展存储容量。

- **性能提升**:通过并行处理和数据分片技术,可以显著提高数据处理和检索的性能。

- **容错性增强**:系统通过数据的冗余副本和自我修复机制保证高可用性。

- **成本优化**:使用廉价的商用硬件代替昂贵的专用硬件可以降低总体拥有成本。

#### 2.1.2 分布式存储的优势与挑战

**优势**

- **可扩展性**:分布式存储系统易于横向扩展,能够更好地应对数据量爆炸性增长的情况。

- **高性能**:数据可以并行读写,通过负载均衡来提高吞吐量和降低延迟。

- **可靠性**:数据多副本存储提高了系统的容错性,避免了单点故障的影响。

**挑战**

- **数据一致性**:确保数据在多个节点上的一致性是一个技术挑战。

- **复杂的网络通信**:数据的分片和传输需要高效稳定的网络支持。

- **管理和维护成本**:虽然硬件成本较低,但分布式系统的维护和管理更为复杂。

### 2.2 HDFS的设计原理

Hadoop分布式文件系统(HDFS)是分布式存储系统的一个典型例子,它是为了存储和处理超大数据量而设计的。

#### 2.2.1 HDFS的设计目标

HDFS的设计主要考虑了以下几点目标:

- **硬件失效的鲁棒性**:能够自动恢复由于硬件故障导致的数据损坏或丢失。

- **流式数据访问**:适合批处理数据,而非交互式数据访问。

- **简单的协同工作**:通过简单的接口和协议与其他系统协同工作。

- **可移植性**:能够在廉价的硬件上运行,并易于移植到其他操作系统上。

#### 2.2.2 HDFS的关键特性

HDFS的关键特性包括:

- **大容量存储**:支持PB级别的数据存储。

- **高容错性**:通过数据副本机制实现容错。

- **可扩展性**:系统规模可以灵活扩展。

- **低延迟的写操作**:尽管HDFS主要用于批处理,但为了提供数据的一致性和可用性,设计了低延迟的写操作。

### 2.3 HDFS的架构组件

HDFS架构由两个主要组件构成:NameNode和DataNode。

#### 2.3.1 NameNode和DataNode的工作原理

**NameNode**是HDFS的中心节点,负责管理文件系统的命名空间和客户端对文件的访问。NameNode记录了每个文件中各个块所在的数据节点(DataNode)的信息,但并不存储实际的数据。

**DataNode**负责存储实际的数据块,执行数据块的创建、删除和复制等操作。客户端直接与DataNode交互,读写数据块。

#### 2.3.2 Secondary NameNode的作用和机制

Secondary NameNode并不是NameNode的热备份,它的主要作用是帮助NameNode合并编辑日志(edit log)和文件系统镜像(fsimage)。

编辑日志记录了HDFS元数据的变更,随着操作的增多,编辑日志会不断增长。当编辑日志太大时,NameNode合并操作会变得缓慢,因此需要Secondary NameNode帮助完成这一过程,保持NameNode运行效率。

这个机制可以有效减少NameNode的重启时间,并且在NameNode故障时提供一定恢复能力。Secondary NameNode定期获取NameNode的编辑日志和文件系统镜像,并创建新的文件系统镜像,最后发送回NameNode。

**注意:** 最新版的Hadoop中引入了Checkpoint Node和BackupNode来更有效地管理元数据。

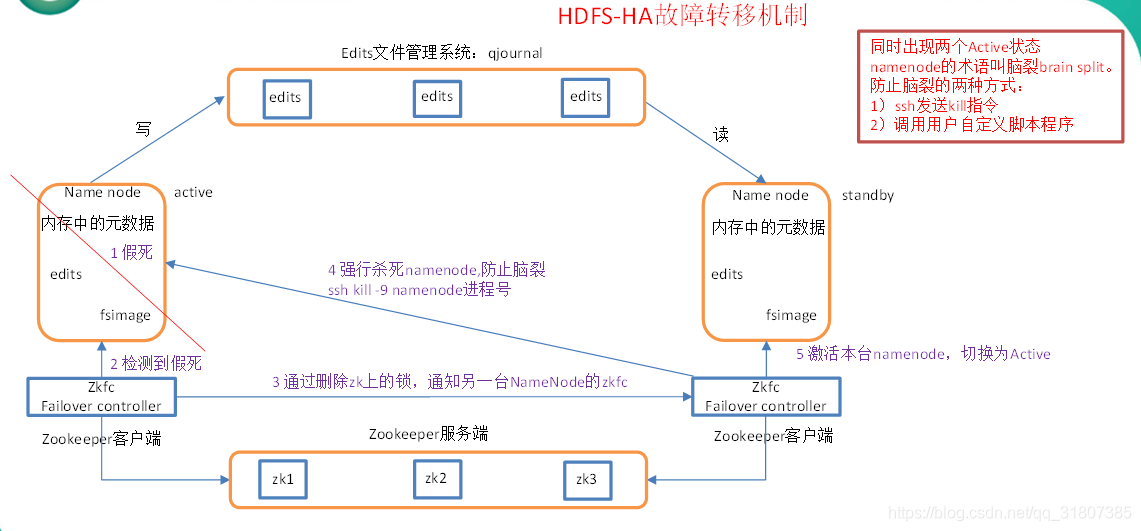

在Hadoop 2.x版本中引入了高可用性(HA)特性,通过使用ZooKeeper实现NameNode的主备切换机制,使得整个系统具备更强的容错能力。

# 3. HDFS的实践操作

## 3.1 HDFS的基本命令和使用

### 3.1.1 HDFS的常用命令

Hadoop分布式文件系统(HDFS)提供了一组丰富的命令行工具,用于管理存储在HDFS上的文件和目录。以下是几个基本但非常有用的命令。

```bash

hdfs dfs -ls /

```

这个命令可以列出HDFS根目录下的所有文件和目录。

```bash

hdfs dfs -mkdir /user

```

使用该命令可以在HDFS上创建一个新的目录。

```bash

hdfs dfs -put localfile /user/hadoop/inhdfs

```

`-put`命令用于将本地文件系统中的文件复制到HDFS。

```bash

hdfs dfs -get /user/hadoop/inhdfs localfile

```

相反,`-get`命令用于将HDFS中的文件复制回本地文件系统。

```bash

hdfs dfs -rm /user/hadoop/inhdfs

```

使用`-rm`命令可以删除HDFS中的文件。

### 3.1.2 文件和目录的操作实践

#### *.*.*.* 文件的上传和下载

要上传本地文件到HDFS,可以使用`hadoop fs -put`命令。例如,要将本地的`sample.txt`文件上传到HDFS的`/user/hadoop`目录下,可以执行以下命令:

```bash

hadoop fs -put sample.txt /user/hadoop/

```

如果要下载HDFS上的文件到本地文件系统,可以使用`hadoop fs -get`命令。例如,从HDFS的`/user/hadoop`目录下载`sample.txt`文件到本地,可以使用以下命令:

```bash

hadoop fs -get /user/hadoop/sample.txt .

```

#### *.*.*.* 目录的创建与删除

创建目录:

```bash

hadoop fs -mkdir /user/hadoop/newdir

```

删除目录:

```bash

hadoop fs -rmr /user/hadoop/newdir

```

### *.*.*.* 文件的查看和复制

查看文件内容:

```bash

hadoop fs -cat /user/hadoop/sample.txt

```

复制文件:

```bash

hadoop fs -cp /user/hadoop/sample.txt /user/hadoop/sample_copy.txt

```

这些命令为HDFS用户提供了基本的文件和目录操作能力,是处理和管理存储在HDFS上的数据所必需的。

## 3.2 HDFS的高可用和数据备份

### 3.2.1 HDFS的高可用架构

HDFS的高可用架构设计是为了保证在NameNode故障的情况下,系统依然能够继续提供服务。这主要是通过使用两个NameNode和一个共享存储设备实现的。其中,一个NameNode处于活动状态,另一个处于待命状态。共享存储设备用于存储NameNode的元数据。

### 3.2.2 数据副本管理和容错机制

HDFS通过创建数据副本(默认是三个副本)在不同的DataNode上,来提供高可靠性的数据存储。当一个DataNode节点宕机时,HDFS会自动将丢失的数据副本重新复制到其他健康的DataNode节点上。此外,HDFS还通过心跳检测机制来及时发现和替换掉故障的DataNode节点。

```mermaid

graph LR

A[客户端] --> |读数据| B(NameNode)

B --> |分配数据节点| C[DataNode1]

B --> |分配数据节点| D[DataNode2]

B --> |分配数据节点| E[DataNode3]

C --> |数据| A

D --> |数据| A

E --> |数据| A

```

在该架构中,客户端从NameNode获取数据块位置信息,然后直接与存放数据块的DataNode进行交互。

## 3.3 HDFS的数据存储和管理

### 3.3.1 文件块的存储策略

HDFS将大文件分割成固定大小的块,默认大小为128MB,并将这些块存储在多个DataNode上。当进行文件写入时,HDFS采用一种称为“就近写入”策略,即优先选择与写入客户端在同一网络拓扑位置上的DataNode来存储数据块,以此来优化网络带宽的使用并减少延迟。

### 3.3.2 空间配额和权限管理

HDFS允许管理员为不同的目录设置空间配额,以防止某些用户或应用程序过度消耗存储资源。此外,HDFS也支持POSIX风格的权限模型,包括读、写和执行权限,管理员可以通过`hdfs dfs -chmod`、`hdfs dfs -chown`和`hdfs dfs -chgrp`等命令来管理文件和目录的权限。

| 命令 | 功能 |

| --- | --- |

| hdfs dfs -chmod | 修改文件或目录的权限 |

| hdfs dfs -chown | 修改文件或目录的所有者 |

| hdfs dfs -chgrp | 修改文件或目录的所属组 |

例如,为HDFS中的`/user/hadoop`目录设置读写权限,并将其所有者设置为用户`hadoop`:

```bash

hdfs dfs -chmod 700 /user/hadoop

hdfs dfs -chown hadoop /user/hadoop

```

通过这些策略和管理工具,HDFS能够有效地管理和控制存储在集群中的数据资源。

以上是第三章“HDFS的实践操作”下的三个小节内容,详细介绍了HDFS的基本命令和使用,高可用性和数据备份,以及数据存储和管理的相关操作和策略。每个小节都通过具体命令、解释和表格或mermaid格式流程图,确保内容的深入细致与操作的连贯性。

# 4. HDFS的高级特性

随着数据量的持续增长和对存储性能需求的不断提升,HDFS在企业级存储解决方案中的地位变得越来越重要。为了满足多样化和高性能的需求,HDFS提供了许多高级特性来提升系统的安全性、优化性能以及支持系统的扩展性。本章将深入探讨这些高级特性,包括HDFS的访问权限和安全模型、性能优化策略、以及如何在不中断服务的情况下进行系统的扩展和升级。

## 4.1 HDFS的访问权限和安全模型

数据的安全性和访问控制是企业级数据存储的重要组成部分。HDFS通过内置的认证和授权机制,提供了一个多层次的安全模型,确保了只有授权用户才能访问和修改数据。

### 4.1.1 用户认证和授权机制

在HDFS中,用户认证是确保只有经过验证的用户才能访问系统资源的过程。HDFS支持集成Kerberos协议来加强用户身份认证过程的安全性。通过Kerberos,HDFS能够验证用户的身份,并确保数据在传输过程中的安全性。

HDFS通过授权来控制用户对文件和目录的访问权限。每个HDFS用户都可以被分配到一个或多个组中。权限设置分为三类:

- 读(Read)

- 写(Write)

- 执行(Execute)

在HDFS中,权限被应用到文件和目录上。每个文件和目录都有自己的所有者和所属组,并且具有相应的访问权限。HDFS提供了`hadoop fs -chmod`和`hadoop fs -chown`等命令来修改文件的权限和所有权。

### 4.1.2 数据加密和安全审计

为了进一步加强数据安全,HDFS提供了数据加密功能,可以在数据传输和存储时对数据进行加密,以防止未授权访问。HDFS支持使用透明加密(TDE)或静态数据加密(SDE)来保护敏感数据。

安全审计是保证数据访问可追溯的重要手段。HDFS通过审计日志记录用户的操作,使得管理员可以跟踪和审查数据访问活动。HDFS的审计日志包括操作的类型、时间、用户和受影响的文件等信息。

```sh

# 示例命令:启用HDFS的审计日志功能

hdfs dfsadmin -setSpaceQuota *** /user

```

## 4.2 HDFS的性能优化

性能优化是HDFS系统管理的关键任务之一。通过调整系统参数和采用适当的技术,可以显著提高系统的读写性能。

### 4.2.1 常见性能问题和调优策略

HDFS性能优化的常见问题包括:

- NameNode的内存瓶颈

- 网络带宽的饱和

- 磁盘I/O成为瓶颈

针对这些问题,HDFS提供了多种优化策略:

- 通过增加NameNode的堆内存容量来缓解内存瓶颈。

- 使用高带宽的网络硬件和网络优化技术。

- 在使用本地存储的DataNode上增加磁盘,采用RAID和SSD等技术。

```sh

# 示例:修改hdfs-site.xml来增加NameNode堆内存

<property>

<name>dfs.namenode.handler.count</name>

<value>40</value>

</property>

```

### 4.2.2 HDFS的读写优化技术

为了提高读写性能,HDFS采用了多种技术:

- **文件块的本地化读取**:HDFS优先在本地DataNode上读取数据,减少了网络延迟。

- **使用短路读取**:当客户端和DataNode在同一台机器上时,可以通过本地文件系统读取数据,绕过网络通信。

- **合并写入**:HDFS支持客户端合并多个小文件的写入操作,减少NameNode的压力并提高写效率。

```java

// 示例代码:使用Hadoop API进行写操作

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path path = new Path("/user/hadoop/test.txt");

FSDataOutputStream out = fs.create(path, true);

out.writeUTF("Hello HDFS!");

out.close();

```

## 4.3 HDFS的扩展和升级

对于运行中的HDFS集群,系统升级和扩展是不可避免的。HDFS提供了平滑升级和扩展现有集群的方法,以保证服务的连续性和数据的安全。

### 4.3.1 HDFS的版本兼容性

为了平滑升级HDFS,开发团队精心设计了版本兼容性策略。升级HDFS集群前,需要确保集群中的所有组件兼容新版本的HDFS。

- **版本兼容表**:Hadoop社区提供了一个版本兼容性表,列出了哪些版本之间可以兼容。

- **滚动升级**:HDFS支持滚动升级,这样升级过程中集群可以继续对外提供服务。

- **回滚方案**:在升级过程中如果出现问题,需要有一个明确的回滚方案。

### 4.3.2 如何安全地升级HDFS

升级HDFS集群的步骤如下:

1. **备份数据**:在升级前,备份HDFS集群中的所有数据。

2. **检查版本兼容性**:确保目标版本与集群中其他组件兼容。

3. **升级DataNode**:从集群中选择一个或多个DataNode开始升级。

4. **升级NameNode**:在所有DataNode升级完成后,升级NameNode。

5. **验证升级**:在每次升级后,执行健康检查和性能测试。

6. **监控升级**:在整个升级过程中,持续监控集群的运行状态。

```sh

# 示例:使用HDFS命令进行滚动升级

hdfs dfsadmin -rollingUpgrade enable

hdfs rollingUpgrade prepare

hdfs rollingUpgrade QuorumPeerMain

hdfs dfsadmin -rollingUpgrade finish

```

## 表格

| 版本兼容性策略 | 适用场景 | 备注 |

| -------------- | -------- | ---- |

| 向前兼容 | 新版本可以读取旧版本生成的数据 | 需要特定配置 |

| 向后兼容 | 旧版本可以读取新版本生成的数据 | 需要特定配置 |

| 滚动升级 | 逐步替换集群中的节点 | 保持服务的可用性 |

## Mermaid 流程图

```mermaid

graph LR

A[开始升级] --> B[备份数据]

B --> C[检查版本兼容性]

C --> D[升级DataNode]

D --> E[升级NameNode]

E --> F[执行验证]

F --> G[结束升级]

```

通过本章节的介绍,您应该对HDFS的高级特性有了更深入的了解。下一章节,我们将探索HDFS在大数据生态系统中的位置及其成功案例研究,为您提供更为全面的视角。

# 5. HDFS的生态系统和案例分析

## 5.1 HDFS在大数据生态系统中的位置

在大数据生态系统中,HDFS 起着至关重要的作用,是构建在大数据平台上的基石。HDFS 为各种数据处理框架提供了可靠的存储能力。本节我们将深入了解 HDFS 如何与其他大数据组件交互,并探究其在不同场景下的应用情况。

### 5.1.1 HDFS与其他大数据组件的交互

Hadoop 生态系统中包含了各种处理不同类型数据的组件,HDFS 是许多其他组件的数据存储基础。

- **HDFS 和 MapReduce**:MapReduce 是一种编程模型和处理大数据的计算框架。它依赖于 HDFS 存储输入数据和中间输出。MapReduce 作业的运行需要读取存储在 HDFS 上的数据,处理后的结果也会被保存到 HDFS 中。

- **HDFS 和 Hive**:Hive 是建立在 Hadoop 之上的数据仓库工具,它使得对大数据的查询和分析变得非常简单。Hive 使用 HDFS 存储数据,并依赖 MapReduce(或者 Tez 或 Spark)执行 SQL 查询。

- **HDFS 和 HBase**:HBase 是一个开源的非关系型分布式数据库(NoSQL),它是构建在 HDFS 之上的,用于支持大规模的稀疏数据集的实时读写访问。

- **HDFS 和 Spark**:Apache Spark 是一个用于大规模数据处理的快速、通用的计算引擎,它提供了一个存储层称为弹性分布式数据集(RDDs)。尽管 Spark 可以使用自己的存储系统,但 HDFS 提供了稳定性和兼容性。

### 5.1.2 HDFS在各种场景下的应用

HDFS 的设计使得它非常适合存储大量的数据集,尤其在那些需要处理大量数据的场景中表现突出。

- **批处理**:HDFS 用于存储和管理从各种数据源导入的大数据集,然后可以利用 MapReduce 等框架进行批处理。

- **实时查询**:虽然 HDFS 更适合批处理,但通过与其他框架结合,如 Apache Impala 或 Apache Drill,HDFS 也可以用于执行实时查询。

- **数据仓库**:企业数据仓库可以使用 HDFS 作为其底层存储,以便处理历史数据和进行复杂分析。

- **日志处理**:HDFS 也常被用于存储服务器日志数据,便于之后的日志分析和监控。

## 5.2 HDFS的成功案例研究

HDFS 的成功案例遍布各个行业,从金融到社交网络,再到电子商务和科学研究,HDFS 在支持数据驱动型决策方面发挥了巨大作用。

### 5.2.1 金融行业的应用案例

金融行业对数据的准确性和可靠性要求极高,HDFS 在这一领域的应用体现在:

- **风险管理**:金融机构利用 HDFS 存储大量的交易和市场数据,通过分析这些数据来评估市场风险和信贷风险。

- **欺诈检测**:通过分析交易数据和用户行为数据,金融机构可以快速检测并防止欺诈行为。

### 5.2.2 互联网公司的应用案例

在互联网公司,HDFS 支持着各种大规模应用,包括:

- **个性化推荐**:互联网公司通过分析用户的行为数据,利用 HDFS 存储信息,并运行机器学习算法来提供个性化推荐。

- **内容分发网络**:为了快速将内容分发给全球的用户,HDFS 用于存储大量的媒体文件和缓存数据。

通过这些案例,我们可以看到 HDFS 在支持大规模数据存储和处理方面的重要性,同时也展示了它在解决行业特定问题中的实用性和灵活性。在实际应用中,HDFS 不仅提供了一个稳定的存储平台,而且与许多大数据技术紧密结合,成为整个生态系统的中心。

0

0