提升MySQL数据导入性能的秘诀:优化导入速度

发布时间: 2024-07-23 18:42:26 阅读量: 105 订阅数: 26

# 1. MySQL数据导入概述

数据导入是将外部数据源中的数据加载到MySQL数据库中的过程。它在数据迁移、数据仓库构建和应用程序集成等场景中发挥着至关重要的作用。

MySQL提供了多种数据导入方法,包括`LOAD DATA INFILE`、`INSERT`语句和第三方工具。选择合适的方法取决于数据量、数据格式和性能要求。

数据导入过程通常包括以下步骤:

- 数据准备:将数据转换为MySQL兼容的格式,例如CSV或JSON。

- 数据库配置:优化数据库参数以提高导入速度,例如增加缓冲池大小和禁用自动提交。

- 数据导入:使用选定的方法将数据加载到数据库中。

- 数据验证:检查导入数据的完整性和准确性。

# 2.1 数据导入原理与瓶颈分析

### 数据导入原理

数据导入是将外部数据源中的数据加载到 MySQL 数据库中的过程。它涉及以下步骤:

1. **连接到数据源:**MySQL 客户端连接到数据源(如文件、数据库或 Web 服务)。

2. **读取数据:**客户端从数据源读取数据,通常以块的形式。

3. **解析数据:**客户端解析数据,将其转换为 MySQL 可以理解的格式。

4. **生成查询:**客户端生成用于将数据插入数据库的 SQL 查询。

5. **执行查询:**客户端将查询发送到 MySQL 服务器,服务器执行查询并插入数据。

### 瓶颈分析

数据导入的瓶颈可能发生在以下阶段:

- **网络传输:**数据从数据源传输到 MySQL 服务器的网络延迟。

- **解析开销:**解析数据并生成查询所需的计算开销。

- **数据库 I/O:**将数据插入数据库所需的 I/O 操作。

- **服务器处理:**MySQL 服务器处理查询并插入数据的开销。

### 影响因素

影响数据导入速度的因素包括:

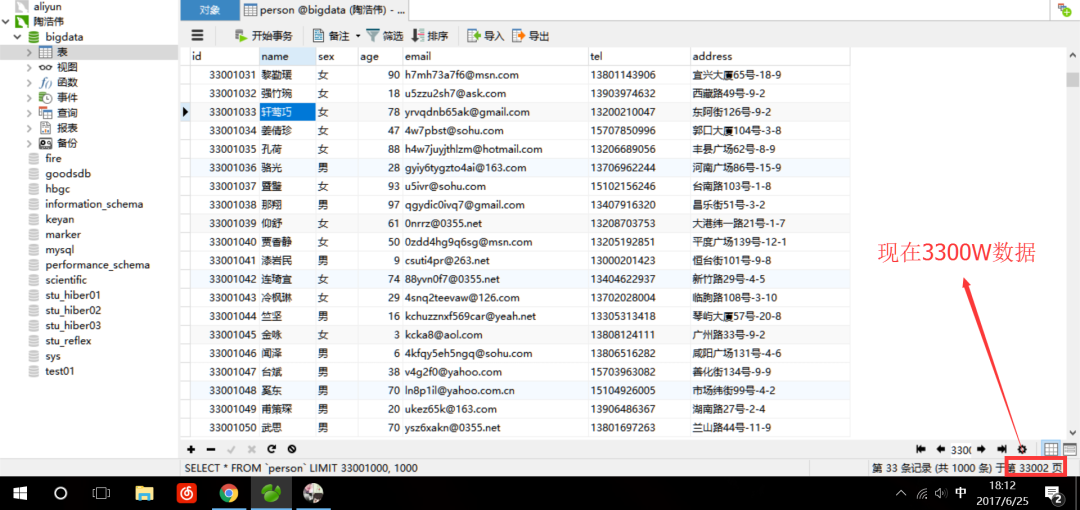

- **数据量:**要导入的数据量。

- **数据格式:**数据的格式(如 CSV、JSON、XML)。

- **网络带宽:**连接数据源和 MySQL 服务器的网络带宽。

- **服务器资源:**MySQL 服务器的 CPU、内存和存储资源。

- **数据库配置:**MySQL 数据库的配置参数(如 innodb_flush_log_at_trx_commit)。

通过理解这些瓶颈和影响因素,我们可以制定优化策略来提高数据导入速度。

# 3. 实践优化之基础优化

**3.1 优化数据格式与编码**

数据格式和编码对导入速度有直接影响。选择合适的格式和编码,可以显著提升导入效率。

**数据格式**

常用的数据格式有 CSV、JSON、XML 等。其中,CSV 格式以其简单易用、兼容性强等优点,成为最常用的数据导入格式。CSV 格式采用逗号分隔字段,换行符分隔记录,结构清晰,易于解析。

**编码**

编码是指将字符转换为二进制位串的过程。不同的编码方式会产生不同的二进制位串长度,从而影响导入速度。UTF-8 编码是一种变长编码,字符长度为 1-4 个字节,兼容性强,是推荐使用的编码方式。

**优化建议**

* 选择 CSV 格式作为数据导入格式。

* 使用 UTF-8 编码。

**3.2 调整数据库配置参数**

MySQL 数据库提供了丰富的配置参数,通过调整这些参数,可以优化数据导入性能。

**innodb_flush_log_at_trx_commit**

该参数控制事务提交时是否立即将数据写入 redo log。默认值为 1,表示事务提交时立即写入 redo log。对于数据导入场景,可以将该参数设置为 2,表示事务提交时不立即写入 redo log,而是每秒写入一次,可以减少 redo log 的写入次数,提升导入速度。

**innodb_buffer_pool_size**

该参数控制缓冲池的大小。缓冲池用于缓存经常访问的数据,可以减少磁盘 I/O 操作,提升导入速度。对于数据导入场景,可以适当增大缓冲池大小,以提高缓存命中率。

**优化建议**

* 将 innodb_flush_log_at_trx_commit 参数设置为 2。

* 适当增大 innodb_buffer_pool_size 参数。

**3.3 使用批量导入工具**

批量导入工具可以将多个数据文件一次性导入数据库,避免了逐条插入的开销,可以大幅提升导入速度。

**MySQL Bulk Loader (mysqlimport)**

mysqlimport 是 MySQL 提供的批量导入工具,支持 CSV、JSON 等多种数据格式。mysqlimport 使用多线程并行导入,可以充分利用多核 CPU 的优势,提升导入速度。

**优化建议**

* 使用 mysqlimport 工具进行批量导入。

* 设置 mysqlimport 的并行线程数,以充分利用多核 CPU。

**代码示例**

```

mysqlimport --user=root --password=password --database=test --table=table_name --fields-terminated-by=, --lines-terminated-by='\n' --local input.csv

```

**参数说明**

* --user:数据库用户名。

* --password:数据库密码。

* --database:要导入数据的数据库名。

* --table:要导入数据的表名。

* --fields-terminated-by:字段分隔符。

* --lines-terminated-by:行分隔符。

* --local:指定要导入的本地文件路径。

**逻辑分析**

该代码使用 mysqlimport 工具将 input.csv 文件中的数据批量导入到 test 数据库的 table_name 表中。mysqlimport 会根据 --fields-terminated-by 和 --lines-terminated-by 指定的分隔符解析 CSV 文件,并将其中的数据插入到表中。

# 4. 实践优化之高级优化

### 4.1 并行导入与分表导入

**并行导入**

并行导入是指同时使用多个线程或进程导入数据。MySQL支持并行导入,通过设置`--bulk-insert-buffer-size`参数可以指定并行导入的缓冲区大小。缓冲区越大,并行导入的效率越高。

```sql

mysql -u root -p --bulk-insert-buffer-size=16M database < data.sql

```

**分表导入**

分表导入是指将数据导入到多个表中,然后通过联合查询或视图将这些表合并为一个逻辑表。分表导入可以有效地提高导入速度,因为每个表可以独立导入,互不影响。

要进行分表导入,需要先创建多个表,然后使用`INSERT INTO ... SELECT ...`语句将数据从一个表导入到另一个表。

```sql

CREATE TABLE table1 (id INT, name VARCHAR(255));

CREATE TABLE table2 (id INT, name VARCHAR(255));

INSERT INTO table1 (id, name) SELECT id, name FROM data WHERE id % 2 = 0;

INSERT INTO table2 (id, name) SELECT id, name FROM data WHERE id % 2 = 1;

```

### 4.2 索引优化与数据预处理

**索引优化**

在导入数据之前,可以对目标表创建索引。索引可以加快数据查询的速度,从而提高导入速度。

```sql

CREATE INDEX idx_name ON table (name);

```

**数据预处理**

在导入数据之前,可以对数据进行预处理,例如:

* **去除重复数据:**使用`DISTINCT`或`GROUP BY`去除重复数据。

* **转换数据类型:**将数据转换为与目标表列数据类型一致的类型。

* **压缩数据:**使用`GZIP`或`BZIP2`等压缩算法压缩数据。

### 4.3 监控与调优

**监控**

在导入数据过程中,需要监控导入进度和系统资源使用情况。可以使用`SHOW PROCESSLIST`命令查看导入进程的状态,并使用`top`或`ps`命令查看系统资源使用情况。

**调优**

如果导入速度不理想,可以尝试以下调优措施:

* **调整缓冲区大小:**增加`--bulk-insert-buffer-size`参数的值。

* **增加线程数:**对于并行导入,可以增加`--bulk-insert-threads`参数的值。

* **优化索引:**确保目标表上有适当的索引。

* **预处理数据:**对数据进行预处理,例如去除重复数据和压缩数据。

# 5. 特殊场景下的优化策略

### 5.1 大数据量导入优化

当导入的数据量达到TB甚至PB级别时,常规的优化策略可能难以满足性能要求。此时,需要采用专门针对大数据量导入的优化策略:

- **并行导入:**将导入任务拆分成多个子任务,并行执行。例如,使用MySQL的`LOAD DATA INFILE`命令中的`PARALLEL`选项,或使用第三方工具(如Sqoop)进行并行导入。

- **分表导入:**将数据拆分成多个表或分区,分别导入。这样可以避免单表数据量过大导致性能下降。

- **流式导入:**采用流式处理技术,将数据源的数据流式传输到目标数据库。这种方式可以避免数据在内存中累积,提高导入效率。

- **使用分布式数据库:**对于超大规模的数据导入,可以考虑使用分布式数据库,如MySQL Cluster或TiDB。这些数据库可以将数据分布在多个节点上,实现并行处理和负载均衡。

### 5.2 异构数据源导入优化

当数据源不是MySQL数据库时,需要采用异构数据源导入优化策略:

- **使用数据转换工具:**使用第三方工具(如Talend、Kettle)将异构数据源的数据转换为MySQL兼容格式,然后再导入。

- **建立数据连接器:**使用MySQL提供的连接器(如ODBC、JDBC),建立与异构数据源的连接,直接导入数据。

- **使用第三方中间件:**使用第三方中间件(如Kafka、Flume),将异构数据源的数据传输到MySQL数据库。

### 5.3 故障恢复与数据一致性保障

在数据导入过程中,可能遇到各种故障,导致数据导入失败或数据不一致。因此,需要采取措施保障故障恢复和数据一致性:

- **使用事务机制:**在导入过程中使用事务机制,确保数据要么全部导入成功,要么全部回滚。

- **设置检查点:**定期设置检查点,将已导入的数据记录下来。如果导入失败,可以从检查点恢复数据。

- **使用数据校验工具:**导入完成后,使用数据校验工具(如MySQL的`CHECKSUM TABLE`命令)验证数据的一致性。

- **制定应急预案:**制定详细的应急预案,明确故障处理流程和数据恢复措施。

# 6.1 综合优化方案

综合优化方案旨在将各个章节的优化策略有机结合,形成一套完整的优化方案。该方案应根据实际业务场景和数据特点进行定制化调整,以最大程度地提升数据导入性能。

**优化步骤:**

1. **数据预处理:**对数据进行清洗、转换和预处理,消除数据中的异常值和冗余信息,提高导入效率。

2. **批量导入:**使用批量导入工具(如mysqlimport、sqlldr)进行数据导入,减少与数据库的交互次数,提升导入速度。

3. **并行导入:**将数据拆分成多个子集,并使用多线程或多进程并发导入,充分利用服务器资源,缩短导入时间。

4. **分表导入:**将数据导入到多个表中,避免单表数据量过大导致性能下降。

5. **索引优化:**在导入前创建必要的索引,加快数据查询和更新速度。

6. **数据库配置优化:**调整数据库配置参数(如innodb_buffer_pool_size、innodb_flush_log_at_trx_commit),提升数据库性能。

7. **监控与调优:**使用监控工具(如MySQL Workbench、pt-query-digest)实时监控导入进程,并根据性能指标进行调优。

**优化效果:**

综合优化方案可以显著提升数据导入性能,具体优化效果取决于数据量、数据结构和服务器配置等因素。一般情况下,优化后的导入速度可以提升数倍甚至数十倍。

## 6.2 性能监控与持续优化

性能监控是持续优化数据导入过程的关键。通过监控导入进程的各项指标,可以及时发现性能瓶颈并进行针对性优化。

**监控指标:**

* 导入速度(每秒导入记录数)

* 数据库连接数

* CPU使用率

* 内存使用率

* I/O操作次数

**优化策略:**

* **定期监控:**定期查看监控指标,分析性能趋势,及时发现潜在问题。

* **瓶颈分析:**根据监控指标,分析性能瓶颈所在,可能是数据库、服务器或网络等方面。

* **针对性优化:**根据瓶颈分析结果,采取针对性的优化措施,如调整数据库配置、优化数据结构或升级服务器硬件。

* **持续改进:**数据导入是一个持续的过程,随着业务需求和数据量的变化,需要不断优化导入策略,以保持最佳性能。

0

0