【R语言数据连接】:data.table包的merge与join高效对比

发布时间: 2024-11-03 04:11:21 阅读量: 65 订阅数: 48

# 1. R语言数据连接的基础知识

在现代数据分析和处理中,有效地连接数据是至关重要的步骤之一。数据连接在R语言中扮演着核心角色,因为它允许研究人员和数据科学家将来自不同来源的数据整合到一起,进而执行进一步的分析或建模工作。

R语言提供了多种数据连接的方法,其中最为基础的是使用`merge()`函数。`merge()`函数可以依据一个或多个共同的键值(key)将两个数据集进行合并,实现行的匹配。更高级的连接策略包括使用第三方包,如`data.table`,它提供了更为高效的数据处理能力,特别是在处理大型数据集时。

在深入`data.table`包之前,我们需要了解数据连接的基础知识,这包括理解数据框(data frame)的基本结构、识别连接类型(如内连接、外连接等)、以及选择合适的连接键。这些基础知识是构建复杂数据分析和处理流程的基石。下面章节将对`data.table`包进行深入探讨,揭示其在数据连接方面的强大功能和优化性能。

# 2. 深入理解data.table包

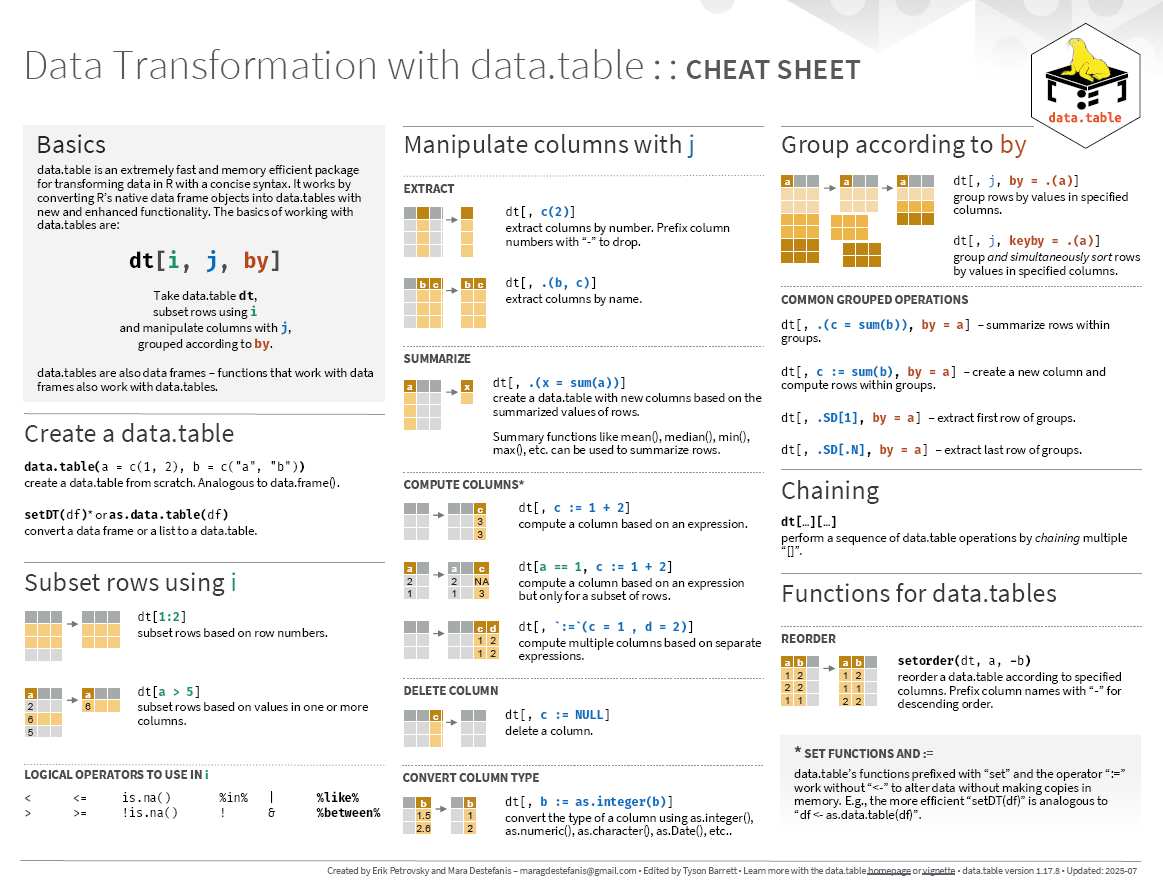

在数据分析和数据处理的领域,data.table包是R语言中一个强大且广泛使用的工具,它提供了一种高效的方式来处理大型数据集。本章将深入探讨data.table包的基本用法、高级特性和性能调优方法。

## 2.1 data.table包的基本用法

### 2.1.1 data.table对象的创建和转换

data.table包的核心是data.table对象,它是一种特殊的数据框(data frame)形式,提供了更快的数据操作和更有效的内存管理。要创建一个data.table对象,您可以使用`data.table()`函数,将一个data.frame或者向量作为输入。

```R

library(data.table)

# 从data.frame转换

df <- data.frame(x = 1:5, y = letters[1:5])

dt <- data.table(df)

class(dt) # 输出:[1] "data.table" "data.frame"

```

在上述代码中,我们首先加载了data.table包,然后创建了一个data.frame对象`df`,并使用`data.table()`函数将其转换为data.table对象`dt`。通过查看`dt`的类别,我们可以确认它同时是data.table和data.frame的实例。

data.table对象的转换是构建高效数据处理流程的第一步,接下来,我们探索快速子集操作的技巧。

### 2.1.2 data.table对象的快速子集操作

快速子集操作是data.table包的一大特点。在data.table中,子集操作是通过直接在数据集上调用筛选条件来完成的。这不仅语法简洁,而且运行速度远快于传统的data.frame操作。

```R

# 在data.table中进行快速子集操作

subset_dt <- dt[x > 3 & y %in% c("a", "b")]

print(subset_dt)

```

上述代码展示了如何在data.table对象`dt`中进行快速子集操作,筛选出`x`列大于3且`y`列值为"a"或"b"的行。输出结果将仅包含符合条件的子集数据。

快速子集操作的关键在于,data.table利用了它的内部机制来优化查询,减少了显式循环的需要。这使得在处理大数据集时,能够显著提升效率。

## 2.2 data.table包的高级特性

### 2.2.1 自动构建键值索引

data.table包的另一个高级特性是它能够自动构建键值索引,这使得某些类型的查询几乎可以即时完成。键值索引是一种提升数据检索效率的方法,data.table在内部自动处理键值,对用户完全透明。

```R

# 为data.table对象创建键值索引

setkey(dt, y)

```

通过使用`setkey()`函数,我们可以为data.table对象`dt`的`y`列创建一个键值索引。这将使与`y`列相关的子集操作和合并操作更加高效。创建索引后,data.table会自动使用这些索引来加速数据检索。

### 2.2.2 优化内存使用的技巧

data.table的设计目标之一是优化内存使用,以处理大型数据集。它通过引用语义来避免不必要的复制,这种机制意味着赋值data.table对象时,实际上传递的是引用而非数据副本。

```R

# 使用引用语义在data.table中高效复制数据

dt2 <- dt

```

在上述代码中,我们并没有创建`dt`的副本,而是创建了一个引用。这意味着对`dt2`的任何更改都会反映在`dt`上,而不会消耗额外的内存。通过这种方式,data.table包帮助我们优化内存使用,使得数据操作更为高效。

## 2.3 data.table包的性能调优

### 2.3.1 性能基准测试

了解data.table包的性能优势的一个重要方法是通过基准测试。基准测试可以帮助我们理解在不同操作和数据集大小下,data.table与其他方法的性能比较。

```R

# 基准测试不同数据操作的性能

microbenchmark::microbenchmark(

data.table_query = dt[x > 3 & y %in% c("a", "b")],

data.frame_query = subset(df, x > 3 & y %in% c("a", "b")),

times = 10L

)

```

在上述基准测试中,我们使用`microbenchmark`包来比较data.table和data.frame在执行相同的子集操作时的性能。通过多次运行查询,我们可以获得性能的均值和变异性,这有助于我们评估哪种方法在实际应用中更为高效。

### 2.3.2 针对不同场景的调优策略

虽然data.table在许多情况下都提供优秀的性能,但不同的使用场景可能需要不同的调优策略。为了最大化性能,开发者需要理解如何根据具体的操作来调整data.table的行为。

```R

# 调整data.table的内部参数来优化性能

options(datatable.print.nrows = 10) # 修改打印行数

options(datatable.optimize.speed = TRUE) # 优化执行速度

```

在上例中,我们通过修改全局选项来优化data.table的行为。第一个选项改变了输出行数,而第二个选项则激活了针对执行速度的优化。根据不同的数据操作和性能需求,调整这些选项可以显著改善data.table的性能表现。

在本章中,我们已经了解到data.table包在基本用法和高级特性方面的一些重要概念,包括如何创建data.table对象、利用键值索引以及优化内存使用。另外,我们也探讨了性能调优的重要性,并通过基准测试和调整选项来提高data.table包的执行效率。在下一章中,我们将深入探讨data.table包中的merge与join操作,以及如何在实际数据处理场景中有效地应用这些操作。

# 3. data.table包的merge与join操作

## 3.1 merge与join操作的理论基础

### 3.1.1 merge与join的概念解析

在数据处理中,合并操作是连接数据表中相关行的基本手段。在R语言中,merge和join是实现此类操作的常用函数。它们都旨在将来自两个数据集的信息合并到一个数据集中。

- **merge() 函数**是R语言基础包中的一个功能,它可以按照指定的键值将数据框(data frames)进行内连接(inner join)、外连接(outer join)、左连接(left join)和右连接(right join)。默认情况下,merge函数执行内连接操作。

- **join() 函数**是data.table包提供的一个更高效的数据合并方式,它允许用户对数据表执行内连接、左连接、右连接和全连接。data.table的join操作以键值为基础,采用优化过的算法,提升处理大数据集时的效率。

理解这两者之间的关系和区别是熟练使用data.table包进行数据处理的关键。

### 3.1.2 R语言中的merge与join函数比较

在R语言中,data.table的join函数与基础R的merge函数相比,有一些显著的优势:

- **性能**: data.table的join操作经过优化,可以更快地处理大规模数据集。

- **语法简洁**: 使用data.table的语法通常更为简洁,可读性更好。

- **内存管理**: data.table在内部进行优化,减少内存使用,有助于处理大型数据集。

然而,基础R的merge函数仍然在某些情况下具有其特定优势,如直接可用性、不需额外安装包等。

## 3.2 data.table包中的merge操作

### 3.2.1 merge函数的用法与示例

data.table包中的merge操作是通过`data.table`类对象来实现的。在合并时,可以通过指定`on`参数来确定连接的列。下面是一个使用data.table的merge操作的简单示例:

```r

library(data.table)

# 创建两个data.table对象

dt1 <- data.table(id = 1:4, value = c("a", "b", "c", "d"

```

0

0