SVM优化:SMO算法的改进策略

"这篇文档主要讨论了支持向量机(SVM)中Platt的SMO(Sequential Minimal Optimization)算法的改进方法。SMO算法在SVM训练中扮演着关键角色,通过优化拉格朗日乘子来找到最佳超平面。然而,标准的SMO算法在选择每轮优化的两个乘子时可能会遇到问题,即可能会选择到并不真正违反KKT条件的乘子,导致无效的迭代。文档提到了两种改进策略:1) 通过Maximal Violating Pair (MVP) 选择优化乘子;2) 通过Second Order Information选择优化乘子。这两种方法都基于对偶问题的KKT条件,旨在更有效地找到需要优化的乘子对,从而提高算法的效率和精度。"

在支持向量机的学习过程中,Platt的SMO算法是一种常用的求解对偶问题的高效算法。标准的SMO算法选取违反KKT条件的拉格朗日乘子进行优化,但这种方法可能导致对原本满足条件的点进行不必要的迭代。KKT条件是优化问题中的必要条件,它确保了解的可行性。在SVM的原问题中,KKT条件涉及到拉格朗日乘子、样本标记以及偏置项。

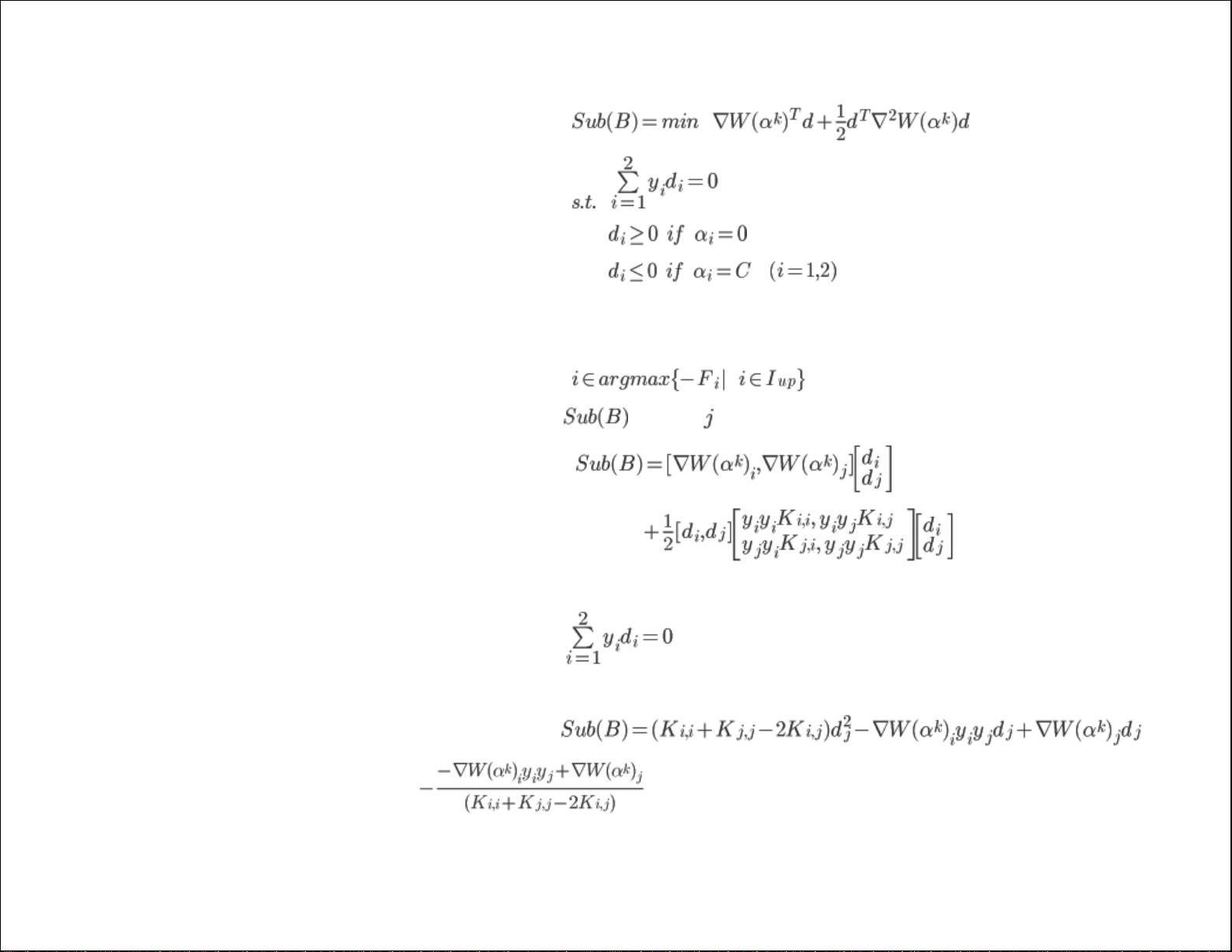

第一种改进策略是Maximal Violating Pair (MVP) 方法。这种方法寻找违反对偶问题KKT条件最严重的乘子对。通过对偶问题的KKT条件重新表述,当分类器对所有样本分类正确时,所有乘子都应该满足特定的条件。引入容忍值后,可以识别出那些接近但未完全满足条件的乘子对。MVP策略就是选择使得KKT条件差异最大的乘子对,这样优化这两个乘子将最大程度地减少目标函数,从而加速算法收敛。

第二种策略是利用Second Order Information,即二阶信息来选择优化乘子。这种方法基于一个定理,如果Hessian矩阵(即拉格朗日函数关于拉格朗日乘子的二阶导数矩阵)是半正定的,优化乘子为MVP时,目标函数会严格下降。通过一阶或二阶导数信息,可以更精确地识别哪些乘子对能导致目标函数的显著下降,从而提高算法的效率。

这两种改进方法都致力于避免无效的迭代,提高SMO算法的性能。通过更智能地选择需要优化的乘子对,可以减少计算时间和资源消耗,同时保证模型的准确性和泛化能力。在实际应用中,这些改进策略对于大规模数据集的SVM训练尤其有价值。

2019-08-10 上传

2023-06-09 上传

2023-12-14 上传

2023-06-08 上传

2023-05-16 上传

2024-01-21 上传

2023-06-08 上传

2023-11-28 上传

妖孽横生

- 粉丝: 33

- 资源: 133

最新资源

- C语言快速排序算法的实现与应用

- KityFormula 编辑器压缩包功能解析

- 离线搭建Kubernetes 1.17.0集群教程与资源包分享

- Java毕业设计教学平台完整教程与源码

- 综合数据集汇总:浏览记录与市场研究分析

- STM32智能家居控制系统:创新设计与无线通讯

- 深入浅出C++20标准:四大新特性解析

- Real-ESRGAN: 开源项目提升图像超分辨率技术

- 植物大战僵尸杂交版v2.0.88:新元素新挑战

- 掌握数据分析核心模型,预测未来不是梦

- Android平台蓝牙HC-06/08模块数据交互技巧

- Python源码分享:计算100至200之间的所有素数

- 免费视频修复利器:Digital Video Repair

- Chrome浏览器新版本Adblock Plus插件发布

- GifSplitter:Linux下GIF转BMP的核心工具

- Vue.js开发教程:全面学习资源指南