华为端侧AI:模型压缩、架构优化与未来趋势探讨

需积分: 21 42 浏览量

更新于2024-07-15

收藏 3.57MB PDF 举报

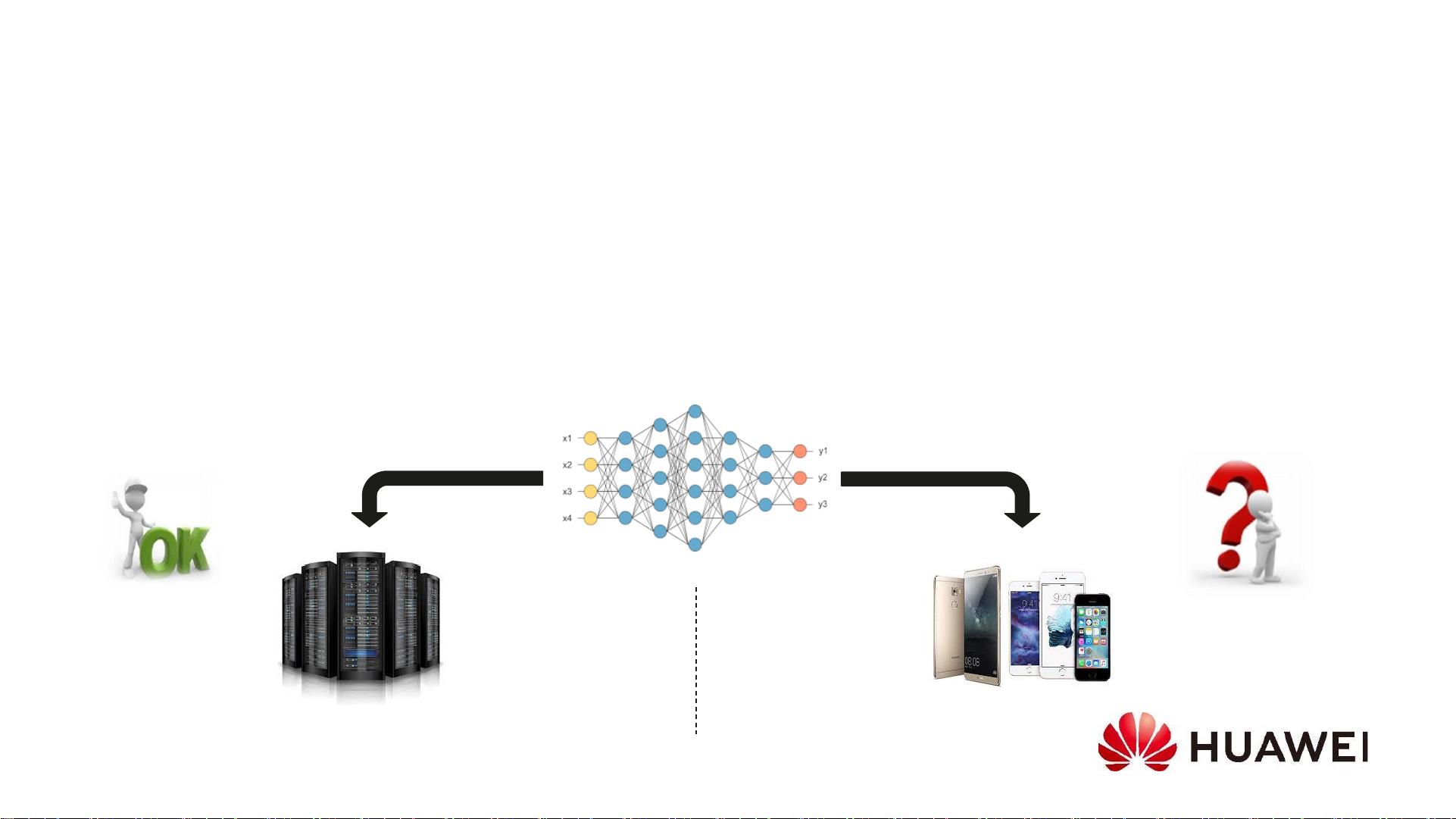

本文档深入探讨了端侧人工智能(端侧AI)模型的进展与未来发展,重点关注在华为诺亚方舟实验室背景下,特别是在与华为昇腾芯片的结合上。文章首先介绍了端侧AI的背景,强调了将其从云端AI迁移至设备端的四个关键驱动因素:隐私与安全需求、实时反馈的需求、网络连接的不稳定性以及能耗效率的提升。

端侧AI的发展历程中,深度神经网络架构经历了显著变化,从最早的LeCun等人在1998年提出的基于梯度的学习应用到文档识别,到后来的AlexNet、GoogleNet、VGG、ResNet等模型在大规模物体识别和图像处理中的突破。这些模型不仅在性能上不断提升,而且在参数量和计算速度上也有着显著的进步,如AlphaGo在围棋领域的卓越表现和MobileNet的轻量化设计。

针对端侧设备的计算能力和资源限制,文章着重讨论了如何通过深度神经网络模型压缩技术来实现加速,如Han et al.在NIPS 2015和ICLR 2016年的研究,展示了如何通过剪枝、量化和低秩分解等方法减少模型大小和计算负担,使得模型能够在移动设备上更高效运行。

此外,架构搜索也是一个关键话题,文中可能提及了如何利用神经架构搜索(NAS)算法,如NAS在GoogleNet和AlphaGo中的应用,寻找最优化的网络结构,以适应不同设备的性能需求。

关于用户隐私保护,文章可能会提到当前端侧AI面临的挑战,如何在提供高效服务的同时确保数据在本地处理,遵守严格的隐私法规。这可能包括加密技术、差分隐私和数据最小化策略的应用。

最后,文档还涉及端侧AI与华为昇腾芯片的关系,解释了昇腾芯片如何作为端侧AI计算的硬件支持,其在性能、能效和对AI模型的优化上的重要作用。未来的展望部分,可能会探讨更多前沿技术,如更先进的芯片技术、边缘计算、以及AI模型的持续优化,以适应不断变化的市场需求和用户期待。

这篇论文深入剖析了端侧AI模型的发展现状,提供了实际解决方案,并展望了这个领域在技术和应用层面的前景。

2024-08-05 上传

2024-08-02 上传

2022-12-27 上传

2023-06-05 上传

2021-05-07 上传

2021-04-24 上传

2019-09-25 上传

2021-04-08 上传

2021-02-06 上传

jwy2014

- 粉丝: 362

- 资源: 26

最新资源

- C语言数组操作:高度检查器编程实践

- 基于Swift开发的嘉定单车LBS iOS应用项目解析

- 钗头凤声乐表演的二度创作分析报告

- 分布式数据库特训营全套教程资料

- JavaScript开发者Robert Bindar的博客平台

- MATLAB投影寻踪代码教程及文件解压缩指南

- HTML5拖放实现的RPSLS游戏教程

- HT://Dig引擎接口,Ampoliros开源模块应用

- 全面探测服务器性能与PHP环境的iprober PHP探针v0.024

- 新版提醒应用v2:基于MongoDB的数据存储

- 《我的世界》东方大陆1.12.2材质包深度体验

- Hypercore Promisifier: JavaScript中的回调转换为Promise包装器

- 探索开源项目Artifice:Slyme脚本与技巧游戏

- Matlab机器人学习代码解析与笔记分享

- 查尔默斯大学计算物理作业HP2解析

- GitHub问题管理新工具:GIRA-crx插件介绍