探索Apache Spark Delta Lake事务日志:实现ACID与数据一致性

107 浏览量

更新于2024-08-29

收藏 458KB PDF 举报

深入理解Apache Spark Delta Lake的事务日志是一项关键任务,因为它对于数据处理系统中的核心功能至关重要,特别是对于支持ACID属性(原子性、一致性、隔离性和持久性)。Delta Lake在2019年的Spark+AI Summit大会上被开源,旨在解决大规模数据处理中的挑战,比如事务管理、元数据扩展和时间旅行。

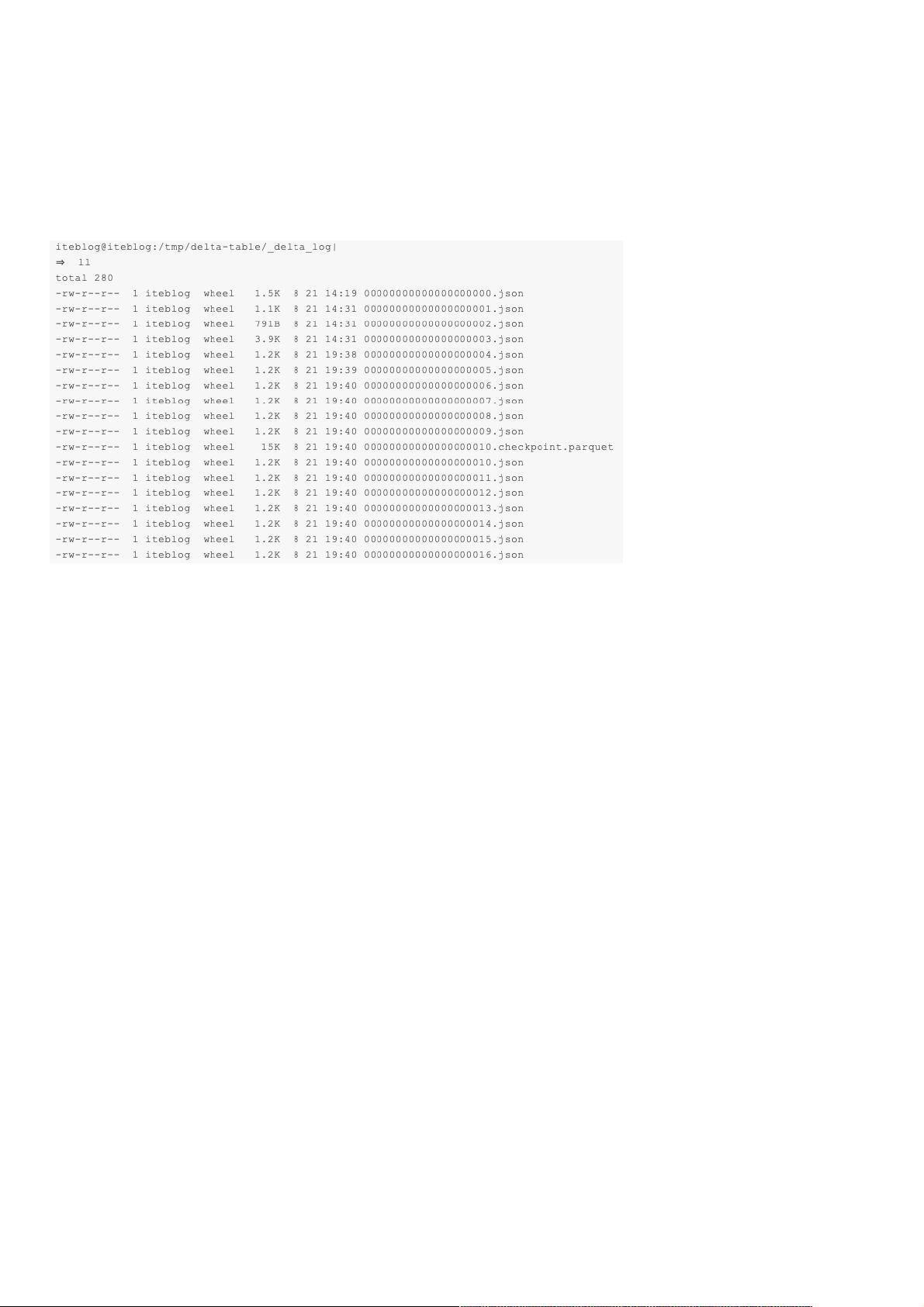

Delta Lake的事务日志,通常称为DeltaLog,是每个表操作的记录,以保证每次事务的顺序执行。事务日志的主要作用是作为单一的事实来源,维护表的所有变更历史,无论数据量有多大。这使得在并发读写环境中,Spark能够实时更新用户的数据视图,避免数据冲突。

事务日志的工作原理是将每一次写操作分解为原子操作。这意味着,如果一个操作是成功的,那么整个事务就会被完整地记录在日志中;反之,如果遇到任何失败,整个事务都不会被写入,从而保持数据的一致性。这种设计保证了在出现硬件故障或软件错误时,不会出现部分数据丢失的情况,提升了系统的可靠性。

在Delta Lake中,当用户首次读取一个表或者运行新的查询时,Spark会检查事务日志,找出表自上次读取以来的新增更改,然后将这些更改应用到用户看到的表上,确保数据版本与最新的主记录保持同步。这样,用户不会看到不一致的或冲突的更改,提高了数据的准确性和一致性。

Apache Spark Delta Lake的事务日志是其基石组件,通过精妙的设计实现了ACID特性,使得在分布式环境下的大规模数据处理变得高效且可靠。理解事务日志的工作原理,有助于我们更好地利用Delta Lake提供的强大功能,包括支持并发操作、保证数据一致性以及实现时间旅行等高级特性。

2019-08-08 上传

2021-01-27 上传

2019-10-28 上传

2020-11-28 上传

2019-10-28 上传

2019-10-28 上传

2021-01-20 上传

点击了解资源详情

点击了解资源详情

weixin_38551046

- 粉丝: 5

- 资源: 928

最新资源

- Python中快速友好的MessagePack序列化库msgspec

- 大学生社团管理系统设计与实现

- 基于Netbeans和JavaFX的宿舍管理系统开发与实践

- NodeJS打造Discord机器人:kazzcord功能全解析

- 小学教学与管理一体化:校务管理系统v***

- AppDeploy neXtGen:无需代理的Windows AD集成软件自动分发

- 基于SSM和JSP技术的网上商城系统开发

- 探索ANOIRA16的GitHub托管测试网站之路

- 语音性别识别:机器学习模型的精确度提升策略

- 利用MATLAB代码让古董486电脑焕发新生

- Erlang VM上的分布式生命游戏实现与Elixir设计

- 一键下载管理 - Go to Downloads-crx插件

- Java SSM框架开发的客户关系管理系统

- 使用SQL数据库和Django开发应用程序指南

- Spring Security实战指南:详细示例与应用

- Quarkus项目测试展示柜:Cucumber与FitNesse实践