深度解析梯度下降优化算法:理论与实践

需积分: 9 122 浏览量

更新于2024-09-09

收藏 644KB PDF 举报

本文是一篇深入探讨梯度下降优化算法的综述文章,作者Sebastian Ruder旨在帮助读者理解这种广泛应用于机器学习和深度学习中的基础优化技术。随着深度学习的兴起,尽管梯度下降方法应用越来越普遍,但由于其复杂性和细节,实践中对其优势和局限性的直观解释却相对较少。

首先,文章强调了梯度下降算法的核心思想:通过沿着目标函数的负梯度方向逐步调整模型参数,以最小化损失函数,从而找到全局或局部最优解。它适用于连续可微函数的优化问题,是训练神经网络和解决机器学习问题的标准工具。

接下来,文章详细介绍了不同类型的梯度下降算法,包括:

1. **批量梯度下降(Batch Gradient Descent)**:每次更新都基于所有训练样本的梯度,但可能在大数据集上计算开销大且可能导致收敛速度慢。

2. **随机梯度下降(Stochastic Gradient Descent, SGD)**:每次更新只用一个随机选择的样本,速度快但可能不那么稳定,适合大规模数据集。

3. **小批量梯度下降(Mini-batch Gradient Descent)**:折中方案,每次使用一小部分样本计算梯度,既具有SGD的效率又保留了部分稳定性。

此外,文章讨论了梯度下降在并行和分布式环境中的实现挑战,如数据并行、模型并行和通信开销,以及如何通过数据分片、模型拆分等策略来优化这些设置。

文中还提到了几个流行的深度学习库,如Lasagne、Caffe和Keras,它们各自对梯度下降优化算法提供了不同的实现和配置选项,反映了业界实践的多样性。

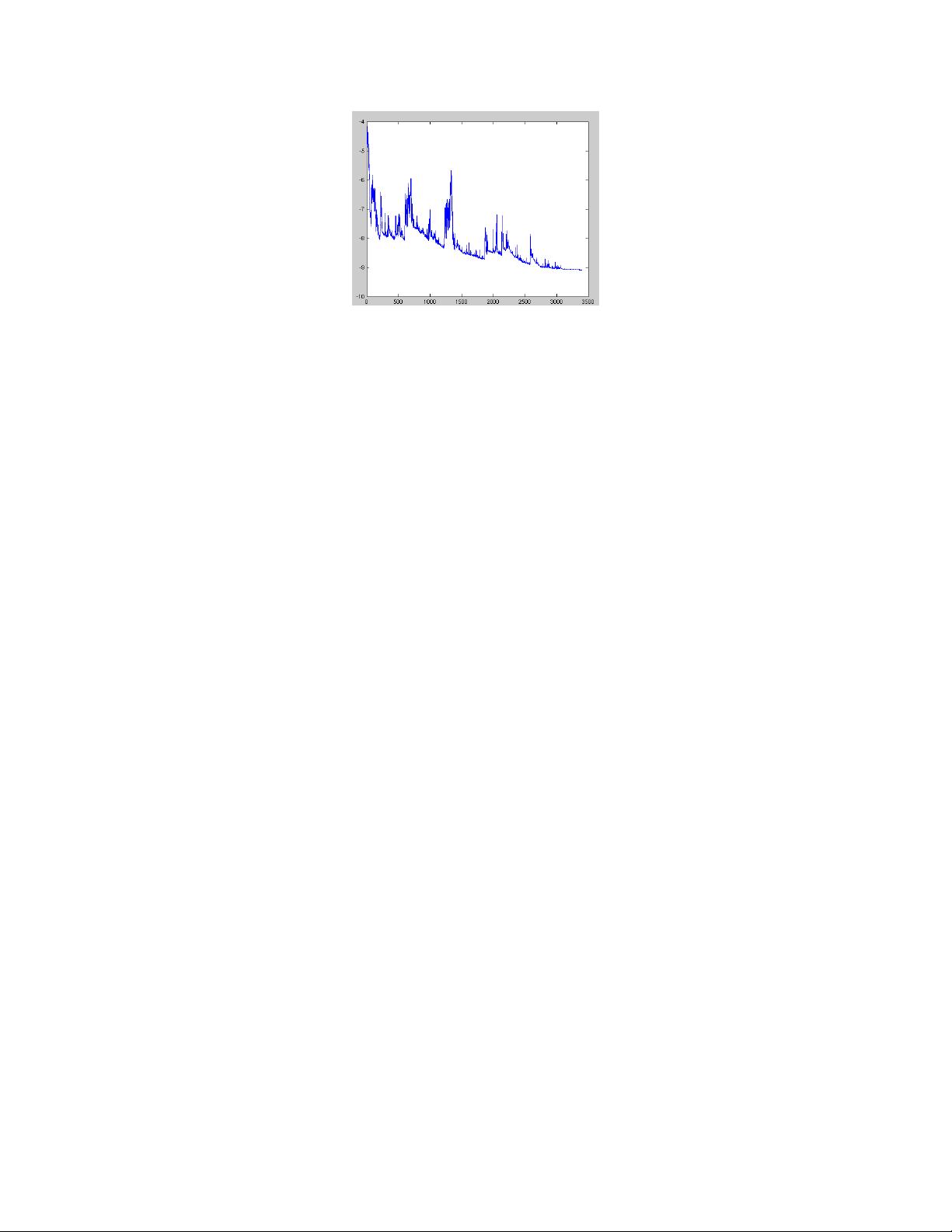

文章进一步涵盖了优化过程中可能遇到的问题,如局部最优解、梯度消失或爆炸、学习率调整策略(如固定学习率、衰减学习率等),以及如何通过动量法、自适应学习率算法(如Adagrad、RMSprop和Adam)来改善性能。

最后,文章鼓励读者结合理论和实践经验,根据具体任务选择合适的梯度下降变种,并理解其内在机制,以便更有效地利用这一核心优化技术。通过阅读这篇文章,读者可以更好地掌握梯度下降的精髓,将其运用到实际问题中,并进行进一步的改进和创新。

2018-03-11 上传

2023-10-18 上传

2023-06-06 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

herosunly

- 粉丝: 7w+

- 资源: 170

最新资源

- MessageBoard:一个用 Ember.js 编写的留言板应用

- abiramen.github.io

- SourceCodeViewer:网页原始码查看器

- 【精品推荐】智慧档案馆大数据智慧档案馆信息化解决方案汇总共5份.zip

- demandanalysis,java源码学习,java源码教学

- pybind11-initialsteps:一些可能对pybind11有用的示例程序

- cv-lin:网页简历原始码

- React-Codeial

- chan65chancleta20:Basi HTML页面

- GGOnItsOwnYo:带有 Yeoman 脚手架的 MEAN 堆栈

- 支持部署动态网站和静态网站

- Shopping,java源码之家,java授权系统

- scottzirkel:在https上找到的个人站点

- chan65chancleta19:Basi HTML页面

- Mihirvijdeshpande

- cure:Cure.js 是 JavaScript Polyfill 的集合,可帮助确保您的项目跨浏览器兼容