Spark本地环境搭建与开发完全指南

需积分: 14 154 浏览量

更新于2024-07-20

收藏 3.42MB PDF 举报

"Spark开发及本地环境搭建指南"

在本文档中,我们将深入探讨如何进行Spark开发,并在本地计算机上建立开发环境。Spark是一个流行的分布式计算框架,它提供了高效的批处理、交互式查询(通过Spark SQL)、实时流处理(通过Spark Streaming)以及机器学习(通过MLlib)等功能。作为入门指南,此文档适用于对大数据处理感兴趣的开发者和数据科学家。

首先,了解Spark的核心概念至关重要。Spark由一个主节点(Driver)和多个工作节点(Executor)组成,工作在弹性分布式数据集(RDD)之上,这是一种容错的、可并行操作的数据结构。RDDs支持多种操作,如转换(Transformation)和动作(Action),转换创建新的RDD,而动作触发实际的计算并可能返回结果。

构建本机开发环境是开始Spark之旅的第一步。以下是一般步骤:

1. **安装Java**:Spark是用Scala编写的,需要Java运行环境。确保你已经安装了Java 8或更高版本。

2. **获取Spark源码**:你可以从Apache Spark官方网站下载最新版本的源码或者通过Git克隆Spark仓库。

3. **配置环境变量**:将Spark和Scala的bin目录添加到PATH环境变量中,以便于命令行调用。

4. **构建Spark**:使用`sbt package`命令来编译和打包Spark。这将生成一个可执行的jar文件,可以在本地或集群上运行。

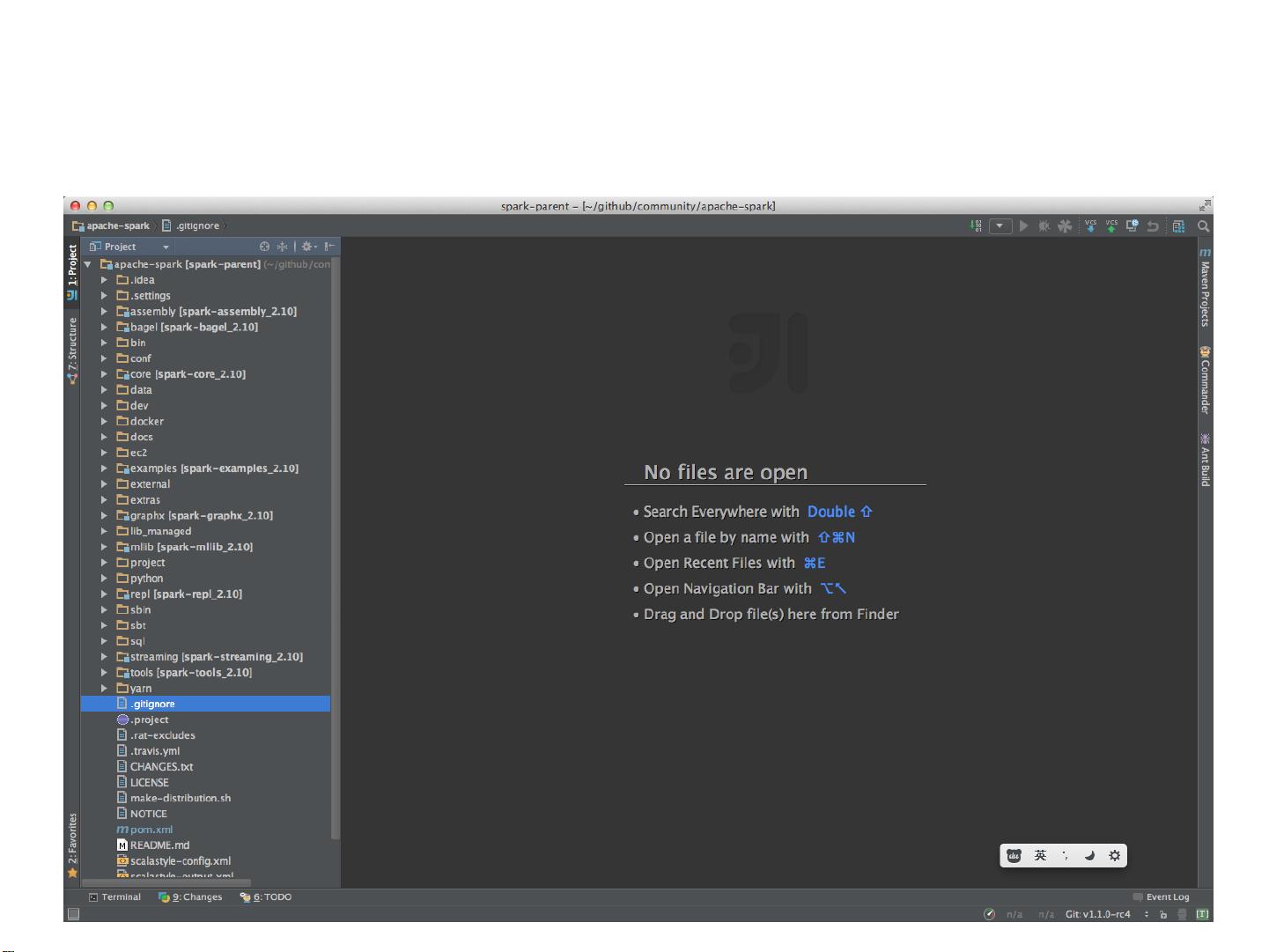

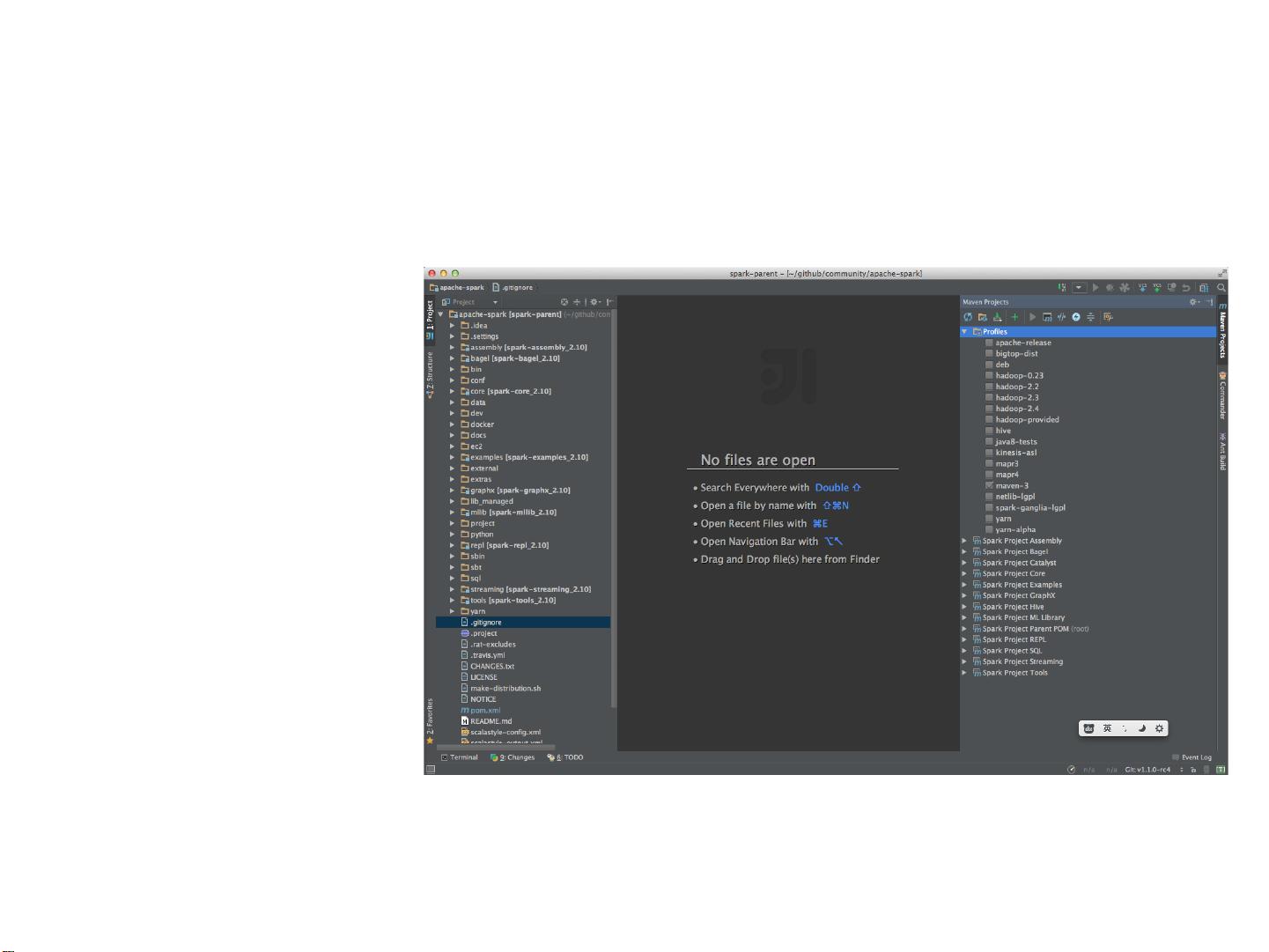

5. **选择IDE**:对于本地开发,可以选择IntelliJ IDEA或Eclipse等集成开发环境,它们都有Scala插件支持Spark开发。设置IDE时,导入Spark项目并配置Scala和Spark的相关库。

6. **创建Spark Context**:在代码中,你需要创建一个SparkContext对象,这是与Spark集群交互的入口点。在本地模式下,可以使用`SparkConf().setMaster("local[*]")`来启动Spark。

7. **编写Spark程序**:利用Spark API创建RDDs,应用转换和动作。例如,你可以使用`sc.textFile()`读取文本文件,然后用`map()`函数处理数据,最后通过`count()`或`collect()`等动作进行计算。

8. **测试和调试**:在IDE中运行你的Spark程序,观察结果。对于复杂的任务,可以使用Spark的交互式Shell(如`spark-shell`或`pyspark`)进行快速原型验证。

9. **提交到社区**:如果你在开发过程中修复了问题或增加了新功能,可以考虑向Spark社区提交Pull Request(PR)。首先,你需要熟悉Spark的贡献指南,然后创建分支,做出修改,最后发起合并请求。

此外,Linux公社是一个丰富的资源库,不仅提供Spark的搭建指南,还有其他如Ubuntu、Fedora、Oracle、Hadoop等多方面的Linux和开源技术信息。其专题栏目涵盖了广泛的Linux和相关技术,是学习和解决问题的好去处。

Spark的本地开发环境搭建是一个初始但重要的步骤,它让你能够在个人计算机上试验和调试代码,为后续的大规模分布式计算打下基础。通过不断实践和探索,你将能更好地理解和利用Spark的强大功能。

2024-07-22 上传

164 浏览量

242 浏览量

177 浏览量

2060 浏览量

137 浏览量

点击了解资源详情

579 浏览量

124 浏览量

IMLZY

- 粉丝: 3

- 资源: 5

最新资源

- 软件水平考试网络工程师英语复习练习题10套

- JAVA面试题目大汇总

- 门禁系统设计 论文 完整版

- soa相关技术介绍与实现

- a Frame Layout Framework

- Thinking in Patterns

- 图书管理信息系统 SIM SQL Server2000数据库管理系统

- Bayesian and Markov chain

- Analysis of a Denial of Service Attack on TCP.

- 802.11英文原版协议 11G 11 N WEP WPA WPA2 BEACON 好东西大家分享

- aix双机配置详细配置

- 中国联通SGIP1.2

- 09数据库系统工程师考试大纲

- DFBlaser窄线宽激光器

- WinSock编程基础原理与C实现代码

- bfin-uclinux内核的CPLB v0.1