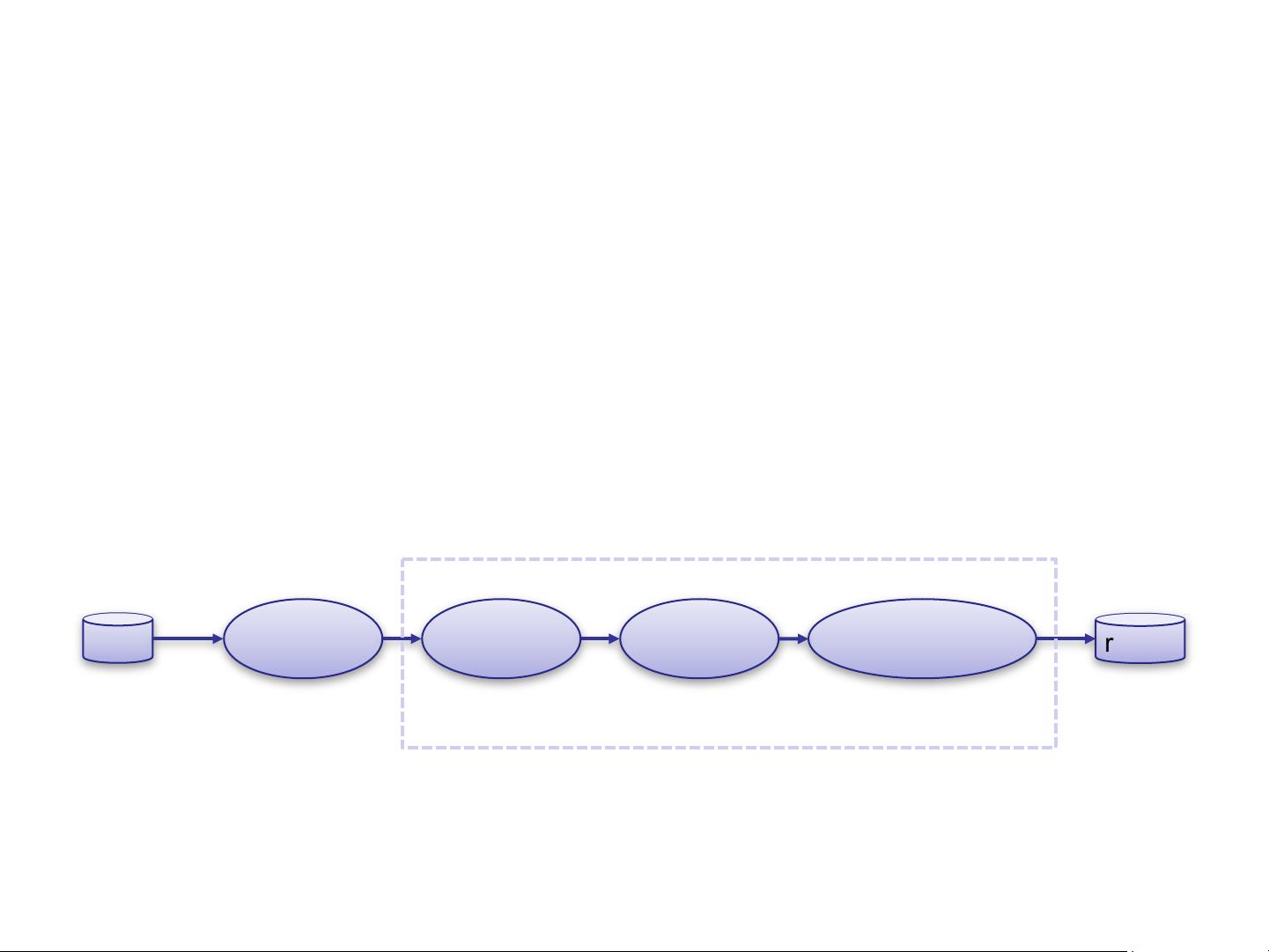

"这篇文档是关于大数据处理框架hadoop、spark和NoSQL数据库的实战教程的第二部分,主要聚焦在flume的特性和工作原理上。flume是一个用于大规模日志收集、聚合和传输的系统,具有分布式、可靠性和高可用性的特点。它能与多种数据源和接收方集成,包括HDFS和Hbase等。" 在大数据处理领域,flume扮演着至关重要的角色。它的核心功能包括日志数据的采集、处理和传输。flume的工作流程基于事件(Event)的概念,事件包含了实际的日志数据和相关的元数据。Source作为数据的入口,负责从外部源获取事件,例如网络日志流。Source接收到事件后,会进行适当的格式化,并将事件推送到Channel中,这里Channel可以视为一种临时存储,用于在Source和Sink之间保持数据。 Channel是flume实现可靠性的关键组件。它可以确保即使在节点故障时,数据也不会丢失。根据不同的可靠性需求,flume提供了三种策略:end-to-end、store-on-failure和best-effort。FileChannel是推荐的实现方式,它将事件持久化在本地文件系统中,以确保数据的安全性。 Sink则负责从Channel取出事件并进行进一步处理,例如将数据写入HDFS或发送给下一个Source。每个Agent可以包含多个Source和Sink,以满足复杂的数据流需求。此外,Agent是在JVM上运行的独立实体,每台机器上通常部署一个Agent,但一个Agent内可以有多个数据处理组件。 Client是数据的生产者,可能运行在独立的线程中,生成日志或其他数据供flume收集。Source、Sink和Channel构成了flume的核心组件,它们协同工作,形成了一种高效、灵活的日志处理流水线。 总结来说,flume是大数据环境中不可或缺的工具,尤其在日志管理和分析中。通过其分布式、可靠的特性,flume能够有效处理大规模的日志数据,确保数据的完整性和可用性,同时提供与其他大数据技术如hadoop和spark的无缝集成,从而构建强大的大数据处理生态系统。

剩余66页未读,继续阅读

- 粉丝: 4

- 资源: 40

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

最新资源

- 计算机人脸表情动画技术发展综述

- 关系数据库的关键字搜索技术综述:模型、架构与未来趋势

- 迭代自适应逆滤波在语音情感识别中的应用

- 概念知识树在旅游领域智能分析中的应用

- 构建is-a层次与OWL本体集成:理论与算法

- 基于语义元的相似度计算方法研究:改进与有效性验证

- 网格梯度多密度聚类算法:去噪与高效聚类

- 网格服务工作流动态调度算法PGSWA研究

- 突发事件连锁反应网络模型与应急预警分析

- BA网络上的病毒营销与网站推广仿真研究

- 离散HSMM故障预测模型:有效提升系统状态预测

- 煤矿安全评价:信息融合与可拓理论的应用

- 多维度Petri网工作流模型MD_WFN:统一建模与应用研究

- 面向过程追踪的知识安全描述方法

- 基于收益的软件过程资源调度优化策略

- 多核环境下基于数据流Java的Web服务器优化实现提升性能

信息提交成功

信息提交成功