深度学习暑期课程:递归神经网络概述与应用

需积分: 10 56 浏览量

更新于2024-07-19

收藏 23.39MB PDF 举报

Recurrent Neural Networks (RNNs) 是一种深度学习模型,特别适用于处理序列数据,如文本、音频或时间序列预测。在2016年的Deep Learning Summer School中,由Yoshua Bengio教授讲解,蒙特利尔学习算法研究所(Montreal Institute for Learning Algorithms)和蒙特利尔大学(Université de Montréal)共同提供的课程内容涵盖了RNN的核心概念和应用。

1. **递归状态更新**: RNN的关键在于其能够通过一个可变大小的状态向量(state vector),通过递归的方式对输入序列进行选择性地总结。这个过程涉及到在每个时间步(time step)更新状态,使得网络能够在新的长度上泛化,即使这些长度在训练期间并未遇到也能适应。

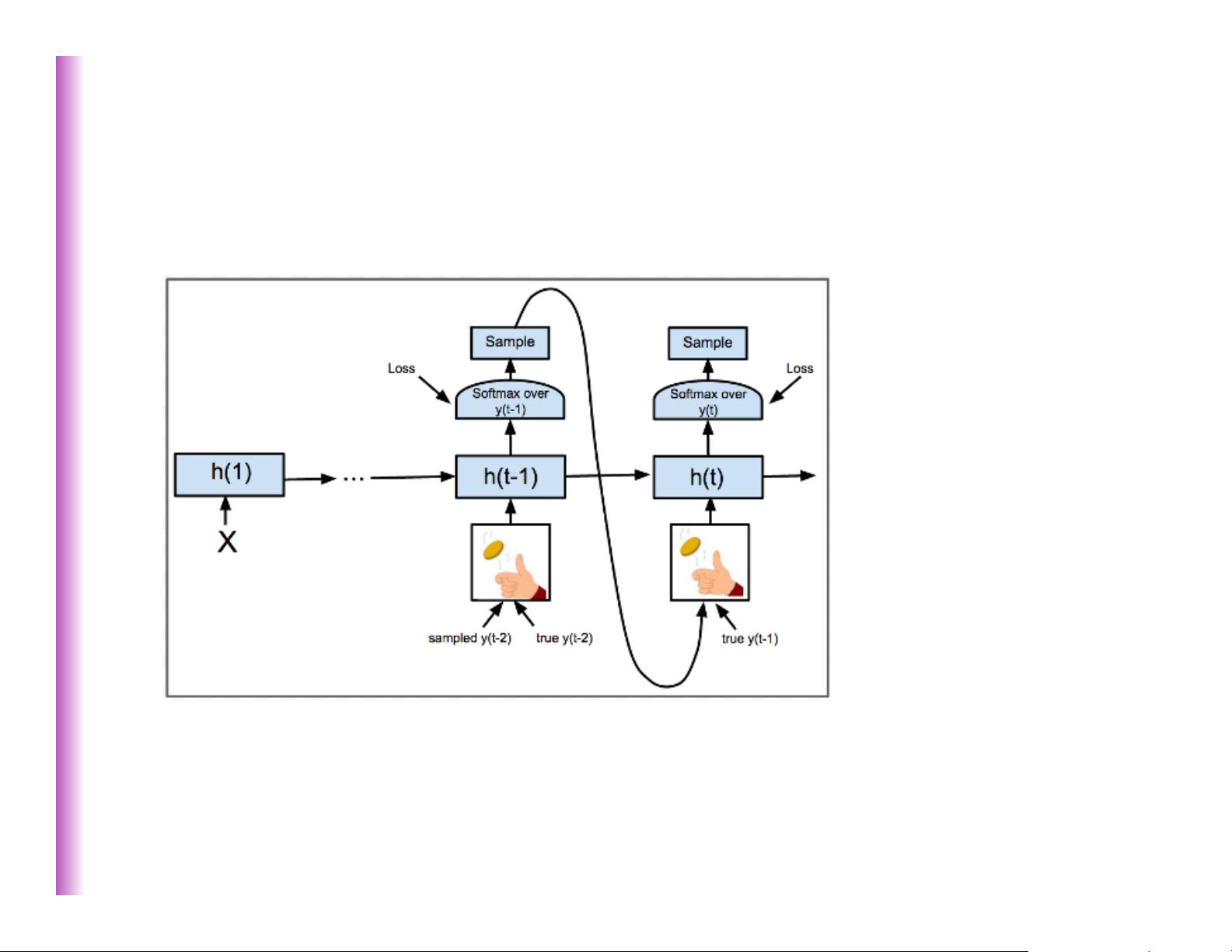

2. **逐时间步输出**: RNN的一个显著特点是能够生成每个时间步的输出。通过展开网络结构,我们可以明确如何通过反向传播算法(backpropagation through time, BPTT)更新权重,从而调整网络内部变量之间的连接。

3. **生成性RNN**: RNN可以表示为一个全连接的有向生成模型,其中每个变量都依赖于所有先前的输入,使其能够预测序列中的后续元素,并具备生成新序列的能力。

4. **条件分布与序列建模**: RNN不仅限于预测单个值,还可以用于各种序列到序列的转换任务。例如,它可以将一个序列映射成固定长度的向量(sequencetovector),或者生成与输入序列相同长度的新序列(sequencetosequence)。此外,还可以处理从向量到序列(vectortosequence)和序列到序列(sequencetosequence)的任务,如条件概率分布的估计。

5. **自回归结构**: 在RNN中,隐藏层的状态(hidden state)h(t)通常与前一个时间步的隐藏状态h(t-1)以及当前输入x(t)相互作用,生成下一个隐藏状态h(t+1)和输出o(t),如在自回归语言模型中,预测下一个词取决于之前的所有词。

在深度学习实践中,RNN因其强大的序列处理能力而被广泛应用于自然语言处理(NLP)、语音识别、机器翻译等领域。理解RNN的工作原理和优化方法,如长短期记忆网络(LSTM)和门控循环单元(GRU),对于有效构建和调整这类模型至关重要。

2008-10-15 上传

2018-02-06 上传

2023-03-16 上传

2019-03-30 上传

2018-07-22 上传

2018-04-10 上传

2021-03-11 上传

2020-03-29 上传

wilbertzhou

- 粉丝: 62

- 资源: 53

最新资源

- accounts-ui-no-dropdown

- 基于matlab+DWT的图像水印项目,数字水印+源代码+文档说明+图片+报告pdf

- RayTraceNextWeek代码实现

- C#控件大全_C#_控件大全_

- flow-8.0.1.jar中文-英文对照文档.zip

- 行业文档-设计装置-无盖的伸缩笔.zip

- tinyserial:小型串行开源项目

- matlab的egde源代码-matlab_speech_features:用Matlab编写的用于ASR和说话人识别的一组语音特征提取功能

- 基于LSB图像信息隐藏实现的数字水印技术matlab源码+文档说明(课程设计)

- slush-asponte:一个 slush 生成器,用于构建基于 Anguar-JS ECMAScript6 的前端,并具有可靠的开发人员工具包和构建流程

- [浙江]现代高层住宅+商业建筑方案设计2020

- python爱心代码合集 (9).zip

- dd_modbusRTU_

- matlab的egde源代码-IMUSensorModels:该存储库包含用于IMU传感器建模的C++类

- 行业分类-设备装置-大对开双面薄纸胶印机.zip

- lombok-0.10.1.jar中文-英文对照文档.zip