Hadoop 0.20.0 集群配置与MapReduce开发实战指南

需积分: 16 23 浏览量

更新于2024-07-27

收藏 410KB PDF 举报

"Hadoop集群配置及MapReduce开发手册,详细介绍了如何在Hadoop 0.20.0版本上配置集群以及进行MapReduce开发。该手册由天喻研究院于2009年修订,涵盖了环境配置、安装步骤、性能优化和MapReduce编程等多个方面。"

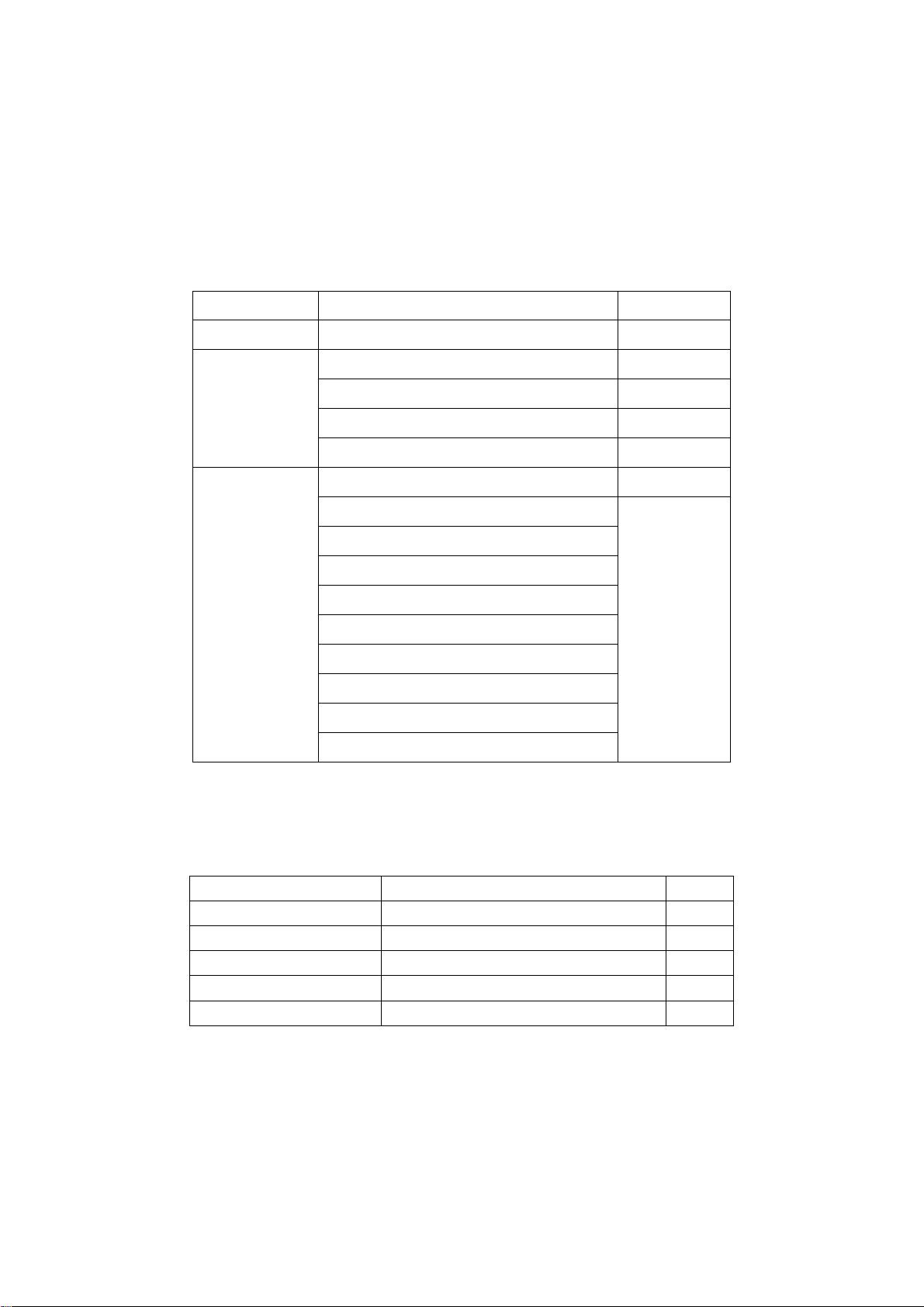

在Hadoop 0.20.0集群配置中,首先需要了解的是环境说明。集群运行在CentOS5操作系统上,使用Sun-java-6作为JDK,SSH服务用于节点间通信,而Eclipse 3.4.2 (Linux版)则用于开发。集群由多个节点组成,包括一个NameNode(10.8.2.25,server1)和多个DataNode(例如:10.8.2.51至10.8.2.59)。所有的配置和开发工作都将在名为hadoop0200的用户目录下进行,如/home/hadoop0200。

环境配置与安装过程包括了硬盘分区、JDK、Hadoop和SSH的安装与配置。硬盘分区配置是集群部署的基础,确保有足够的存储空间来存放数据和日志。JDK安装分为安装和配置两个步骤,配置主要是设置JAVA_HOME环境变量,使其指向JDK的安装路径。安装Hadoop涉及下载源码或二进制包,解压并设置HADOOP_HOME。配置Hadoop时,需要修改conf目录下的配置文件,如core-site.xml、hdfs-site.xml和mapred-site.xml,设置HDFS和MapReduce的相关参数。配置master和slaves文件,列出所有DataNode的主机名,以便NameNode管理和调度。

SSH的安装和配置是集群通信的关键,确保每个节点之间可以无密码互信,方便集群操作。安装SSH后,通过ssh-keygen生成公钥和私钥,然后将公钥复制到所有节点,实现ssh免密登录。

MapReduce开发部分,首先需要安装Hadoop Eclipse Plugin,以便在Eclipse环境中开发MapReduce程序。接着配置Eclipse Plugin,连接到Hadoop集群。建立MapReduce工程时,可以创建一个新的Java项目,遵循Hadoop的编程模型编写Mapper和Reducer类,并指定输入输出路径。

在Hadoop性能优化方面,手册提供了多个维度的建议。内存优化是关键,可以通过调整mapred.map.memory.mb和mapred.reduce.memory.mb等参数控制任务分配的内存。Master优化涉及到NameNode和JobTracker的性能,如调整它们的内存分配和守护进程数量。文件存储设置包括副本数量和块大小的设定,以平衡存储效率和容错性。MapReduce临时存储优化涉及本地磁盘的使用,减少网络传输。tasks配置,如mapred.tasktracker.map.tasks.maximum和mapred.tasktracker.reduce.tasks.maximum,可以调整每个TaskTracker上同时运行的任务数量。

这份手册提供了Hadoop集群从搭建到优化,再到开发MapReduce应用的完整流程,对于学习和实践Hadoop有着极大的帮助。开发者可以通过这些步骤逐步掌握Hadoop的使用,提高集群的运行效率和应用程序的性能。

2010-08-30 上传

2014-10-25 上传

2023-07-15 上传

2024-04-18 上传

2023-05-04 上传

2024-05-17 上传

2023-10-14 上传

2023-05-11 上传

2023-07-27 上传

mypersche

- 粉丝: 1

- 资源: 4

最新资源

- AirKiss技术详解:无线传递信息与智能家居连接

- Hibernate主键生成策略详解

- 操作系统实验:位示图法管理磁盘空闲空间

- JSON详解:数据交换的主流格式

- Win7安装Ubuntu双系统详细指南

- FPGA内部结构与工作原理探索

- 信用评分模型解析:WOE、IV与ROC

- 使用LVS+Keepalived构建高可用负载均衡集群

- 微信小程序驱动餐饮与服装业创新转型:便捷管理与低成本优势

- 机器学习入门指南:从基础到进阶

- 解决Win7 IIS配置错误500.22与0x80070032

- SQL-DFS:优化HDFS小文件存储的解决方案

- Hadoop、Hbase、Spark环境部署与主机配置详解

- Kisso:加密会话Cookie实现的单点登录SSO

- OpenCV读取与拼接多幅图像教程

- QT实战:轻松生成与解析JSON数据