EM算法详解与非监督学习应用

需积分: 9 136 浏览量

更新于2024-07-20

收藏 1.91MB PDF 举报

EM算法是一种重要的迭代优化方法,在机器学习领域中尤其在非监督学习和高斯混合模型(GMM)中有着广泛应用。它最初由李航在教学材料中介绍,主要用于解决那些含有未观测隐变量的问题,如在三硬币模型中的参数估计。

在三硬币模型中,我们有三个硬币A、B、C,每个硬币都有各自的正面概率π、p、q。通过观察一系列结果,我们无法直接得知硬币A的掷出情况,只能看到最终的观测结果。这个问题可以通过建立一个生成模型来解决,其中观测变量Y表示结果(1或0),隐变量z表示硬币A的掷出状态。通过最大化似然函数,EM算法试图找到这些参数的估计值。EM算法的核心在于E步(Expectation Step)和M步(Maximization Step):

1. E步:根据当前参数估计,计算在给定观测数据yi下,隐变量z的条件概率分布。

2. M步:利用E步的结果,更新模型参数的估计值,使得条件分布下的联合概率最大化。

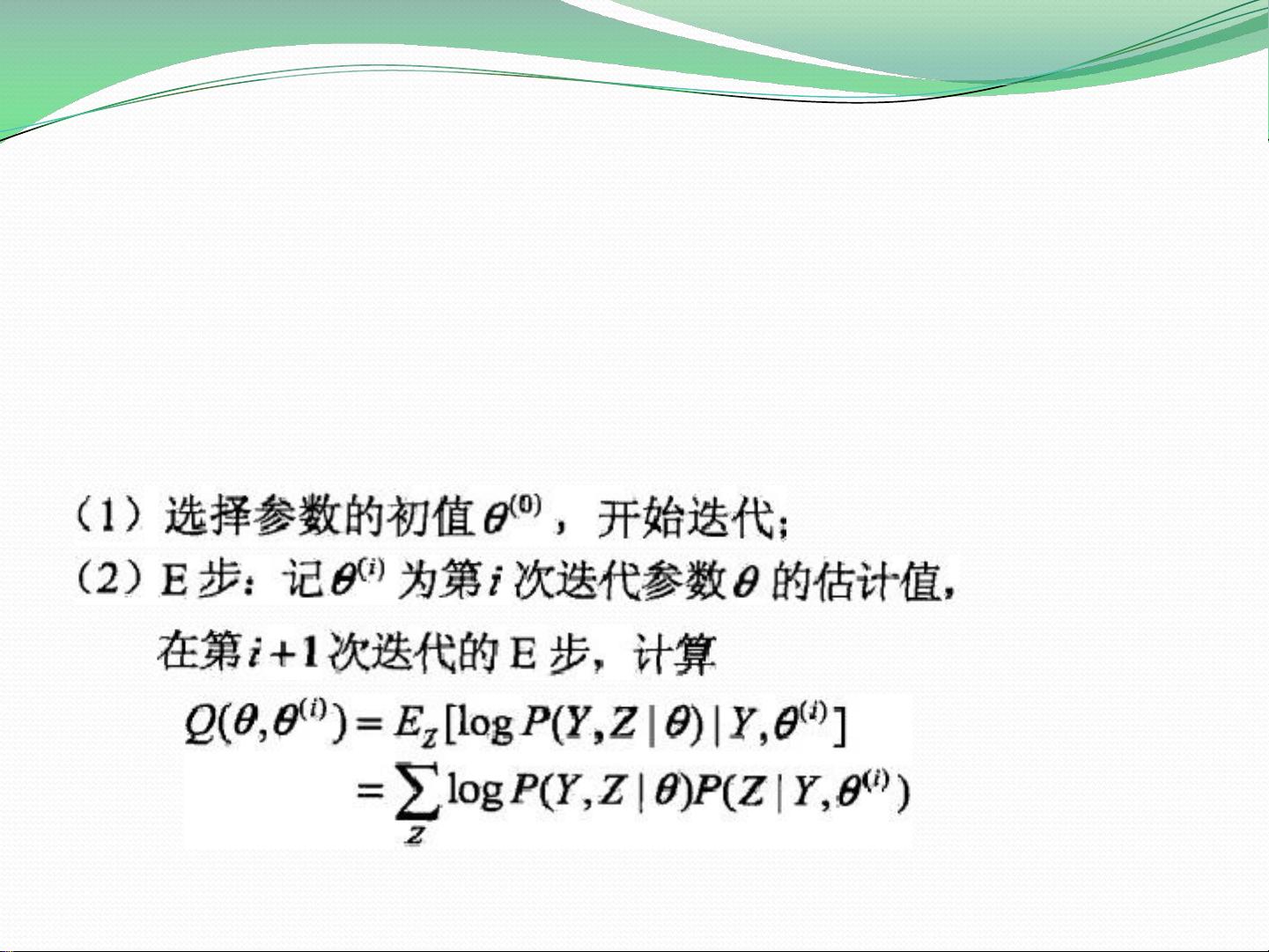

算法的迭代过程通常从一个初始估计开始,例如π^(0), p^(0), q^(0),然后通过以下步骤进行:

- 对于给定的观测数据Y,计算Q函数,它是完全数据对数似然函数关于隐变量条件概率的期望。

- 证明每次迭代都会增加似然函数或者达到局部最大值,直到满足停止条件(通常是迭代次数达到预定值或连续多次迭代变化小于某个阈值)。

- EM算法导出过程中,通过比较观测数据和隐变量数据的似然函数,利用Jason不等式(即上界和下界的差)来证明EM方法的有效性,通过迭代逼近极大似然估计。

在非监督学习中,如生成模型的训练,EM算法允许我们在没有明确监督的情况下估计潜在结构和概率分布,这对于聚类分析和密度估计等任务非常有用。生成模型的联合概率分布P(X,Y)反映了数据背后的生成过程,而EM算法在这个过程中扮演了关键角色,帮助我们从观测数据中挖掘潜在的信息。

EM算法是一种强大的工具,通过巧妙地处理未观测数据,为解决复杂的数据建模和估计问题提供了有效的方法。其在理论和实践中的应用广泛,尤其是在高斯混合模型和非监督学习中的应用尤为显著。理解并掌握EM算法的原理和操作对于从事机器学习的研究和实践至关重要。

论文

论文

2023-11-20 上传

2023-11-28 上传

2023-12-01 上传

2023-12-14 上传

2023-09-27 上传

2023-05-27 上传

gouzhinan

- 粉丝: 0

- 资源: 3

最新资源

- 构建Cadence PSpice仿真模型库教程

- VMware 10.0安装指南:步骤详解与网络、文件共享解决方案

- 中国互联网20周年必读:影响行业的100本经典书籍

- SQL Server 2000 Analysis Services的经典MDX查询示例

- VC6.0 MFC操作Excel教程:亲测Win7下的应用与保存技巧

- 使用Python NetworkX处理网络图

- 科技驱动:计算机控制技术的革新与应用

- MF-1型机器人硬件与robobasic编程详解

- ADC性能指标解析:超越位数、SNR和谐波

- 通用示波器改造为逻辑分析仪:0-1字符显示与电路设计

- C++实现TCP控制台客户端

- SOA架构下ESB在卷烟厂的信息整合与决策支持

- 三维人脸识别:技术进展与应用解析

- 单张人脸图像的眼镜边框自动去除方法

- C语言绘制图形:余弦曲线与正弦函数示例

- Matlab 文件操作入门:fopen、fclose、fprintf、fscanf 等函数使用详解