NLPCC小模型比赛:预训练模型推理优化与实践

版权申诉

44 浏览量

更新于2024-07-05

收藏 1.63MB PDF 举报

"NLPCC预训练小模型比赛经验分享,由小米AI实验室-NLP团队成员赵群、吴晓琳、丁鹏傑介绍。该分享主要涉及预训练模型在小米的推理优化实践,包括在NLPCC2020上的比赛情况和CLUEbenchmark提供的基准线。NLPCC是由CCF中国信息技术技术委员会主办的国际会议,旨在推动NLP和中文计算的前沿研究。比赛设有丰厚的奖励,并鼓励参赛者提升面向中文的轻量级模型的性能。"

正文:

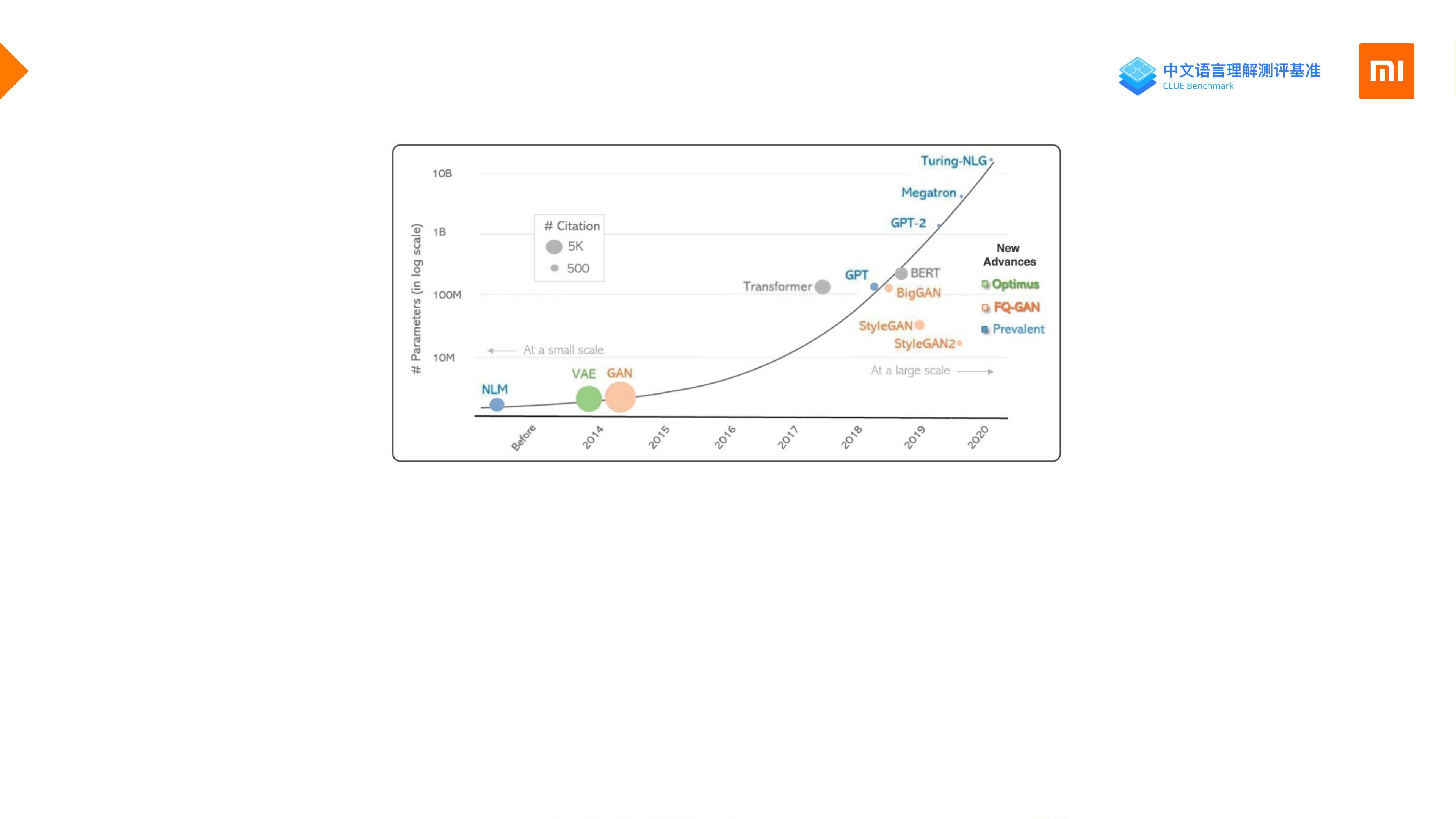

在NLP(自然语言处理)领域,预训练已经成为一个核心环节,尤其对于中文模型而言。预训练模型如BERT、RoBERTa等已经在多个任务上展现出强大的性能,但它们的计算需求巨大,往往需要大规模的计算资源和长时间的训练。这不仅增加了成本,也限制了模型在实际应用中的部署。

预训练通常涉及多种任务,如句子/句对分类、序列标注、阅读理解、指代消歧和关键词识别等。这些任务通过大量无监督的数据学习语言表示,然后在下游任务中微调以提高性能。然而,随着模型规模的扩大,训练过程变得极其耗时和资源密集,例如使用超过100GB的语料在一台V100 GPU上可能需要2-3个月的时间。

NLPCC预训练小模型比赛正是为了解决这一问题,它鼓励开发更高效、轻量级的模型,能在有限的计算资源下实现良好的性能。华为和小米等公司在比赛中展现出了强劲的实力,争夺排行榜的前列。比赛提供了基础的baseline模型LightLM,供参赛者参考和改进,同时还有双周赛和最终决赛的奖励机制,包括现金奖励、证书和参与分享技术的机会。

在推理效率优化及落地方面,小米AI实验室的团队分享了他们在预训练模型应用中的实践经验。他们可能采用了模型压缩、量化、蒸馏等技术,以减少模型大小并提高推理速度,同时保持或接近原始模型的性能。这些优化对于在实际产品中部署预训练模型至关重要,因为实时响应和低延迟是许多应用场景的基本要求。

NLPCC预训练小模型比赛推动了中文NLP领域的创新,促进了轻量级模型的发展。通过优化模型的效率,不仅可以降低成本,还能拓宽模型的应用场景,例如在移动设备、物联网设备等资源受限的环境中实现有效的自然语言理解和处理。这种优化工作不仅是技术挑战,也是推动NLP技术普惠大众的关键步骤。

2022-03-18 上传

2022-02-25 上传

2022-07-01 上传

2023-05-23 上传

2023-07-17 上传

2023-06-01 上传

2023-04-03 上传

2024-08-31 上传

2023-04-01 上传

行业报告

- 粉丝: 4

- 资源: 6234

最新资源

- 多模态联合稀疏表示在视频目标跟踪中的应用

- Kubernetes资源管控与Gardener开源软件实践解析

- MPI集群监控与负载平衡策略

- 自动化PHP安全漏洞检测:静态代码分析与数据流方法

- 青苔数据CEO程永:技术生态与阿里云开放创新

- 制造业转型: HyperX引领企业上云策略

- 赵维五分享:航空工业电子采购上云实战与运维策略

- 单片机控制的LED点阵显示屏设计及其实现

- 驻云科技李俊涛:AI驱动的云上服务新趋势与挑战

- 6LoWPAN物联网边界路由器:设计与实现

- 猩便利工程师仲小玉:Terraform云资源管理最佳实践与团队协作

- 类差分度改进的互信息特征选择提升文本分类性能

- VERITAS与阿里云合作的混合云转型与数据保护方案

- 云制造中的生产线仿真模型设计与虚拟化研究

- 汪洋在PostgresChina2018分享:高可用 PostgreSQL 工具与架构设计

- 2018 PostgresChina大会:阿里云时空引擎Ganos在PostgreSQL中的创新应用与多模型存储