Spark:超越Hadoop的高效数据分析工具

94 浏览量

更新于2024-08-30

收藏 120KB PDF 举报

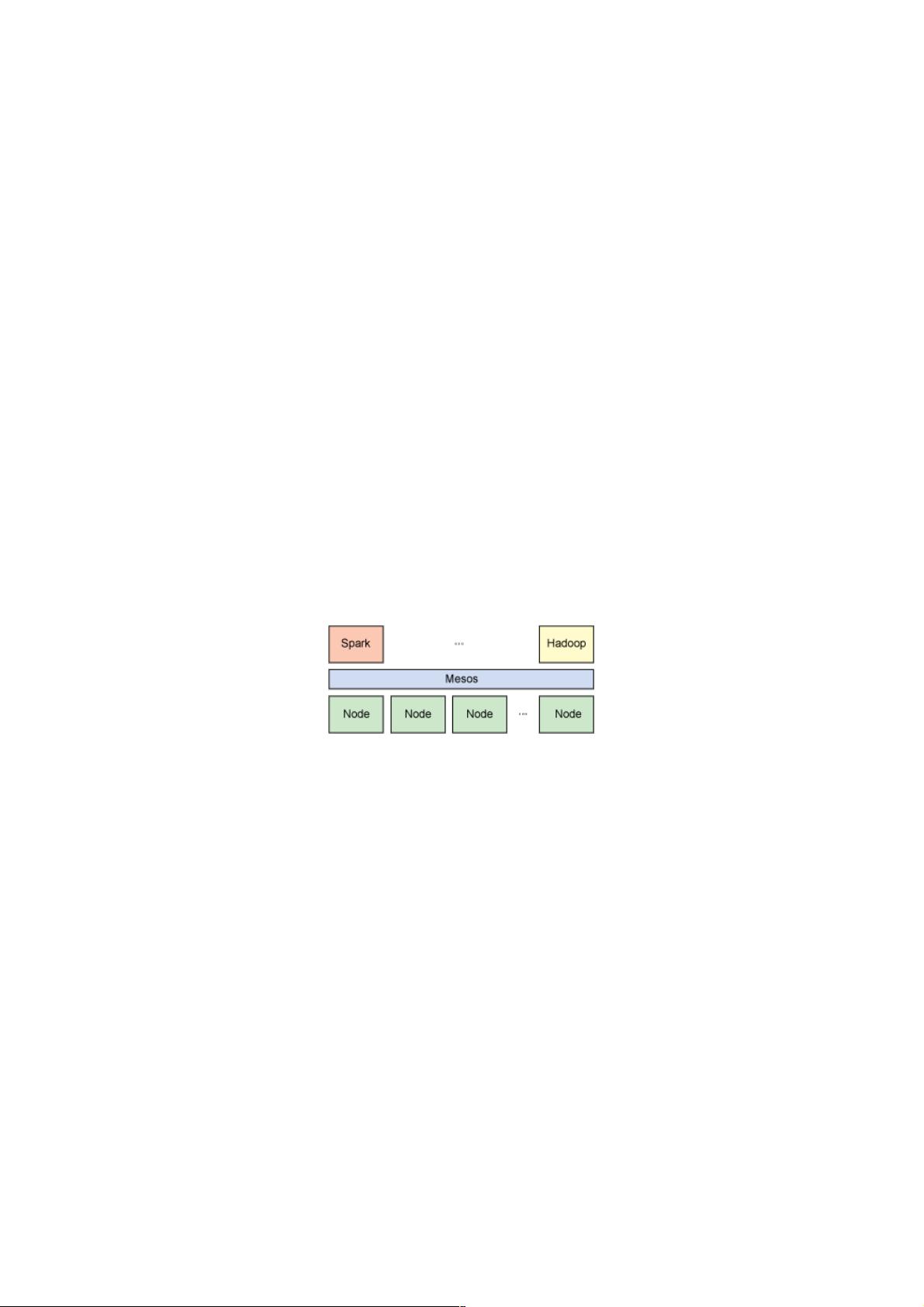

"Spark是一种快速数据分析平台,以其高效性能和内存计算能力成为Hadoop的有力替代方案。它在Scala语言中实现,与Hadoop相比,Spark更擅长处理迭代工作负载,通过内存计算显著提高了数据处理速度。Spark的核心是弹性分布式数据集(RDD),这是一种容错的只读对象集合,可以用于构建大规模、低延迟的数据分析应用。Spark可以在Hadoop文件系统上并行运行,也可以利用Mesos集群框架进行部署。"

Spark作为快速数据分析工具,其主要优势在于其内存计算模型。传统的Hadoop MapReduce模型在处理大数据时需要频繁地读写硬盘,这导致了较高的延迟。相比之下,Spark将数据存储在内存中,减少了I/O操作,极大地提升了处理速度,尤其适合需要多次迭代的计算任务,如机器学习算法。

Spark的编程模型是基于Scala语言的,这使得开发人员能够利用Scala的函数式编程特性,以简洁、高效的代码处理分布式数据。Scala与Spark的紧密结合使得开发人员能够像操作本地集合一样操作分布式数据集,降低了开发复杂度。

Spark的核心概念是弹性分布式数据集(RDD)。RDD是一个逻辑上的分片,分布在集群的不同节点上,具有容错性。当某个分片丢失时,可以通过其血统信息重新计算。RDD支持两种基本操作:转换和行动。转换创建新的RDD而不立即执行,而行动则触发实际的计算并可能返回结果给驱动程序或写入外部存储。

Spark还提供了一个交互式的Shell,名为Spark Shell,允许数据科学家和分析师快速测试和探索数据,进一步增强了其作为快速数据分析工具的吸引力。此外,Spark支持多种数据处理模式,包括批处理、流处理、图形处理和SQL查询,通过Spark SQL模块实现了与SQL的兼容性,方便传统SQL用户使用。

在集群管理方面,Spark可以与Hadoop的YARN或Apache Mesos配合使用,实现资源调度和任务管理。这种灵活性使得Spark可以无缝集成到现有的大数据生态系统中,成为Hadoop之外的一个强大选择。

Spark通过其内存计算、Scala集成、RDD抽象和广泛的功能支持,提供了一个高效、灵活且易用的大数据分析平台,尤其适用于需要高性能和低延迟的场景。

106 浏览量

106 浏览量

2024-07-03 上传

158 浏览量

122 浏览量

点击了解资源详情

833 浏览量

522 浏览量

点击了解资源详情

weixin_38626192

- 粉丝: 4

- 资源: 932

最新资源

- PJBlog2 qihh

- TodoRestApi:待办事项其余应用程序的服务器端

- spread:SPREAD 移动前景中的所有图形并尝试以愉快的方式排列它们。-matlab开发

- SeleniumDemo:Selenium自动化框架模板

- For-While

- kaggle dataset: publicassistance-数据集

- PHPWind论坛 prettyshow

- multitranslator

- 使用CNN的OCR韩语辅助应用程序

- SwiftUI仿表格效果完成代码

- Impermalink:用于创建缩短的,即将到期的链接的工具

- anime-sync

- Arduino-基于Web的MP3播放器-项目开发

- 预算跟踪器:使用503020方法的简单预算跟踪器

- TITUNI:Tituni - 标题程序。 还在测试中。-matlab开发

- BBSxp论坛 蓝语风格