Hadoop集群详解:架构、网络与服务器关系

"深入理解Hadoop集群和网络,探讨Hadoop在云计算环境中的网络架构,以及其与服务器基础设施的关系。"

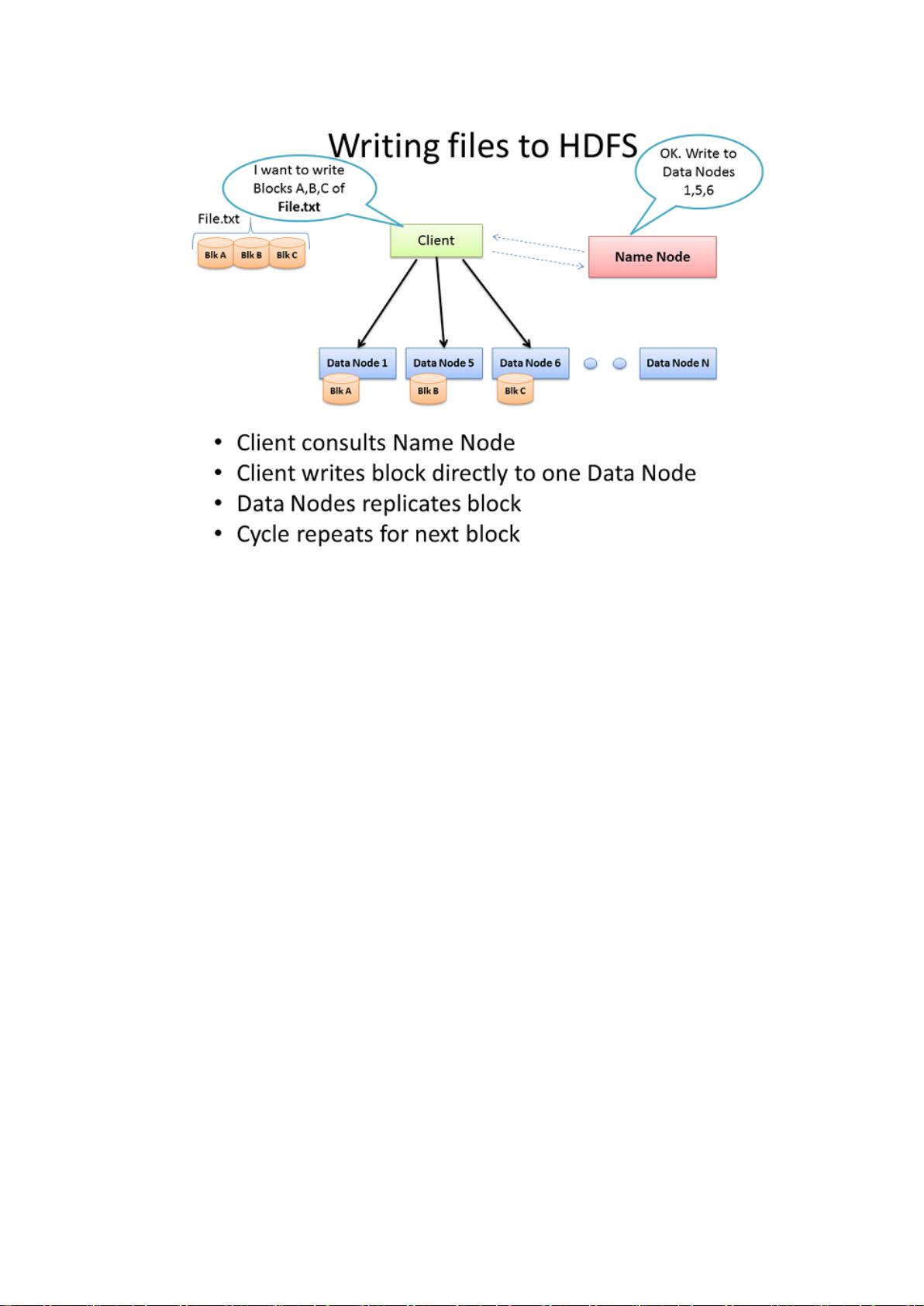

Hadoop是一个分布式计算框架,它允许在大规模集群中处理大量数据。Hadoop集群的核心组成部分包括Client机器、主节点和从节点。主节点包括名称节点(NameNode)和JobTracker,它们分别管理HDFS(Hadoop Distributed File System)和MapReduce的运行。名称节点负责存储文件系统的元数据,并协调数据块的访问;JobTracker则负责作业调度和任务分配。

从节点(DataNodes)是集群中的工作horse,它们存储数据并执行MapReduce任务。每个从节点既是数据节点,也是与主节点通信的守护进程。Client机器则扮演数据输入输出的角色,提交作业,接收结果,但并不参与实际的计算过程。

在小型集群中,可能在一个物理服务器上同时运行JobTracker和名称节点,以节省硬件成本。然而,在大型生产环境中,为了保证高可用性和性能,通常会将这些角色分开,每项任务由单独的服务器承载。这是因为虚拟化会引入额外的开销,而Hadoop设计的目标是直接与硬件交互,以实现最佳性能。

在Hadoop集群的物理布局中,服务器通常采用机架式结构,机架之间通过高速网络交换机互连。常见的网络带宽为1GB或2GB,但更高速的10GB带宽可以显著提升集群的处理能力,尤其是在处理高密度的CPU和磁盘I/O时。这种网络架构允许数据在节点间快速移动,确保了MapReduce操作的高效执行。

Hadoop在Linux操作系统上的表现最佳,因为它可以直接访问底层硬件,提供更好的性能和更低的成本。集群的扩展性是其另一大优势,可以根据需求添加更多服务器来扩展存储和计算能力。理解Hadoop集群的网络架构对于优化大数据处理的性能和效率至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2013-11-11 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

2018-10-09 上传

2010-07-12 上传